diff --git a/defer.md b/defer.md

index ae0d8bf..ada7c2b 100644

--- a/defer.md

+++ b/defer.md

@@ -76,7 +76,7 @@ func newdefer(siz int32) *_defer {

```go

type _defer struct {

siz int32 // 函数的参数总大小

- started bool // TODO defer 是否已开始执行?

+ started bool // defer 是否已开始执行

sp uintptr // 存储调用 defer 函数的函数的 sp 寄存器值

pc uintptr // 存储 call deferproc 的下一条汇编指令的指令地址

fn *funcval // 描述函数的变长结构体,包括函数地址及参数

@@ -160,3 +160,6 @@ A: deferproc 和 deferreturn 是成对出现的,对于编译器的实现来说

https://ieevee.com/tech/2017/11/23/go-panic.html

+

+

+

diff --git a/defer.md b/defer.md

index ae0d8bf..ada7c2b 100644

--- a/defer.md

+++ b/defer.md

@@ -76,7 +76,7 @@ func newdefer(siz int32) *_defer {

```go

type _defer struct {

siz int32 // 函数的参数总大小

- started bool // TODO defer 是否已开始执行?

+ started bool // defer 是否已开始执行

sp uintptr // 存储调用 defer 函数的函数的 sp 寄存器值

pc uintptr // 存储 call deferproc 的下一条汇编指令的指令地址

fn *funcval // 描述函数的变长结构体,包括函数地址及参数

@@ -160,3 +160,6 @@ A: deferproc 和 deferreturn 是成对出现的,对于编译器的实现来说

https://ieevee.com/tech/2017/11/23/go-panic.html

+

+

+ diff --git a/futex.md b/futex.md

index 812d091..9d51161 100644

--- a/futex.md

+++ b/futex.md

@@ -235,3 +235,6 @@ http://blog.sina.com.cn/s/blog_e59371cc0102v29b.html

https://www.jianshu.com/p/570a61f08e27

https://eli.thegreenplace.net/2018/basics-of-futexes/

+

+

+

diff --git a/futex.md b/futex.md

index 812d091..9d51161 100644

--- a/futex.md

+++ b/futex.md

@@ -235,3 +235,6 @@ http://blog.sina.com.cn/s/blog_e59371cc0102v29b.html

https://www.jianshu.com/p/570a61f08e27

https://eli.thegreenplace.net/2018/basics-of-futexes/

+

+

+ diff --git a/gc.md b/gc.md

index ff0ec21..b7973ed 100644

--- a/gc.md

+++ b/gc.md

@@ -742,3 +742,5 @@ gc时间,stw时间和响应延迟之间是什么关系

宏观来看gc划分为多少个阶段

+

+

diff --git a/gc.md b/gc.md

index ff0ec21..b7973ed 100644

--- a/gc.md

+++ b/gc.md

@@ -742,3 +742,5 @@ gc时间,stw时间和响应延迟之间是什么关系

宏观来看gc划分为多少个阶段

+

+ diff --git a/gc_write_barrier.md b/gc_write_barrier.md

new file mode 100644

index 0000000..d606aff

--- /dev/null

+++ b/gc_write_barrier.md

@@ -0,0 +1,37 @@

+# GC write barrier 详解

+

+在垃圾回收领域所讲的 barrier 包括 read barrier 与 write barrier,无论是哪一种,都与并发编程领域的 memory barrier 不是一回事。

+

+在 GC 中的 barrier 其本质是 : snippet of code insert before pointer modify。

+

+所以在阅读相关材料时,请注意不要将两者混淆。

+

+在当前 Go 语言的实现中,GC 只有 write barrier,没有 read barrier。

+

+在应用进入 GC 标记阶段前的 stw 阶段,会将全局变量 runtime.writeBarrier.enabled 修改为 true,当应用从 STW 中恢复,重新开始执行,垃圾回收的标记阶段便与应用逻辑开始并发执行,这时所有的堆上指针修改操作在修改之前会额外调用 runtime.gcWriteBarrier:

+

+

+

+我们随便找找这些反汇编结果在代码中对应的行:

+

+

+

+Go 语言当前使用了混合 barrier 来实现 gc 标记期间的被修改对象动态跟踪,早期只使用了 Dijistra 插入 barrier,但 Dijistra barrier 需要在标记完成之后进行栈重扫,因此在 1.8 时修改为混合 barrier。

+

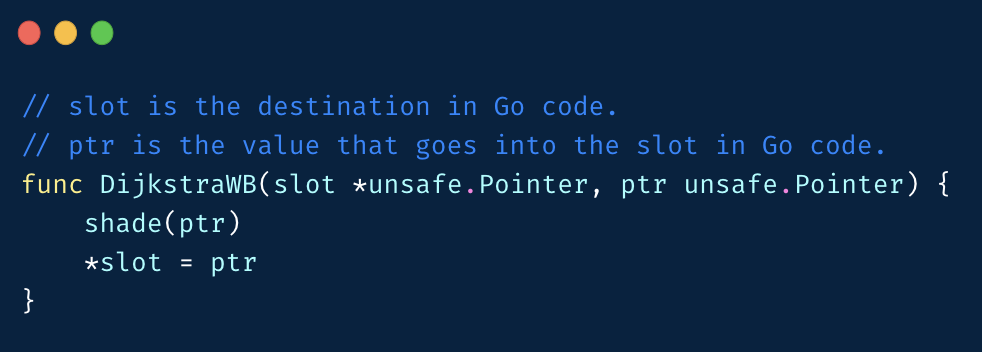

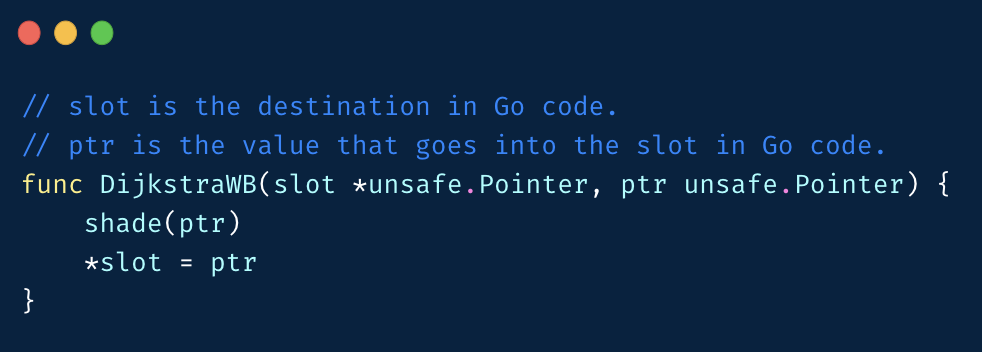

+Dijistra 插入屏障伪代码如下:

+

+

+

+堆上指针修改时,新指向的对象要标灰。

+

+但是因为 Go 的栈上对象不加 barrier,所以会存在对象丢失的问题:

+

+

+

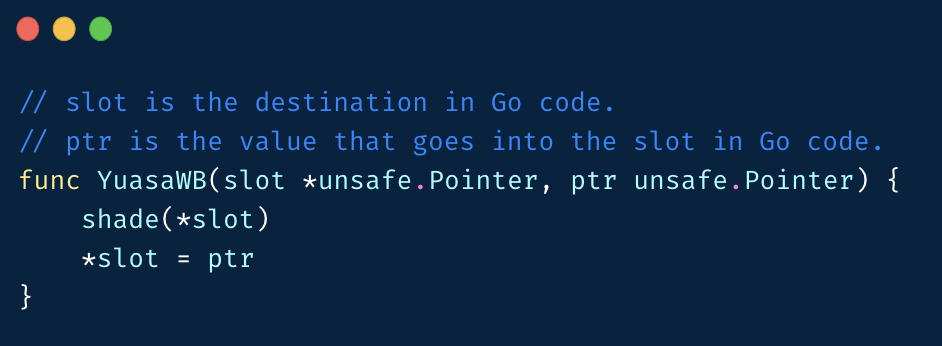

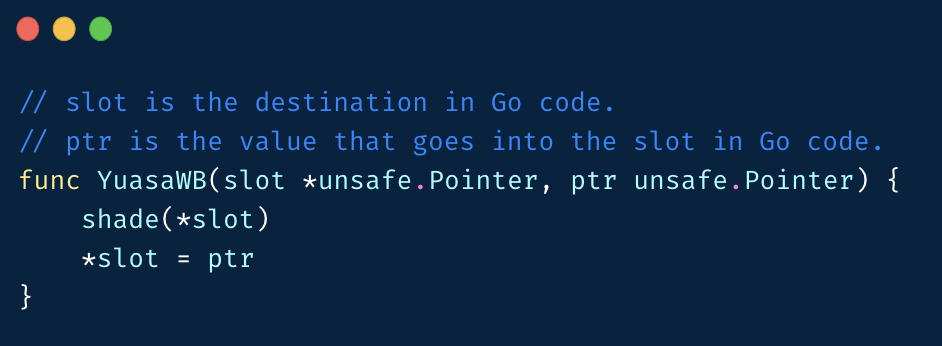

+还有一种非常有名的 barrier,Yuasa 删除屏障,与 Dijistra 屏障相反,它是在堆指针指向的对象发生变化时,将之前指向的对象标灰:

+

+

+

+和 Dijistra 类似,也存在对象漏标问题:

+

+

diff --git a/generics.md b/generics.md

index caf2ba5..4a36142 100644

--- a/generics.md

+++ b/generics.md

@@ -40,3 +40,5 @@ cat source.go | genny gen "Something=string"

没有官方的泛型支持,社区怎么搞都是邪道。2021 年 1 月,官方的方案已经基本上成型,并释出了 [draft design](https://go.googlesource.com/proposal/+/refs/heads/master/design/go2draft-type-parameters.md)。

+

+

diff --git a/gc_write_barrier.md b/gc_write_barrier.md

new file mode 100644

index 0000000..d606aff

--- /dev/null

+++ b/gc_write_barrier.md

@@ -0,0 +1,37 @@

+# GC write barrier 详解

+

+在垃圾回收领域所讲的 barrier 包括 read barrier 与 write barrier,无论是哪一种,都与并发编程领域的 memory barrier 不是一回事。

+

+在 GC 中的 barrier 其本质是 : snippet of code insert before pointer modify。

+

+所以在阅读相关材料时,请注意不要将两者混淆。

+

+在当前 Go 语言的实现中,GC 只有 write barrier,没有 read barrier。

+

+在应用进入 GC 标记阶段前的 stw 阶段,会将全局变量 runtime.writeBarrier.enabled 修改为 true,当应用从 STW 中恢复,重新开始执行,垃圾回收的标记阶段便与应用逻辑开始并发执行,这时所有的堆上指针修改操作在修改之前会额外调用 runtime.gcWriteBarrier:

+

+

+

+我们随便找找这些反汇编结果在代码中对应的行:

+

+

+

+Go 语言当前使用了混合 barrier 来实现 gc 标记期间的被修改对象动态跟踪,早期只使用了 Dijistra 插入 barrier,但 Dijistra barrier 需要在标记完成之后进行栈重扫,因此在 1.8 时修改为混合 barrier。

+

+Dijistra 插入屏障伪代码如下:

+

+

+

+堆上指针修改时,新指向的对象要标灰。

+

+但是因为 Go 的栈上对象不加 barrier,所以会存在对象丢失的问题:

+

+

+

+还有一种非常有名的 barrier,Yuasa 删除屏障,与 Dijistra 屏障相反,它是在堆指针指向的对象发生变化时,将之前指向的对象标灰:

+

+

+

+和 Dijistra 类似,也存在对象漏标问题:

+

+

diff --git a/generics.md b/generics.md

index caf2ba5..4a36142 100644

--- a/generics.md

+++ b/generics.md

@@ -40,3 +40,5 @@ cat source.go | genny gen "Something=string"

没有官方的泛型支持,社区怎么搞都是邪道。2021 年 1 月,官方的方案已经基本上成型,并释出了 [draft design](https://go.googlesource.com/proposal/+/refs/heads/master/design/go2draft-type-parameters.md)。

+

+ diff --git a/goroutine.md b/goroutine.md

index 0de6ace..38b020b 100644

--- a/goroutine.md

+++ b/goroutine.md

@@ -7,4 +7,6 @@

> Written with [StackEdit](https://stackedit.io/).

\ No newline at end of file

+-->

+

+

diff --git a/goroutine.md b/goroutine.md

index 0de6ace..38b020b 100644

--- a/goroutine.md

+++ b/goroutine.md

@@ -7,4 +7,6 @@

> Written with [StackEdit](https://stackedit.io/).

\ No newline at end of file

+-->

+

+ diff --git a/images/garbage_collection/barrier_asm.png b/images/garbage_collection/barrier_asm.png

new file mode 100644

index 0000000..5012031

Binary files /dev/null and b/images/garbage_collection/barrier_asm.png differ

diff --git a/images/garbage_collection/barrier_code.png b/images/garbage_collection/barrier_code.png

new file mode 100644

index 0000000..5f971b0

Binary files /dev/null and b/images/garbage_collection/barrier_code.png differ

diff --git a/interface.md b/interface.md

index 703507d..a365ff4 100644

--- a/interface.md

+++ b/interface.md

@@ -543,3 +543,5 @@ go.itab.*os.File,io.Writer SRODATA dupok size=32

// 下面就是正常流程了

```

+

+

diff --git a/images/garbage_collection/barrier_asm.png b/images/garbage_collection/barrier_asm.png

new file mode 100644

index 0000000..5012031

Binary files /dev/null and b/images/garbage_collection/barrier_asm.png differ

diff --git a/images/garbage_collection/barrier_code.png b/images/garbage_collection/barrier_code.png

new file mode 100644

index 0000000..5f971b0

Binary files /dev/null and b/images/garbage_collection/barrier_code.png differ

diff --git a/interface.md b/interface.md

index 703507d..a365ff4 100644

--- a/interface.md

+++ b/interface.md

@@ -543,3 +543,5 @@ go.itab.*os.File,io.Writer SRODATA dupok size=32

// 下面就是正常流程了

```

+

+ diff --git a/io.md b/io.md

index 2bbac62..c15b884 100644

--- a/io.md

+++ b/io.md

@@ -193,4 +193,534 @@ vmtouch /disk/data/tmp/test

- https://tech.meituan.com/2017/05/19/about-desk-io.html

- https://github.com/ncw/directio

# DMA

-# Zero-Copy

\ No newline at end of file

+# Zero-Copy

+

+## splice

+在介绍 splice 及其在 golang 中的应用之前, 先从一段简单的网络代理代码开始入手

+#### read & write

+```go

+var (

+ p sync.Pool

+)

+

+func init() {

+ p.New = func() interface{} {

+ return make([]byte, DEFAULTSIZE)

+ }

+}

+// src 客户端 tcp 链接

+// dst mock server tcp 链接

+func normal(src, dst net.Conn) {

+ var bts []byte = p.Get().([]byte)

+ var bts2 []byte = p.Get().([]byte)

+ defer p.Put(bts)

+ defer p.Put(bts2)

+ // mock server to client

+ go func() {

+ for {

+ num, err := dst.Read(bts2[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = src.Write(bts2[num_write:num])

+ if err != nil {

+ return

+ }

+ num -= num_write

+ }

+ }

+ }()

+ // client to mock server

+ for {

+ num, err := src.Read(bts[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = dst.Write(bts[num_write:num])

+ if err != nil {

+ return

+ }

+ num -= num_write

+ }

+ }

+}

+```

+以上片段实现了一个简单的功能: 将客户端请求的 tcp 数据通过`read`系统调用读出放入本地用户空间 缓存, 而后再调用`write`发送给目标服务器,反之亦然

+

+整个过程如下图所示(暂不考虑 IO 模型调度以及 DMA 等细节部分)

+

+```shell

+[ user space ]

+

+ --------------------------------------------

+ | application |

+ --------------------------------------------

+ ····················|·································|··················

+ | read() | write()

+[ kernel space ] | |

+ ----------------- -----------------

+ | socket buffer | | socket buffer |

+ ----------------- -----------------

+ | copy |

+ ····················|·································|··················

+[ hardware sapce ] | |

+ ------------------------------------------------------

+ | network interface |

+ ------------------------------------------------------

+

+```

+对于透传或者部分透传(例如七层头部解析后透明代理请求体)之类的需求场景来说, 这种流程的成本无疑是很高的, 可以总结下涉及的几个浪费点

+

+- 数据需要从内核态拷贝到用户态

+- 应用层在 read 及 write 的过程中对这部分 byte 的操作开销(申请、释放、对象池维护等)

+

+#### splice 介绍

+```c

+/*

+ splice() moves data between two file descriptors without copying

+ between kernel address space and user address space. It

+ transfers up to len bytes of data from the file descriptor fd_in

+ to the file descriptor fd_out, where one of the file descriptors

+ must refer to a pipe.

+*/

+ssize_t splice(int fd_in, off64_t *off_in, int fd_out,

+ off64_t *off_out, size_t len, unsigned int flags);

+```

+一句话概括就是, `splice` 不需要从内核空间复制这部分数据到用户空间就可以支持将数据从两个文件描述符之间进行转移, 不过两个描述符至少得有一个是 `pipe`, 以下列举如何利用`splice`完成 `socket->socket` 的数据代理

+

+example:

+```go

+func example(src, dst net.Conn) {

+ // 由于 src 及 dst 都是 socket, 没法直接使用 splice, 因此先创建临时 pipe

+ const flags = syscall.O_CLOEXEC | syscall.O_NONBLOCK

+ var fds [2]int // readfd, writefd

+ if err := syscall.Pipe2(fds[:], flags); err != nil {

+ panic(err)

+ }

+ // 使用完后关闭 pipe

+ defer syscall.Close(fds[0])

+ defer syscall.Close(fds[1])

+ // 获取 src fd

+ srcfile, err := src.(*net.TCPConn).File()

+ if err != nil {

+ panic(err)

+ }

+ srcfd := int(srcfile.Fd())

+ syscall.SetNonblock(srcfd, true)

+ ...

+ // 从 srcfd 读出, 写入 fds[1] (pipe write fd)

+ num, err := syscall.Splice(srcfd, nil, fds[1], nil, DEFAULTSIZE/* size to splice */, SPLICE_F_NONBLOCK)

+ ...

+}

+```

+此时的调用过程变为:

+

+```shell

+[ user space ]

+

+ -----------------------------------------------------------------------------------------------

+ | application |

+ -----------------------------------------------------------------------------------------------

+ ········································|····················|·····················|··································

+ | splice() | pipe() | splice()

+[ kernel space ] | | |

+ ----------------- ”copy“ ----------------------- ”copy“ -----------------

+ | socket buffer |· · · · · · · · · >| pipe writefd & readfd |· · · · · · · · >| socket buffer |

+ ----------------- ----------------------- -----------------

+ | copy |

+ ····················|··············································································|

+[ hardware sapce ] | |

+ -----------------------------------------------------------------------------------------------

+ | network interface |

+ -----------------------------------------------------------------------------------------------

+```

+此时产生的系统调用为

+- 首先 `pipe()` 调用, 创建临时管道

+- 调用 `splice()` 将 `srcfd` 数据 ”拷贝“ 到 `pipe`

+- 调用 `splice()` 将 `pipe` 中的数据 ”拷贝“ 到 `dstfd`

+

+可以注意到图中以及总结部分的”拷贝“给加了引号, 具体了解过`pipe`底层实现的小伙伴应该理解, 在这边简单表述下, `splice` 是基于 `pipe buffer` 实现的, 本质上在数据传输的时候并没有进行数据的拷贝, 而是仅仅将数据的内存地址等信息塞进了`pipe_buffer`中对应的字段

+

+至此, 完成了 kernel-user space 的拷贝优化, 不过可能细心的人会发现, 这种方式虽然减少了数据的拷贝, 但是同样额外增加了系统调用(create pipe & close pipe), 接下来就关于这部分的取舍与具体场景进行具体讨论

+

+#### splice 还是 read & write?

+如何取舍使用哪种方式?

+

+两种方法各有各的好处, 往往选择层面的考虑在于应用层的具体策略, 如是否进行透传(/部分), 饥饿问题, 对象池策略等等

+

+下面提供几种场景下的测试以供参考

+benchmark 代码:

+```go

+/*

+ * 测试环境: go 1.14.3 centos7

+ */

+package main

+

+import (

+ "bytes"

+ "io"

+ "net"

+ "net/http"

+ "sync"

+ "sync/atomic"

+ "testing"

+ "time"

+)

+

+var (

+ p sync.Pool

+)

+

+func init() {

+ p.New = func() interface{} {

+ return make([]byte, DEFAULTSIZE)

+ }

+}

+

+const (

+ // mock http 请求体大小

+ REQUESTBYTESIZE = 0

+ // 应用层对象池 byte 大小

+ DEFAULTSIZE = 1 << 10

+

+ SPLICE_F_MOVE = 0x1

+ SPLICE_F_NONBLOCK = 0x2

+ SPLICE_F_MORE = 0x4

+ SPLICE_F_GIFT = 0x8

+)

+// io.Copy 该场景下内部调用 splice syscall, 感兴趣的自行查看源码

+func gosplice(src, dst net.Conn) {

+ defer src.Close()

+ defer dst.Close()

+ go func() {

+ io.Copy(src, dst)

+ }()

+ io.Copy(dst, src)

+}

+

+func normal(src, dst net.Conn) {

+ defer src.Close()

+ defer dst.Close()

+ var bts []byte = p.Get().([]byte)

+ var bts2 []byte = p.Get().([]byte)

+ defer p.Put(bts)

+ defer p.Put(bts2)

+ go func() {

+ for {

+ num, err := dst.Read(bts2[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = src.Write(bts2[num_write:num])

+ num -= num_write

+ if err != nil {

+ return

+ }

+ }

+ }

+ }()

+ // local to mock serve

+ for {

+ num, err := src.Read(bts[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = dst.Write(bts[num_write:num])

+ num -= num_write

+ if err != nil {

+ return

+ }

+ }

+ }

+}

+

+// Server http server

+var Server *http.Server

+

+type s struct{}

+

+func (ss s) ServeHTTP(res http.ResponseWriter, req *http.Request) {

+ res.WriteHeader(200)

+ return

+}

+func TestMain(m *testing.M) {

+ // mock tcp server

+ var ss s

+ go func() {

+ Server = &http.Server{

+ Addr: "0.0.0.0:9610",

+ Handler: ss,

+ WriteTimeout: 60 * time.Second,

+ ReadTimeout: 60 * time.Second,

+ }

+ err := Server.ListenAndServe()

+ if err != nil {

+ panic(err)

+ }

+ }()

+ go func() { // normal 9611

+ l, err := net.ListenTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"),

+ Port: 9611,

+ })

+ if err != nil {

+ panic(err)

+ }

+ for {

+ n, err := l.Accept()

+ if err != nil {

+ continue

+ }

+ remote, err := net.DialTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 0,

+ }, &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 9610,

+ })

+ if err != nil {

+ continue

+ }

+ go normal(n, remote)

+ }

+ }()

+ go func() { // gosplice 9612

+ l, err := net.ListenTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"),

+ Port: 9612,

+ })

+ if err != nil {

+ panic(err)

+ }

+ for {

+ n, err := l.Accept()

+ if err != nil {

+ continue

+ }

+ remote, err := net.DialTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 0,

+ }, &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 9610,

+ })

+ if err != nil {

+ continue

+ }

+ go gosplice(n, remote)

+ }

+ }()

+ m.Run()

+}

+func BenchmarkNormalReadWrite(b *testing.B) {

+ // normal 9611

+ c := http.Client{

+ Timeout: time.Minute,

+ }

+ var total, success uint32

+ b.ResetTimer()

+ for i := 0; i < b.N; i++ {

+ atomic.AddUint32(&total, 1)

+ req, err := http.NewRequest("POST", "http://0.0.0.0:9611", bytes.NewReader(make([]byte, REQUESTBYTESIZE)))

+ if err != nil {

+ b.Fatalf("%s", err.Error())

+ }

+ res, err := c.Do(req)

+ if err == nil && res.StatusCode == 200 {

+ atomic.AddUint32(&success, 1)

+ }

+ c.CloseIdleConnections()

+ }

+ b.Logf("test:%s,total: %d,rate: %.2f%%\n", b.Name(), total, float64(success*100/total))

+}

+

+func BenchmarkGoSplice(b *testing.B) {

+ // normal 9612

+ c := http.Client{

+ Timeout: time.Minute,

+ }

+ var total, success uint32

+ b.ResetTimer()

+ for i := 0; i < b.N; i++ {

+ atomic.AddUint32(&total, 1)

+ req, err := http.NewRequest("POST", "http://0.0.0.0:9612", bytes.NewReader(make([]byte, REQUESTBYTESIZE)))

+ if err != nil {

+ b.Fatalf("%s", err.Error())

+ }

+ res, err := c.Do(req)

+ if err == nil && res.StatusCode == 200 {

+ atomic.AddUint32(&success, 1)

+ }

+ c.CloseIdleConnections()

+ }

+ b.Logf("test:%s, total: %d, success rate: %.2f%%\n", b.Name(), total, float64(success*100/total))

+}

+```

+- 场景一: 单次请求数据量较少, 应用维护单个 buffer 较小

+```go

+REQUESTBYTESIZE = 0 // http request body

+DEFAULTSIZE = 1 << 10 // buffer size 1kb

+```

+```shell

+RRunning tool: /usr/local/bin/go test -benchmem -run=^$ -bench ^(BenchmarkNormalReadWrite|BenchmarkGoSplice)$ barrier/t

+

+goos: linux

+goarch: amd64

+pkg: barrier/t

+BenchmarkNormalReadWrite-4 6348 179699 ns/op 4847 B/op 62 allocs/op

+--- BENCH: BenchmarkNormalReadWrite-4

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 1,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 100,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 6348,rate: 100.00%

+BenchmarkGoSplice-4 6652 179622 ns/op 4852 B/op 62 allocs/op

+--- BENCH: BenchmarkGoSplice-4

+ test_test.go:194: test:BenchmarkGoSplice, total: 1, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 100, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 6652, success rate: 100.00%

+PASS

+ok barrier/t 2.391s

+```

+两种方式无明显性能差异

+- 场景二: 单次请求数据量多, 应用维护单个 buffer 较小

+```go

+REQUESTBYTESIZE = 1 << 20 // 1 MB

+DEFAULTSIZE = 1 << 10 // buffer size 1kb

+```

+```shell

+Running tool: /usr/local/bin/go test -benchmem -run=^$ -bench ^(BenchmarkNormalReadWrite|BenchmarkGoSplice)$ barrier/t

+

+goos: linux

+goarch: amd64

+pkg: barrier/t

+BenchmarkNormalReadWrite-4 465 2329209 ns/op 1073956 B/op 163 allocs/op

+--- BENCH: BenchmarkNormalReadWrite-4

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 1,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 100,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 376,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 465,rate: 100.00%

+BenchmarkGoSplice-4 963 1555386 ns/op 1070506 B/op 157 allocs/op

+--- BENCH: BenchmarkGoSplice-4

+ test_test.go:194: test:BenchmarkGoSplice, total: 1, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 100, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 963, success rate: 100.00%

+PASS

+ok barrier/t 4.056s

+```

+当链接需要处理的数据量较多而应用层每次处理的 buffer 相比起来较小, 以至于需要 read & write 的次数更多的时候, 差异就会比较明显

+

+#### go 中的 splice

+在上面的介绍过程中简单说了下 `io.Copy` 在 `socket` 之间操作的时候, 当机器架构支持的时候会采取 `splice`, 接下来就此进行详细分析来介绍下 `runtime` 在 `splice` 上的一些决策以及当前`runtime`在 `splice` 上的一些不足

+```go

+/*

+ * src/net/spice_linux.go

+ */

+// splice transfers data from r to c using the splice system call to minimize

+// copies from and to userspace. c must be a TCP connection. Currently, splice

+// is only enabled if r is a TCP or a stream-oriented Unix connection.

+//

+// If splice returns handled == false, it has performed no work.

+func splice(c *netFD, r io.Reader) (written int64, err error, handled bool) {

+ /*

+ * 因为前面介绍过 splice 是通过 pipe buffer 实现的

+ * 在调用的时候 kernel无需进行数据拷贝, 仅操作数据原信息(基础字段的指针等)

+ * 所以这边默认 splice 的 len 开得比较大, 读到 EOF 为止

+ */

+ var remain int64 = 1 << 62 // by default, copy until EOF

+ lr, ok := r.(*io.LimitedReader)

+ if ok {

+ remain, r = lr.N, lr.R

+ if remain <= 0 {

+ return 0, nil, true

+ }

+ }

+

+ var s *netFD

+ if tc, ok := r.(*TCPConn); ok {

+ s = tc.fd

+ } else if uc, ok := r.(*UnixConn); ok {

+ if uc.fd.net != "unix" {

+ return 0, nil, false

+ }

+ s = uc.fd

+ } else {

+ return 0, nil, false

+ }

+

+ written, handled, sc, err := poll.Splice(&c.pfd, &s.pfd, remain)

+ if lr != nil {

+ lr.N -= written

+ }

+ return written, wrapSyscallError(sc, err), handled

+}

+```

+```go

+/*

+ * go 1.14.3

+ * src/internal/poll/splice_linux.go

+ */

+// Splice transfers at most remain bytes of data from src to dst, using the

+// splice system call to minimize copies of data from and to userspace.

+//

+// Splice creates a temporary pipe, to serve as a buffer for the data transfer.

+// src and dst must both be stream-oriented sockets.

+//

+// If err != nil, sc is the system call which caused the error.

+func Splice(dst, src *FD, remain int64) (written int64, handled bool, sc string, err error) {

+ // dst 以及 src 均为 socket.fd, 因此若想使用 splice 则需要借助 pipe

+ // 创建临时 pipe

+ prfd, pwfd, sc, err := newTempPipe()

+ if err != nil {

+ return 0, false, sc, err

+ }

+ defer destroyTempPipe(prfd, pwfd)

+ var inPipe, n int

+ for err == nil && remain > 0 {

+ max := maxSpliceSize

+ if int64(max) > remain {

+ max = int(remain)

+ }

+ // spliceDrain 调用 splice syscall

+ inPipe, err = spliceDrain(pwfd, src, max)

+ // The operation is considered handled if splice returns no

+ // error, or an error other than EINVAL. An EINVAL means the

+ // kernel does not support splice for the socket type of src.

+ // The failed syscall does not consume any data so it is safe

+ // to fall back to a generic copy.

+ //

+ // spliceDrain should never return EAGAIN, so if err != nil,

+ // Splice cannot continue.

+ //

+ // If inPipe == 0 && err == nil, src is at EOF, and the

+ // transfer is complete.

+ handled = handled || (err != syscall.EINVAL)

+ if err != nil || (inPipe == 0 && err == nil) {

+ break

+ }

+ // splicePump 调用 splice syscall

+ n, err = splicePump(dst, prfd, inPipe)

+ if n > 0 {

+ written += int64(n)

+ remain -= int64(n)

+ }

+ }

+ if err != nil {

+ return written, handled, "splice", err

+ }

+ return written, true, "", nil

+}

+```

+

+相信上面简短的分析大家也可以看到, 每次在进行 `splice` 的时候都会利用临时 `pipe`, 频繁的创建、销毁, 用户态-内核态的切换会带来非常多不必要的开销, 当前社区内也有关于 `splice temp-pipe` 生命周期的[讨论](https://go-review.googlesource.com/c/go/+/271537/)。

+

+再者, 因为当前关联到 `socket` 的 `splice` 实现在 `runtime` 层面和内置 `io 模型(epoll 等)`高度耦合, 基本无法解耦单独应用, 而如果想自己来实现 `splice(syscall.Splice)` 的话则不得不顺带在用户层面实现自己的`io 模型`再来使用, 会比较繁琐(上面测试用例使用内置 `splice api` 也是因为这个原因)

+

+## 参考资料

+

+- https://go-review.googlesource.com/c/go/+/271537/

+- https://zhuanlan.zhihu.com/p/308054212

+

+

diff --git a/io.md b/io.md

index 2bbac62..c15b884 100644

--- a/io.md

+++ b/io.md

@@ -193,4 +193,534 @@ vmtouch /disk/data/tmp/test

- https://tech.meituan.com/2017/05/19/about-desk-io.html

- https://github.com/ncw/directio

# DMA

-# Zero-Copy

\ No newline at end of file

+# Zero-Copy

+

+## splice

+在介绍 splice 及其在 golang 中的应用之前, 先从一段简单的网络代理代码开始入手

+#### read & write

+```go

+var (

+ p sync.Pool

+)

+

+func init() {

+ p.New = func() interface{} {

+ return make([]byte, DEFAULTSIZE)

+ }

+}

+// src 客户端 tcp 链接

+// dst mock server tcp 链接

+func normal(src, dst net.Conn) {

+ var bts []byte = p.Get().([]byte)

+ var bts2 []byte = p.Get().([]byte)

+ defer p.Put(bts)

+ defer p.Put(bts2)

+ // mock server to client

+ go func() {

+ for {

+ num, err := dst.Read(bts2[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = src.Write(bts2[num_write:num])

+ if err != nil {

+ return

+ }

+ num -= num_write

+ }

+ }

+ }()

+ // client to mock server

+ for {

+ num, err := src.Read(bts[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = dst.Write(bts[num_write:num])

+ if err != nil {

+ return

+ }

+ num -= num_write

+ }

+ }

+}

+```

+以上片段实现了一个简单的功能: 将客户端请求的 tcp 数据通过`read`系统调用读出放入本地用户空间 缓存, 而后再调用`write`发送给目标服务器,反之亦然

+

+整个过程如下图所示(暂不考虑 IO 模型调度以及 DMA 等细节部分)

+

+```shell

+[ user space ]

+

+ --------------------------------------------

+ | application |

+ --------------------------------------------

+ ····················|·································|··················

+ | read() | write()

+[ kernel space ] | |

+ ----------------- -----------------

+ | socket buffer | | socket buffer |

+ ----------------- -----------------

+ | copy |

+ ····················|·································|··················

+[ hardware sapce ] | |

+ ------------------------------------------------------

+ | network interface |

+ ------------------------------------------------------

+

+```

+对于透传或者部分透传(例如七层头部解析后透明代理请求体)之类的需求场景来说, 这种流程的成本无疑是很高的, 可以总结下涉及的几个浪费点

+

+- 数据需要从内核态拷贝到用户态

+- 应用层在 read 及 write 的过程中对这部分 byte 的操作开销(申请、释放、对象池维护等)

+

+#### splice 介绍

+```c

+/*

+ splice() moves data between two file descriptors without copying

+ between kernel address space and user address space. It

+ transfers up to len bytes of data from the file descriptor fd_in

+ to the file descriptor fd_out, where one of the file descriptors

+ must refer to a pipe.

+*/

+ssize_t splice(int fd_in, off64_t *off_in, int fd_out,

+ off64_t *off_out, size_t len, unsigned int flags);

+```

+一句话概括就是, `splice` 不需要从内核空间复制这部分数据到用户空间就可以支持将数据从两个文件描述符之间进行转移, 不过两个描述符至少得有一个是 `pipe`, 以下列举如何利用`splice`完成 `socket->socket` 的数据代理

+

+example:

+```go

+func example(src, dst net.Conn) {

+ // 由于 src 及 dst 都是 socket, 没法直接使用 splice, 因此先创建临时 pipe

+ const flags = syscall.O_CLOEXEC | syscall.O_NONBLOCK

+ var fds [2]int // readfd, writefd

+ if err := syscall.Pipe2(fds[:], flags); err != nil {

+ panic(err)

+ }

+ // 使用完后关闭 pipe

+ defer syscall.Close(fds[0])

+ defer syscall.Close(fds[1])

+ // 获取 src fd

+ srcfile, err := src.(*net.TCPConn).File()

+ if err != nil {

+ panic(err)

+ }

+ srcfd := int(srcfile.Fd())

+ syscall.SetNonblock(srcfd, true)

+ ...

+ // 从 srcfd 读出, 写入 fds[1] (pipe write fd)

+ num, err := syscall.Splice(srcfd, nil, fds[1], nil, DEFAULTSIZE/* size to splice */, SPLICE_F_NONBLOCK)

+ ...

+}

+```

+此时的调用过程变为:

+

+```shell

+[ user space ]

+

+ -----------------------------------------------------------------------------------------------

+ | application |

+ -----------------------------------------------------------------------------------------------

+ ········································|····················|·····················|··································

+ | splice() | pipe() | splice()

+[ kernel space ] | | |

+ ----------------- ”copy“ ----------------------- ”copy“ -----------------

+ | socket buffer |· · · · · · · · · >| pipe writefd & readfd |· · · · · · · · >| socket buffer |

+ ----------------- ----------------------- -----------------

+ | copy |

+ ····················|··············································································|

+[ hardware sapce ] | |

+ -----------------------------------------------------------------------------------------------

+ | network interface |

+ -----------------------------------------------------------------------------------------------

+```

+此时产生的系统调用为

+- 首先 `pipe()` 调用, 创建临时管道

+- 调用 `splice()` 将 `srcfd` 数据 ”拷贝“ 到 `pipe`

+- 调用 `splice()` 将 `pipe` 中的数据 ”拷贝“ 到 `dstfd`

+

+可以注意到图中以及总结部分的”拷贝“给加了引号, 具体了解过`pipe`底层实现的小伙伴应该理解, 在这边简单表述下, `splice` 是基于 `pipe buffer` 实现的, 本质上在数据传输的时候并没有进行数据的拷贝, 而是仅仅将数据的内存地址等信息塞进了`pipe_buffer`中对应的字段

+

+至此, 完成了 kernel-user space 的拷贝优化, 不过可能细心的人会发现, 这种方式虽然减少了数据的拷贝, 但是同样额外增加了系统调用(create pipe & close pipe), 接下来就关于这部分的取舍与具体场景进行具体讨论

+

+#### splice 还是 read & write?

+如何取舍使用哪种方式?

+

+两种方法各有各的好处, 往往选择层面的考虑在于应用层的具体策略, 如是否进行透传(/部分), 饥饿问题, 对象池策略等等

+

+下面提供几种场景下的测试以供参考

+benchmark 代码:

+```go

+/*

+ * 测试环境: go 1.14.3 centos7

+ */

+package main

+

+import (

+ "bytes"

+ "io"

+ "net"

+ "net/http"

+ "sync"

+ "sync/atomic"

+ "testing"

+ "time"

+)

+

+var (

+ p sync.Pool

+)

+

+func init() {

+ p.New = func() interface{} {

+ return make([]byte, DEFAULTSIZE)

+ }

+}

+

+const (

+ // mock http 请求体大小

+ REQUESTBYTESIZE = 0

+ // 应用层对象池 byte 大小

+ DEFAULTSIZE = 1 << 10

+

+ SPLICE_F_MOVE = 0x1

+ SPLICE_F_NONBLOCK = 0x2

+ SPLICE_F_MORE = 0x4

+ SPLICE_F_GIFT = 0x8

+)

+// io.Copy 该场景下内部调用 splice syscall, 感兴趣的自行查看源码

+func gosplice(src, dst net.Conn) {

+ defer src.Close()

+ defer dst.Close()

+ go func() {

+ io.Copy(src, dst)

+ }()

+ io.Copy(dst, src)

+}

+

+func normal(src, dst net.Conn) {

+ defer src.Close()

+ defer dst.Close()

+ var bts []byte = p.Get().([]byte)

+ var bts2 []byte = p.Get().([]byte)

+ defer p.Put(bts)

+ defer p.Put(bts2)

+ go func() {

+ for {

+ num, err := dst.Read(bts2[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = src.Write(bts2[num_write:num])

+ num -= num_write

+ if err != nil {

+ return

+ }

+ }

+ }

+ }()

+ // local to mock serve

+ for {

+ num, err := src.Read(bts[:])

+ if err != nil {

+ break

+ }

+ var num_write int

+ for num > 0 {

+ num_write, err = dst.Write(bts[num_write:num])

+ num -= num_write

+ if err != nil {

+ return

+ }

+ }

+ }

+}

+

+// Server http server

+var Server *http.Server

+

+type s struct{}

+

+func (ss s) ServeHTTP(res http.ResponseWriter, req *http.Request) {

+ res.WriteHeader(200)

+ return

+}

+func TestMain(m *testing.M) {

+ // mock tcp server

+ var ss s

+ go func() {

+ Server = &http.Server{

+ Addr: "0.0.0.0:9610",

+ Handler: ss,

+ WriteTimeout: 60 * time.Second,

+ ReadTimeout: 60 * time.Second,

+ }

+ err := Server.ListenAndServe()

+ if err != nil {

+ panic(err)

+ }

+ }()

+ go func() { // normal 9611

+ l, err := net.ListenTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"),

+ Port: 9611,

+ })

+ if err != nil {

+ panic(err)

+ }

+ for {

+ n, err := l.Accept()

+ if err != nil {

+ continue

+ }

+ remote, err := net.DialTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 0,

+ }, &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 9610,

+ })

+ if err != nil {

+ continue

+ }

+ go normal(n, remote)

+ }

+ }()

+ go func() { // gosplice 9612

+ l, err := net.ListenTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"),

+ Port: 9612,

+ })

+ if err != nil {

+ panic(err)

+ }

+ for {

+ n, err := l.Accept()

+ if err != nil {

+ continue

+ }

+ remote, err := net.DialTCP("tcp4", &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 0,

+ }, &net.TCPAddr{

+ IP: net.ParseIP("0.0.0.0"), Port: 9610,

+ })

+ if err != nil {

+ continue

+ }

+ go gosplice(n, remote)

+ }

+ }()

+ m.Run()

+}

+func BenchmarkNormalReadWrite(b *testing.B) {

+ // normal 9611

+ c := http.Client{

+ Timeout: time.Minute,

+ }

+ var total, success uint32

+ b.ResetTimer()

+ for i := 0; i < b.N; i++ {

+ atomic.AddUint32(&total, 1)

+ req, err := http.NewRequest("POST", "http://0.0.0.0:9611", bytes.NewReader(make([]byte, REQUESTBYTESIZE)))

+ if err != nil {

+ b.Fatalf("%s", err.Error())

+ }

+ res, err := c.Do(req)

+ if err == nil && res.StatusCode == 200 {

+ atomic.AddUint32(&success, 1)

+ }

+ c.CloseIdleConnections()

+ }

+ b.Logf("test:%s,total: %d,rate: %.2f%%\n", b.Name(), total, float64(success*100/total))

+}

+

+func BenchmarkGoSplice(b *testing.B) {

+ // normal 9612

+ c := http.Client{

+ Timeout: time.Minute,

+ }

+ var total, success uint32

+ b.ResetTimer()

+ for i := 0; i < b.N; i++ {

+ atomic.AddUint32(&total, 1)

+ req, err := http.NewRequest("POST", "http://0.0.0.0:9612", bytes.NewReader(make([]byte, REQUESTBYTESIZE)))

+ if err != nil {

+ b.Fatalf("%s", err.Error())

+ }

+ res, err := c.Do(req)

+ if err == nil && res.StatusCode == 200 {

+ atomic.AddUint32(&success, 1)

+ }

+ c.CloseIdleConnections()

+ }

+ b.Logf("test:%s, total: %d, success rate: %.2f%%\n", b.Name(), total, float64(success*100/total))

+}

+```

+- 场景一: 单次请求数据量较少, 应用维护单个 buffer 较小

+```go

+REQUESTBYTESIZE = 0 // http request body

+DEFAULTSIZE = 1 << 10 // buffer size 1kb

+```

+```shell

+RRunning tool: /usr/local/bin/go test -benchmem -run=^$ -bench ^(BenchmarkNormalReadWrite|BenchmarkGoSplice)$ barrier/t

+

+goos: linux

+goarch: amd64

+pkg: barrier/t

+BenchmarkNormalReadWrite-4 6348 179699 ns/op 4847 B/op 62 allocs/op

+--- BENCH: BenchmarkNormalReadWrite-4

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 1,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 100,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 6348,rate: 100.00%

+BenchmarkGoSplice-4 6652 179622 ns/op 4852 B/op 62 allocs/op

+--- BENCH: BenchmarkGoSplice-4

+ test_test.go:194: test:BenchmarkGoSplice, total: 1, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 100, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 6652, success rate: 100.00%

+PASS

+ok barrier/t 2.391s

+```

+两种方式无明显性能差异

+- 场景二: 单次请求数据量多, 应用维护单个 buffer 较小

+```go

+REQUESTBYTESIZE = 1 << 20 // 1 MB

+DEFAULTSIZE = 1 << 10 // buffer size 1kb

+```

+```shell

+Running tool: /usr/local/bin/go test -benchmem -run=^$ -bench ^(BenchmarkNormalReadWrite|BenchmarkGoSplice)$ barrier/t

+

+goos: linux

+goarch: amd64

+pkg: barrier/t

+BenchmarkNormalReadWrite-4 465 2329209 ns/op 1073956 B/op 163 allocs/op

+--- BENCH: BenchmarkNormalReadWrite-4

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 1,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 100,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 376,rate: 100.00%

+ test_test.go:173: test:BenchmarkNormalReadWrite,total: 465,rate: 100.00%

+BenchmarkGoSplice-4 963 1555386 ns/op 1070506 B/op 157 allocs/op

+--- BENCH: BenchmarkGoSplice-4

+ test_test.go:194: test:BenchmarkGoSplice, total: 1, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 100, success rate: 100.00%

+ test_test.go:194: test:BenchmarkGoSplice, total: 963, success rate: 100.00%

+PASS

+ok barrier/t 4.056s

+```

+当链接需要处理的数据量较多而应用层每次处理的 buffer 相比起来较小, 以至于需要 read & write 的次数更多的时候, 差异就会比较明显

+

+#### go 中的 splice

+在上面的介绍过程中简单说了下 `io.Copy` 在 `socket` 之间操作的时候, 当机器架构支持的时候会采取 `splice`, 接下来就此进行详细分析来介绍下 `runtime` 在 `splice` 上的一些决策以及当前`runtime`在 `splice` 上的一些不足

+```go

+/*

+ * src/net/spice_linux.go

+ */

+// splice transfers data from r to c using the splice system call to minimize

+// copies from and to userspace. c must be a TCP connection. Currently, splice

+// is only enabled if r is a TCP or a stream-oriented Unix connection.

+//

+// If splice returns handled == false, it has performed no work.

+func splice(c *netFD, r io.Reader) (written int64, err error, handled bool) {

+ /*

+ * 因为前面介绍过 splice 是通过 pipe buffer 实现的

+ * 在调用的时候 kernel无需进行数据拷贝, 仅操作数据原信息(基础字段的指针等)

+ * 所以这边默认 splice 的 len 开得比较大, 读到 EOF 为止

+ */

+ var remain int64 = 1 << 62 // by default, copy until EOF

+ lr, ok := r.(*io.LimitedReader)

+ if ok {

+ remain, r = lr.N, lr.R

+ if remain <= 0 {

+ return 0, nil, true

+ }

+ }

+

+ var s *netFD

+ if tc, ok := r.(*TCPConn); ok {

+ s = tc.fd

+ } else if uc, ok := r.(*UnixConn); ok {

+ if uc.fd.net != "unix" {

+ return 0, nil, false

+ }

+ s = uc.fd

+ } else {

+ return 0, nil, false

+ }

+

+ written, handled, sc, err := poll.Splice(&c.pfd, &s.pfd, remain)

+ if lr != nil {

+ lr.N -= written

+ }

+ return written, wrapSyscallError(sc, err), handled

+}

+```

+```go

+/*

+ * go 1.14.3

+ * src/internal/poll/splice_linux.go

+ */

+// Splice transfers at most remain bytes of data from src to dst, using the

+// splice system call to minimize copies of data from and to userspace.

+//

+// Splice creates a temporary pipe, to serve as a buffer for the data transfer.

+// src and dst must both be stream-oriented sockets.

+//

+// If err != nil, sc is the system call which caused the error.

+func Splice(dst, src *FD, remain int64) (written int64, handled bool, sc string, err error) {

+ // dst 以及 src 均为 socket.fd, 因此若想使用 splice 则需要借助 pipe

+ // 创建临时 pipe

+ prfd, pwfd, sc, err := newTempPipe()

+ if err != nil {

+ return 0, false, sc, err

+ }

+ defer destroyTempPipe(prfd, pwfd)

+ var inPipe, n int

+ for err == nil && remain > 0 {

+ max := maxSpliceSize

+ if int64(max) > remain {

+ max = int(remain)

+ }

+ // spliceDrain 调用 splice syscall

+ inPipe, err = spliceDrain(pwfd, src, max)

+ // The operation is considered handled if splice returns no

+ // error, or an error other than EINVAL. An EINVAL means the

+ // kernel does not support splice for the socket type of src.

+ // The failed syscall does not consume any data so it is safe

+ // to fall back to a generic copy.

+ //

+ // spliceDrain should never return EAGAIN, so if err != nil,

+ // Splice cannot continue.

+ //

+ // If inPipe == 0 && err == nil, src is at EOF, and the

+ // transfer is complete.

+ handled = handled || (err != syscall.EINVAL)

+ if err != nil || (inPipe == 0 && err == nil) {

+ break

+ }

+ // splicePump 调用 splice syscall

+ n, err = splicePump(dst, prfd, inPipe)

+ if n > 0 {

+ written += int64(n)

+ remain -= int64(n)

+ }

+ }

+ if err != nil {

+ return written, handled, "splice", err

+ }

+ return written, true, "", nil

+}

+```

+

+相信上面简短的分析大家也可以看到, 每次在进行 `splice` 的时候都会利用临时 `pipe`, 频繁的创建、销毁, 用户态-内核态的切换会带来非常多不必要的开销, 当前社区内也有关于 `splice temp-pipe` 生命周期的[讨论](https://go-review.googlesource.com/c/go/+/271537/)。

+

+再者, 因为当前关联到 `socket` 的 `splice` 实现在 `runtime` 层面和内置 `io 模型(epoll 等)`高度耦合, 基本无法解耦单独应用, 而如果想自己来实现 `splice(syscall.Splice)` 的话则不得不顺带在用户层面实现自己的`io 模型`再来使用, 会比较繁琐(上面测试用例使用内置 `splice api` 也是因为这个原因)

+

+## 参考资料

+

+- https://go-review.googlesource.com/c/go/+/271537/

+- https://zhuanlan.zhihu.com/p/308054212

+

+ diff --git a/lockfree.md b/lockfree.md

index f9c19d1..261e9cb 100644

--- a/lockfree.md

+++ b/lockfree.md

@@ -1,4 +1,6 @@

# lock free programming in Go

# 参考资料

-https://docs.google.com/presentation/d/1wuNNW-g6v8qizIc_IxAGZTj-49TODKF0TYddTA1VDUo/mobilepresent?slide=id.p

\ No newline at end of file

+https://docs.google.com/presentation/d/1wuNNW-g6v8qizIc_IxAGZTj-49TODKF0TYddTA1VDUo/mobilepresent?slide=id.p

+

+

diff --git a/lockfree.md b/lockfree.md

index f9c19d1..261e9cb 100644

--- a/lockfree.md

+++ b/lockfree.md

@@ -1,4 +1,6 @@

# lock free programming in Go

# 参考资料

-https://docs.google.com/presentation/d/1wuNNW-g6v8qizIc_IxAGZTj-49TODKF0TYddTA1VDUo/mobilepresent?slide=id.p

\ No newline at end of file

+https://docs.google.com/presentation/d/1wuNNW-g6v8qizIc_IxAGZTj-49TODKF0TYddTA1VDUo/mobilepresent?slide=id.p

+

+ diff --git a/map.md b/map.md

index 123cfd8..351146d 100644

--- a/map.md

+++ b/map.md

@@ -1267,3 +1267,5 @@ func (h *hmap) incrnoverflow() {

}

}

```

+

+

diff --git a/map.md b/map.md

index 123cfd8..351146d 100644

--- a/map.md

+++ b/map.md

@@ -1267,3 +1267,5 @@ func (h *hmap) incrnoverflow() {

}

}

```

+

+ diff --git a/memory.md b/memory.md

index d71141a..b937fcf 100644

--- a/memory.md

+++ b/memory.md

@@ -1396,3 +1396,6 @@ func (p *notInHeap) add(bytes uintptr) *notInHeap {

### 堆外内存用法

嗯,堆外内存只是 runtime 自己玩的东西,用户态是使用不了的,属于 runtime 专用的 directive。

+

+

+

diff --git a/memory.md b/memory.md

index d71141a..b937fcf 100644

--- a/memory.md

+++ b/memory.md

@@ -1396,3 +1396,6 @@ func (p *notInHeap) add(bytes uintptr) *notInHeap {

### 堆外内存用法

嗯,堆外内存只是 runtime 自己玩的东西,用户态是使用不了的,属于 runtime 专用的 directive。

+

+

+ diff --git a/memory_barrier.md b/memory_barrier.md

index 94383c0..cc1a7ce 100644

--- a/memory_barrier.md

+++ b/memory_barrier.md

@@ -126,7 +126,7 @@ mesi 协议解决了多核环境下,内存多层级带来的问题。使得 ca

## CPU 导致乱序

-使用 litmus 进行形式化验证:

+使用 litmus 进行验证:

```

cat sb.litmus

@@ -181,6 +181,56 @@ Time SB 0.11

在两个核心上运行汇编指令,意料之外的情况 100w 次中出现了 96 次。虽然很少,但确实是客观存在的情况。

+有文档提到,x86 体系的内存序本身比较严格,除了 store-load 以外不存在其它类型的重排,也可以用下列脚本验证:

+

+```

+X86 RW

+{ x=0; y=0; }

+ P0 | P1 ;

+ MOV EAX,[y] | MOV EAX,[x] ;

+ MOV [x],$1 | MOV [y],$1 ;

+locations [x;y;]

+exists (0:EAX=1 /\ 1:EAX=1)

+```

+

+```

+%%%%%%%%%%%%%%%%%%%%%%%%%

+% Results for sb.litmus %

+%%%%%%%%%%%%%%%%%%%%%%%%%

+X86 OOO

+

+{x=0; y=0;}

+

+ P0 | P1 ;

+ MOV EAX,[y] | MOV EAX,[x] ;

+ MOV [x],$1 | MOV [y],$1 ;

+

+locations [x; y;]

+exists (0:EAX=1 /\ 1:EAX=1)

+Generated assembler

+ ##START _litmus_P0

+ movl -4(%rsi,%rcx,4), %eax

+ movl $1, -4(%rbx,%rcx,4)

+ ##START _litmus_P1

+ movl -4(%rbx,%rcx,4), %eax

+ movl $1, -4(%rsi,%rcx,4)

+

+Test OOO Allowed

+Histogram (2 states)

+500000:>0:EAX=1; 1:EAX=0; x=1; y=1;

+500000:>0:EAX=0; 1:EAX=1; x=1; y=1;

+No

+

+Witnesses

+Positive: 0, Negative: 1000000

+Condition exists (0:EAX=1 /\ 1:EAX=1) is NOT validated

+Hash=7cdd62e8647b817c1615cf8eb9d2117b

+Observation OOO Never 0 1000000

+Time OOO 0.14

+```

+

+无论运行多少次,Positive 应该都是 0。

+

## barrier

从功能上来讲,barrier 有四种:

@@ -519,3 +569,5 @@ https://stackoverflow.com/questions/29880015/lock-prefix-vs-mesi-protocol

https://github.com/torvalds/linux/blob/master/Documentation/memory-barriers.txt

http://www.overbyte.com.au/misc/Lesson3/CacheFun.html

+

+

diff --git a/memory_barrier.md b/memory_barrier.md

index 94383c0..cc1a7ce 100644

--- a/memory_barrier.md

+++ b/memory_barrier.md

@@ -126,7 +126,7 @@ mesi 协议解决了多核环境下,内存多层级带来的问题。使得 ca

## CPU 导致乱序

-使用 litmus 进行形式化验证:

+使用 litmus 进行验证:

```

cat sb.litmus

@@ -181,6 +181,56 @@ Time SB 0.11

在两个核心上运行汇编指令,意料之外的情况 100w 次中出现了 96 次。虽然很少,但确实是客观存在的情况。

+有文档提到,x86 体系的内存序本身比较严格,除了 store-load 以外不存在其它类型的重排,也可以用下列脚本验证:

+

+```

+X86 RW

+{ x=0; y=0; }

+ P0 | P1 ;

+ MOV EAX,[y] | MOV EAX,[x] ;

+ MOV [x],$1 | MOV [y],$1 ;

+locations [x;y;]

+exists (0:EAX=1 /\ 1:EAX=1)

+```

+

+```

+%%%%%%%%%%%%%%%%%%%%%%%%%

+% Results for sb.litmus %

+%%%%%%%%%%%%%%%%%%%%%%%%%

+X86 OOO

+

+{x=0; y=0;}

+

+ P0 | P1 ;

+ MOV EAX,[y] | MOV EAX,[x] ;

+ MOV [x],$1 | MOV [y],$1 ;

+

+locations [x; y;]

+exists (0:EAX=1 /\ 1:EAX=1)

+Generated assembler

+ ##START _litmus_P0

+ movl -4(%rsi,%rcx,4), %eax

+ movl $1, -4(%rbx,%rcx,4)

+ ##START _litmus_P1

+ movl -4(%rbx,%rcx,4), %eax

+ movl $1, -4(%rsi,%rcx,4)

+

+Test OOO Allowed

+Histogram (2 states)

+500000:>0:EAX=1; 1:EAX=0; x=1; y=1;

+500000:>0:EAX=0; 1:EAX=1; x=1; y=1;

+No

+

+Witnesses

+Positive: 0, Negative: 1000000

+Condition exists (0:EAX=1 /\ 1:EAX=1) is NOT validated

+Hash=7cdd62e8647b817c1615cf8eb9d2117b

+Observation OOO Never 0 1000000

+Time OOO 0.14

+```

+

+无论运行多少次,Positive 应该都是 0。

+

## barrier

从功能上来讲,barrier 有四种:

@@ -519,3 +569,5 @@ https://stackoverflow.com/questions/29880015/lock-prefix-vs-mesi-protocol

https://github.com/torvalds/linux/blob/master/Documentation/memory-barriers.txt

http://www.overbyte.com.au/misc/Lesson3/CacheFun.html

+

+ diff --git a/netpoll.md b/netpoll.md

index 942adad..7ab59f9 100644

--- a/netpoll.md

+++ b/netpoll.md

@@ -1355,3 +1355,5 @@ func poll_runtime_pollUnblock(pd *pollDesc) {

}

}

```

+

+

diff --git a/netpoll.md b/netpoll.md

index 942adad..7ab59f9 100644

--- a/netpoll.md

+++ b/netpoll.md

@@ -1355,3 +1355,5 @@ func poll_runtime_pollUnblock(pd *pollDesc) {

}

}

```

+

+ diff --git a/panic.md b/panic.md

index 7765ec1..e34b3ad 100644

--- a/panic.md

+++ b/panic.md

@@ -295,4 +295,6 @@ func main() {

defer panic(2)

panic(1)

}

-```

\ No newline at end of file

+```

+

+

diff --git a/panic.md b/panic.md

index 7765ec1..e34b3ad 100644

--- a/panic.md

+++ b/panic.md

@@ -295,4 +295,6 @@ func main() {

defer panic(2)

panic(1)

}

-```

\ No newline at end of file

+```

+

+ diff --git a/pprof.md b/pprof.md

new file mode 100644

index 0000000..f825a1a

--- /dev/null

+++ b/pprof.md

@@ -0,0 +1,778 @@

+# pprof

+> 本章节没有介绍具体 pprof 以及周边工具的使用, 而是进行了 runtime pprof 实现原理的分析, 旨在提供给读者一个使用方面的参考

+在进行深入本章节之前, 让我们来看三个问题, 相信下面这几个问题也是大部分人在使用 pprof 的时候对它最大的困惑, 那么可以带着这三个问题来进行接下去的分析

+- 开启 pprof 会对 runtime 产生多大的压力?

+- 能否选择性在合适阶段对生产环境的应用进行 pprof 的开启 / 关闭操作?

+- pprof 的原理是什么?

+

+go 内置的 `pprof API` 在 `runtime/pprof` 包内, 它提供给了用户与 `runtime` 交互的能力, 让我们能够在应用运行的过程中分析当前应用的各项指标来辅助进行性能优化以及问题排查, 当然也可以直接加载 `_ "net/http/pprof"` 包使用内置的 `http 接口` 来进行使用, `net` 模块内的 pprof 即为 go 替我们封装好的一系列调用 `runtime/pprof` 的方法, 当然也可以自己直接使用

+```go

+// src/runtime/pprof/pprof.go

+// 可观察类目

+profiles.m = map[string]*Profile{

+ "goroutine": goroutineProfile,

+ "threadcreate": threadcreateProfile,

+ "heap": heapProfile,

+ "allocs": allocsProfile,

+ "block": blockProfile,

+ "mutex": mutexProfile,

+ }

+```

+

+## allocs

+```go

+

+var allocsProfile = &Profile{

+ name: "allocs",

+ count: countHeap, // identical to heap profile

+ write: writeAlloc,

+}

+```

+- writeAlloc (主要涉及以下几个 api)

+ - ReadMemStats(m *MemStats)

+ - MemProfile(p []MemProfileRecord, inuseZero bool)

+

+```go

+// ReadMemStats populates m with memory allocator statistics.

+//

+// The returned memory allocator statistics are up to date as of the

+// call to ReadMemStats. This is in contrast with a heap profile,

+// which is a snapshot as of the most recently completed garbage

+// collection cycle.

+func ReadMemStats(m *MemStats) {

+ // STW 操作

+ stopTheWorld("read mem stats")

+ // systemstack 切换

+ systemstack(func() {

+ // 将 memstats 通过 copy 操作复制给 m

+ readmemstats_m(m)

+ })

+

+ startTheWorld()

+}

+```

+

+```go

+// MemProfile returns a profile of memory allocated and freed per allocation

+// site.

+//

+// MemProfile returns n, the number of records in the current memory profile.

+// If len(p) >= n, MemProfile copies the profile into p and returns n, true.

+// If len(p) < n, MemProfile does not change p and returns n, false.

+//

+// If inuseZero is true, the profile includes allocation records

+// where r.AllocBytes > 0 but r.AllocBytes == r.FreeBytes.

+// These are sites where memory was allocated, but it has all

+// been released back to the runtime.

+//

+// The returned profile may be up to two garbage collection cycles old.

+// This is to avoid skewing the profile toward allocations; because

+// allocations happen in real time but frees are delayed until the garbage

+// collector performs sweeping, the profile only accounts for allocations

+// that have had a chance to be freed by the garbage collector.

+//

+// Most clients should use the runtime/pprof package or

+// the testing package's -test.memprofile flag instead

+// of calling MemProfile directly.

+func MemProfile(p []MemProfileRecord, inuseZero bool) (n int, ok bool) {

+ lock(&proflock)

+ // If we're between mProf_NextCycle and mProf_Flush, take care

+ // of flushing to the active profile so we only have to look

+ // at the active profile below.

+ mProf_FlushLocked()

+ clear := true

+ /*

+ * 记住这个 mbuckets -- memory profile buckets

+ * allocs 的采样都是记录在这个全局变量内, 下面会进行详细分析

+ * -------------------------------------------------

+ * (gdb) info variables mbuckets

+ * All variables matching regular expression "mbuckets":

+

+ * File runtime:

+ * runtime.bucket *runtime.mbuckets;

+ * (gdb)

+ */

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ n++

+ }

+ if mp.active.allocs != 0 || mp.active.frees != 0 {

+ clear = false

+ }

+ }

+ if clear {

+ // Absolutely no data, suggesting that a garbage collection

+ // has not yet happened. In order to allow profiling when

+ // garbage collection is disabled from the beginning of execution,

+ // accumulate all of the cycles, and recount buckets.

+ n = 0

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ for c := range mp.future {

+ mp.active.add(&mp.future[c])

+ mp.future[c] = memRecordCycle{}

+ }

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ n++

+ }

+ }

+ }

+ if n <= len(p) {

+ ok = true

+ idx := 0

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ // mbuckets 数据拷贝

+ record(&p[idx], b)

+ idx++

+ }

+ }

+ }

+ unlock(&proflock)

+ return

+}

+```

+

+总结一下 `pprof/allocs` 所涉及的操作

+- 短暂的 `STW` 以及 `systemstack` 切换来获取 `runtime` 相关信息

+- 拷贝全局对象 `mbuckets` 值返回给用户

+

+### mbuckets

+上文提到, `pprof/allocs` 的核心在于对 `mbuckets` 的操作, 下面用一张图来简单描述下 `mbuckets` 的相关操作

+```go

+var mbuckets *bucket // memory profile buckets

+type bucket struct {

+ next *bucket

+ allnext *bucket

+ typ bucketType // memBucket or blockBucket (includes mutexProfile)

+ hash uintptr

+ size uintptr

+ nstk uintptr

+}

+```

+

+

+```shell

+ ---------------

+ | user access |

+ ---------------

+ |

+ ------------------ |

+| mbuckets list | copy |

+| (global) | -------------------------------------

+ ------------------

+ |

+ |

+ | create_or_get && insert_or_update bucket into mbuckets

+ |

+ |

+ --------------------------------------

+| func stkbucket & typ == memProfile |

+ --------------------------------------

+ |

+ ----------------

+ | mProf_Malloc | // 堆栈等信息记录

+ ----------------

+ |

+ ----------------

+ | profilealloc | // next_sample 计算

+ ----------------

+ |

+ | /*

+ | * if rate := MemProfileRate; rate > 0 {

+ | * if rate != 1 && size < c.next_sample {

+ | * c.next_sample -= size

+ | 采样 * } else {

+ | 记录 * mp := acquirem()

+ | * profilealloc(mp, x, size)

+ | * releasem(mp)

+ | * }

+ | * }

+ | */

+ |

+ ------------ 不采样

+ | mallocgc |-----------...

+ ------------

+```

+

+由上图我们可以清晰的看见, `runtime` 在内存分配的时候会根据一定策略进行采样, 记录到 `mbuckets` 中让用户得以进行分析, 而采样算法有个重要的依赖 `MemProfileRate`

+

+```go

+// MemProfileRate controls the fraction of memory allocations

+// that are recorded and reported in the memory profile.

+// The profiler aims to sample an average of

+// one allocation per MemProfileRate bytes allocated.

+//

+// To include every allocated block in the profile, set MemProfileRate to 1.

+// To turn off profiling entirely, set MemProfileRate to 0.

+//

+// The tools that process the memory profiles assume that the

+// profile rate is constant across the lifetime of the program

+// and equal to the current value. Programs that change the

+// memory profiling rate should do so just once, as early as

+// possible in the execution of the program (for example,

+// at the beginning of main).

+var MemProfileRate int = 512 * 1024

+```

+默认大小是 512 KB, 可以由用户自行配置.

+

+值的注意的是, 由于开启了 pprof 会产生一些采样的额外压力及开销, go 团队已经在较新的编译器中有选择地进行了这个变量的配置以[改变](https://go-review.googlesource.com/c/go/+/299671/8/src/runtime/mprof.go)默认开启的现状

+

+具体方式为代码未进行相关引用则编译器将初始值配置为 0, 否则则为默认(512 KB)

+

+(本文讨论的基于 1.14.3 版本, 如有差异请进行版本确认)

+

+#### pprof/allocs 总结

+- 开启后会对 runtime 产生额外压力, 采样时会在 `runtime malloc` 时记录额外信息以供后续分析

+- 可以人为选择是否开启, 以及采样频率, 通过设置 `runtime.MemProfileRate` 参数, 不同 go 版本存在差异(是否默认开启), 与用户代码内是否引用(linker)相关模块/变量有关, 默认大小为 512 KB

+

+`allocs` 部分还包含了 `heap` 情况的近似计算, 放在下一节分析

+## heap

+>allocs: A sampling of all past memory allocations

+

+>heap: A sampling of memory allocations of live objects. You can specify the gc GET parameter to run GC before taking the heap sample.

+

+对比下 `allocs` 和 `heap` 官方说明上的区别, 一个是分析所有内存分配的情况, 一个是当前 `heap` 上的分配情况. `heap` 还能使用额外参数运行一次 `GC` 后再进行分析

+

+看起来两者差别很大。。。不过实质上在代码层面两者除了一次 `GC` 可以人为调用以及生成的文件类型不同之外 (debug == 0 的时候) 之外没啥区别.

+

+### heap 采样(伪)

+```go

+// p 为上文提到过的 MemProfileRecord 采样记录

+for _, r := range p {

+ hideRuntime := true

+ for tries := 0; tries < 2; tries++ {

+ stk := r.Stack()

+ // For heap profiles, all stack

+ // addresses are return PCs, which is

+ // what appendLocsForStack expects.

+ if hideRuntime {

+ for i, addr := range stk {

+ if f := runtime.FuncForPC(addr); f != nil && strings.HasPrefix(f.Name(), "runtime.") {

+ continue

+ }

+ // Found non-runtime. Show any runtime uses above it.

+ stk = stk[i:]

+ break

+ }

+ }

+ locs = b.appendLocsForStack(locs[:0], stk)

+ if len(locs) > 0 {

+ break

+ }

+ hideRuntime = false // try again, and show all frames next time.

+ }

+ // rate 即为 runtime.MemProfileRate

+ values[0], values[1] = scaleHeapSample(r.AllocObjects, r.AllocBytes, rate)

+ values[2], values[3] = scaleHeapSample(r.InUseObjects(), r.InUseBytes(), rate)

+ var blockSize int64

+ if r.AllocObjects > 0 {

+ blockSize = r.AllocBytes / r.AllocObjects

+ }

+ b.pbSample(values, locs, func() {

+ if blockSize != 0 {

+ b.pbLabel(tagSample_Label, "bytes", "", blockSize)

+ }

+ })

+ }

+```

+```go

+// scaleHeapSample adjusts the data from a heap Sample to

+// account for its probability of appearing in the collected

+// data. heap profiles are a sampling of the memory allocations

+// requests in a program. We estimate the unsampled value by dividing

+// each collected sample by its probability of appearing in the

+// profile. heap profiles rely on a poisson process to determine

+// which samples to collect, based on the desired average collection

+// rate R. The probability of a sample of size S to appear in that

+// profile is 1-exp(-S/R).

+func scaleHeapSample(count, size, rate int64) (int64, int64) {

+ if count == 0 || size == 0 {

+ return 0, 0

+ }

+

+ if rate <= 1 {

+ // if rate==1 all samples were collected so no adjustment is needed.

+ // if rate<1 treat as unknown and skip scaling.

+ return count, size

+ }

+

+ avgSize := float64(size) / float64(count)

+ scale := 1 / (1 - math.Exp(-avgSize/float64(rate)))

+

+ return int64(float64(count) * scale), int64(float64(size) * scale)

+}

+```

+

+为什么要在标题里加个伪? 看上面代码片段也可以注意到, 实质上在 `pprof` 分析的时候并没有扫描所有堆上内存进行分析 (想想也不现实) , 而是通过之前采样出的数据, 进行计算 (现有对象数量, 大小, 采样率等) 来估算出 `heap` 上的情况, 当然给我们参考一般来说是足够了

+

+## goroutine

+- debug >= 2 的情况, 直接进行堆栈输出, 详情可以查看 [stack](runtime_stack.md) 章节

+

+```go

+// fetch == runtime.GoroutineProfile

+func writeRuntimeProfile(w io.Writer, debug int, name string, fetch func([]runtime.StackRecord) (int, bool)) error {

+ // Find out how many records there are (fetch(nil)),

+ // allocate that many records, and get the data.

+ // There's a race—more records might be added between

+ // the two calls—so allocate a few extra records for safety

+ // and also try again if we're very unlucky.

+ // The loop should only execute one iteration in the common case.

+ var p []runtime.StackRecord

+ n, ok := fetch(nil)

+ for {

+ // Allocate room for a slightly bigger profile,

+ // in case a few more entries have been added

+ // since the call to ThreadProfile.

+ p = make([]runtime.StackRecord, n+10)

+ n, ok = fetch(p)

+ if ok {

+ p = p[0:n]

+ break

+ }

+ // Profile grew; try again.

+ }

+

+ return printCountProfile(w, debug, name, runtimeProfile(p))

+}

+```

+

+```go

+// GoroutineProfile returns n, the number of records in the active goroutine stack profile.

+// If len(p) >= n, GoroutineProfile copies the profile into p and returns n, true.

+// If len(p) < n, GoroutineProfile does not change p and returns n, false.

+//

+// Most clients should use the runtime/pprof package instead

+// of calling GoroutineProfile directly.

+func GoroutineProfile(p []StackRecord) (n int, ok bool) {

+ gp := getg()

+

+ isOK := func(gp1 *g) bool {

+ // Checking isSystemGoroutine here makes GoroutineProfile

+ // consistent with both NumGoroutine and Stack.

+ return gp1 != gp && readgstatus(gp1) != _Gdead && !isSystemGoroutine(gp1, false)

+ }

+ // 熟悉的味道, STW 又来了

+ stopTheWorld("profile")

+ // 统计有多少 goroutine

+ n = 1

+ for _, gp1 := range allgs {

+ if isOK(gp1) {

+ n++

+ }

+ }

+ // 当传入的 p 非空的时候, 开始获取各个 goroutine 信息, 整体姿势和 stack api 几乎一模一样

+ if n <= len(p) {

+ ok = true

+ r := p

+

+ // Save current goroutine.

+ sp := getcallersp()

+ pc := getcallerpc()

+ systemstack(func() {

+ saveg(pc, sp, gp, &r[0])

+ })

+ r = r[1:]

+

+ // Save other goroutines.

+ for _, gp1 := range allgs {

+ if isOK(gp1) {

+ if len(r) == 0 {

+ // Should be impossible, but better to return a

+ // truncated profile than to crash the entire process.

+ break

+ }

+ saveg(^uintptr(0), ^uintptr(0), gp1, &r[0])

+ r = r[1:]

+ }

+ }

+ }

+

+ startTheWorld()

+

+ return n, ok

+}

+```

+总结下 `pprof/goroutine`

+- STW 操作, 如果需要观察详情的需要注意这个 API 带来的风险

+- 整体流程基本就是 stackdump 所有协程信息的流程, 差别不大没什么好讲的, 不熟悉的可以去看下 stack 对应章节

+

+## pprof/threadcreate

+可能会有人想问, 我们通常只关注 `goroutine` 就够了, 为什么还需要对线程的一些情况进行追踪? 例如无法被抢占的阻塞性[系统调用](syscall.md), `cgo` 相关的线程等等, 都可以利用它来进行一个简单的分析, 当然大多数情况考虑的线程问题(诸如泄露等), 一般都是上层的使用问题所导致的(线程泄露等)

+```go

+// 还是用之前用过的无法被抢占的阻塞性系统调用来进行一个简单的实验

+package main

+

+import (

+ "fmt"

+ "net/http"

+ _ "net/http/pprof"

+ "os"

+ "syscall"

+ "unsafe"

+)

+

+const (

+ SYS_futex = 202

+ _FUTEX_PRIVATE_FLAG = 128

+ _FUTEX_WAIT = 0

+ _FUTEX_WAKE = 1

+ _FUTEX_WAIT_PRIVATE = _FUTEX_WAIT | _FUTEX_PRIVATE_FLAG

+ _FUTEX_WAKE_PRIVATE = _FUTEX_WAKE | _FUTEX_PRIVATE_FLAG

+)

+

+func main() {

+ fmt.Println(os.Getpid())

+ go func() {

+ b := make([]byte, 1<<20)

+ _ = b

+ }()

+ for i := 1; i < 13; i++ {

+ go func() {

+ var futexVar int = 0

+ for {

+ // Syscall && RawSyscall, 具体差别分析可自行查看 syscall 章节

+ fmt.Println(syscall.Syscall6(

+ SYS_futex, // trap AX 202

+ uintptr(unsafe.Pointer(&futexVar)), // a1 DI 1

+ uintptr(_FUTEX_WAIT), // a2 SI 0

+ 0, // a3 DX

+ 0, //uintptr(unsafe.Pointer(&ts)), // a4 R10

+ 0, // a5 R8

+ 0))

+ }

+ }()

+ }

+ http.ListenAndServe("0.0.0.0:8899", nil)

+}

+```

+```shell

+# GET /debug/pprof/threadcreate?debug=1

+threadcreate profile: total 18

+17 @

+# 0x0

+

+1 @ 0x43b818 0x43bfa3 0x43c272 0x43857d 0x467fb1

+# 0x43b817 runtime.allocm+0x157 /usr/local/go/src/runtime/proc.go:1414

+# 0x43bfa2 runtime.newm+0x42 /usr/local/go/src/runtime/proc.go:1736

+# 0x43c271 runtime.startTemplateThread+0xb1 /usr/local/go/src/runtime/proc.go:1805

+# 0x43857c runtime.main+0x18c /usr/local/go/src/runtime/proc.go:186

+```

+```shell

+# 再结合诸如 pstack 的工具

+ps -efT | grep 22298 # pid = 22298

+root 22298 22298 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22299 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22300 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22301 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22302 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22303 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22304 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22305 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22306 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22307 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22308 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22309 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22310 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22311 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22312 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22316 13767 0 16:59 pts/4 00:00:00 ./mstest

+root 22298 22317 13767 0 16:59 pts/4 00:00:00 ./mstest

+

+pstack 22299

+Thread 1 (process 22299):

+#0 runtime.futex () at /usr/local/go/src/runtime/sys_linux_amd64.s:568

+#1 0x00000000004326f4 in runtime.futexsleep (addr=0xb2fd78

diff --git a/pprof.md b/pprof.md

new file mode 100644

index 0000000..f825a1a

--- /dev/null

+++ b/pprof.md

@@ -0,0 +1,778 @@

+# pprof

+> 本章节没有介绍具体 pprof 以及周边工具的使用, 而是进行了 runtime pprof 实现原理的分析, 旨在提供给读者一个使用方面的参考

+在进行深入本章节之前, 让我们来看三个问题, 相信下面这几个问题也是大部分人在使用 pprof 的时候对它最大的困惑, 那么可以带着这三个问题来进行接下去的分析

+- 开启 pprof 会对 runtime 产生多大的压力?

+- 能否选择性在合适阶段对生产环境的应用进行 pprof 的开启 / 关闭操作?

+- pprof 的原理是什么?

+

+go 内置的 `pprof API` 在 `runtime/pprof` 包内, 它提供给了用户与 `runtime` 交互的能力, 让我们能够在应用运行的过程中分析当前应用的各项指标来辅助进行性能优化以及问题排查, 当然也可以直接加载 `_ "net/http/pprof"` 包使用内置的 `http 接口` 来进行使用, `net` 模块内的 pprof 即为 go 替我们封装好的一系列调用 `runtime/pprof` 的方法, 当然也可以自己直接使用

+```go

+// src/runtime/pprof/pprof.go

+// 可观察类目

+profiles.m = map[string]*Profile{

+ "goroutine": goroutineProfile,

+ "threadcreate": threadcreateProfile,

+ "heap": heapProfile,

+ "allocs": allocsProfile,

+ "block": blockProfile,

+ "mutex": mutexProfile,

+ }

+```

+

+## allocs

+```go

+

+var allocsProfile = &Profile{

+ name: "allocs",

+ count: countHeap, // identical to heap profile

+ write: writeAlloc,

+}

+```

+- writeAlloc (主要涉及以下几个 api)

+ - ReadMemStats(m *MemStats)

+ - MemProfile(p []MemProfileRecord, inuseZero bool)

+

+```go

+// ReadMemStats populates m with memory allocator statistics.

+//

+// The returned memory allocator statistics are up to date as of the

+// call to ReadMemStats. This is in contrast with a heap profile,

+// which is a snapshot as of the most recently completed garbage

+// collection cycle.

+func ReadMemStats(m *MemStats) {

+ // STW 操作

+ stopTheWorld("read mem stats")

+ // systemstack 切换

+ systemstack(func() {

+ // 将 memstats 通过 copy 操作复制给 m

+ readmemstats_m(m)

+ })

+

+ startTheWorld()

+}

+```

+

+```go

+// MemProfile returns a profile of memory allocated and freed per allocation

+// site.

+//

+// MemProfile returns n, the number of records in the current memory profile.

+// If len(p) >= n, MemProfile copies the profile into p and returns n, true.

+// If len(p) < n, MemProfile does not change p and returns n, false.

+//

+// If inuseZero is true, the profile includes allocation records

+// where r.AllocBytes > 0 but r.AllocBytes == r.FreeBytes.

+// These are sites where memory was allocated, but it has all

+// been released back to the runtime.

+//

+// The returned profile may be up to two garbage collection cycles old.

+// This is to avoid skewing the profile toward allocations; because

+// allocations happen in real time but frees are delayed until the garbage

+// collector performs sweeping, the profile only accounts for allocations

+// that have had a chance to be freed by the garbage collector.

+//

+// Most clients should use the runtime/pprof package or

+// the testing package's -test.memprofile flag instead

+// of calling MemProfile directly.

+func MemProfile(p []MemProfileRecord, inuseZero bool) (n int, ok bool) {

+ lock(&proflock)

+ // If we're between mProf_NextCycle and mProf_Flush, take care

+ // of flushing to the active profile so we only have to look

+ // at the active profile below.

+ mProf_FlushLocked()

+ clear := true

+ /*

+ * 记住这个 mbuckets -- memory profile buckets

+ * allocs 的采样都是记录在这个全局变量内, 下面会进行详细分析

+ * -------------------------------------------------

+ * (gdb) info variables mbuckets

+ * All variables matching regular expression "mbuckets":

+

+ * File runtime:

+ * runtime.bucket *runtime.mbuckets;

+ * (gdb)

+ */

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ n++

+ }

+ if mp.active.allocs != 0 || mp.active.frees != 0 {

+ clear = false

+ }

+ }

+ if clear {

+ // Absolutely no data, suggesting that a garbage collection

+ // has not yet happened. In order to allow profiling when

+ // garbage collection is disabled from the beginning of execution,

+ // accumulate all of the cycles, and recount buckets.

+ n = 0

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ for c := range mp.future {

+ mp.active.add(&mp.future[c])

+ mp.future[c] = memRecordCycle{}

+ }

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ n++

+ }

+ }

+ }

+ if n <= len(p) {

+ ok = true

+ idx := 0

+ for b := mbuckets; b != nil; b = b.allnext {

+ mp := b.mp()

+ if inuseZero || mp.active.alloc_bytes != mp.active.free_bytes {

+ // mbuckets 数据拷贝

+ record(&p[idx], b)

+ idx++

+ }

+ }

+ }

+ unlock(&proflock)

+ return

+}

+```

+

+总结一下 `pprof/allocs` 所涉及的操作

+- 短暂的 `STW` 以及 `systemstack` 切换来获取 `runtime` 相关信息

+- 拷贝全局对象 `mbuckets` 值返回给用户

+

+### mbuckets

+上文提到, `pprof/allocs` 的核心在于对 `mbuckets` 的操作, 下面用一张图来简单描述下 `mbuckets` 的相关操作

+```go

+var mbuckets *bucket // memory profile buckets

+type bucket struct {

+ next *bucket

+ allnext *bucket

+ typ bucketType // memBucket or blockBucket (includes mutexProfile)

+ hash uintptr

+ size uintptr

+ nstk uintptr

+}

+```

+

+

+```shell

+ ---------------

+ | user access |

+ ---------------

+ |

+ ------------------ |

+| mbuckets list | copy |

+| (global) | -------------------------------------

+ ------------------

+ |

+ |

+ | create_or_get && insert_or_update bucket into mbuckets

+ |

+ |

+ --------------------------------------

+| func stkbucket & typ == memProfile |

+ --------------------------------------

+ |

+ ----------------

+ | mProf_Malloc | // 堆栈等信息记录

+ ----------------

+ |

+ ----------------

+ | profilealloc | // next_sample 计算

+ ----------------

+ |

+ | /*

+ | * if rate := MemProfileRate; rate > 0 {

+ | * if rate != 1 && size < c.next_sample {

+ | * c.next_sample -= size

+ | 采样 * } else {

+ | 记录 * mp := acquirem()

+ | * profilealloc(mp, x, size)

+ | * releasem(mp)

+ | * }

+ | * }

+ | */

+ |

+ ------------ 不采样

+ | mallocgc |-----------...

+ ------------

+```

+

+由上图我们可以清晰的看见, `runtime` 在内存分配的时候会根据一定策略进行采样, 记录到 `mbuckets` 中让用户得以进行分析, 而采样算法有个重要的依赖 `MemProfileRate`

+

+```go

+// MemProfileRate controls the fraction of memory allocations

+// that are recorded and reported in the memory profile.

+// The profiler aims to sample an average of

+// one allocation per MemProfileRate bytes allocated.

+//

+// To include every allocated block in the profile, set MemProfileRate to 1.

+// To turn off profiling entirely, set MemProfileRate to 0.

+//

+// The tools that process the memory profiles assume that the

+// profile rate is constant across the lifetime of the program

+// and equal to the current value. Programs that change the

+// memory profiling rate should do so just once, as early as

+// possible in the execution of the program (for example,

+// at the beginning of main).

+var MemProfileRate int = 512 * 1024

+```

+默认大小是 512 KB, 可以由用户自行配置.

+

+值的注意的是, 由于开启了 pprof 会产生一些采样的额外压力及开销, go 团队已经在较新的编译器中有选择地进行了这个变量的配置以[改变](https://go-review.googlesource.com/c/go/+/299671/8/src/runtime/mprof.go)默认开启的现状

+

+具体方式为代码未进行相关引用则编译器将初始值配置为 0, 否则则为默认(512 KB)

+

+(本文讨论的基于 1.14.3 版本, 如有差异请进行版本确认)

+

+#### pprof/allocs 总结

+- 开启后会对 runtime 产生额外压力, 采样时会在 `runtime malloc` 时记录额外信息以供后续分析

+- 可以人为选择是否开启, 以及采样频率, 通过设置 `runtime.MemProfileRate` 参数, 不同 go 版本存在差异(是否默认开启), 与用户代码内是否引用(linker)相关模块/变量有关, 默认大小为 512 KB

+

+`allocs` 部分还包含了 `heap` 情况的近似计算, 放在下一节分析

+## heap

+>allocs: A sampling of all past memory allocations

+

+>heap: A sampling of memory allocations of live objects. You can specify the gc GET parameter to run GC before taking the heap sample.

+

+对比下 `allocs` 和 `heap` 官方说明上的区别, 一个是分析所有内存分配的情况, 一个是当前 `heap` 上的分配情况. `heap` 还能使用额外参数运行一次 `GC` 后再进行分析

+

+看起来两者差别很大。。。不过实质上在代码层面两者除了一次 `GC` 可以人为调用以及生成的文件类型不同之外 (debug == 0 的时候) 之外没啥区别.

+

+### heap 采样(伪)

+```go

+// p 为上文提到过的 MemProfileRecord 采样记录

+for _, r := range p {

+ hideRuntime := true

+ for tries := 0; tries < 2; tries++ {

+ stk := r.Stack()

+ // For heap profiles, all stack

+ // addresses are return PCs, which is

+ // what appendLocsForStack expects.

+ if hideRuntime {

+ for i, addr := range stk {

+ if f := runtime.FuncForPC(addr); f != nil && strings.HasPrefix(f.Name(), "runtime.") {

+ continue

+ }

+ // Found non-runtime. Show any runtime uses above it.

+ stk = stk[i:]

+ break

+ }

+ }

+ locs = b.appendLocsForStack(locs[:0], stk)

+ if len(locs) > 0 {

+ break

+ }

+ hideRuntime = false // try again, and show all frames next time.

+ }

+ // rate 即为 runtime.MemProfileRate

+ values[0], values[1] = scaleHeapSample(r.AllocObjects, r.AllocBytes, rate)

+ values[2], values[3] = scaleHeapSample(r.InUseObjects(), r.InUseBytes(), rate)

+ var blockSize int64

+ if r.AllocObjects > 0 {

+ blockSize = r.AllocBytes / r.AllocObjects

+ }

+ b.pbSample(values, locs, func() {

+ if blockSize != 0 {

+ b.pbLabel(tagSample_Label, "bytes", "", blockSize)

+ }

+ })

+ }

+```

+```go

+// scaleHeapSample adjusts the data from a heap Sample to

+// account for its probability of appearing in the collected

+// data. heap profiles are a sampling of the memory allocations

+// requests in a program. We estimate the unsampled value by dividing

+// each collected sample by its probability of appearing in the

+// profile. heap profiles rely on a poisson process to determine

+// which samples to collect, based on the desired average collection

+// rate R. The probability of a sample of size S to appear in that

+// profile is 1-exp(-S/R).

+func scaleHeapSample(count, size, rate int64) (int64, int64) {

+ if count == 0 || size == 0 {

+ return 0, 0

+ }

+

+ if rate <= 1 {

+ // if rate==1 all samples were collected so no adjustment is needed.

+ // if rate<1 treat as unknown and skip scaling.