From 5dda3425451094f416a6486b9d128e1f619a514c Mon Sep 17 00:00:00 2001

From: dabin <1713476357@qq.com>

Date: Sat, 12 Aug 2023 11:14:21 +0800

Subject: [PATCH 1/8] update

---

.../excellent-article/29-idempotent-design.md | 1 +

.../excellent-article/30-yi-di-duo-huo.md | 563 ++++++++++++++++++

.../31-mysql-data-sync-es.md | 503 ++++++++++++++++

docs/learn/ghelper.md | 29 +-

docs/note/docker-note.md | 15 +

docs/note/write-sql.md | 93 +++

docs/zsxq/article/select-max-rows.md | 225 +++++++

docs/zsxq/article/sql-optimize.md | 196 ++++++

docs/zsxq/introduce.md | 2 +-

docs/zsxq/question/qa-or-java.md | 29 +

docs/zsxq/share/completable-future-bug.md | 250 ++++++++

docs/zsxq/share/oom.md | 13 +

docs/zsxq/share/slow-query.md | 62 ++

.../zsxq/share/spring-upgrade-copy-problem.md | 146 +++++

package-lock.json | 159 +++++

15 files changed, 2280 insertions(+), 6 deletions(-)

create mode 100644 docs/advance/excellent-article/30-yi-di-duo-huo.md

create mode 100644 docs/advance/excellent-article/31-mysql-data-sync-es.md

create mode 100644 docs/note/docker-note.md

create mode 100644 docs/note/write-sql.md

create mode 100644 docs/zsxq/article/select-max-rows.md

create mode 100644 docs/zsxq/article/sql-optimize.md

create mode 100644 docs/zsxq/question/qa-or-java.md

create mode 100644 docs/zsxq/share/completable-future-bug.md

create mode 100644 docs/zsxq/share/oom.md

create mode 100644 docs/zsxq/share/slow-query.md

create mode 100644 docs/zsxq/share/spring-upgrade-copy-problem.md

diff --git a/docs/advance/excellent-article/29-idempotent-design.md b/docs/advance/excellent-article/29-idempotent-design.md

index 3ab7b34..6cf7d5b 100644

--- a/docs/advance/excellent-article/29-idempotent-design.md

+++ b/docs/advance/excellent-article/29-idempotent-design.md

@@ -12,6 +12,7 @@ head:

- name: description

content: 努力打造最优质的Java学习网站

---

+

## 接口的幂等性如何设计?

分布式系统中的某个接口,该如何保证幂等性?

diff --git a/docs/advance/excellent-article/30-yi-di-duo-huo.md b/docs/advance/excellent-article/30-yi-di-duo-huo.md

new file mode 100644

index 0000000..75657f1

--- /dev/null

+++ b/docs/advance/excellent-article/30-yi-di-duo-huo.md

@@ -0,0 +1,563 @@

+---

+sidebar: heading

+title: 异地多活

+category: 优质文章

+tag:

+ - 架构

+head:

+ - - meta

+ - name: keywords

+ content: 异地多活,同城灾备,同城双活,两地三中心,异地双活,异地多活

+ - - meta

+ - name: description

+ content: 努力打造最优质的Java学习网站

+---

+

+在软件开发领域,「异地多活」是分布式系统架构设计的一座高峰,很多人经常听过它,但很少人理解其中的原理。

+

+**异地多活到底是什么?为什么需要异地多活?它到底解决了什么问题?究竟是怎么解决的?**

+

+这些疑问,想必是每个程序看到异地多活这个名词时,都想要搞明白的问题。

+

+有幸,我曾经深度参与过一个中等互联网公司,建设异地多活系统的设计与实施过程。所以今天,我就来和你聊一聊异地多活背后的的实现原理。

+

+认真读完这篇文章,我相信你会对异地多活架构,有更加深刻的理解。

+

+**这篇文章干货很多,希望你可以耐心读完。**

+

+

+

+

+

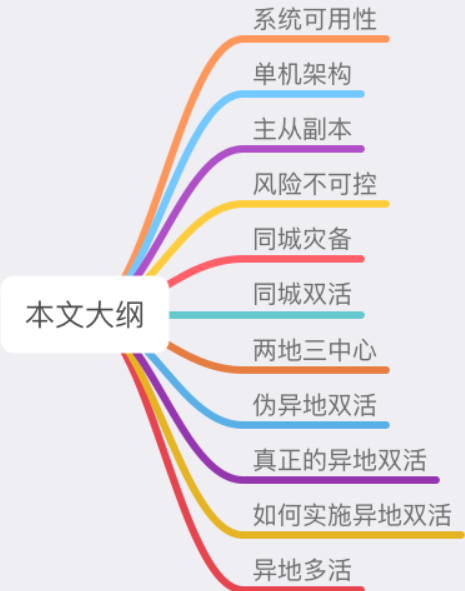

+# 01 系统可用性

+

+要想理解异地多活,我们需要从架构设计的原则说起。

+

+现如今,我们开发一个软件系统,对其要求越来越高,如果你了解一些「架构设计」的要求,就知道一个好的软件架构应该遵循以下 3 个原则:

+

+1. 高性能

+2. 高可用

+3. 易扩展

+

+其中,高性能意味着系统拥有更大流量的处理能力,更低的响应延迟。例如 1 秒可处理 10W 并发请求,接口响应时间 5 ms 等等。

+

+易扩展表示系统在迭代新功能时,能以最小的代价去扩展,系统遇到流量压力时,可以在不改动代码的前提下,去扩容系统。

+

+而「高可用」这个概念,看起来很抽象,怎么理解它呢?通常用 2 个指标来衡量:

+

+- **平均故障间隔 MTBF**(Mean Time Between Failure):表示两次故障的间隔时间,也就是系统「正常运行」的平均时间,这个时间越长,说明系统稳定性越高

+- **故障恢复时间 MTTR**(Mean Time To Repair):表示系统发生故障后「恢复的时间」,这个值越小,故障对用户的影响越小

+

+可用性与这两者的关系:

+

+> 可用性(Availability)= MTBF / (MTBF + MTTR) * 100%

+

+这个公式得出的结果是一个「比例」,通常我们会用「N 个 9」来描述一个系统的可用性。

+

+

+

+从这张图你可以看到,要想达到 4 个 9 以上的可用性,平均每天故障时间必须控制在 10 秒以内。

+

+也就是说,只有故障的时间「越短」,整个系统的可用性才会越高,每提升 1 个 9,都会对系统提出更高的要求。

+

+我们都知道,系统发生故障其实是不可避免的,尤其是规模越大的系统,发生问题的概率也越大。这些故障一般体现在 3 个方面:

+

+1. **硬件故障**:CPU、内存、磁盘、网卡、交换机、路由器

+2. **软件问题**:代码 Bug、版本迭代

+3. **不可抗力**:地震、水灾、火灾、战争

+

+这些风险随时都有可能发生。所以,在面对故障时,我们的系统能否以「最快」的速度恢复,就成为了可用性的关键。

+

+可如何做到快速恢复呢?

+

+这篇文章要讲的「异地多活」架构,就是为了解决这个问题,而提出的高效解决方案。

+

+下面,我会从一个最简单的系统出发,带你一步步演化出一个支持「异地多活」的系统架构。

+

+在这个过程中,你会看到一个系统会遇到哪些可用性问题,以及为什么架构要这样演进,从而理解异地多活架构的意义。

+

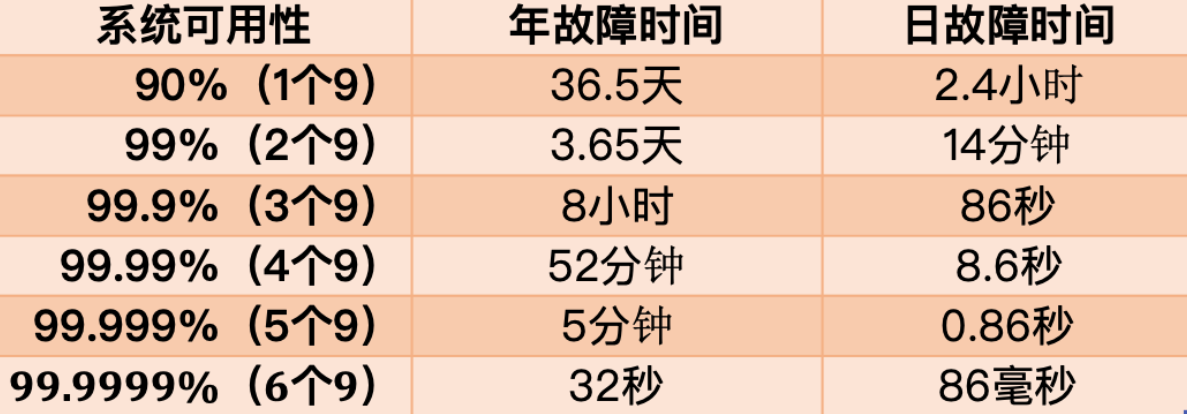

+# 02 单机架构

+

+我们从最简单的开始讲起。

+

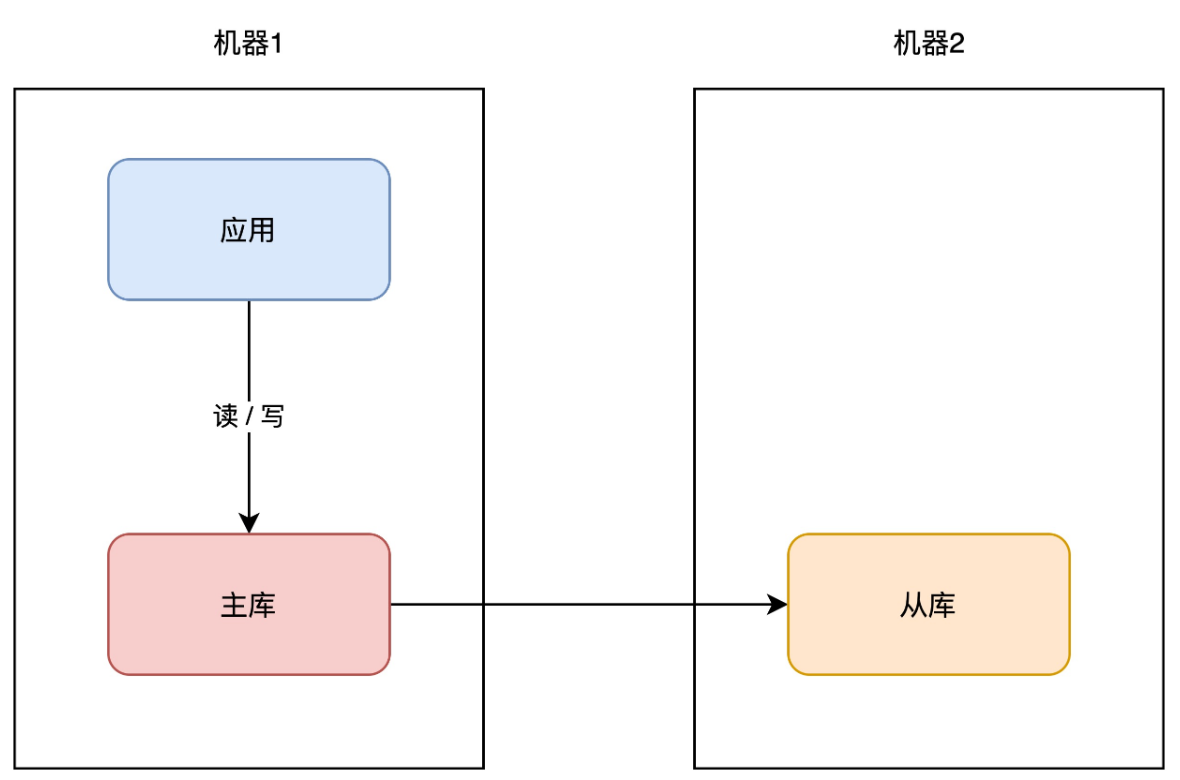

+假设你的业务处于起步阶段,体量非常小,那你的架构是这样的:

+

+

+

+这个架构模型非常简单,客户端请求进来,业务应用读写数据库,返回结果,非常好理解。

+

+但需要注意的是,这里的数据库是「单机」部署的,所以它有一个致命的缺点:一旦遭遇意外,例如磁盘损坏、操作系统异常、误删数据,那这意味着所有数据就全部「丢失」了,这个损失是巨大的。

+

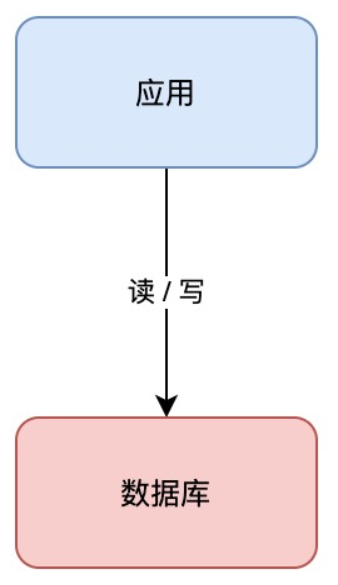

+如何避免这个问题呢?我们很容易想到一个方案:**备份**。

+

+

+

+你可以对数据做备份,把数据库文件「定期」cp 到另一台机器上,这样,即使原机器丢失数据,你依旧可以通过备份把数据「恢复」回来,以此保证数据安全。

+

+这个方案实施起来虽然比较简单,但存在 2 个问题:

+

+1. **恢复需要时间**:业务需先停机,再恢复数据,停机时间取决于恢复的速度,恢复期间服务「不可用」

+2. **数据不完整**:因为是定期备份,数据肯定不是「最新」的,数据完整程度取决于备份的周期

+

+很明显,你的数据库越大,意味故障恢复时间越久。那按照前面我们提到的「高可用」标准,这个方案可能连 1 个 9 都达不到,远远无法满足我们对可用性的要求。

+

+那有什么更好的方案,既可以快速恢复业务?还能尽可能保证数据完整性呢?

+

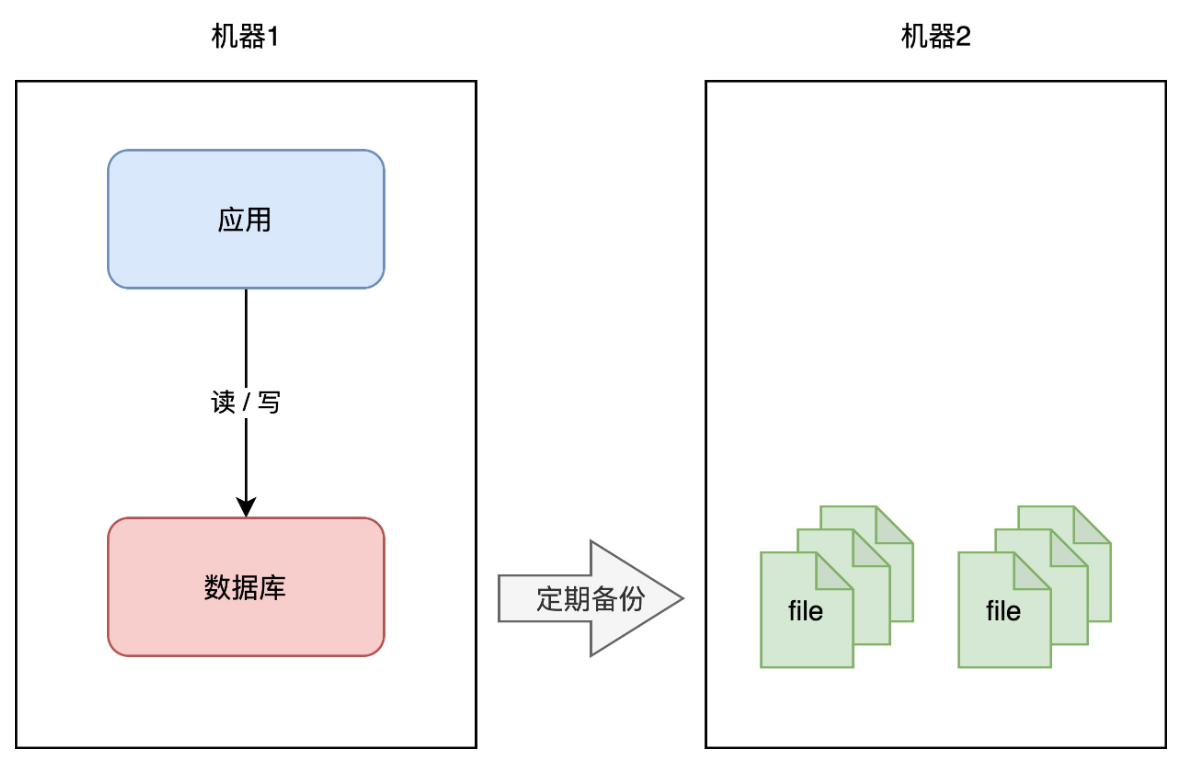

+这时你可以采用这个方案:**主从副本**。

+

+# 03 主从副本

+

+你可以在另一台机器上,再部署一个数据库实例,让这个新实例成为原实例的「副本」,让两者保持「实时同步」,就像这样:

+

+

+

+我们一般把原实例叫作主库(master),新实例叫作从库(slave)。这个方案的优点在于:

+

+- **数据完整性高**:主从副本实时同步,数据「差异」很小

+- **抗故障能力提升**:主库有任何异常,从库可随时「切换」为主库,继续提供服务

+- **读性能提升**:业务应用可直接读从库,分担主库「压力」读压力

+

+这个方案不错,不仅大大提高了数据库的可用性,还提升了系统的读性能。

+

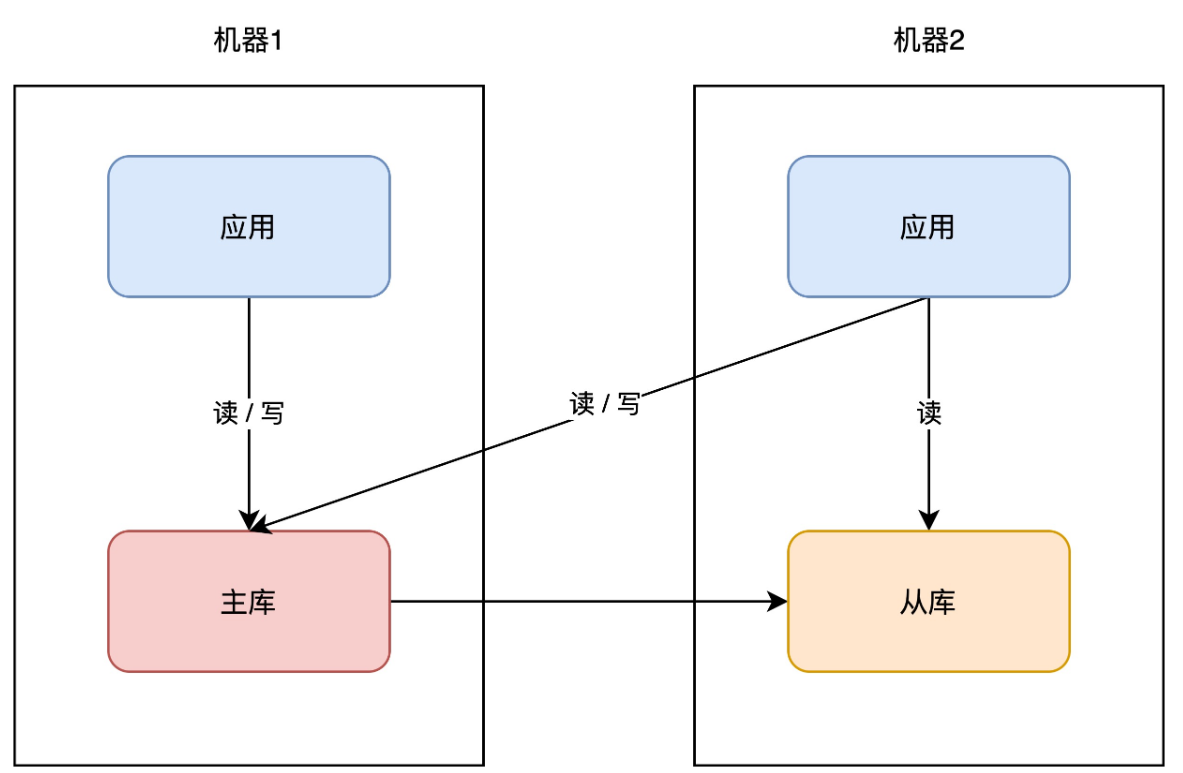

+同样的思路,你的「业务应用」也可以在其它机器部署一份,避免单点。因为业务应用通常是「无状态」的(不像数据库那样存储数据),所以直接部署即可,非常简单。

+

+

+

+因为业务应用部署了多个,所以你现在还需要部署一个「接入层」,来做请求的「负载均衡」(一般会使用 nginx 或 LVS),这样当一台机器宕机后,另一台机器也可以「接管」所有流量,持续提供服务。

+

+

+

+从这个方案你可以看出,提升可用性的关键思路就是:**冗余**。

+

+没错,担心一个实例故障,那就部署多个实例,担心一个机器宕机,那就部署多台机器。

+

+到这里,你的架构基本已演变成主流方案了,之后开发新的业务应用,都可以按照这种模式去部署。

+

+

+

+但这种方案还有什么风险吗?

+

+# 04 风险不可控

+

+现在让我们把视角下放,把焦点放到具体的「部署细节」上来。

+

+按照前面的分析,为了避免单点故障,你的应用虽然部署了多台机器,但这些机器的分布情况,我们并没有去深究。

+

+而一个机房有很多服务器,这些服务器通常会分布在一个个「机柜」上,如果你使用的这些机器,刚好在一个机柜,还是存在风险。

+

+如果恰好连接这个机柜的交换机 / 路由器发生故障,那么你的应用依旧有「不可用」的风险。

+

+> 虽然交换机 / 路由器也做了路线冗余,但不能保证一定不出问题。

+

+部署在一个机柜有风险,那把这些机器打散,分散到不同机柜上,是不是就没问题了?

+

+这样确实会大大降低出问题的概率。但我们依旧不能掉以轻心,因为无论怎么分散,它们总归还是在一个相同的环境下:**机房**。

+

+那继续追问,机房会不会发生故障呢?

+

+一般来讲,建设一个机房的要求其实是很高的,地理位置、温湿度控制、备用电源等等,机房厂商会在各方面做好防护。但即使这样,我们每隔一段时间还会看到这样的新闻:

+

+- 2015 年 5 月 27 日,杭州市某地光纤被挖断,近 3 亿用户长达 5 小时无法访问支付宝

+- 2021 年 7 月 13 日,B 站部分服务器机房发生故障,造成整站持续 3 个小时无法访问

+- 2021 年 10 月 9 日,富途证券服务器机房发生电力闪断故障,造成用户 2 个小时无法登陆、交易

+- …

+

+可见,即使机房级别的防护已经做得足够好,但只要有「概率」出问题,那现实情况就有可能发生。虽然概率很小,但一旦真的发生,影响之大可见一斑。

+

+看到这里你可能会想,机房出现问题的概率也太小了吧,工作了这么多年,也没让我碰上一次,有必要考虑得这么复杂吗?

+

+但你有没有思考这样一个问题:**不同体量的系统,它们各自关注的重点是什么?**

+

+体量很小的系统,它会重点关注「用户」规模、增长,这个阶段获取用户是一切。等用户体量上来了,这个阶段会重点关注「性能」,优化接口响应时间、页面打开速度等等,这个阶段更多是关注用户体验。

+

+等体量再大到一定规模后你会发现,「可用性」就变得尤为重要。像微信、支付宝这种全民级的应用,如果机房发生一次故障,那整个影响范围可以说是非常巨大的。

+

+所以,再小概率的风险,我们在提高系统可用性时,也不能忽视。

+

+分析了风险,再说回我们的架构。那到底该怎么应对机房级别的故障呢?

+

+没错,还是**冗余**。

+

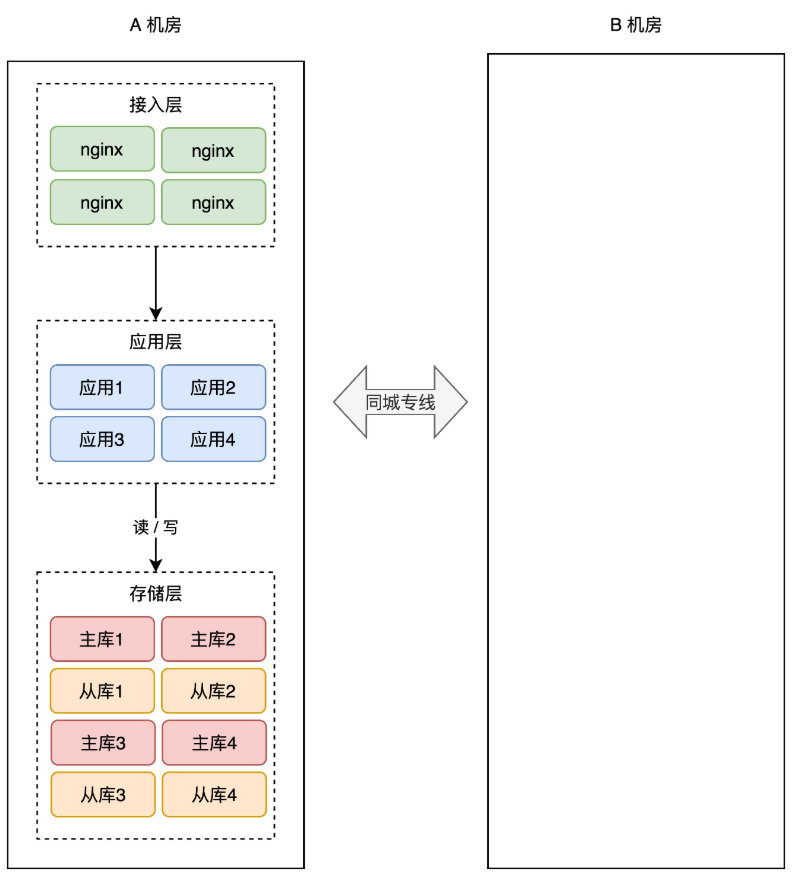

+# 05 同城灾备

+

+想要抵御「机房」级别的风险,那应对方案就不能局限在一个机房内了。

+

+现在,你需要做机房级别的冗余方案,也就是说,你需要再搭建一个机房,来部署你的服务。

+

+简单起见,你可以在「同一个城市」再搭建一个机房,原机房我们叫作 A 机房,新机房叫 B 机房,这两个机房的网络用一条「专线」连通。

+

+

+

+有了新机房,怎么把它用起来呢?这里还是要优先考虑「数据」风险。

+

+为了避免 A 机房故障导致数据丢失,所以我们需要把数据在 B 机房也存一份。最简单的方案还是和前面提到的一样:**备份**。

+

+A 机房的数据,定时在 B 机房做备份(拷贝数据文件),这样即使整个 A 机房遭到严重的损坏,B 机房的数据不会丢,通过备份可以把数据「恢复」回来,重启服务。

+

+

+

+这种方案,我们称之为「**冷备**」。为什么叫冷备呢?因为 B 机房只做备份,不提供实时服务,它是冷的,只会在 A 机房故障时才会启用。

+

+但备份的问题依旧和之前描述的一样:数据不完整、恢复数据期间业务不可用,整个系统的可用性还是无法得到保证。

+

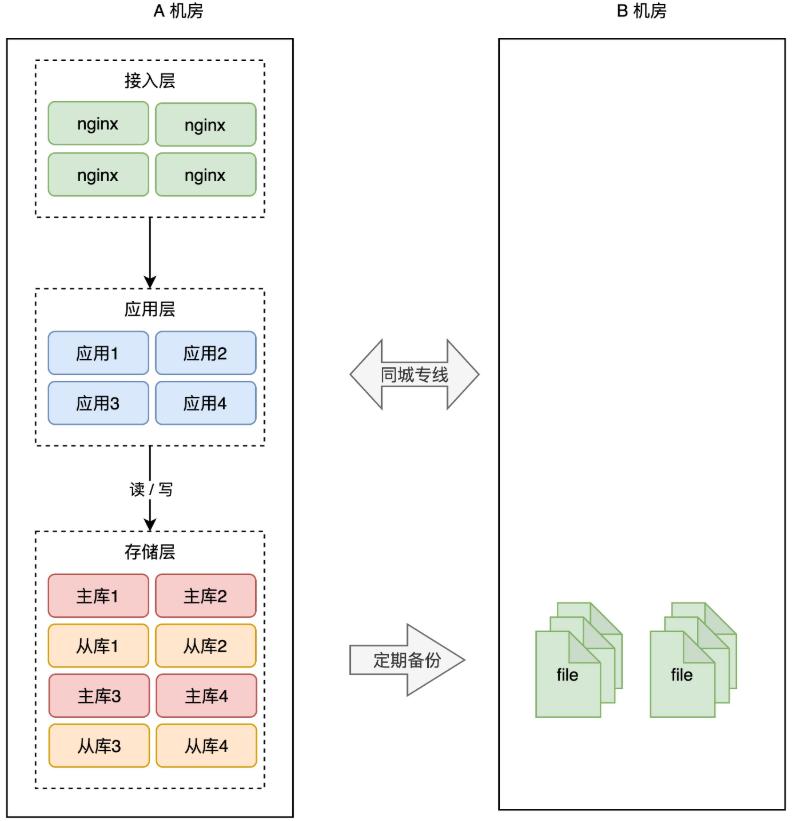

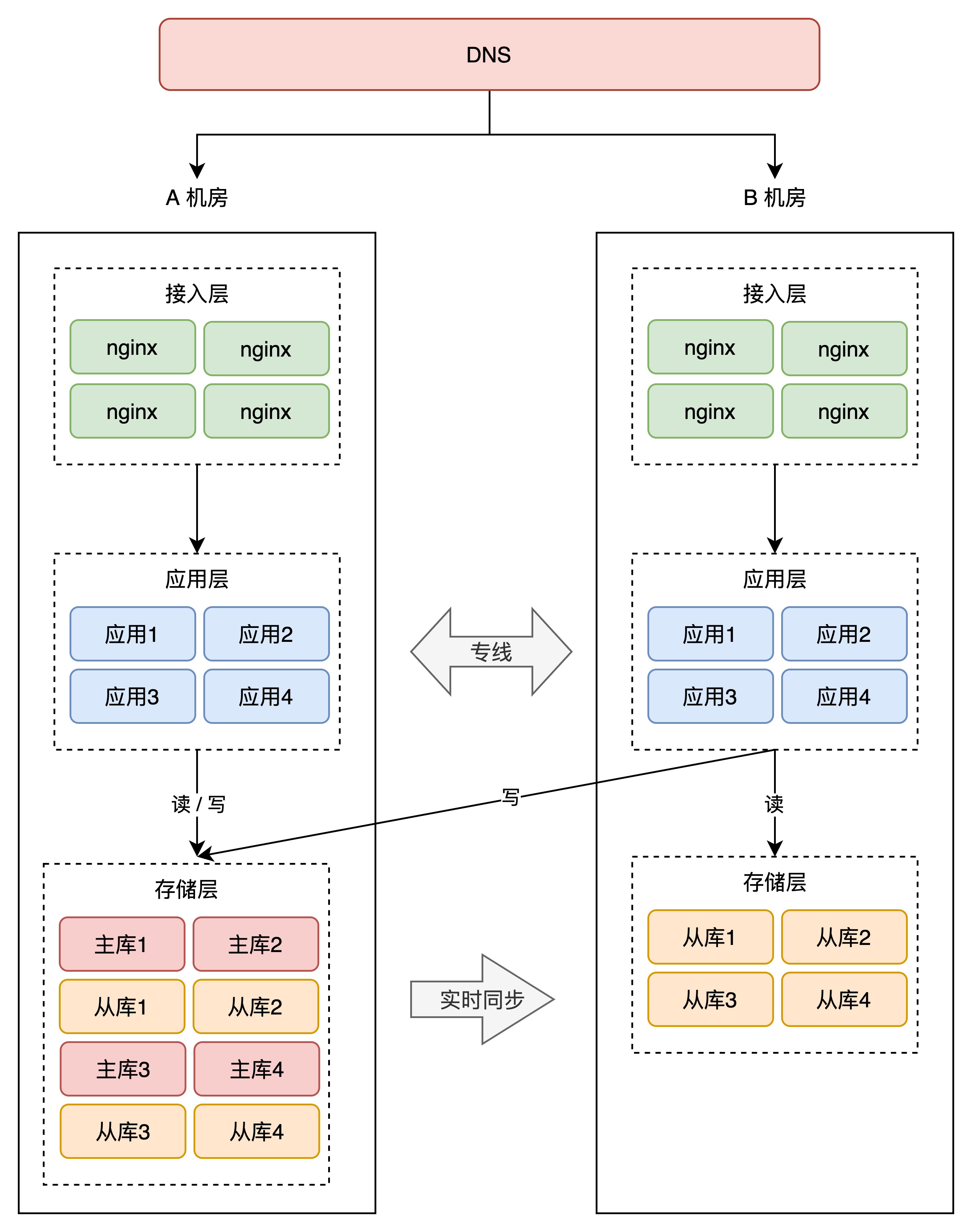

+所以,我们还是需要用「主从副本」的方式,在 B 机房部署 A 机房的数据副本,架构就变成了这样:

+

+

+

+这样,就算整个 A 机房挂掉,我们在 B 机房也有比较「完整」的数据。

+

+数据是保住了,但这时你需要考虑另外一个问题:**如果 A 机房真挂掉了,要想保证服务不中断,你还需要在 B 机房「紧急」做这些事情**:

+

+1. B 机房所有从库提升为主库

+2. 在 B 机房部署应用,启动服务

+3. 部署接入层,配置转发规则

+4. DNS 指向 B 机房接入层,接入流量,业务恢复

+

+看到了么?A 机房故障后,B 机房需要做这么多工作,你的业务才能完全「恢复」过来。

+

+你看,整个过程需要人为介入,且需花费大量时间来操作,恢复之前整个服务还是不可用的,这个方案还是不太爽,如果能做到故障后立即「切换」,那就好了。

+

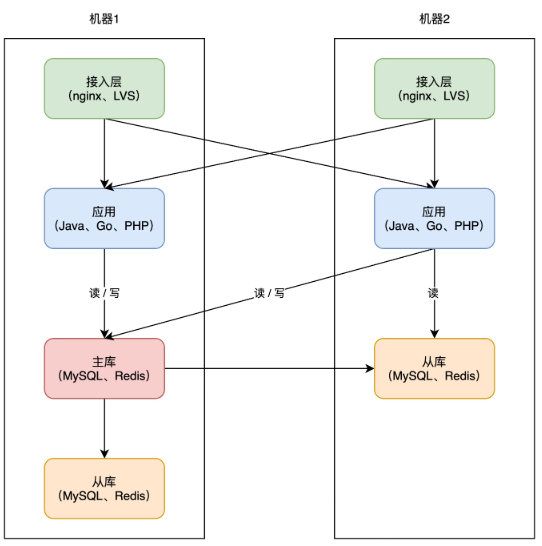

+因此,要想缩短业务恢复的时间,你必须把这些工作在 B 机房「提前」做好,也就是说,你需要在 B 机房提前部署好接入层、业务应用,等待随时切换。架构就变成了这样:

+

+

+

+这样的话,A 机房整个挂掉,我们只需要做 2 件事即可:

+

+1. B 机房所有从库提升为主库

+2. DNS 指向 B 机房接入层,接入流量,业务恢复

+

+这样一来,恢复速度快了很多。

+

+到这里你会发现,B 机房从最开始的「空空如也」,演变到现在,几乎是「镜像」了一份 A 机房的所有东西,从最上层的接入层,到中间的业务应用,到最下层的存储。两个机房唯一的区别是,**A 机房的存储都是主库,而 B 机房都是从库**。

+

+这种方案,我们把它叫做「**热备**」。

+

+热的意思是指,B 机房处于「待命」状态,A 故障后 B 可以随时「接管」流量,继续提供服务。热备相比于冷备最大的优点是:**随时可切换**。

+

+无论是冷备还是热备,因为它们都处于「备用」状态,所以我们把这两个方案统称为:**同城灾备**。

+

+同城灾备的最大优势在于,我们再也不用担心「机房」级别的故障了,一个机房发生风险,我们只需把流量切换到另一个机房即可,可用性再次提高,是不是很爽?(后面还有更爽的)

+

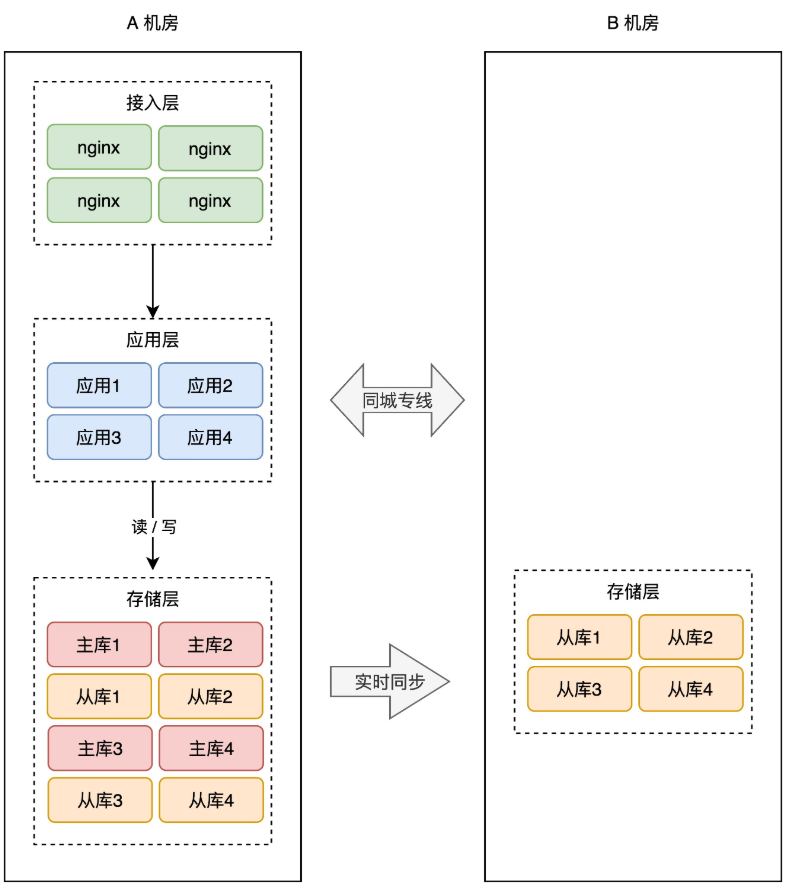

+# 06 同城双活

+

+我们继续来看这个架构。

+

+虽然我们有了应对机房故障的解决方案,但这里有个问题是我们不能忽视的:**A 机房挂掉,全部流量切到 B 机房,B 机房能否真的如我们所愿,正常提供服务?**

+

+这是个值得思考的问题。

+

+这就好比有两支军队 A 和 B,A 军队历经沙场,作战经验丰富,而 B 军队只是后备军,除了有军人的基本素养之外,并没有实战经验,战斗经验基本为 0。

+

+如果 A 军队丧失战斗能力,需要 B 军队立即顶上时,作为指挥官的你,肯定也会担心 B 军队能否真的担此重任吧?

+

+我们的架构也是如此,此时的 B 机房虽然是随时「待命」状态,但 A 机房真的发生故障,我们要把全部流量切到 B 机房,其实是不敢百分百保证它可以「如期」工作的。

+

+你想,我们在一个机房内部署服务,还总是发生各种各样的问题,例如:发布应用的版本不一致、系统资源不足、操作系统参数不一样等等。现在多部署一个机房,这些问题只会增多,不会减少。

+

+另外,从「成本」的角度来看,我们新部署一个机房,需要购买服务器、内存、硬盘、带宽资源,花费成本也是非常高昂的,只让它当一个后备军,未免也太「大材小用」了!

+

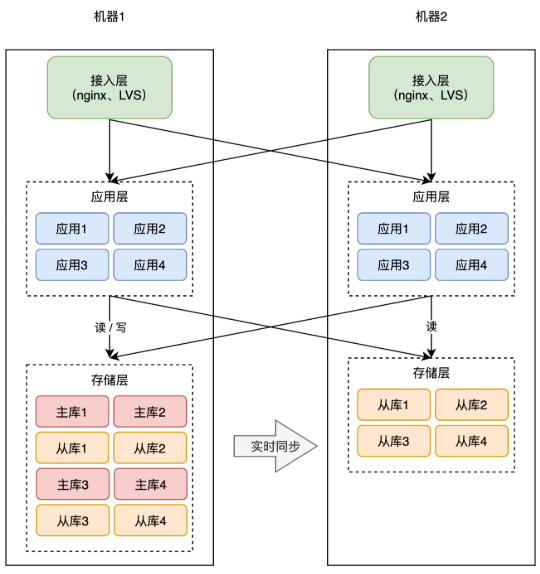

+因此,我们需要让 B 机房也接入流量,实时提供服务,这样做的好处,**一是可以实时训练这支后备军,让它达到与 A 机房相同的作战水平,随时可切换,二是 B 机房接入流量后,可以分担 A 机房的流量压力**。这才是把 B 机房资源优势,发挥最大化的最好方案!

+

+那怎么让 B 机房也接入流量呢?很简单,就是把 B 机房的接入层 IP 地址,加入到 DNS 中,这样,B 机房从上层就可以有流量进来了。

+

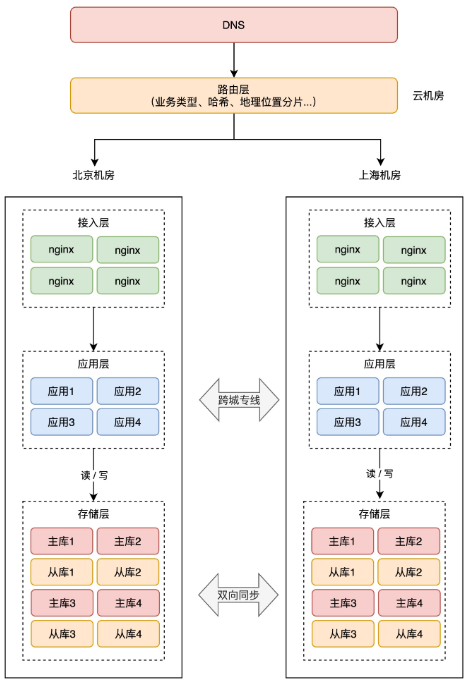

+

+

+但这里有一个问题:别忘了,B 机房的存储,现在可都是 A 机房的「从库」,从库默认可都是「不可写」的,B 机房的写请求打到本机房存储上,肯定会报错,这还是不符合我们预期。怎么办?

+

+这时,你就需要在「业务应用」层做改造了。

+

+你的业务应用在操作数据库时,需要区分「读写分离」(一般用中间件实现),即两个机房的「读」流量,可以读任意机房的存储,但「写」流量,只允许写 A 机房,因为主库在 A 机房。

+

+

+

+这会涉及到你用的所有存储,例如项目中用到了 MySQL、Redis、MongoDB 等等,操作这些数据库,都需要区分读写请求,所以这块需要一定的业务「改造」成本。

+

+因为 A 机房的存储都是主库,所以我们把 A 机房叫做「主机房」,B 机房叫「从机房」。

+

+两个机房部署在「同城」,物理距离比较近,而且两个机房用「专线」网络连接,虽然跨机房访问的延迟,比单个机房内要大一些,但整体的延迟还是可以接受的。

+

+业务改造完成后,B 机房可以慢慢接入流量,从 10%、30%、50% 逐渐覆盖到 100%,你可以持续观察 B 机房的业务是否存在问题,有问题及时修复,逐渐让 B 机房的工作能力,达到和 A 机房相同水平。

+

+现在,因为 B 机房实时接入了流量,此时如果 A 机房挂了,那我们就可以「大胆」地把 A 的流量,全部切换到 B 机房,完成快速切换!

+

+到这里你可以看到,我们部署的 B 机房,在物理上虽然与 A 有一定距离,但整个系统从「逻辑」上来看,我们是把这两个机房看做一个「整体」来规划的,也就是说,相当于把 2 个机房当作 1 个机房来用。

+

+这种架构方案,比前面的同城灾备更「进了一步」,B 机房实时接入了流量,还能应对随时的故障切换,这种方案我们把它叫做「**同城双活**」。

+

+因为两个机房都能处理业务请求,这对我们系统的内部维护、改造、升级提供了更多的可实施空间(流量随时切换),现在,整个系统的弹性也变大了,是不是更爽了?

+

+那这种架构有什么问题呢?

+

+# 07 两地三中心

+

+还是回到风险上来说。

+

+虽然我们把 2 个机房当做一个整体来规划,但这 2 个机房在物理层面上,还是处于「一个城市」内,如果是整个城市发生自然灾害,例如地震、水灾(河南水灾刚过去不久),那 2 个机房依旧存在「全局覆没」的风险。

+

+真是防不胜防啊?怎么办?没办法,继续冗余。

+

+但这次冗余机房,就不能部署在同一个城市了,你需要把它放到距离更远的地方,部署在「异地」。

+

+> 通常建议两个机房的距离要在 1000 公里以上,这样才能应对城市级别的灾难。

+

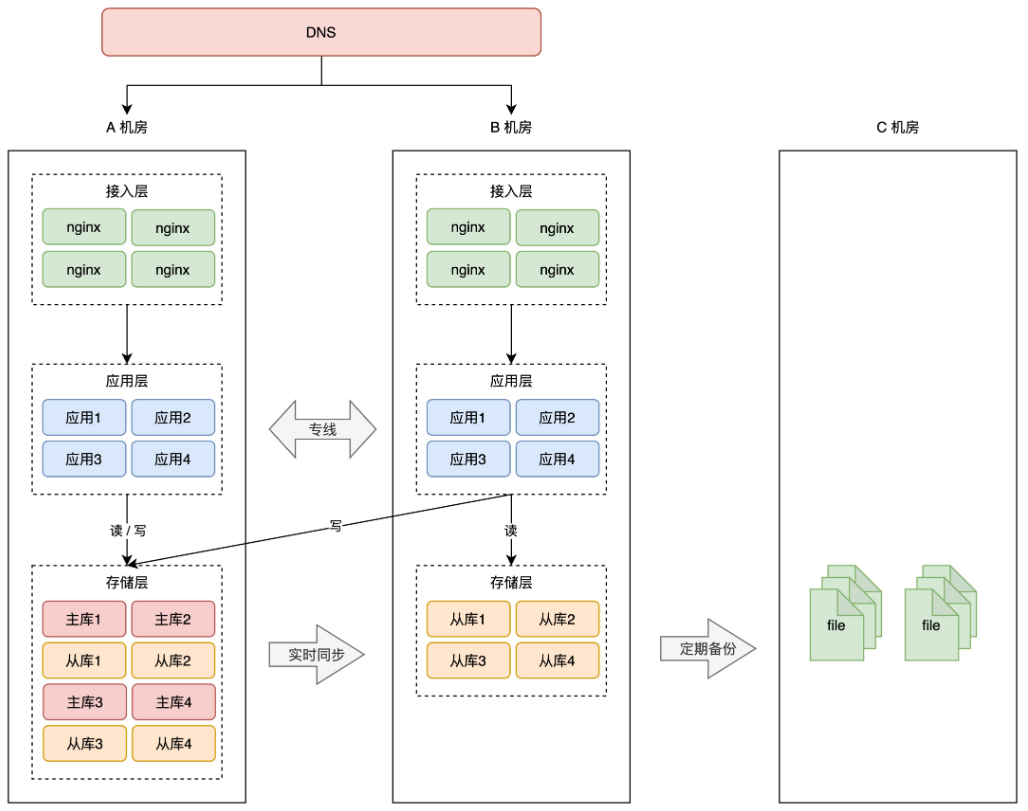

+假设之前的 A、B 机房在北京,那这次新部署的 C 机房可以放在上海。

+

+按照前面的思路,把 C 机房用起来,最简单粗暴的方案还就是做「冷备」,即定时把 A、B 机房的数据,在 C 机房做备份,防止数据丢失。

+

+

+

+这种方案,就是我们经常听到的「**两地三中心**」。

+

+**两地是指 2 个城市,三中心是指有 3 个机房,其中 2 个机房在同一个城市,并且同时提供服务,第 3 个机房部署在异地,只做数据灾备。**

+

+这种架构方案,通常用在银行、金融、政企相关的项目中。它的问题还是前面所说的,启用灾备机房需要时间,而且启用后的服务,不确定能否如期工作。

+

+所以,要想真正的抵御城市级别的故障,越来越多的互联网公司,开始实施「**异地双活**」。

+

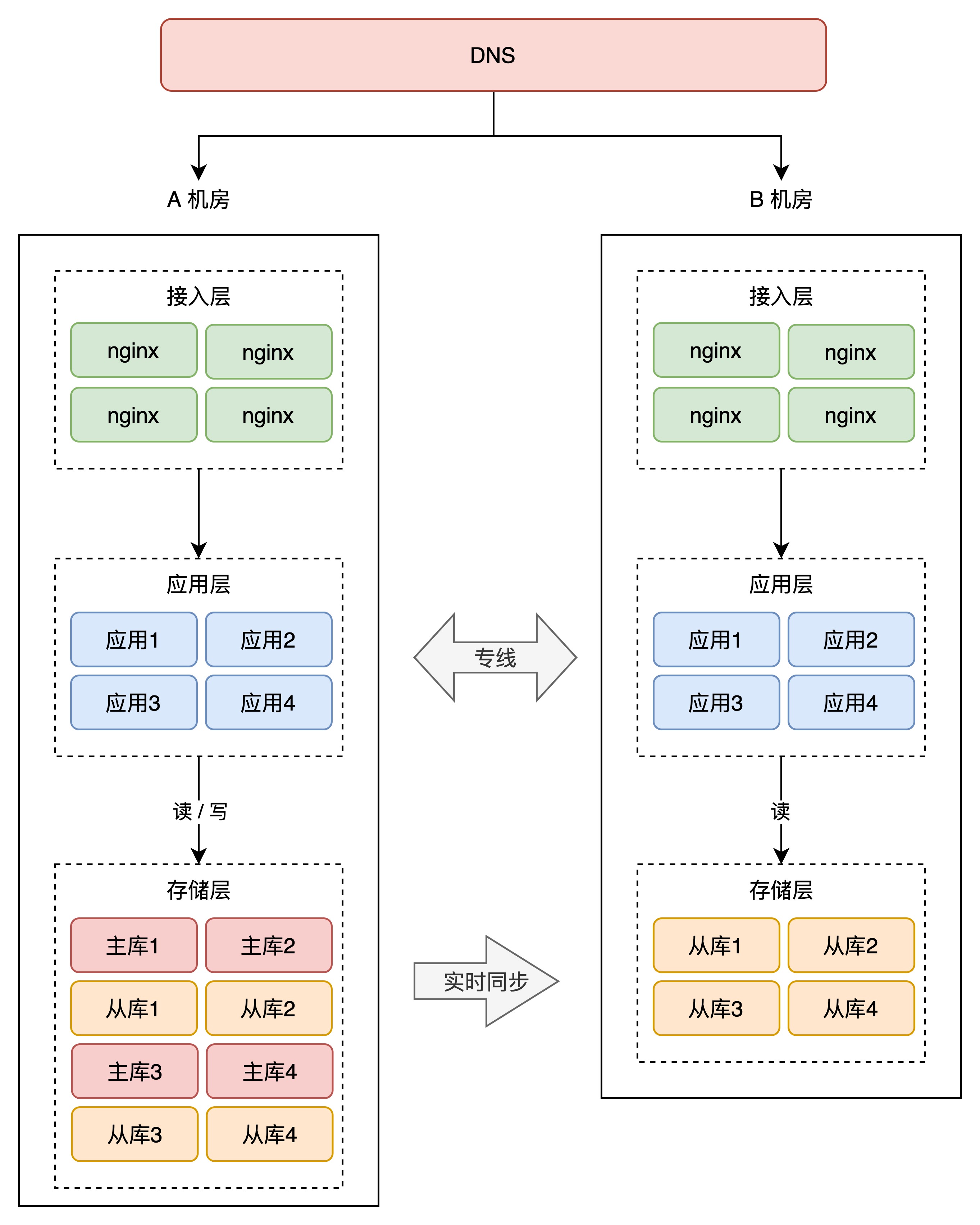

+# 08 伪异地双活

+

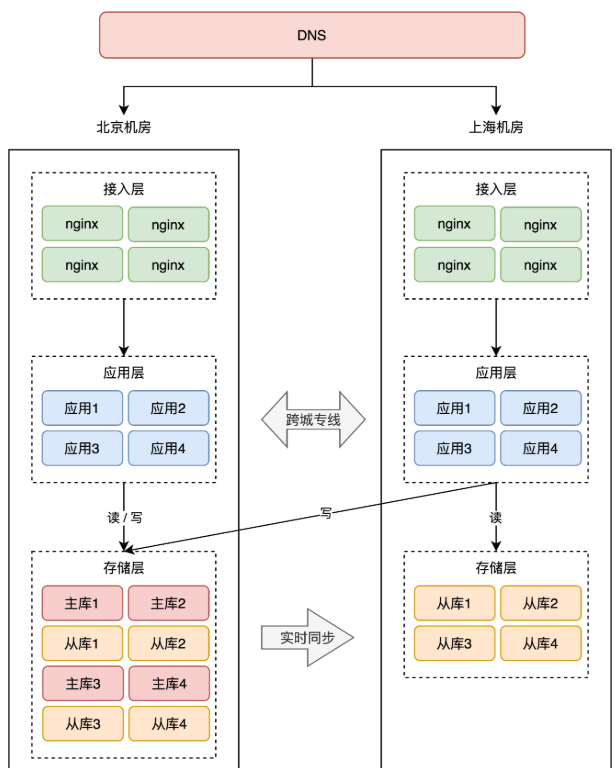

+这里,我们还是分析 2 个机房的架构情况。我们不再把 A、B 机房部署在同一个城市,而是分开部署,例如 A 机房放在北京,B 机房放在上海。

+

+前面我们讲了同城双活,那异地双活是不是直接「照搬」同城双活的模式去部署就可以了呢?

+

+事情没你想的那么简单。

+

+如果还是按照同城双活的架构来部署,那异地双活的架构就是这样的:

+

+

+

+注意看,两个机房的网络是通过「跨城专线」连通的。

+

+此时两个机房都接入流量,那上海机房的请求,可能要去读写北京机房的存储,这里存在一个很大的问题:**网络延迟**。

+

+因为两个机房距离较远,受到物理距离的限制,现在,两地之间的网络延迟就变成了「**不可忽视**」的因素了。

+

+北京到上海的距离大约 1300 公里,即使架设一条高速的「网络专线」,光纤以光速传输,一个来回也需要近 10ms 的延迟。

+

+况且,网络线路之间还会经历各种路由器、交换机等网络设备,实际延迟可能会达到 30ms ~ 100ms,如果网络发生抖动,延迟甚至会达到 1 秒。

+

+> 不止是延迟,远距离的网络专线质量,是远远达不到机房内网络质量的,专线网络经常会发生延迟、丢包、甚至中断的情况。总之,不能过度信任和依赖「跨城专线」。

+

+你可能会问,这点延迟对业务影响很大吗?影响非常大!

+

+试想,一个客户端请求打到上海机房,上海机房要去读写北京机房的存储,一次跨机房访问延迟就达到了 30ms,这大致是机房内网网络(0.5 ms)访问速度的 60 倍(30ms / 0.5ms),一次请求慢 60 倍,来回往返就要慢 100 倍以上。

+

+而我们在 App 打开一个页面,可能会访问后端几十个 API,每次都跨机房访问,整个页面的响应延迟有可能就达到了**秒级**,这个性能简直惨不忍睹,难以接受。

+

+看到了么,虽然我们只是简单的把机房部署在了「异地」,但「同城双活」的架构模型,在这里就不适用了,还是按照这种方式部署,这是「伪异地双活」!

+

+那如何做到真正的异地双活呢?

+

+# 09 真正的异地双活

+

+既然「跨机房」调用延迟是不容忽视的因素,那我们只能尽量避免跨机房「调用」,规避这个延迟问题。

+

+也就是说,上海机房的应用,不能再「跨机房」去读写北京机房的存储,只允许读写上海本地的存储,实现「就近访问」,这样才能避免延迟问题。

+

+还是之前提到的问题:上海机房存储都是从库,不允许写入啊,除非我们只允许上海机房接入「读流量」,不接收「写流量」,否则无法满足不再跨机房的要求。

+

+很显然,只让上海机房接收读流量的方案不现实,因为很少有项目是只有读流量,没有写流量的。所以这种方案还是不行,这怎么办?

+

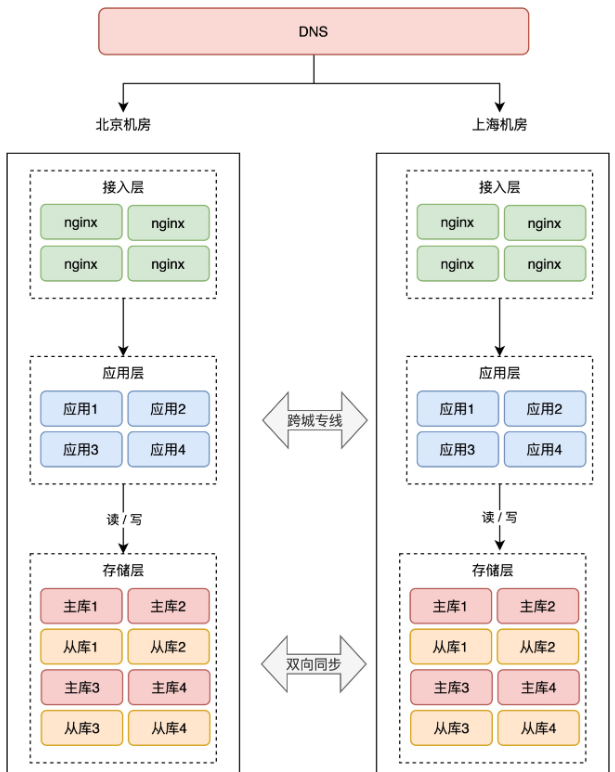

+此时,你就必须在「**存储层**」做改造了。

+

+要想上海机房读写本机房的存储,那上海机房的存储不能再是北京机房的从库,而是也要变为「主库」。

+

+你没看错,两个机房的存储必须都是「**主库**」,而且两个机房的数据还要「**互相同步**」数据,即客户端无论写哪一个机房,都能把这条数据同步到另一个机房。

+

+因为只有两个机房都拥有「全量数据」,才能支持任意切换机房,持续提供服务。

+

+怎么实现这种「双主」架构呢?它们之间如何互相同步数据?

+

+如果你对 MySQL 有所了解,MySQL 本身就提供了双主架构,它支持双向复制数据,但平时用的并不多。而且 Redis、MongoDB 等数据库并没有提供这个功能,所以,你必须开发对应的「数据同步中间件」来实现双向同步的功能。

+

+此外,除了数据库这种有状态的软件之外,你的项目通常还会使用到消息队列,例如 RabbitMQ、Kafka,这些也是有状态的服务,所以它们也需要开发双向同步的中间件,支持任意机房写入数据,同步至另一个机房。

+

+看到了么,这一下子复杂度就上来了,单单针对每个数据库、队列开发同步中间件,就需要投入很大精力了。

+

+> 业界也开源出了很多数据同步中间件,例如阿里的 Canal、RedisShake、MongoShake,可分别在两个机房同步 MySQL、Redis、MongoDB 数据。

+>

+> 很多有能力的公司,也会采用自研同步中间件的方式来做,例如饿了么、携程、美团都开发了自己的同步中间件。

+>

+> 我也有幸参与设计开发了 MySQL、Redis/Codis、MongoDB 的同步中间件,有时间写一篇文章详细聊聊实现细节,欢迎持续关注。:)

+

+现在,整个架构就变成了这样:

+

+

+

+注意看,两个机房的存储层都互相同步数据的。有了数据同步中间件,就可以达到这样的效果:

+

+- 北京机房写入 X = 1

+- 上海机房写入 Y = 2

+- 数据通过中间件双向同步

+- 北京、上海机房都有 X = 1、Y = 2 的数据

+

+这里我们用中间件双向同步数据,就不用再担心专线问题,专线出问题,我们的中间件可以自动重试,直到成功,达到数据最终一致。

+

+但这里还会遇到一个问题,两个机房都可以写,操作的不是同一条数据那还好,如果修改的是同一条的数据,发生冲突怎么办?

+

+- 用户短时间内发了 2 个修改请求,都是修改同一条数据

+- 一个请求落在北京机房,修改 X = 1(还未同步到上海机房)

+- 另一个请求落在上海机房,修改 X = 2(还未同步到北京机房)

+- 两个机房以哪个为准?

+

+也就是说,在很短的时间内,同一个用户修改同一条数据,两个机房无法确认谁先谁后,数据发生「冲突」。

+

+这是一个很严重的问题,系统发生故障并不可怕,可怕的是数据发生「错误」,因为修正数据的成本太高了。我们一定要避免这种情况的发生。解决这个问题,有 2 个方案。

+

+**第一个方案**,数据同步中间件要有自动「合并」数据、解决「冲突」的能力。

+

+这个方案实现起来比较复杂,要想合并数据,就必须要区分出「先后」顺序。我们很容易想到的方案,就是以「时间」为标尺,以「后到达」的请求为准。

+

+但这种方案需要两个机房的「时钟」严格保持一致才行,否则很容易出现问题。例如:

+

+- 第 1 个请求落到北京机房,北京机房时钟是 10:01,修改 X = 1

+- 第 2 个请求落到上海机房,上海机房时钟是 10:00,修改 X = 2

+

+因为北京机房的时间「更晚」,那最终结果就会是 X = 1。但这里其实应该以第 2 个请求为准,X = 2 才对。

+

+可见,完全「依赖」时钟的冲突解决方案,不太严谨。

+

+所以,通常会采用第二种方案,从「源头」就避免数据冲突的发生。

+

+# 10 如何实施异地双活

+

+既然自动合并数据的方案实现成本高,那我们就要想,能否从源头就「避免」数据冲突呢?

+

+这个思路非常棒!

+

+从源头避免数据冲突的思路是:**在最上层接入流量时,就不要让冲突的情况发生**。

+

+具体来讲就是,要在最上层就把用户「区分」开,部分用户请求固定打到北京机房,其它用户请求固定打到上海 机房,进入某个机房的用户请求,之后的所有业务操作,都在这一个机房内完成,从根源上避免「跨机房」。

+

+所以这时,你需要在接入层之上,再部署一个「路由层」(通常部署在云服务器上),自己可以配置路由规则,把用户「分流」到不同的机房内。

+

+

+

+但这个路由规则,具体怎么定呢?有很多种实现方式,最常见的我总结了 3 类:

+

+1. 按业务类型分片

+2. 直接哈希分片

+3. 按地理位置分片

+

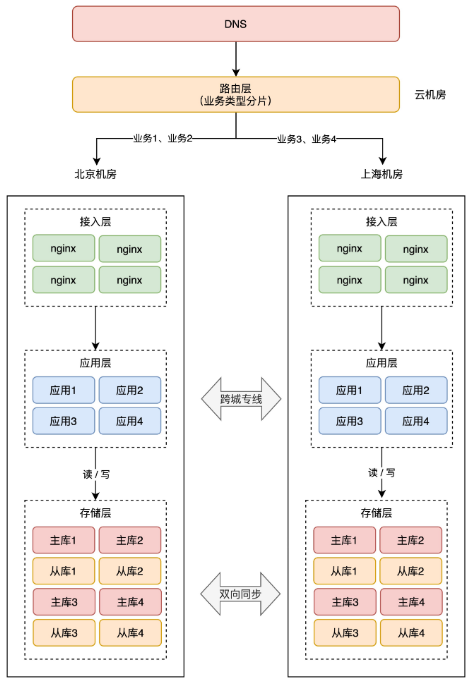

+**1、按业务类型分片**

+

+这种方案是指,按应用的「业务类型」来划分。

+

+举例:假设我们一共有 4 个应用,北京和上海机房都部署这些应用。但应用 1、2 只在北京机房接入流量,在上海机房只是热备。应用 3、4 只在上海机房接入流量,在北京机房是热备。

+

+这样一来,应用 1、2 的所有业务请求,只读写北京机房存储,应用 3、4 的所有请求,只会读写上海机房存储。

+

+

+

+这样按业务类型分片,也可以避免同一个用户修改同一条数据。

+

+> 这里按业务类型在不同机房接入流量,还需要考虑多个应用之间的依赖关系,要尽可能的把完成「相关」业务的应用部署在同一个机房,避免跨机房调用。

+>

+> 例如,订单、支付服务有依赖关系,会产生互相调用,那这 2 个服务在 A 机房接入流量。社区、发帖服务有依赖关系,那这 2 个服务在 B 机房接入流量。

+

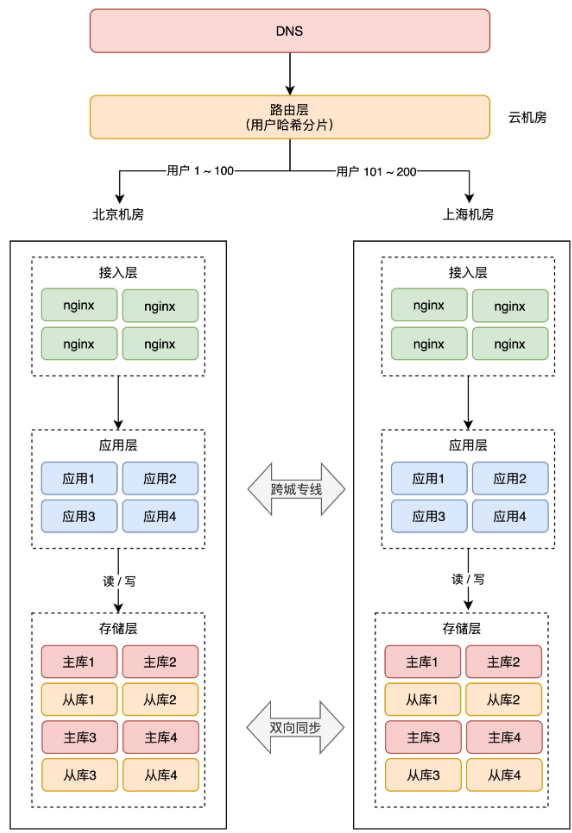

+**2、直接哈希分片**

+

+这种方案就是,最上层的路由层,会根据用户 ID 计算「哈希」取模,然后从路由表中找到对应的机房,之后把请求转发到指定机房内。

+

+举例:一共 200 个用户,根据用户 ID 计算哈希值,然后根据路由规则,把用户 1 - 100 路由到北京机房,101 - 200 用户路由到上海机房,这样,就避免了同一个用户修改同一条数据的情况发生。

+

+

+

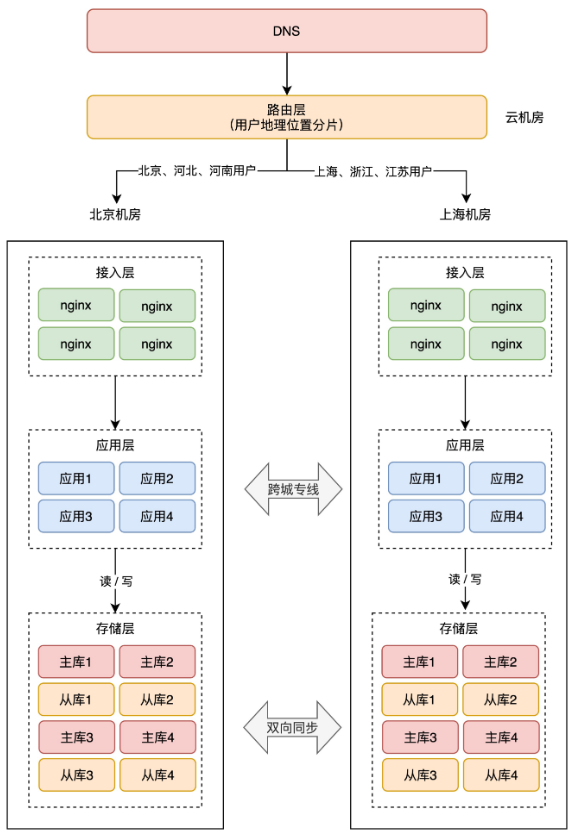

+**3、按地理位置分片**

+

+这种方案,非常适合与地理位置密切相关的业务,例如打车、外卖服务就非常适合这种方案。

+

+拿外卖服务举例,你要点外卖肯定是「就近」点餐,整个业务范围相关的有商家、用户、骑手,它们都是在相同的地理位置内的。

+

+针对这种特征,就可以在最上层,按用户的「地理位置」来做分片,分散到不同的机房。

+

+举例:北京、河北地区的用户点餐,请求只会打到北京机房,而上海、浙江地区的用户,请求则只会打到上海机房。这样的分片规则,也能避免数据冲突。

+

+

+

+> 提醒:这 3 种常见的分片规则,第一次看不太好理解,建议配合图多理解几遍。搞懂这 3 个分片规则,你才能真正明白怎么做异地多活。

+

+总之,分片的核心思路在于,**让同一个用户的相关请求,只在一个机房内完成所有业务「闭环」,不再出现「跨机房」访问**。

+

+阿里在实施这种方案时,给它起了个名字,叫做「**单元化**」。

+

+> 当然,最上层的路由层把用户分片后,理论来说同一个用户只会落在同一个机房内,但不排除程序 Bug 导致用户会在两个机房「漂移」。

+>

+> 安全起见,每个机房在写存储时,还需要有一套机制,能够检测「数据归属」,应用层操作存储时,需要通过中间件来做「兜底」,避免不该写本机房的情况发生。(篇幅限制,这里不展开讲,理解思路即可)

+

+现在,两个机房就可以都接收「读写」流量(做好分片的请求),底层存储保持「双向」同步,两个机房都拥有全量数据,当任意机房故障时,另一个机房就可以「接管」全部流量,实现快速切换,简直不要太爽。

+

+不仅如此,因为机房部署在异地,我们还可以更细化地「优化」路由规则,让用户访问就近的机房,这样整个系统的性能也会大大提升。

+

+> 这里还有一种情况,是无法做数据分片的:**全局数据**。例如系统配置、商品库存这类需要强一致的数据,这类服务依旧只能采用写主机房,读从机房的方案,不做双活。

+>

+> 双活的重点,是要优先保证「核心」业务先实现双活,并不是「全部」业务实现双活。

+

+至此,我们才算实现了真正的「**异地双活**」!

+

+> 到这里你可以看出,完成这样一套架构,需要投入的成本是巨大的。

+>

+> 路由规则、路由转发、数据同步中间件、数据校验兜底策略,不仅需要开发强大的中间件,同时还要业务配合改造(业务边界划分、依赖拆分)等一些列工作,没有足够的人力物力,这套架构很难实施。

+

+# 11 异地多活

+

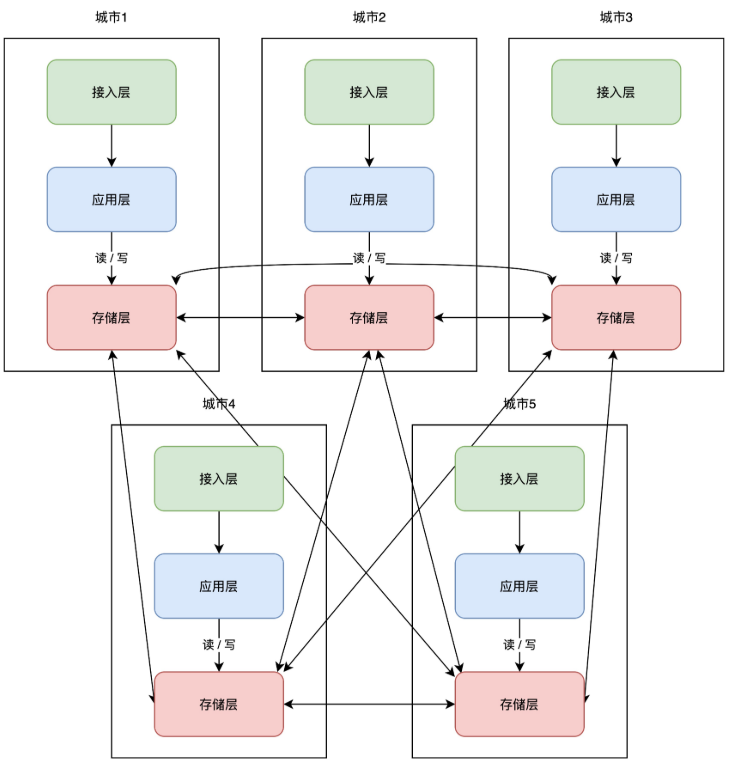

+理解了异地双活,那「异地多活」顾名思义,就是在异地双活的基础上,部署多个机房即可。架构变成了这样:

+

+

+

+这些服务按照「单元化」的部署方式,可以让每个机房部署在任意地区,随时扩展新机房,你只需要在最上层定义好分片规则就好了。

+

+但这里还有一个小问题,随着扩展的机房越来越多,当一个机房写入数据后,需要同步的机房也越来越多,这个实现复杂度会比较高。

+

+所以业界又把这一架构又做了进一步优化,把「网状」架构升级为「星状」:

+

+

+

+这种方案必须设立一个「中心机房」,任意机房写入数据后,都只同步到中心机房,再由中心机房同步至其它机房。

+

+这样做的好处是,一个机房写入数据,只需要同步数据到中心机房即可,不需要再关心一共部署了多少个机房,实现复杂度大大「简化」。

+

+但与此同时,这个中心机房的「稳定性」要求会比较高。不过也还好,即使中心机房发生故障,我们也可以把任意一个机房,提升为中心机房,继续按照之前的架构提供服务。

+

+至此,我们的系统彻底实现了「**异地多活**」!

+

+多活的优势在于,**可以任意扩展机房「就近」部署。任意机房发生故障,可以完成快速「切换」**,大大提高了系统的可用性。

+

+同时,我们也再也不用担心系统规模的增长,因为这套架构具有极强的「**扩展能力**」。

+

+怎么样?我们从一个最简单的应用,一路优化下来,到最终的架构方案,有没有帮你彻底理解异地多活呢?

+

+# 总结

+

+好了,总结一下这篇文章的重点。

+

+1、一个好的软件架构,应该遵循高性能、高可用、易扩展 3 大原则,其中「高可用」在系统规模变得越来越大时,变得尤为重要

+

+2、系统发生故障并不可怕,能以「最快」的速度恢复,才是高可用追求的目标,异地多活是实现高可用的有效手段

+

+3、提升高可用的核心是「冗余」,备份、主从副本、同城灾备、同城双活、两地三中心、异地双活,异地多活都是在做冗余

+

+4、同城灾备分为「冷备」和「热备」,冷备只备份数据,不提供服务,热备实时同步数据,并做好随时切换的准备

+

+5、同城双活比灾备的优势在于,两个机房都可以接入「读写」流量,提高可用性的同时,还提升了系统性能。虽然物理上是两个机房,但「逻辑」上还是当做一个机房来用

+

+6、两地三中心是在同城双活的基础上,额外部署一个异地机房做「灾备」,用来抵御「城市」级别的灾害,但启用灾备机房需要时间

+

+7、异地双活才是抵御「城市」级别灾害的更好方案,两个机房同时提供服务,故障随时可切换,可用性高。但实现也最复杂,理解了异地双活,才能彻底理解异地多活

+

+8、异地多活是在异地双活的基础上,任意扩展多个机房,不仅又提高了可用性,还能应对更大规模的流量的压力,扩展性最强,是实现高可用的最终方案

+

+# 后记

+

+这篇文章我从「宏观」层面,向你介绍了异地多活架构的「核心」思路,整篇文章的信息量还是很大的,如果不太好理解,我建议你多读几遍。

+

+因为篇幅限制,很多细节我并没有展开来讲。这篇文章更像是讲异地多活的架构之「道」,而真正实施的「术」,要考虑的点其实也非常繁多,因为它需要开发强大的「基础设施」才可以完成实施。

+

+不仅如此,要想真正实现异地多活,还需要遵循一些原则,例如业务梳理、业务分级、数据分类、数据最终一致性保障、机房切换一致性保障、异常处理等等。同时,相关的运维设施、监控体系也要能跟得上才行。

+

+宏观上需要考虑业务(微服务部署、依赖、拆分、SDK、Web 框架)、基础设施(服务发现、流量调度、持续集成、同步中间件、自研存储),微观上要开发各种中间件,还要关注中间件的高性能、高可用、容错能力,其复杂度之高,只有亲身参与过之后才知道。

+

+我曾经有幸参与过,存储层同步中间件的设计与开发,实现过「跨机房」同步 MySQL、Redis、MongoDB 的中间件,踩过的坑也非常多。当然,这些中间件的设计思路也非常有意思,有时间单独分享一下这些中间件的设计思路。

+

+值得提醒你的是,只有真正理解了「异地双活」,才能彻底理解「异地多活」。在我看来,从同城双活演变为异地双活的过程,是最为复杂的,最核心的东西包括,**业务单元化划分、存储层数据双向同步、最上层的分片逻辑**,这些是实现异地多活的重中之重。

+

diff --git a/docs/advance/excellent-article/31-mysql-data-sync-es.md b/docs/advance/excellent-article/31-mysql-data-sync-es.md

new file mode 100644

index 0000000..8d43d94

--- /dev/null

+++ b/docs/advance/excellent-article/31-mysql-data-sync-es.md

@@ -0,0 +1,503 @@

+---

+sidebar: heading

+title: MySQL数据如何实时同步到ES

+category: 优质文章

+tag:

+ - MySQL

+head:

+ - - meta

+ - name: keywords

+ content: MySQL,ES,elasticsearch,数据同步

+ - - meta

+ - name: description

+ content: 努力打造最优质的Java学习网站

+---

+

+

+## 前言

+

+我们一般会使用MySQL用来存储数据,用Es来做全文检索和特殊查询,那么如何将数据优雅的从MySQL同步到Es呢?我们一般有以下几种方式:

+

+1.**双写**。在代码中先向MySQL中写入数据,然后紧接着向Es中写入数据。这个方法的缺点是代码严重耦合,需要手动维护MySQL和Es数据关系,非常不便于维护。

+

+2.**发MQ,异步执行**。在执行完向Mysql中写入数据的逻辑后,发送MQ,告诉消费端这个数据需要写入Es,消费端收到消息后执行向Es写入数据的逻辑。这个方式的优点是Mysql和Es数据维护分离,开发Mysql和Es的人员只需要关心各自的业务。缺点是依然需要维护发送、接收MQ的逻辑,并且引入了MQ组件,增加了系统的复杂度。

+

+3.**使用Datax进行全量数据同步**。这个方式优点是可以完全不用写维护数据关系的代码,各自只需要关心自己的业务,对代码侵入性几乎为零。缺点是Datax是一种全量同步数据的方式,不使用实时同步。如果系统对数据时效性不强,可以考虑此方式。

+

+4.**使用Canal进行实时数据同步**。这个方式具有跟Datax一样的优点,可以完全不用写维护数据关系的代码,各自只需要关心自己的业务,对代码侵入性几乎为零。与Datax不同的是Canal是一种实时同步数据的方式,对数据时效性较强的系统,我们会采用Canal来进行实时数据同步。

+

+那么就让我们来看看Canal是如何使用的。

+

+## 官网

+

+https://github.com/alibaba/canal

+

+## 1.Canal简介

+

+

+

+**canal [kə'næl]** ,译意为水道/管道/沟渠,主要用途是基于 MySQL 数据库增量日志解析,提供增量数据订阅和消费

+

+早期阿里巴巴因为杭州和美国双机房部署,存在跨机房同步的业务需求,实现方式主要是基于业务 trigger 获取增量变更。从 2010 年开始,业务逐步尝试数据库日志解析获取增量变更进行同步,由此衍生出了大量的数据库增量订阅和消费业务。

+

+基于日志增量订阅和消费的业务包括

+

+- 数据库镜像

+- 数据库实时备份

+- 索引构建和实时维护(拆分异构索引、倒排索引等)

+- 业务 cache 刷新

+- 带业务逻辑的增量数据处理

+

+当前的 canal 支持源端 MySQL 版本包括 5.1.x , 5.5.x , 5.6.x , 5.7.x , 8.0.x

+

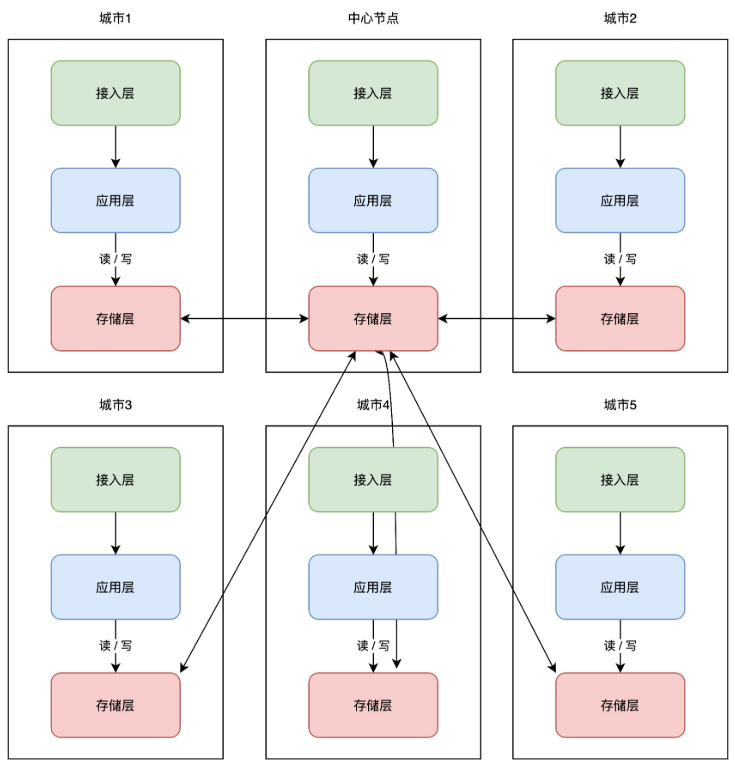

+### **MySQL主备复制原理**

+

+

+

+- MySQL master 将数据变更写入二进制日志( binary log, 其中记录叫做二进制日志事件binary log events,可以通过 show binlog events 进行查看)

+- MySQL slave 将 master 的 binary log events 拷贝到它的中继日志(relay log)

+- MySQL slave 重放 relay log 中事件,将数据变更反映它自己的数据

+

+### **canal工作原理**

+

+- canal 模拟 MySQL slave 的交互协议,伪装自己为 MySQL slave ,向 MySQL master 发送dump 协议

+- MySQL master 收到 dump 请求,开始推送 binary log 给 slave (即 canal )

+- canal 解析 binary log 对象(原始为 byte 流)

+

+## 2.开启MySQL Binlog

+

+- 对于自建 MySQL , 需要先开启 Binlog 写入功能,配置 binlog-format 为 ROW 模式,my.cnf 中配置如下

+

+```ini

+[mysqld]

+log-bin=mysql-bin # 开启 binlog

+binlog-format=ROW # 选择 ROW 模式

+server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复

+lua

+## 复制代码注意:针对阿里云 RDS for MySQL , 默认打开了 binlog , 并且账号默认具有 binlog dump 权限 , 不需要任何权限或者 binlog 设置,可以直接跳过这一步

+```

+

+- 授权 canal 链接 MySQL 账号具有作为 MySQL slave 的权限, 如果已有账户可直接 grant

+

+```sql

+CREATE USER canal IDENTIFIED BY 'canal';

+GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

+-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;

+FLUSH PRIVILEGES;

+```

+

+注意:Mysql版本为8.x时启动canal可能会出现“caching_sha2_password Auth failed”错误,这是因为8.x创建用户时默认的密码加密方式为**caching_sha2_password**,与canal的方式不一致,所以需要将canal用户的密码加密方式修改为**mysql_native_password**

+

+```sql

+ALTER USER 'canal'@'%' IDENTIFIED WITH mysql_native_password BY 'canal'; #更新一下用户密码

+FLUSH PRIVILEGES; #刷新权限

+```

+

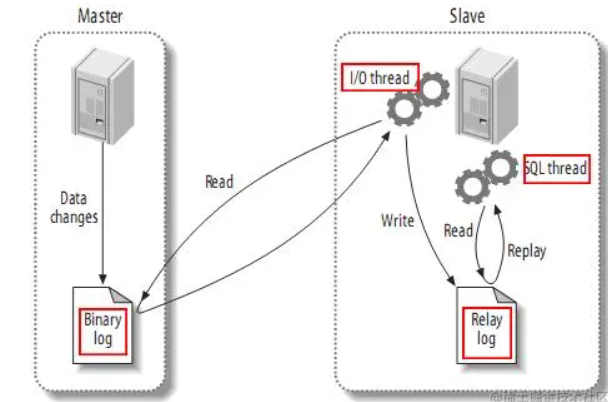

+## 3.安装Canal

+

+### 3.1 下载Canal

+

+**点击下载地址,选择版本后点击canal.deployer文件下载**

+

+

+

+### 3.2 修改配置文件

+

+打开目录下conf/example/instance.properties文件,主要修改以下内容

+

+```ini

+## mysql serverId,不要和 mysql 的 server_id 重复

+canal.instance.mysql.slaveId = 10

+#position info,需要改成自己的数据库信息

+canal.instance.master.address = 127.0.0.1:3306

+#username/password,需要改成自己的数据库信息,与刚才添加的用户保持一致

+canal.instance.dbUsername = canal

+canal.instance.dbPassword = canal

+```

+

+### 3.3 启动和关闭

+

+```bash

+#进入文件目录下的bin文件夹

+#启动

+sh startup.sh

+#关闭

+sh stop.sh

+```

+

+## 4.Springboot集成Canal

+

+### 4.1 Canal数据结构

+

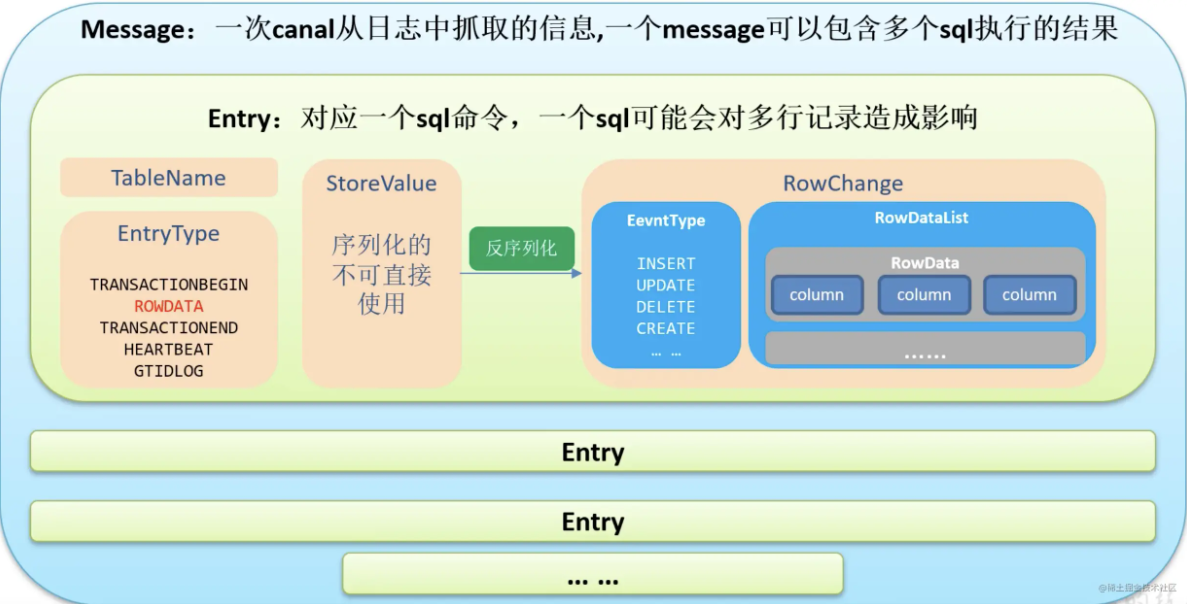

+

+

+### 4.2 引入依赖

+

+```xml

+

+

+ com.alibaba.otter

+ canal.client

+ 1.1.6

+

+

+

+

+

+ com.alibaba.otter

+ canal.protocol

+ 1.1.6

+

+

+

+

+ co.elastic.clients

+ elasticsearch-java

+ 8.4.3

+

+

+

+

+ jakarta.json

+ jakarta.json-api

+ 2.0.1

+

+```

+

+### 4.3 application.yaml

+

+```yaml

+custom:

+ elasticsearch:

+ host: localhost #主机

+ port: 9200 #端口

+ username: elastic #用户名

+ password: 3bf24a76 #密码

+```

+

+### 4.4 EsClient

+

+```java

+@Setter

+@ConfigurationProperties(prefix = "custom.elasticsearch")

+@Configuration

+public class EsClient {

+

+ /**

+ * 主机

+ */

+ private String host;

+

+ /**

+ * 端口

+ */

+ private Integer port;

+

+ /**

+ * 用户名

+ */

+ private String username;

+

+ /**

+ * 密码

+ */

+ private String password;

+

+

+ @Bean

+ public ElasticsearchClient elasticsearchClient() {

+ CredentialsProvider credentialsProvider = new BasicCredentialsProvider();

+ credentialsProvider.setCredentials(

+ AuthScope.ANY, new UsernamePasswordCredentials(username, password));

+

+ // Create the low-level client

+ RestClient restClient = RestClient.builder(new HttpHost(host, port))

+ .setHttpClientConfigCallback(httpAsyncClientBuilder ->

+ httpAsyncClientBuilder.setDefaultCredentialsProvider(credentialsProvider))

+ .build();

+ // Create the transport with a Jackson mapper

+ RestClientTransport transport = new RestClientTransport(

+ restClient, new JacksonJsonpMapper());

+ // Create the transport with a Jackson mapper

+ return new ElasticsearchClient(transport);

+ }

+}

+```

+

+### 4.5 Music实体类

+

+```java

+@Data

+@Builder

+@NoArgsConstructor

+@AllArgsConstructor

+public class Music {

+

+ /**

+ * id

+ */

+ private String id;

+

+ /**

+ * 歌名

+ */

+ private String name;

+

+ /**

+ * 歌手名

+ */

+ private String singer;

+

+ /**

+ * 封面图地址

+ */

+ private String imageUrl;

+

+ /**

+ * 歌曲地址

+ */

+ private String musicUrl;

+

+ /**

+ * 歌词地址

+ */

+ private String lrcUrl;

+

+ /**

+ * 歌曲类型id

+ */

+ private String typeId;

+

+ /**

+ * 是否被逻辑删除,1 是,0 否

+ */

+ private Integer isDeleted;

+

+ /**

+ * 创建时间

+ */

+ @JsonFormat(shape = JsonFormat.Shape.STRING, pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

+ private Date createTime;

+

+ /**

+ * 更新时间

+ */

+ @JsonFormat(shape = JsonFormat.Shape.STRING, pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

+ private Date updateTime;

+

+}

+```

+

+### 4.6 CanalClient

+

+```java

+@Slf4j

+@Component

+public class CanalClient {

+

+ @Resource

+ private ElasticsearchClient client;

+

+

+ /**

+ * 实时数据同步程序

+ *

+ * @throws InterruptedException

+ * @throws InvalidProtocolBufferException

+ */

+ public void run() throws InterruptedException, IOException {

+ CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(

+ "localhost", 11111), "example", "", "");

+

+ while (true) {

+ //连接

+ connector.connect();

+ //订阅数据库

+ connector.subscribe("cloudmusic_music.music");

+ //获取数据

+ Message message = connector.get(100);

+

+ List entryList = message.getEntries();

+ if (CollectionUtils.isEmpty(entryList)) {

+ //没有数据,休息一会

+ TimeUnit.SECONDS.sleep(2);

+ } else {

+ for (CanalEntry.Entry entry : entryList) {

+ //获取类型

+ CanalEntry.EntryType entryType = entry.getEntryType();

+

+ //判断类型是否为ROWDATA

+ if (CanalEntry.EntryType.ROWDATA.equals(entryType)) {

+ //获取序列化后的数据

+ ByteString storeValue = entry.getStoreValue();

+ //反序列化数据

+ CanalEntry.RowChange rowChange = CanalEntry.RowChange.parseFrom(storeValue);

+ //获取当前事件操作类型

+ CanalEntry.EventType eventType = rowChange.getEventType();

+ //获取数据集

+ List rowDataList = rowChange.getRowDatasList();

+

+ if (eventType == CanalEntry.EventType.INSERT) {

+ log.info("------新增操作------");

+

+ List musicList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ musicList.add(createMusic(rowData.getAfterColumnsList()));

+ }

+ //es批量新增文档

+ index(musicList);

+ //打印新增集合

+ log.info(Arrays.toString(musicList.toArray()));

+ } else if (eventType == CanalEntry.EventType.UPDATE) {

+ log.info("------更新操作------");

+

+ List beforeMusicList = new ArrayList<>();

+ List afterMusicList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ //更新前

+ beforeMusicList.add(createMusic(rowData.getBeforeColumnsList()));

+ //更新后

+ afterMusicList.add(createMusic(rowData.getAfterColumnsList()));

+ }

+ //es批量更新文档

+ index(afterMusicList);

+ //打印更新前集合

+ log.info("更新前:{}", Arrays.toString(beforeMusicList.toArray()));

+ //打印更新后集合

+ log.info("更新后:{}", Arrays.toString(afterMusicList.toArray()));

+ } else if (eventType == CanalEntry.EventType.DELETE) {

+ //删除操作

+ log.info("------删除操作------");

+

+ List idList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ for (CanalEntry.Column column : rowData.getBeforeColumnsList()) {

+ if("id".equals(column.getName())) {

+ idList.add(column.getValue());

+ break;

+ }

+ }

+ }

+ //es批量删除文档

+ delete(idList);

+ //打印删除id集合

+ log.info(Arrays.toString(idList.toArray()));

+ }

+ }

+ }

+ }

+ }

+ }

+

+ /**

+ * 根据canal获取的数据创建Music对象

+ *

+ * @param columnList

+ * @return

+ */

+ private Music createMusic(List columnList) {

+ Music music = new Music();

+ DateTimeFormatter formatter = DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss");

+

+ for (CanalEntry.Column column : columnList) {

+ switch (column.getName()) {

+ case "id" -> music.setId(column.getValue());

+ case "name" -> music.setName(column.getValue());

+ case "singer" -> music.setSinger(column.getValue());

+ case "image_url" -> music.setImageUrl(column.getValue());

+ case "music_url" -> music.setMusicUrl(column.getValue());

+ case "lrc_url" -> music.setLrcUrl(column.getValue());

+ case "type_id" -> music.setTypeId(column.getValue());

+ case "is_deleted" -> music.setIsDeleted(Integer.valueOf(column.getValue()));

+ case "create_time" ->

+ music.setCreateTime(Date.from(LocalDateTime.parse(column.getValue(), formatter).atZone(ZoneId.systemDefault()).toInstant()));

+ case "update_time" ->

+ music.setUpdateTime(Date.from(LocalDateTime.parse(column.getValue(), formatter).atZone(ZoneId.systemDefault()).toInstant()));

+ default -> {

+ }

+ }

+ }

+

+ return music;

+ }

+

+ /**

+ * es批量新增、更新文档(不存在:新增, 存在:更新)

+ *

+ * @param musicList 音乐集合

+ * @throws IOException

+ */

+ private void index(List musicList) throws IOException {

+ BulkRequest.Builder br = new BulkRequest.Builder();

+

+ musicList.forEach(music -> br

+ .operations(op -> op

+ .index(idx -> idx

+ .index("music")

+ .id(music.getId())

+ .document(music))));

+

+ client.bulk(br.build());

+ }

+

+ /**

+ * es批量删除文档

+ *

+ * @param idList 音乐id集合

+ * @throws IOException

+ */

+ private void delete(List idList) throws IOException {

+ BulkRequest.Builder br = new BulkRequest.Builder();

+

+ idList.forEach(id -> br

+ .operations(op -> op

+ .delete(idx -> idx

+ .index("music")

+ .id(id))));

+

+ client.bulk(br.build());

+ }

+

+}

+```

+

+### 4.7 ApplicationContextAware

+

+```java

+@Component

+public class ApplicationContextUtil implements ApplicationContextAware {

+

+ private static ApplicationContext applicationContext;

+

+ @Override

+ public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

+ ApplicationContextUtil.applicationContext = applicationContext;

+ }

+

+ public static T getBean (Class classType) {

+ return applicationContext.getBean(classType);

+ }

+

+}

+```

+

+### 4.8 main

+

+```java

+@Slf4j

+@SpringBootApplication

+public class CanalApplication {

+ public static void main(String[] args) throws InterruptedException, IOException {

+ SpringApplication.run(CanalApplication.class, args);

+ log.info("数据同步程序启动");

+

+ CanalClient client = ApplicationContextUtil.getBean(CanalClient.class);

+ client.run();

+ }

+}

+```

+

+## 5.总结

+

+那么以上就是Canal组件的介绍啦,希望大家都能有所收获~

+

diff --git a/docs/learn/ghelper.md b/docs/learn/ghelper.md

index a640f63..f5de885 100644

--- a/docs/learn/ghelper.md

+++ b/docs/learn/ghelper.md

@@ -1,4 +1,17 @@

-# 科学上网教程

+---

+sidebar: heading

+title: 科学上网教程

+category: 工具

+tag:

+ - 工具

+head:

+ - - meta

+ - name: keywords

+ content: ghelper

+ - - meta

+ - name: description

+ content: 提高工作效率的工具

+---

@@ -64,10 +77,16 @@ Ghelper可以在google play商店进行下载,需要访问google商店,无

-> 最后给大家分享一个Github仓库,上面有大彬整理的**300多本经典的计算机书籍PDF**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、架构、分布式、微服务、机器学习、编程人生**等,可以star一下,下次找书直接在上面搜索,仓库持续更新中~

-

-

+最后给大家分享一个Github仓库,上面有大彬整理的**300多本经典的计算机书籍PDF**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,可以star一下,下次找书直接在上面搜索,仓库持续更新中~

-**Github地址**:https://github.com/Tyson0314/java-books

\ No newline at end of file

+

+

+

+

+[**Github地址**](https://github.com/Tyson0314/java-books)

+

+如果访问不了Github,可以访问码云地址。

+

+[码云地址](https://gitee.com/tysondai/java-books)

\ No newline at end of file

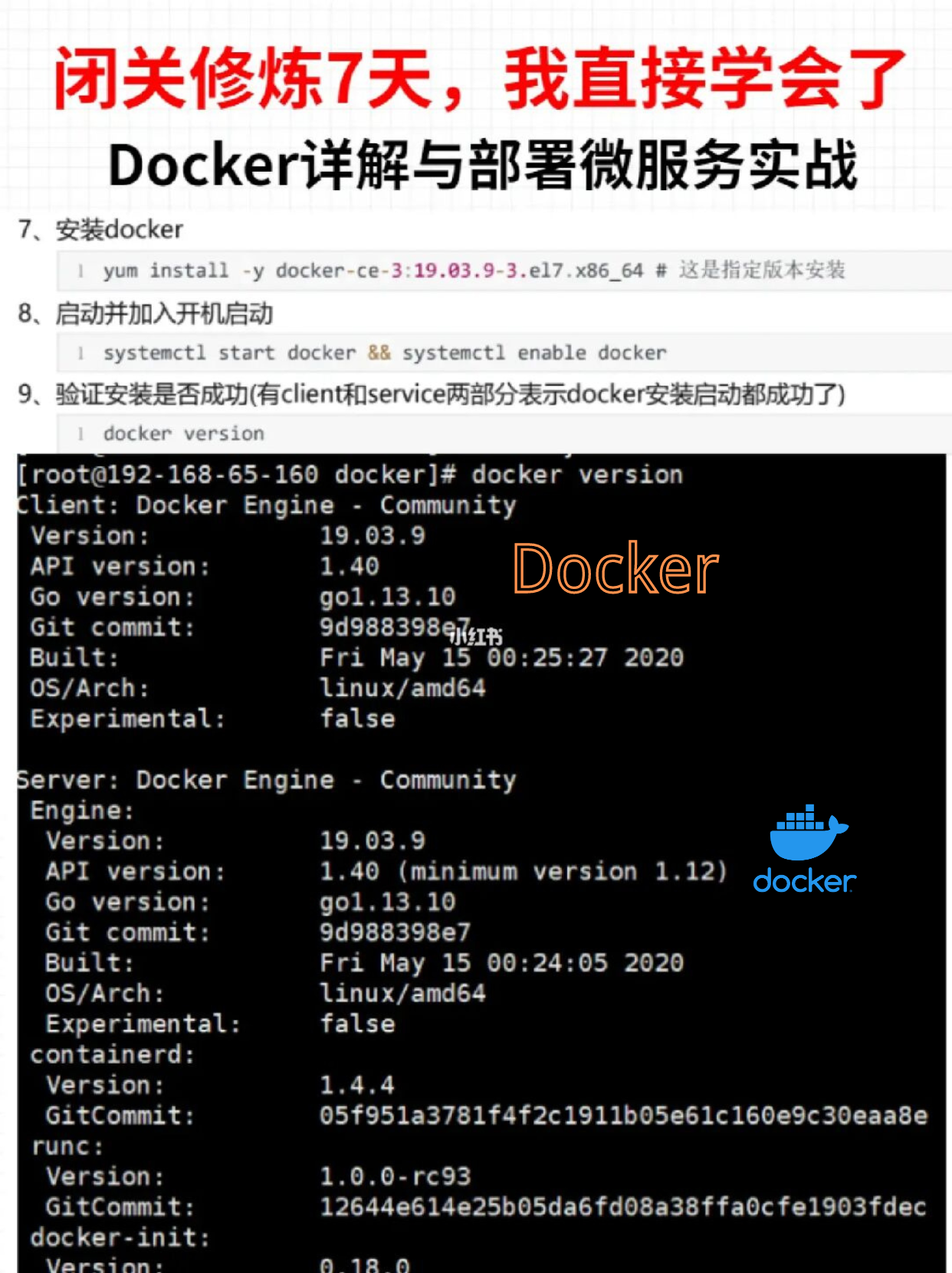

diff --git a/docs/note/docker-note.md b/docs/note/docker-note.md

new file mode 100644

index 0000000..68a8f62

--- /dev/null

+++ b/docs/note/docker-note.md

@@ -0,0 +1,15 @@

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

\ No newline at end of file

diff --git a/docs/note/write-sql.md b/docs/note/write-sql.md

new file mode 100644

index 0000000..14faa3a

--- /dev/null

+++ b/docs/note/write-sql.md

@@ -0,0 +1,93 @@

+::: tip 这是一则或许对你有帮助的信息

+

+- **面试手册**:这是一份大彬精心整理的[**大厂面试手册**](https://topjavaer.cn/zsxq/mianshishouce.html)最新版,目前已经更新迭代了**19**个版本,质量很高(专为面试打造)

+- **知识星球**:**专属面试手册/一对一交流/简历修改/超棒的学习氛围/学习路线规划**,欢迎加入[大彬的知识星球](https://topjavaer.cn/zsxq/introduce.html)(点击链接查看星球的详细介绍)

+

+:::

+

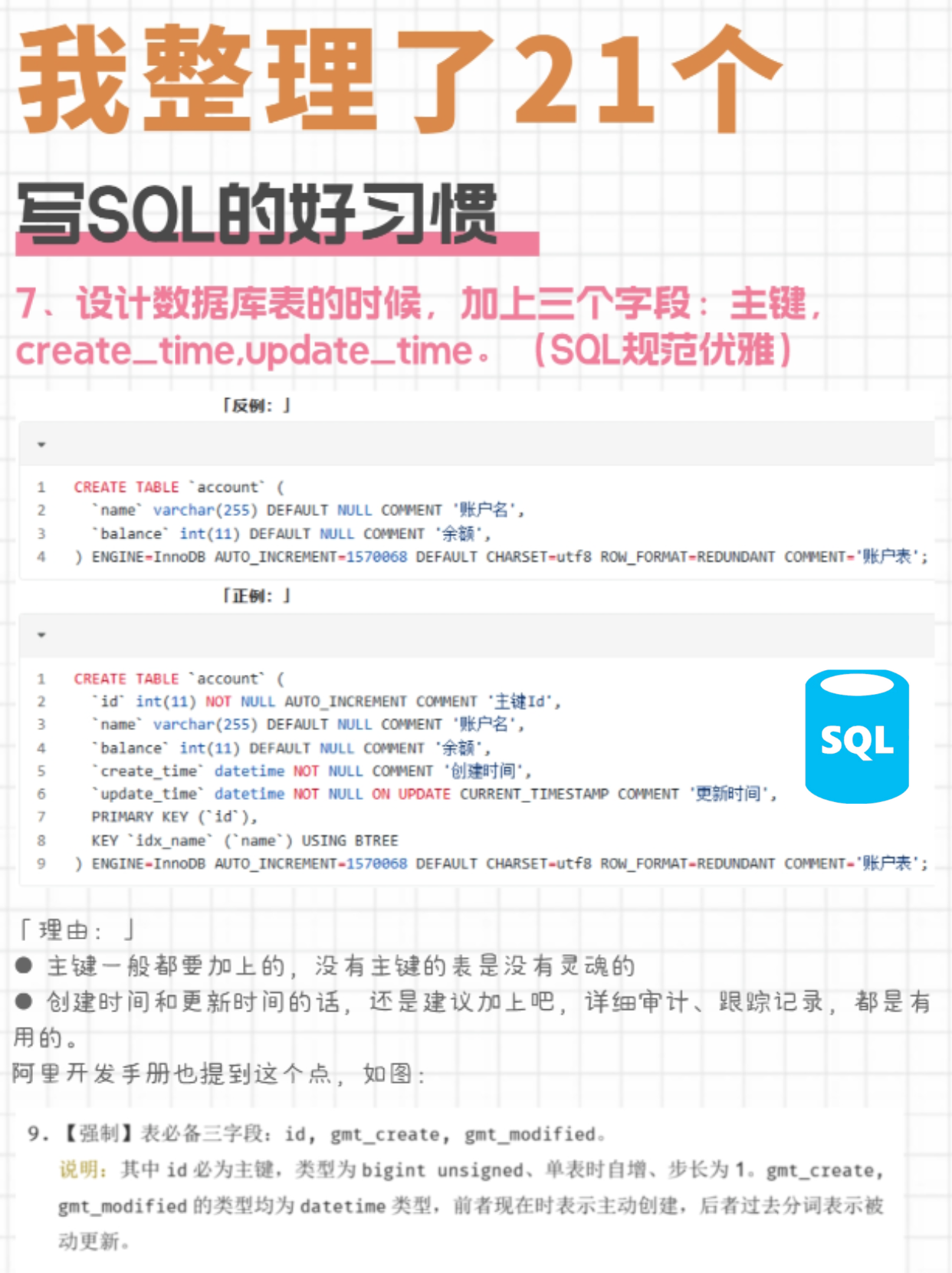

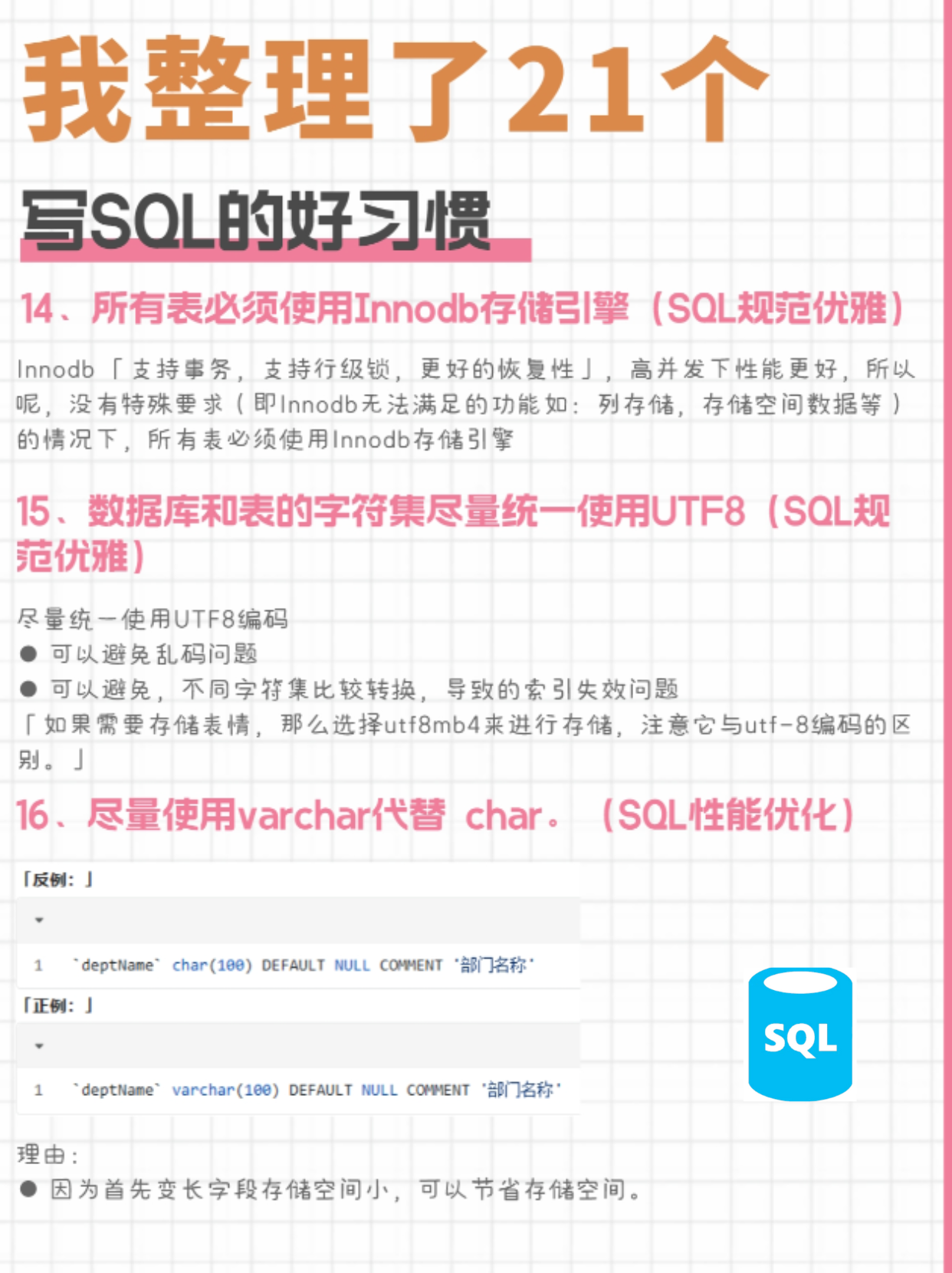

+## 21个写SQL的好习惯

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+## MySQL面试题

+

+下面分享MySQL常考的**面试题目**。

+

+- [事务的四大特性?](https://topjavaer.cn/database/mysql.html#%E4%BA%8B%E5%8A%A1%E7%9A%84%E5%9B%9B%E5%A4%A7%E7%89%B9%E6%80%A7)

+- [数据库的三大范式](https://topjavaer.cn/database/mysql.html#%E6%95%B0%E6%8D%AE%E5%BA%93%E7%9A%84%E4%B8%89%E5%A4%A7%E8%8C%83%E5%BC%8F)

+- [事务隔离级别有哪些?](https://topjavaer.cn/database/mysql.html#%E4%BA%8B%E5%8A%A1%E9%9A%94%E7%A6%BB%E7%BA%A7%E5%88%AB%E6%9C%89%E5%93%AA%E4%BA%9B)

+- [生产环境数据库一般用的什么隔离级别呢?](https://topjavaer.cn/database/mysql.html#%E7%94%9F%E4%BA%A7%E7%8E%AF%E5%A2%83%E6%95%B0%E6%8D%AE%E5%BA%93%E4%B8%80%E8%88%AC%E7%94%A8%E7%9A%84%E4%BB%80%E4%B9%88%E9%9A%94%E7%A6%BB%E7%BA%A7%E5%88%AB%E5%91%A2)

+- [编码和字符集的关系](https://topjavaer.cn/database/mysql.html#%E7%BC%96%E7%A0%81%E5%92%8C%E5%AD%97%E7%AC%A6%E9%9B%86%E7%9A%84%E5%85%B3%E7%B3%BB)

+- [utf8和utf8mb4的区别](https://topjavaer.cn/database/mysql.html#utf8%E5%92%8Cutf8mb4%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [什么是索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E7%B4%A2%E5%BC%95)

+- [索引的优缺点?](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E7%9A%84%E4%BC%98%E7%BC%BA%E7%82%B9)

+- [索引的作用?](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E7%9A%84%E4%BD%9C%E7%94%A8)

+- [什么情况下需要建索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%83%85%E5%86%B5%E4%B8%8B%E9%9C%80%E8%A6%81%E5%BB%BA%E7%B4%A2%E5%BC%95)

+- [什么情况下不建索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%83%85%E5%86%B5%E4%B8%8B%E4%B8%8D%E5%BB%BA%E7%B4%A2%E5%BC%95)

+- [索引的数据结构](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E7%9A%84%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)

+- [Hash索引和B+树索引的区别?](https://topjavaer.cn/database/mysql.html#hash%E7%B4%A2%E5%BC%95%E5%92%8Cb%E6%A0%91%E7%B4%A2%E5%BC%95%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [为什么B+树比B树更适合实现数据库索引?](https://topjavaer.cn/database/mysql.html#%E4%B8%BA%E4%BB%80%E4%B9%88b%E6%A0%91%E6%AF%94b%E6%A0%91%E6%9B%B4%E9%80%82%E5%90%88%E5%AE%9E%E7%8E%B0%E6%95%B0%E6%8D%AE%E5%BA%93%E7%B4%A2%E5%BC%95)

+- [索引有什么分类?](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E6%9C%89%E4%BB%80%E4%B9%88%E5%88%86%E7%B1%BB)

+- [什么是最左匹配原则?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E6%9C%80%E5%B7%A6%E5%8C%B9%E9%85%8D%E5%8E%9F%E5%88%99)

+- [什么是聚集索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E8%81%9A%E9%9B%86%E7%B4%A2%E5%BC%95)

+- [什么是覆盖索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E8%A6%86%E7%9B%96%E7%B4%A2%E5%BC%95)

+- [索引的设计原则?](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E7%9A%84%E8%AE%BE%E8%AE%A1%E5%8E%9F%E5%88%99)

+- [索引什么时候会失效?](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E4%BB%80%E4%B9%88%E6%97%B6%E5%80%99%E4%BC%9A%E5%A4%B1%E6%95%88)

+- [什么是前缀索引?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E5%89%8D%E7%BC%80%E7%B4%A2%E5%BC%95)

+- [索引下推](https://topjavaer.cn/database/mysql.html#%E7%B4%A2%E5%BC%95%E4%B8%8B%E6%8E%A8)

+- [常见的存储引擎有哪些?](https://topjavaer.cn/database/mysql.html#%E5%B8%B8%E8%A7%81%E7%9A%84%E5%AD%98%E5%82%A8%E5%BC%95%E6%93%8E%E6%9C%89%E5%93%AA%E4%BA%9B)

+- [MyISAM和InnoDB的区别?](https://topjavaer.cn/database/mysql.html#myisam%E5%92%8Cinnodb%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [MySQL有哪些锁?](https://topjavaer.cn/database/mysql.html#mysql%E6%9C%89%E5%93%AA%E4%BA%9B%E9%94%81)

+- [MVCC 实现原理?](https://topjavaer.cn/database/mysql.html#mvcc-%E5%AE%9E%E7%8E%B0%E5%8E%9F%E7%90%86)

+- [快照读和当前读](https://topjavaer.cn/database/mysql.html#%E5%BF%AB%E7%85%A7%E8%AF%BB%E5%92%8C%E5%BD%93%E5%89%8D%E8%AF%BB)

+- [共享锁和排他锁](https://topjavaer.cn/database/mysql.html#%E5%85%B1%E4%BA%AB%E9%94%81%E5%92%8C%E6%8E%92%E4%BB%96%E9%94%81)

+- [bin log/redo log/undo log](https://topjavaer.cn/database/mysql.html#bin-logredo-logundo-log)

+- [bin log和redo log有什么区别?](https://topjavaer.cn/database/mysql.html#bin-log%E5%92%8Credo-log%E6%9C%89%E4%BB%80%E4%B9%88%E5%8C%BA%E5%88%AB)

+- [讲一下MySQL架构?](https://topjavaer.cn/database/mysql.html#%E8%AE%B2%E4%B8%80%E4%B8%8Bmysql%E6%9E%B6%E6%9E%84)

+- [分库分表](https://topjavaer.cn/database/mysql.html#%E5%88%86%E5%BA%93%E5%88%86%E8%A1%A8)

+- [什么是分区表?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AF%E5%88%86%E5%8C%BA%E8%A1%A8)

+- [分区表类型](https://topjavaer.cn/database/mysql.html#%E5%88%86%E5%8C%BA%E8%A1%A8%E7%B1%BB%E5%9E%8B)

+- [分区的问题?](https://topjavaer.cn/database/mysql.html#%E5%88%86%E5%8C%BA%E7%9A%84%E9%97%AE%E9%A2%98)

+- [查询语句执行流程?](https://topjavaer.cn/database/mysql.html#%E6%9F%A5%E8%AF%A2%E8%AF%AD%E5%8F%A5%E6%89%A7%E8%A1%8C%E6%B5%81%E7%A8%8B)

+- [更新语句执行过程?](https://topjavaer.cn/database/mysql.html#%E6%9B%B4%E6%96%B0%E8%AF%AD%E5%8F%A5%E6%89%A7%E8%A1%8C%E8%BF%87%E7%A8%8B)

+- [exist和in的区别?](https://topjavaer.cn/database/mysql.html#exist%E5%92%8Cin%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [MySQL中int()和char()的区别?](https://topjavaer.cn/database/mysql.html#mysql%E4%B8%ADint10%E5%92%8Cchar10%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [truncate、delete与drop区别?](https://topjavaer.cn/database/mysql.html#truncatedelete%E4%B8%8Edrop%E5%8C%BA%E5%88%AB)

+- [having和where区别?](https://topjavaer.cn/database/mysql.html#having%E5%92%8Cwhere%E5%8C%BA%E5%88%AB)

+- [什么是MySQL主从同步?](https://topjavaer.cn/database/mysql.html#%E4%BB%80%E4%B9%88%E6%98%AFmysql%E4%B8%BB%E4%BB%8E%E5%90%8C%E6%AD%A5)

+- [为什么要做主从同步?](https://topjavaer.cn/database/mysql.html#%E4%B8%BA%E4%BB%80%E4%B9%88%E8%A6%81%E5%81%9A%E4%B8%BB%E4%BB%8E%E5%90%8C%E6%AD%A5)

+- [乐观锁和悲观锁是什么?](https://topjavaer.cn/database/mysql.html#%E4%B9%90%E8%A7%82%E9%94%81%E5%92%8C%E6%82%B2%E8%A7%82%E9%94%81%E6%98%AF%E4%BB%80%E4%B9%88)

+- [用过processlist吗?](https://topjavaer.cn/database/mysql.html#%E7%94%A8%E8%BF%87processlist%E5%90%97)

+- [MySQL查询 limit 1000,10 和limit 10 速度一样快吗?](https://topjavaer.cn/database/mysql.html#mysql%E6%9F%A5%E8%AF%A2-limit-100010-%E5%92%8Climit-10-%E9%80%9F%E5%BA%A6%E4%B8%80%E6%A0%B7%E5%BF%AB%E5%90%97)

+- [深分页怎么优化?](https://topjavaer.cn/database/mysql.html#%E6%B7%B1%E5%88%86%E9%A1%B5%E6%80%8E%E4%B9%88%E4%BC%98%E5%8C%96)

+- [高度为3的B+树,可以存放多少数据?](https://topjavaer.cn/database/mysql.html#%E9%AB%98%E5%BA%A6%E4%B8%BA3%E7%9A%84b%E6%A0%91%E5%8F%AF%E4%BB%A5%E5%AD%98%E6%94%BE%E5%A4%9A%E5%B0%91%E6%95%B0%E6%8D%AE)

+- [MySQL单表多大进行分库分表?](https://topjavaer.cn/database/mysql.html#mysql%E5%8D%95%E8%A1%A8%E5%A4%9A%E5%A4%A7%E8%BF%9B%E8%A1%8C%E5%88%86%E5%BA%93%E5%88%86%E8%A1%A8)

+- [大表查询慢怎么优化?](https://topjavaer.cn/database/mysql.html#%E5%A4%A7%E8%A1%A8%E6%9F%A5%E8%AF%A2%E6%85%A2%E6%80%8E%E4%B9%88%E4%BC%98%E5%8C%96)

+- [说说count()、count()和count()的区别](https://topjavaer.cn/database/mysql.html#%E8%AF%B4%E8%AF%B4count1count%E5%92%8Ccount%E5%AD%97%E6%AE%B5%E5%90%8D%E7%9A%84%E5%8C%BA%E5%88%AB)

+- [MySQL中DATETIME 和 TIMESTAMP有什么区别?](https://topjavaer.cn/database/mysql.html#mysql%E4%B8%ADdatetime-%E5%92%8C-timestamp%E6%9C%89%E4%BB%80%E4%B9%88%E5%8C%BA%E5%88%AB)

+- [说说为什么不建议用外键?](https://topjavaer.cn/database/mysql.html#%E8%AF%B4%E8%AF%B4%E4%B8%BA%E4%BB%80%E4%B9%88%E4%B8%8D%E5%BB%BA%E8%AE%AE%E7%94%A8%E5%A4%96%E9%94%AE)

+- [使用自增主键有什么好处?](https://topjavaer.cn/database/mysql.html#%E4%BD%BF%E7%94%A8%E8%87%AA%E5%A2%9E%E4%B8%BB%E9%94%AE%E6%9C%89%E4%BB%80%E4%B9%88%E5%A5%BD%E5%A4%84)

+- [自增主键保存在什么地方?](https://topjavaer.cn/database/mysql.html#%E8%87%AA%E5%A2%9E%E4%B8%BB%E9%94%AE%E4%BF%9D%E5%AD%98%E5%9C%A8%E4%BB%80%E4%B9%88%E5%9C%B0%E6%96%B9)

+- [自增主键一定是连续的吗?](https://topjavaer.cn/database/mysql.html#%E8%87%AA%E5%A2%9E%E4%B8%BB%E9%94%AE%E4%B8%80%E5%AE%9A%E6%98%AF%E8%BF%9E%E7%BB%AD%E7%9A%84%E5%90%97)

+- [InnoDB的自增值为什么不能回收利用?](https://topjavaer.cn/database/mysql.html#innodb%E7%9A%84%E8%87%AA%E5%A2%9E%E5%80%BC%E4%B8%BA%E4%BB%80%E4%B9%88%E4%B8%8D%E8%83%BD%E5%9B%9E%E6%94%B6%E5%88%A9%E7%94%A8)

+- [MySQL数据如何同步到Redis缓存?](https://topjavaer.cn/database/mysql.html#mysql%E6%95%B0%E6%8D%AE%E5%A6%82%E4%BD%95%E5%90%8C%E6%AD%A5%E5%88%B0redis%E7%BC%93%E5%AD%98)

\ No newline at end of file

diff --git a/docs/zsxq/article/select-max-rows.md b/docs/zsxq/article/select-max-rows.md

new file mode 100644

index 0000000..9ffabc2

--- /dev/null

+++ b/docs/zsxq/article/select-max-rows.md

@@ -0,0 +1,225 @@

+## 问题

+

+一条这样的 SQL 语句能查询出多少条记录?

+

+```SQL

+select * from user

+```

+

+表中有 100 条记录的时候能全部查询出来返回给客户端吗?

+

+如果记录数是 1w 呢? 10w 呢? 100w 、1000w 呢?

+

+虽然在实际业务操作中我们不会这么干,尤其对于数据量大的表不会这样干,但这是个值得想一想的问题。

+

+## 寻找答案

+

+前提:以下所涉及资料全部基于 MySQL 8

+

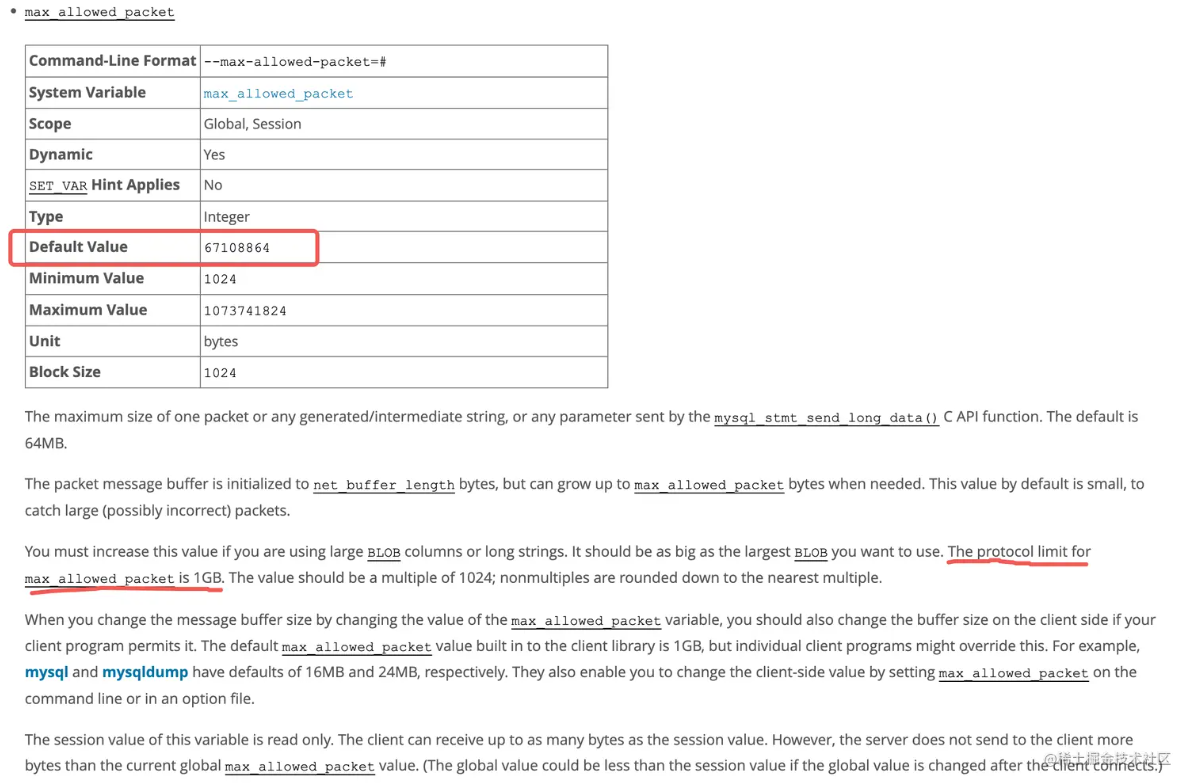

+### max_allowed_packet

+

+在查询资料的过程中发现了这个参数 `max_allowed_packet`

+

+

+

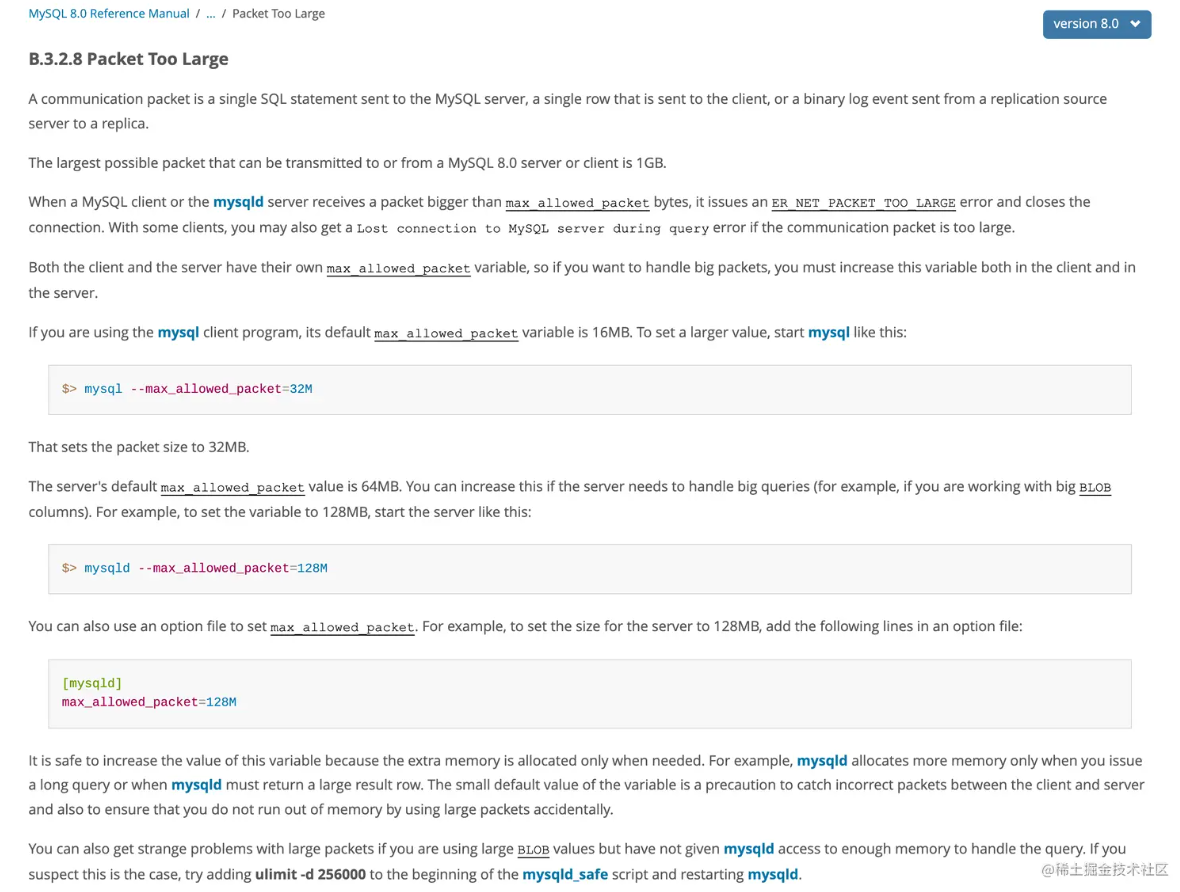

+上图参考了 MySQL 的官方文档,根据文档我们知道:

+

+- MySQL 客户端 `max_allowed_packet` 值的默认大小为 16M(不同的客户端可能有不同的默认值,但最大不能超过 1G)

+- MySQL 服务端 `max_allowed_packet` 值的默认大小为 64M

+- `max_allowed_packet` 值最大可以设置为 1G(1024 的倍数)

+

+然而 根据上图的文档中所述

+

+> The maximum size of one packet or any generated/intermediate string,or any parameter sent by the mysql_smt_send_long_data() C API function

+

+- one packet

+- generated/intermediate string

+- any parameter sent by the mysql_smt_send_long_data() C API function

+

+这三个东东具体都是什么呢? `packet` 到底是结果集大小,还是网络包大小还是什么? 于是 google 了一下,搜索排名第一的是这个:

+

+

+

+根据 “Packet Too Large” 的说明, 通信包 (communication packet) 是

+

+- 一个被发送到 MySQL 服务器的单个 SQL 语句

+- 或者是一个被发送到客户端的**单行记录**

+- 或者是一个从主服务器 (replication source server) 被发送到从属服务器 (replica) 的二进制日志事件。

+

+1、3 点好理解,这也同时解释了,如果你发送的一条 SQL 语句特别大可能会执行不成功的原因,尤其是`insert` `update` 这种,单个 SQL 语句不是没有上限的,不过这种情况一般不是因为 SQL 语句写的太长,主要是由于某个字段的值过大,比如有 BLOB 字段。

+

+那么第 2 点呢,单行记录,默认值是 64M,会不会太大了啊,一行记录有可能这么大的吗? 有必要设置这么大吗? 单行最大存储空间限制又是多少呢?

+

+### 单行最大存储空间

+

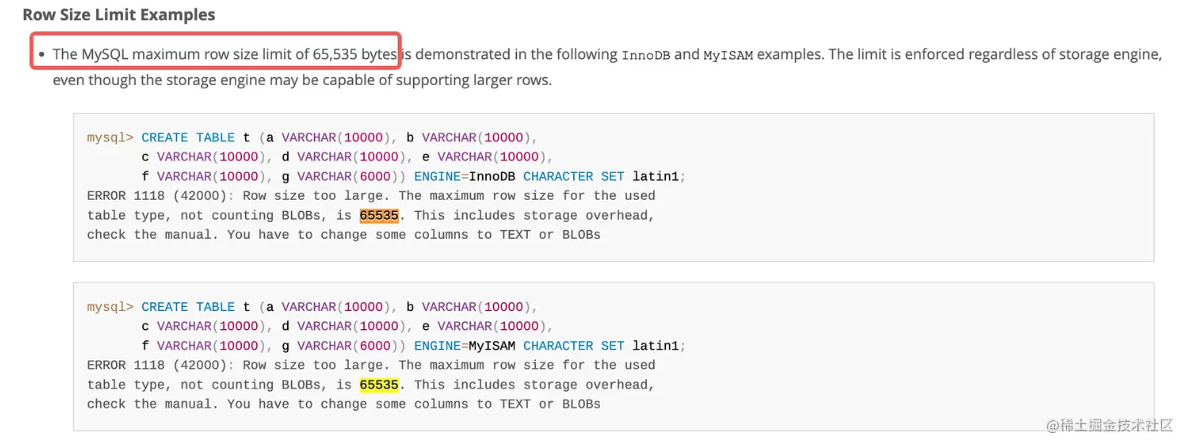

+MySQL 单行最大宽度是 65535 个字节,也就是 64KB 。无论是 InnoDB 引擎还是 MyISAM 引擎。

+

+

+

+通过上图可以看到 超过 65535 不行,不过请注意其中的错误提示:“Row size too large. The maximum row size for the used table type, not counting BLOBs, is 65535” ,如果字段是变长类型的如 BLOB 和 TEXT 就不包括了,那么我们试一下用和上图一样的字段长度,只把最后一个字段的类型改成 BLOB 和 TEXT

+

+```SQL

+mysql> CREATE TABLE t (a VARCHAR(10000), b VARCHAR(10000),

+ c VARCHAR(10000), d VARCHAR(10000), e VARCHAR(10000),

+ f VARCHAR(10000), g TEXT(6000)) ENGINE=InnoDB CHARACTER SET latin1;

+Query OK, 0 rows affected (0.02 sec)

+```

+

+可见无论 是改成 BLOB 还是 TEXT 都可以成功。但这里请注意,字符集是 `latin1` 可以成功,如果换成 `utf8mb4` 或者 `utf8mb3` 就不行了,会报错,仍然是 :“Row size too large. The maximum row size for the used table type, not counting BLOBs, is 65535.” 为什么呢?

+

+**因为虽然不包括 TEXT 和 BLOB, 但总长度还是超了!**

+

+我们先看一下这个熟悉的 VARCHAR(255) , 你有没有想过为什么用 255,不用 256?

+

+> 在 4.0 版本以下,varchar(255) 指的是 255 个字节,使用 1 个字节存储长度即可。当大于等于 256 时,要使用 2 个字节存储长度。所以定义 varchar(255) 比 varchar(256) 更好。

+>

+> 但是在 5.0 版本以上,varchar(255) 指的是 255 个字符,每个字符可能占用多个字节,例如使用 UTF8 编码时每个汉字占用 3 字节,使用 GBK 编码时每个汉字占 2 字节。

+

+例子中我们用的是 MySQL8 ,由于字符集是 utf8mb3 ,存储一个字要用三个字节, 长度为 255 的话(列宽),总长度要 765 字节 ,再加上用 2 个字节存储长度,那么这个列的总长度就是 767 字节。所以用 latin1 可以成功,是因为一个字符对应一个字节,而 utf8mb3 或 utf8mb4 一个字符对应三个或四个字节,VARCHAR(10000) 就可能等于要占用 30000 多 40000 多字节,比原来大了 3、4 倍,肯定放不下了。

+

+**另外,还有一个要求**,列的宽度不要超过 MySQL 页大小 (默认 16K)的一半,要比一半小一点儿。 例如,对于默认的 16KB `InnoDB` 页面大小,最大行大小略小于 8KB。

+

+下面这个例子就是超过了一半,所以报错,当然解决办法也在提示中给出了。

+

+```SQL

+mysql> CREATE TABLE t4 (

+ c1 CHAR(255),c2 CHAR(255),c3 CHAR(255),

+ c4 CHAR(255),c5 CHAR(255),c6 CHAR(255),

+ c7 CHAR(255),c8 CHAR(255),c9 CHAR(255),

+ c10 CHAR(255),c11 CHAR(255),c12 CHAR(255),

+ c13 CHAR(255),c14 CHAR(255),c15 CHAR(255),

+ c16 CHAR(255),c17 CHAR(255),c18 CHAR(255),

+ c19 CHAR(255),c20 CHAR(255),c21 CHAR(255),

+ c22 CHAR(255),c23 CHAR(255),c24 CHAR(255),

+ c25 CHAR(255),c26 CHAR(255),c27 CHAR(255),

+ c28 CHAR(255),c29 CHAR(255),c30 CHAR(255),

+ c31 CHAR(255),c32 CHAR(255),c33 CHAR(255)

+ ) ENGINE=InnoDB ROW_FORMAT=DYNAMIC DEFAULT CHARSET latin1;

+ERROR 1118 (42000): Row size too large (> 8126). Changing some columns to TEXT or BLOB may help.

+In current row format, BLOB prefix of 0 bytes is stored inline.

+```

+

+**那么为什么是 8K,不是 7K,也不是 9K 呢?** 这么设计的原因可能是:MySQL 想让一个数据页中能存放更多的数据行,至少也得要存放两行数据(16K)。否则就失去了 B+Tree 的意义。B+Tree 会退化成一个低效的链表。

+

+**你可能还会奇怪,不超过 8K ?你前面的例子明明都快 64K 也能存下,那 8K 到 64K 中间这部分怎么解释?**

+

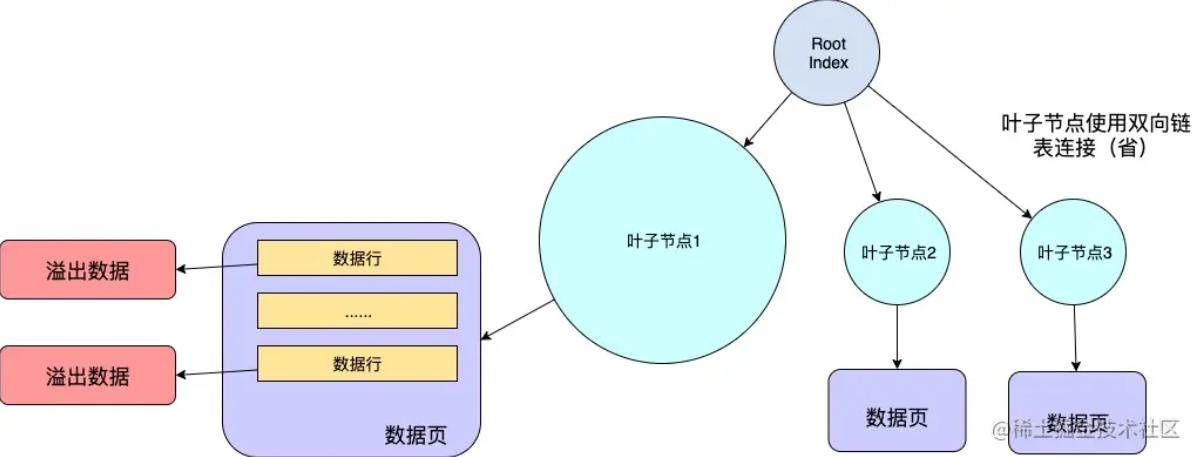

+答:如果包含可变长度列的行超过 `InnoDB` 最大行大小, `InnoDB` 会选择可变长度列进行页外存储,直到该行适合 `InnoDB` ,这也就是为什么前面有超过 8K 的也能成功,那是因为用的是`VARCHAR`这种可变长度类型。

+

+

+

+当你往这个数据页中写入一行数据时,即使它很大将达到了数据页的极限,但是通过行溢出机制。依然能保证你的下一条数据还能写入到这个数据页中。

+

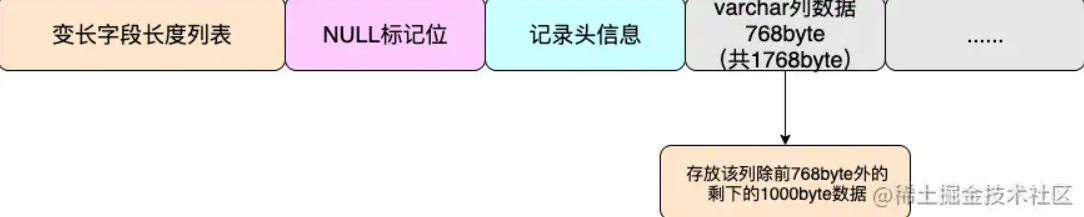

+**我们通过 Compact 格式,简单了解一下什么是 `页外存储` 和 `行溢出`**

+

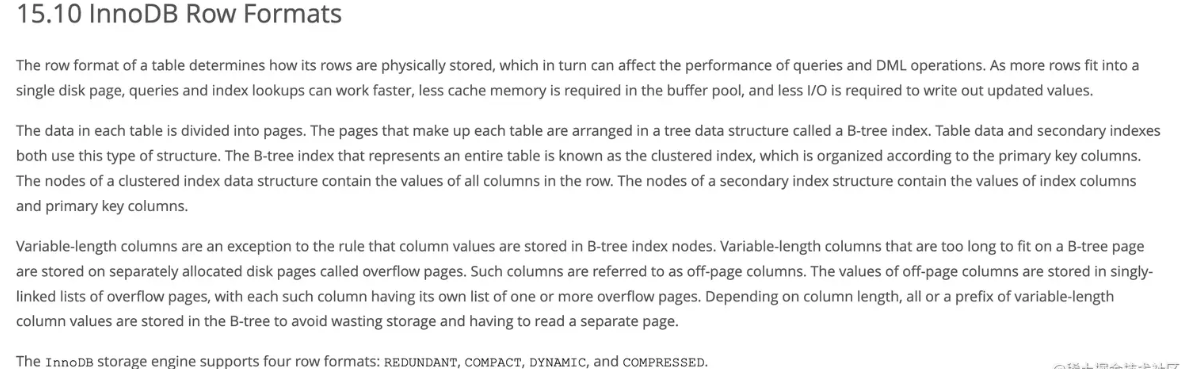

+MySQL8 InnoDB 引擎目前有 4 种 行记录格式:

+

+- REDUNDANT

+- COMPACT

+- DYNAMIC(默认 default 是这个)

+- COMPRESSED

+

+`行记录格式` 决定了其行的物理存储方式,这反过来又会影响查询和 DML 操作的性能。

+

+

+

+Compact 格式的实现思路是:当列的类型为 VARCHAR、 VARBINARY、 BLOB、TEXT 时,该列超过 768byte 的数据放到其他数据页中去。

+

+

+

+在 MySQL 设定中,当 varchar 列长度达到 768byte 后,会将该列的前 768byte 当作当作 prefix 存放在行中,多出来的数据溢出存放到溢出页中,然后通过一个偏移量指针将两者关联起来,这就是 `行溢出`机制

+

+> **假如你要存储的数据行很大超过了 65532byte 那么你是写入不进去的。假如你要存储的单行数据小于 65535byte 但是大于 16384byte,这时你可以成功 insert,但是一个数据页又存储不了你插入的数据。这时肯定会行溢出!**

+

+MySQL 这样做,有效的防止了单个 varchar 列或者 Text 列太大导致单个数据页中存放的行记录过少的情况,避免了 IO 飙升的窘境。

+

+### 单行最大列数限制

+

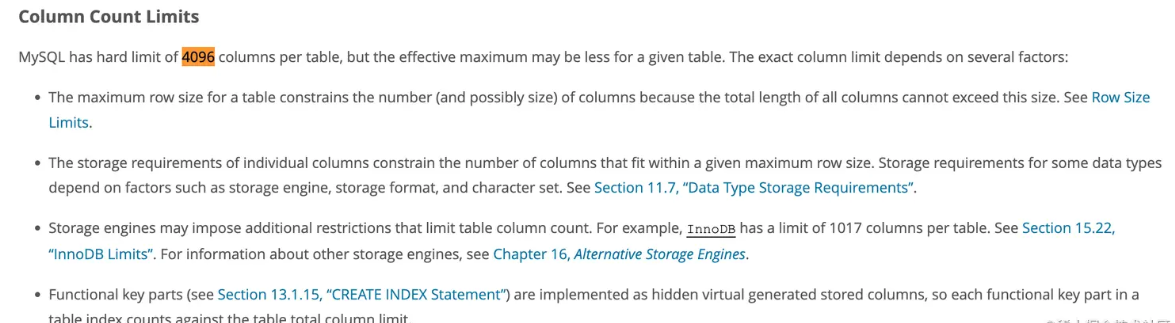

+**mysql 单表最大列数也是有限制的,是 4096 ,但 InnoDB 是 1017**

+

+

+

+### 实验

+

+前文中我们疑惑 `max_allowed_packet` 在 MySQL8 的默认值是 64M,又说这是限制单行数据的,单行数据有这么大吗? 在前文我们介绍了行溢出, 由于有了 `行溢出` ,单行数据确实有可能比较大。

+

+那么还剩下一个问题,`max_allowed_packet` 限制的确定是单行数据吗,难道不是查询结果集的大小吗 ? 下面我们做个实验,验证一下。

+

+建表

+

+```SQL

+CREATE TABLE t1 (

+ c1 CHAR(255),c2 CHAR(255),c3 CHAR(255),

+ c4 CHAR(255),c5 CHAR(255),c6 CHAR(255),

+ c7 CHAR(255),c8 CHAR(255),c9 CHAR(255),

+ c10 CHAR(255),c11 CHAR(255),c12 CHAR(255),

+ c13 CHAR(255),c14 CHAR(255),c15 CHAR(255),

+ c16 CHAR(255),c17 CHAR(255),c18 CHAR(255),

+ c19 CHAR(255),c20 CHAR(255),c21 CHAR(255),

+ c22 CHAR(255),c23 CHAR(255),c24 CHAR(255),

+ c25 CHAR(255),c26 CHAR(255),c27 CHAR(255),

+ c28 CHAR(255),c29 CHAR(255),c30 CHAR(255),

+ c31 CHAR(255),c32 CHAR(192)

+ ) ENGINE=InnoDB ROW_FORMAT=DYNAMIC DEFAULT CHARSET latin1;

+```

+

+经过测试虽然提示的是 `Row size too large (> 8126)` 但如果全部长度加起来是 8126 建表不成功,最终我试到 8097 是能建表成功的。为什么不是 8126 呢 ?可能是还需要存储一些其他的东西占了一些字节吧,比如隐藏字段什么的。

+

+用存储过程造一些测试数据,把表中的所有列填满

+

+```SQL

+create

+ definer = root@`%` procedure generate_test_data()

+BEGIN

+ DECLARE i INT DEFAULT 0;

+ DECLARE col_value TEXT DEFAULT REPEAT('a', 255);

+ WHILE i < 5 DO

+ INSERT INTO t1 VALUES

+ (

+ col_value, col_value, col_value,

+ col_value, REPEAT('b', 192)

+ );

+ SET i = i + 1;

+ END WHILE;

+END;

+```

+

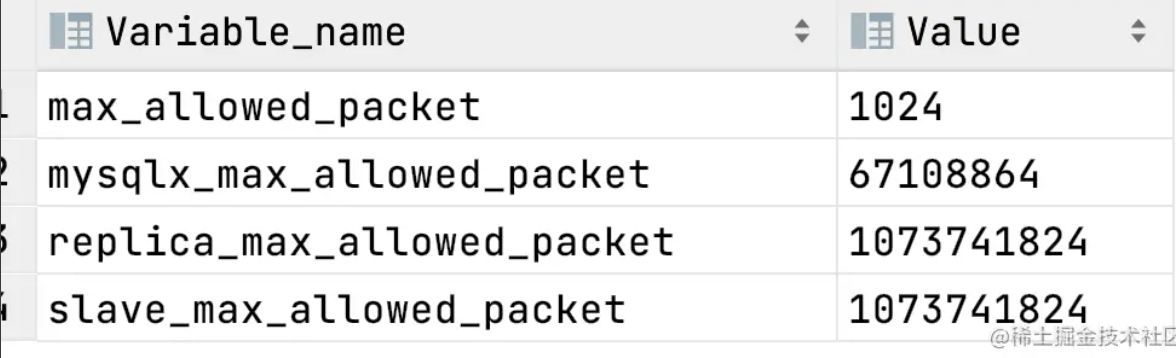

+将 `max_allowed_packet` 设置的小一些,先用 `show VARIABLES like '%max_allowed_packet%';` 看一下当前的大小,我的是 `67108864` 这个单位是字节,等于 64M,然后用 `set global max_allowed_packet =1024` 将它设置成允许的最小值 1024 byte。 设置好后,关闭当前查询窗口再新建一个,然后再查看:

+

+

+

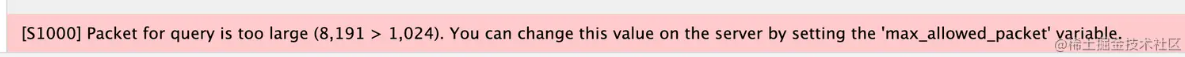

+这时我用 `select * from t1;` 查询表数据时就会报错:

+

+

+

+因为我们一条记录的大小就是 8K 多了,所以肯定超过 1024byte。可见文档的说明是对的, `max_allowed_packet` 确实是可以约束单行记录大小的。

+

+## 答案

+

+文章写到这里,我有点儿写不下去了,一是因为懒,另外一个原因是关于这个问题:“一条 SQL 最多能查询出来多少条记录?” 肯定没有标准答案

+

+目前我们可以知道的是:

+

+- 你的单行记录大小不能超过 `max_allowed_packet`

+- 一个表最多可以创建 1017 列 (InnoDB)

+- 建表时定义列的固定长度不能超过 页的一半(8k,16k...)

+- 建表时定义列的总长度不能超过 65535 个字节

+

+如果这些条件我们都满足了,然后发出了一个没有 where 条件的全表查询 `select *` 那么.....

+

+首先,你我都知道,这种情况不会发生在生产环境的,如果真发生了,一定是你写错了,忘了加条件。因为几乎没有这种要查询出所有数据的需求。如果有,也不能开发,因为这不合理。

+

+我考虑的也就是个理论情况,从理论上讲能查询出多少数据不是一个确定的值,除了前文提到的一些条件外,它肯定与以下几项有直接的关系

+

+- 数据库的可用内存

+- 数据库内部的缓存机制,比如缓存区的大小

+- 数据库的查询超时机制

+- 应用的可用物理内存

+- ......

+

+说到这儿,我确实可以再做个实验验证一下,但因为懒就不做了,大家有兴趣可以自己设定一些条件做个实验试一下,比如在特定内存和特定参数的情况下,到底能查询出多少数据,就能看得出来了。

+

+虽然我没能给出文章开头问题的答案,但通过寻找答案也弄清楚了 MySQL 的一些限制条件,并加以了验证,也算是有所收获了。

+

+

+

+**参考**链接:https://juejin.cn/post/7255478273652834360

diff --git a/docs/zsxq/article/sql-optimize.md b/docs/zsxq/article/sql-optimize.md

new file mode 100644

index 0000000..952c970

--- /dev/null

+++ b/docs/zsxq/article/sql-optimize.md

@@ -0,0 +1,196 @@

+在应用开发的早期,数据量少,开发人员开发功能时更重视功能上的实现,随着生产数据的增长,很多SQL语句开始暴露出性能问题,对生产的影响也越来越大,有时可能这些有问题的SQL就是整个系统性能的瓶颈。

+

+## SQL优化一般步骤

+

+#### 1、通过慢查日志等定位那些执行效率较低的SQL语句

+

+#### 2、explain 分析SQL的执行计划

+

+需要重点关注type、rows、filtered、extra。

+

+type由上至下,效率越来越高

+

+- ALL 全表扫描

+- index 索引全扫描

+- range 索引范围扫描,常用语<,<=,>=,between,in等操作

+- ref 使用非唯一索引扫描或唯一索引前缀扫描,返回单条记录,常出现在关联查询中

+- eq_ref 类似ref,区别在于使用的是唯一索引,使用主键的关联查询

+- const/system 单条记录,系统会把匹配行中的其他列作为常数处理,如主键或唯一索引查询

+- null MySQL不访问任何表或索引,直接返回结果 虽然上至下,效率越来越高,但是根据cost模型,假设有两个索引idx1(a, b, c),idx2(a, c),SQL为"select * from t where a = 1 and b in (1, 2) order by c";如果走idx1,那么是type为range,如果走idx2,那么type是ref;当需要扫描的行数,使用idx2大约是idx1的5倍以上时,会用idx1,否则会用idx2

+

+Extra

+

+- Using filesort:MySQL需要额外的一次传递,以找出如何按排序顺序检索行。通过根据联接类型浏览所有行并为所有匹配WHERE子句的行保存排序关键字和行的指针来完成排序。然后关键字被排序,并按排序顺序检索行。

+- Using temporary:使用了临时表保存中间结果,性能特别差,需要重点优化

+- Using index:表示相应的 select 操作中使用了覆盖索引(Coveing Index),避免访问了表的数据行,效率不错!如果同时出现 using where,意味着无法直接通过索引查找来查询到符合条件的数据。

+- Using index condition:MySQL5.6之后新增的ICP,using index condtion就是使用了ICP(索引下推),在存储引擎层进行数据过滤,而不是在服务层过滤,利用索引现有的数据减少回表的数据。

+

+#### 3、show profile 分析

+

+了解SQL执行的线程的状态及消耗的时间。默认是关闭的,开启语句“set profiling = 1;”

+

+```

+SHOW PROFILES ;

+SHOW PROFILE FOR QUERY #{id};

+```

+

+#### 4、trace

+

+trace分析优化器如何选择执行计划,通过trace文件能够进一步了解为什么优惠券选择A执行计划而不选择B执行计划。

+

+```

+set optimizer_trace="enabled=on";

+set optimizer_trace_max_mem_size=1000000;

+select * from information_schema.optimizer_trace;

+```

+

+#### 5、确定问题并采用相应的措施

+

+- 优化索引

+- 优化SQL语句:修改SQL、IN 查询分段、时间查询分段、基于上一次数据过滤

+- 改用其他实现方式:ES、数仓等

+- 数据碎片处理

+

+## 场景分析

+

+#### 案例1、最左匹配

+

+索引

+

+```

+KEY `idx_shopid_orderno` (`shop_id`,`order_no`)

+```

+

+SQL语句

+

+```

+select * from _t where orderno=''

+```

+

+查询匹配从左往右匹配,要使用order_no走索引,必须查询条件携带shop_id或者索引(`shop_id`,`order_no`)调换前后顺序。

+

+#### 案例2、隐式转换

+

+索引

+

+```

+KEY `idx_mobile` (`mobile`)

+```

+

+SQL语句

+

+```

+select * from _user where mobile=12345678901

+```

+

+隐式转换相当于在索引上做运算,会让索引失效。mobile是字符类型,使用了数字,应该使用字符串匹配,否则MySQL会用到隐式替换,导致索引失效。

+

+#### 案例3、大分页

+

+索引

+

+```

+KEY `idx_a_b_c` (`a`, `b`, `c`)

+```

+

+SQL语句

+

+```

+select * from _t where a = 1 and b = 2 order by c desc limit 10000, 10;

+```

+

+对于大分页的场景,可以优先让产品优化需求,如果没有优化的,有如下两种优化方式, 一种是把上一次的最后一条数据,也即上面的c传过来,然后做“c < xxx”处理,但是这种一般需要改接口协议,并不一定可行。

+

+另一种是采用延迟关联的方式进行处理,减少SQL回表,但是要记得索引需要完全覆盖才有效果,SQL改动如下

+

+```

+select t1.* from _t t1, (select id from _t where a = 1 and b = 2 order by c desc limit 10000, 10) t2 where t1.id = t2.id;

+```

+

+#### 案例4、in + order by

+

+索引

+

+```

+KEY `idx_shopid_status_created` (`shop_id`, `order_status`, `created_at`)

+```

+

+SQL语句

+

+```

+select * from _order where shop_id = 1 and order_status in (1, 2, 3) order by created_at desc limit 10

+```

+

+in查询在MySQL底层是通过n*m的方式去搜索,类似union,但是效率比union高。in查询在进行cost代价计算时(代价 = 元组数 * IO平均值),是通过将in包含的数值,一条条去查询获取元组数的,因此这个计算过程会比较的慢,所以MySQL设置了个临界值(eq_range_index_dive_limit),5.6之后超过这个临界值后该列的cost就不参与计算了。

+

+因此会导致执行计划选择不准确。默认是200,即in条件超过了200个数据,会导致in的代价计算存在问题,可能会导致Mysql选择的索引不准确。

+

+处理方式,可以(`order_status`, `created_at`)互换前后顺序,并且调整SQL为延迟关联。

+

+#### 案例5、范围查询阻断,后续字段不能走索引

+

+索引

+

+```

+KEY `idx_shopid_created_status` (`shop_id`, `created_at`, `order_status`)

+```

+

+SQL语句

+

+```

+select * from _order where shop_id = 1 and created_at > '2021-01-01 00:00:00' and order_status = 10

+```

+

+范围查询还有“IN、between”

+

+#### 案例6、不等于、不包含不能用到索引的快速搜索。(可以用到ICP)

+

+```

+select * from _order where shop_id=1 and order_status not in (1,2)

+select * from _order where shop_id=1 and order_status != 1

+```

+

+在索引上,避免使用NOT、!=、<>、!<、!>、NOT EXISTS、NOT IN、NOT LIKE等

+

+#### 案例7、优化器选择不使用索引的情况

+

+如果要求访问的数据量很小,则优化器还是会选择辅助索引,但是当访问的数据占整个表中数据的蛮大一部分时(一般是20%左右),优化器会选择通过聚集索引来查找数据。

+

+```

+select * from _order where order_status = 1

+```

+

+查询出所有未支付的订单,一般这种订单是很少的,即使建了索引,也没法使用索引。

+

+#### 案例8、复杂查询

+

+```

+select sum(amt) from _t where a = 1 and b in (1, 2, 3) and c > '2020-01-01';

+select * from _t where a = 1 and b in (1, 2, 3) and c > '2020-01-01' limit 10;

+```

+

+如果是统计某些数据,可能改用数仓进行解决;

+

+如果是业务上就有那么复杂的查询,可能就不建议继续走SQL了,而是采用其他的方式进行解决,比如使用ES等进行解决。

+

+#### 案例9、asc和desc混用

+

+```

+select * from _t where a=1 order by b desc, c asc

+```

+

+desc 和asc混用时会导致索引失效

+

+#### 案例10、大数据

+

+对于推送业务的数据存储,可能数据量会很大,如果在方案的选择上,最终选择存储在MySQL上,并且做7天等有效期的保存。

+

+那么需要注意,频繁的清理数据,会照成数据碎片,需要联系DBA进行数据碎片处理。

+

+参考资料:

+

+- 深入浅出MySQL:数据库开发、优化与管理维护(唐汉明 / 翟振兴 / 关宝军 / 王洪权)

+- MySQL技术内幕——InnoDB存储引擎(姜承尧)

+- https://dev.mysql.com/doc/refman/5.7/en/explain-output.html

+- https://dev.mysql.com/doc/refman/5.7/en/cost-model.html

+- https://www.yuque.com/docs/share/3463148b-05e9-40ce-a551-ce93a53a2c66

\ No newline at end of file

diff --git a/docs/zsxq/introduce.md b/docs/zsxq/introduce.md

index e3c4f85..bae53f0 100644

--- a/docs/zsxq/introduce.md

+++ b/docs/zsxq/introduce.md

@@ -181,7 +181,7 @@ APP端页面如下(建议大家**使用APP**,因为APP布局更加美观,

## 怎么进入星球?

-如果你下定决心要加入的话,可以直接扫下面这个二维码。星球定价**158**元,减去**50**元的优惠券,等于说只需要**108**元(**拒绝割韭菜**)的价格就可以加入,服务期一年,**每天不到三毛钱**(0.29元),相比培训班几万块的学费,非常值了,星球提供的服务**远超**门票价格了。

+如果你下定决心要加入的话,可以直接扫下面这个二维码。星球定价**178**元,减去**50**元的优惠券,等于说只需要**128**元(**拒绝割韭菜**)的价格就可以加入,服务期一年,**每天只要三毛钱**(0.35元),相比培训班几万块的学费,非常值了,星球提供的服务**远超**门票价格了。

随着星球内容不断积累,星球定价也会不断**上涨**,所以,想提升自己的小伙伴要趁早加入,**早就是优势**(优惠券只有50个名额,用完就恢复**原价**了)。

diff --git a/docs/zsxq/question/qa-or-java.md b/docs/zsxq/question/qa-or-java.md

new file mode 100644

index 0000000..919a3da

--- /dev/null

+++ b/docs/zsxq/question/qa-or-java.md

@@ -0,0 +1,29 @@

+大彬老师您好

+

+我是参加今年24届秋招的研二学生,本科就读于某211信息安全专业,硕士就读于中国科学院大学 网络空间安全专业,最近开始了秋招,但是在职业规划上十分迷茫,想听听您的建议。

+

+我得求职期望是,在北京找一个高薪的岗位,工作几年后回家乡,找一个国企躺平。

+

+目前我已经排除了算法岗,虽然已经发表了两篇论文,但是研究方向小众,不足以支撑我找到一个算法岗的工作。所以我在以下几个岗位中有所纠结:

+

+1. java开发岗:为了准备开发岗,我跟着教程自己做了一个项目,整体的感受是工程能力很薄弱,并且只有一个学习项目,没有真正的工程项目。

+2. 安全岗位:虽然我本硕都是安全专业,但是研究方向都比较小众,目前互联网需要的安全人才都是攻防方向的,我的竞争力不够。

+3. 测试开发岗:这是我比较有把握的一个求职方向,因为之前有过一段在字节的测开实习经历,加上一直准备java开发,很多八股都是通用的。但是我比较担心测开岗位会不会不太好跳槽到国企,对未来比较担忧。

+

+所以我目前采取的策略是:大厂投测开、中小厂投开发、国企/银行投安全

+

+这令我十分地疲惫。很羞愧,已经7月份了,我竟让自己陷入了如此被动的局面,加上这两年互联网寒冬,我对秋招很担心。实际上我从很早之前就在准备找工作了,科研之余每天刷题、学java基础、学框架、写项目,但是时至今日我还是不够,始终比不上那些硕士阶段一直在参加工程的同学。

+

+以上是我的基本情况

+- 想听听老师对我的现状有没有什么建议

+- 您是否了解测试开发岗位的发展前景,它的薪资和开发是差不多的嘛?

+- 测开有没有可能从互联网顺利转国企

+- 现阶段我是继续补充java基础卷java岗,还是把重点放在测开上呢?

+

+原谅我现在处于焦虑状态因此问题比较多,图片是我的简历方便老师了解我的基本情况,期待老师回复🍓

+谢谢老师~

+

+1、建议投测开,你这个简历在测开岗里面算是比较好的,相反在Java开发岗中算是比较一般的,没有很大的竞争力。有了字节的测开实习,在测开岗里面应该领先一大波人了。

+2、测开发展前景个人觉得也是不错的,随着互联网行业的发展,用户对产品的质量要求也越来越高,软件的性能测试、需求测试等方面的需求目前看是只增不减的。薪资方面,同职级测开跟开发基本持平。

+3、测开有没有可能从互联网顺利转国企?完全可以,没问题

+4、把重点放在测开,不建议同时准备两个岗位,可能顾此失彼

\ No newline at end of file

diff --git a/docs/zsxq/share/completable-future-bug.md b/docs/zsxq/share/completable-future-bug.md

new file mode 100644

index 0000000..6ff1be0

--- /dev/null

+++ b/docs/zsxq/share/completable-future-bug.md

@@ -0,0 +1,250 @@

+---

+sidebar: heading

+title: 记一次生产中使用CompletableFuture遇到的坑

+category: 优质文章

+tag:

+ - 生产问题

+head:

+ - - meta

+ - name: keywords

+ content: CompletableFuture,生产问题,bug,异步调用

+ - - meta

+ - name: description

+ content: 努力打造最优质的Java学习网站

+---

+

+#### 为什么使用CompletableFuture

+

+业务功能描述:有一个功能是需要调用基础平台接口组装我们需要的数据,在这个功能里面我们要调用多次基础平台的接口,我们的入参是一个id,但是这个id是一个集合。我们都是使用RPC调用,一般常规的想法去遍历循环这个idList,但是呢这个id集合里面的数据可能会有500个左右。说多不多,说少也不少,主要是在for循环里面多次去RPC调用是一件特别费时的事情。

+

+我用代码大致描述一下这个需求:

+

+```java

+public List buildBasicInfo(List ids) {

+ List basicInfoList = new ArrayList<>();

+ for (Long id : ids) {

+ getBasicData(basicInfoList, id);

+ }

+ }

+

+ private List getBasicData(List basicInfoList, Long id) {

+ BasicInfo basicInfo = rpcGetBasicInfo(id);

+ return basicInfoList.add(basicInfo);

+ }

+

+ public BasicInfo rpcGetBasicInfo(Long id) {

+ // 第一次RPC 调用

+ rpcInvoking_1()...........

+

+ // 拿到第一次的结果进行第二次RPC 调用

+ rpcInvoking_2()...........

+

+ // 拿到第二次的结果进行第三次RPC 调用、

+ rpcInvoking_3()...........

+

+ // 拿到第三次的结果进行第四次RPC 调用、

+ rpcInvoking_4()...........

+

+ // 组装结果返回

+

+ return BasicInfo;

+ }

+```

+

+是的,这个数据的获取就是这么的扯淡。。。如果使用循环的方式,当ids数据量在500个左右的时候,这个接口返回的时间再8s左右,这是万万不能接受的,那如果ids数据更多呢?所以不能用for循环去遍历ids呀,这样确实是太费时了。

+

+既然远程调用避免不了,那就想办法让这个接口快一点,这时候就想到了多线程去处理,然后就想到使用CompletableFuture异步调用:

+

+#### CompletableFuture多线程异步调用

+

+```java

+List basicInfoList = new ArrayList<>();

+ CompletableFuture> future = CompletableFuture.supplyAsync(() -> {

+ ids.forEach(id -> {

+ getBasicData(basicInfoList, id);

+ });

+ return basicInfoList;

+ });

+ try {

+ List basicInfos = future.get();

+ } catch (Exception e) {

+ e.printStackTrace();

+ }

+```

+

+> 这里补充一点:**CompletableFuture是否使用默认线程池的依据,和机器的CPU核心数有关。当CPU核心数减1大于1时,才会使用默认的线程池(ForkJoinPool),否则将会为每个CompletableFuture的任务创建一个新线程去执行**。即,CompletableFuture的默认线程池,只有在**双核以上的机器**内才会使用。在双核及以下的机器中,会为每个任务创建一个新线程,**等于没有使用线程池,且有资源耗尽的风险**。

+

+默认线程池,**池内的核心线程数,也为机器核心数减1**,这里我们的机器是8核的,也就是会创建7个线程去执行。

+

+上面这种方式虽然实现了多线程异步执行,但是如果ids集合很多话,依然会很慢,因为`future.get();`也是堵塞的,必须等待所有的线程执行完成才能返回结果。

+

+#### 改进CompletableFuture多线程异步调用

+

+想让速度更快一点,就想到了把ids进行分隔:

+

+```ini

+ini复制代码 int pageSize = ids.size() > 8 ? ids.size() >> 3 : 1;

+ List> partitionAssetsIdList = Lists.partition(ids, pageSize);

+```

+

+因为我们CPU核数为8核,所有当ids的大小小于8时,就开启8个线程,每个线程分一个。这里的>>3(右移运算)相当于ids的大小除以2的3次方也就是除以8;右移运算符相比除效率会高。毕竟现在是在优化提升速度。

+

+如果这里的ids的大小是500个,就是开启9个线程,其中8个线程是处理62个数据,另一个线程处理4个数据,因为有余数会另开一个线程处理。具体代码如下:

+

+```java

+int pageSize = ids.size() > 8 ? ids.size() >> 3 : 1;

+ List> partitionIdList = Lists.partition(ids, pageSize);

+ List> futures = new ArrayList<>();

+ //如果ids为500,这里会分隔成9份,也就是partitionIdList.size()=9;遍历9次,也相当于创建了9个CompletableFuture对象,前8个CompletableFuture对象处理62个数据。第9个处理4个数据。

+ partitionIdList.forEach(partitionIds -> {

+ List basicInfoList = new ArrayList<>();

+ CompletableFuture> future = CompletableFuture.supplyAsync(() -> {

+ partitionIds.forEach(id -> {

+ getBasicData(basicInfoList, id);

+ });

+ return basicInfoList;

+ });

+ futures.add(future);

+ });

+ // 把所有线程执行的结果进行汇总

+ List basicInfoResult = new ArrayList<>();

+ for (CompletableFuture future : futures) {

+ try {

+ basicInfoResult.addAll((List)future.get());

+ } catch (Exception e) {

+ e.printStackTrace();

+ }

+ }

+```

+

+如果ids的大小等于500,就会被分隔成9份,创建9个CompletableFuture对象,前8个CompletableFuture对象处理62个数据(id),第9个处理4个数据(id)。这62个数据又会被分成7个线程去执行(CPU核数减1个线程)。经过分隔之后充分利用了CPU。速度也从8s减到1-2s。得到了总监和同事的夸赞,同时也被写到正向事件中;哈哈哈哈。

+

+#### 在生产环境中遇到的坑

+

+上面说了那么多还没有说到坑在哪里,下面我们就说说坑在哪里?

+

+本地和测试都没有啥问题,那就找个时间上生产呗,升级到生产环境,发现这个接口堵塞了,超时了。。。

+

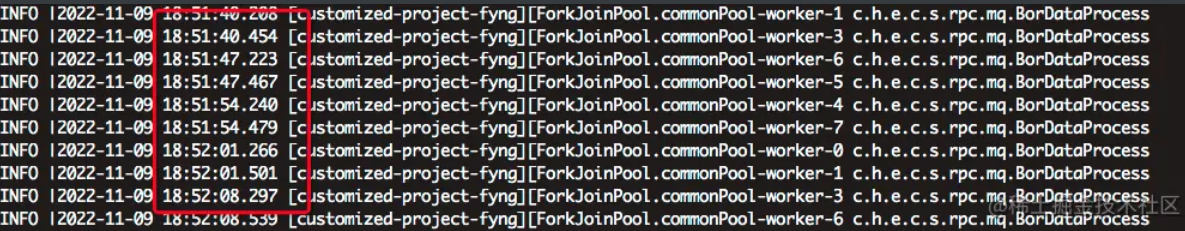

+

+

+刚被记录到正向事件,可不想在被记录个负向时间。感觉去看日志。

+

+发现日志就执行了将ids进行分隔,后面循环去创建CompletableFuture对象之后的代码都没有在执行了。然后我第一感觉测试是future.get()获取结果的时候堵塞了,所以一直没有结果返回。

+

+#### 排查问题过程

+

+我们要解决这个问题就要看看问题出现在哪里?

+

+当执行到这个接口时候我们第一时间看了看CPU的使用率:

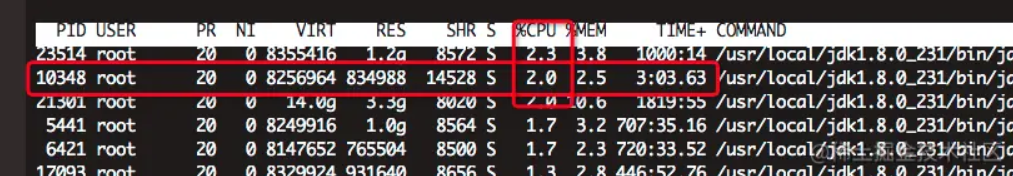

+

+

+

+这是访问接口之前:

+

+

+

+发现执行这个接口时PID为10348的这个进程的CPU突然的高了起来。

+

+紧接着使用`jps -l` :打印出我们服务进程的PID

+

+

+

+PID为10348正式我们现在执行这个服务。

+

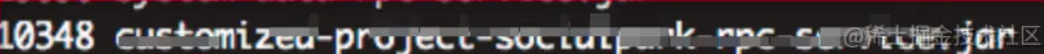

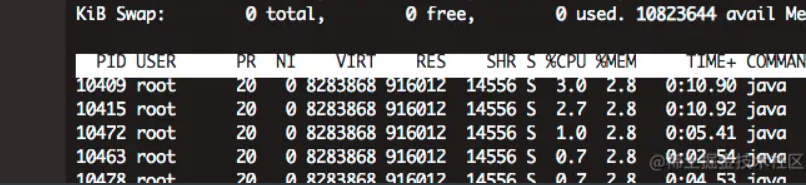

+接着我就详细的看一下这个PID为10348的进程下哪里线程占用的高:

+

+发现这几个占用的相对高一点:

+

+

+

+

+

+紧接着使用jstack命令生成java虚拟机当前时刻的线程快照,生成线程快照的主要目的是定位线程出现长时间停顿的原因,如线程间死锁、死循环、请求外部资源导致的长时间等待等。 线程出现停顿的时候通过jstack来查看各个线程的调用堆栈,就可以知道没有响应的线程到底在后台做什么事情,或者等待什么资源

+

+`jstack -l 10348 >/tmp/10348.log`,使用此命令将PID为10348的进程下所有线程快照输出到log文件中。

+

+同时我们将线程比较的PID转换成16进制:printf "%x\n" 10411

+

+

+

+我们将转换成16进制的数值28ab,28a9在10348.log中搜索一下:

+

+

+

+

+

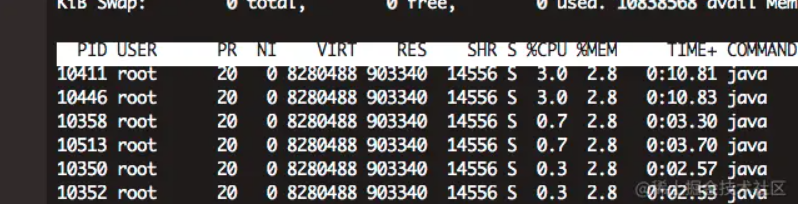

+看到线程的快照发现这不是本次修改的接口呀。看到日志4处但是也是用了CompletableFuture。找到对应4处的代码发现这是监听mq消息,然后异步去执行,代码类型这样:

+

+

+

+经过查看日志发现这个mq消息处理很频繁,每秒都会有很多的数据上来。

+

+

+

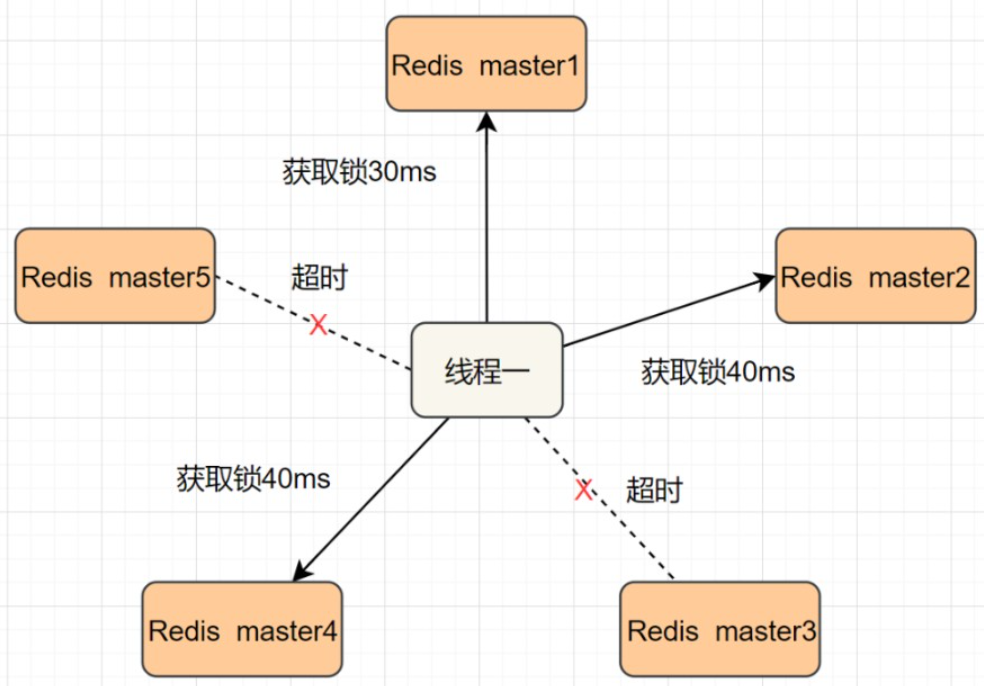

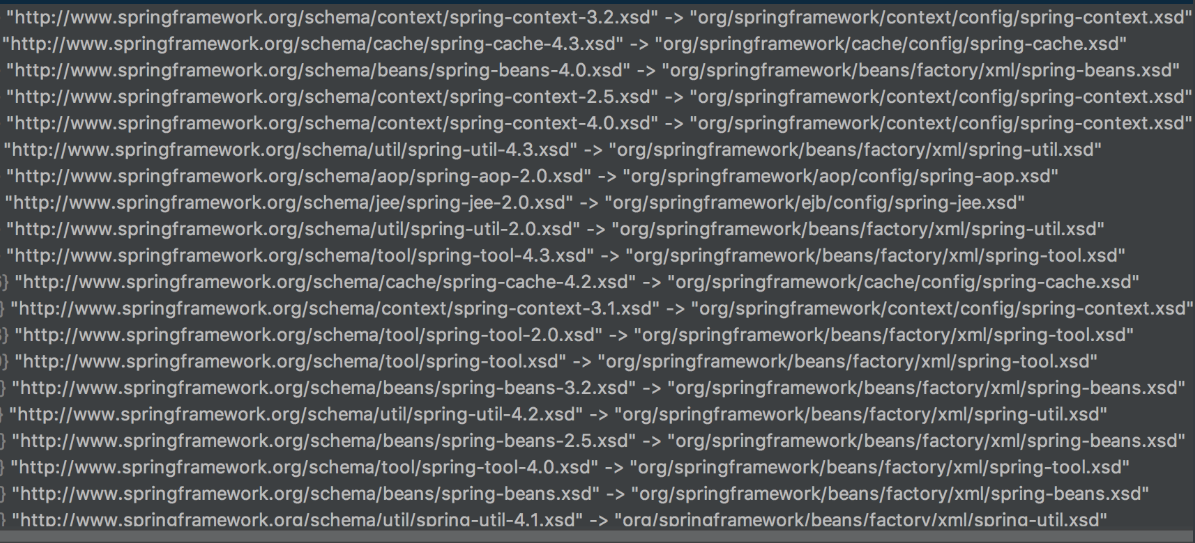

+我们知道CompletableFuture默认是使用ForkJoinPool作为线程池。难道mq使用ForkJoinPool和我当前接口使用的都是同一个线程池中的线程?难道是共用的吗?

+

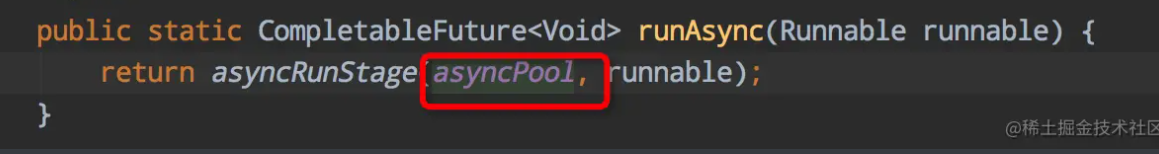

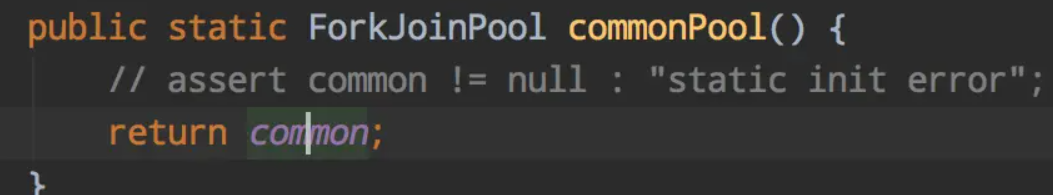

+MQ监听使用的线程池:

+

+

+

+我们当前接口使用的线程池:

+

+

+

+

+

+

+

+

+

+它们使用的都是ForkJoinPool.commonPool()公共线程池中的线程!

+

+看到这个结论就很好理解了,我们目前修改的接口使用的线程池中的线程全部都被MQ消息处理占用,我们修改优化的接口得不到资源,所以一直处于等待。

+

+同时我们在线程快照10348.log日志中也看到我们优化的接口对应的线程处于WAITING状态!

+

+

+

+这里`- parking to wait for <0x00000000fe2081d8>`肯定也是MQ消费线程中的某一个。由于MQ消费消息比较多,每秒都会监听到大量的数据,线程的快照日志收集不全。所以在10348.log中没有找到,这不影响我们修改bug。问题的原因已经找到了。

+

+#### 解决问题

+

+上面我们知道两边使用的都是公共静态线程池,我们只要让他们各用各的就行了:自定义一个线程池:`ForkJoinPool pool = new ForkJoinPool();`

+

+```java

+int pageSize = ids.size() > 8 ? ids.size() >> 3 : 1;

+ List> partitionIdList = Lists.partition(ids, pageSize);

+ List> futures = new ArrayList<>();

+ partitionIdList.forEach(partitionIds -> {

+ List basicInfoList = new ArrayList<>();

+ //重新创建一个ForkJoinPool对象就可以了

+ ForkJoinPool pool = new ForkJoinPool();

+ CompletableFuture> future = CompletableFuture.supplyAsync(() -> {

+ partitionIds.forEach(id -> {

+ getMonitoringCoverage(basicInfoList, id);

+ });

+ return basicInfoList;

+ //在这里使用

+ },pool);

+ futures.add(future);

+ });

+ // 把所有线程执行的结果进行汇总

+ List basicInfoResult = new ArrayList<>();

+ for (CompletableFuture future : futures) {

+ try {

+ basicInfoResult.addAll((List)future.get());

+ } catch (Exception e) {

+ e.printStackTrace();

+ }

+ }

+```

+

+这样他们就各自用各自的线程池中的线程了。不会存在资源的等待现场了。

+

+#### 总结:

+

+之所以测试环境和开发环境没有出现这样的问题是因为这两个环境mq没有监听到消息。大量的消息都在生产环境中才会出现。由于测试环境的数据量达不到生产环境的数据量,所以有些问题在测试环境体验不出来。

+

+

+

+> 原文链接:https://juejin.cn/post/7165704556540755982

\ No newline at end of file

diff --git a/docs/zsxq/share/oom.md b/docs/zsxq/share/oom.md

new file mode 100644

index 0000000..d378bbf

--- /dev/null

+++ b/docs/zsxq/share/oom.md

@@ -0,0 +1,13 @@

+记录一次内存泄露排查的过程。

+

+最近经常告警有空指针异常报出,于是找到运维查日志定位到具体是哪一行代码抛出的空指针异常,发现是在解析cookie的一个方法内,调用`HttpServletRequest.getServerName()`获取不到抛出的NPE,这个获取服务名获取不到,平时都没有出现过的问题,最近也没有发版,那初步怀疑应该前端或者传输过程有问题导致获取不到参数。

+

+后续找了运维查了ng的日志,确实存在状态码为**499**的错误码,查了一下这个是**客户端主动关闭请求或者客户端网络断掉时**报的错误码,那也就是前端断开了请求。

+

+继续排查为啥前端会中断请求的原因,问了前端同学说是超时时间设置了10秒,又看了日志,确实是有处理时间超过10秒的,那问题大概定位到了。

+

+接下来就是分析处理时长为什么会那么长,看了报错的时候请求量并没有很大,后续让运维查了机器有几台cpu用量处于30%左右,明显高于另外几台3%,而且499错误的集中在cpu用量高的几台,怀疑是否是内存问题导致,让运维跑了`jstat -gcutil`看了一下,确实存在full GC问题,又跑了`jmap -dump`下了dump文件,定位到是ip限流的方法,有一个清除Map的方法在多线程并发情况下没有生效,导致内存泄露。

+

+知道问题后反推感觉就一切的疑问有了结果,ng报499是前置超时,超时是服务频繁full gc导致stw,无法处理请求导致耗时增加,ng探活接口在机器stw期间无法响应产生了error.log,而有几台机器cpu不高是因为之前重启过所以释放掉了内存没有触发full gc。

+

+后续处理是改进了ip限流的方法,测试环境复现问题和改动限流方法,通过guaua的LoadingCache监听器的方式过期自动处理,这次问题嵌套问题比较多,由于上报量低,ng侧报了499没有纳入监控范围,而且机器由于重启没有快速发现问题,后续改进是代码侧能复用规范代码最好复用,不要重复造轮子。

\ No newline at end of file

diff --git a/docs/zsxq/share/slow-query.md b/docs/zsxq/share/slow-query.md

new file mode 100644

index 0000000..4d3ab7f

--- /dev/null

+++ b/docs/zsxq/share/slow-query.md

@@ -0,0 +1,62 @@

+**最近的生产慢查询问题分析与总结**

+

+**1.问题描述**

+

+前几天凌晨出现大量慢查询告警,经DBA定位为某个子系统涉及的一条查询语句出现慢查询,引起数据库服务器的cpu使用率突增,触发大量告警,查看生产执行计划发现慢查询为索引跳变引起;具体出现问题的sql语句如下:

+

+```

+select * from ( select t.goods id as cardid,p.validate as validate, p.create timecreateTime

+ p.repay_coupon type as repaycoupontype,p.require anount as requireAmount, p.goods tag as goodsTag,

+ p.deduction anount as deductionAmount, p.repay coupon remark as repay(ouponkemark,

+ p.sale_point as salepoint from user_prizes p join trans_order t

+ on p.user_id = t.user_id and p.order_no = t.order_no

+ where p.user_id = #{user_id} and p.wmkt_type = '6' and t.status = 's' and p.equity_code_status = 'N'

+ and p.create_time >= #{beginDate}

+ order by p.create_time dese limit 1000) as cc group by cc.cardid:

+```

+

+ 该sql为查询三个月内满足条件的还款代金券列表,其中user_prizes表和trans_order表都是大表,数据量达到亿级别,user_prizes表有如下几个索引:

+

+```sql

+PRIMARY KEY ('merchant_order_no ,partition key ) USING BTREE,

+KEY “thirdOrderNo" ("third_order_no","app_id"),

+KEY "createTime" ("create_time"),

+KEY "userId" ("user_id"),

+KEY "time_activity" ("create_time', 'activity_name')

+```

+

+ 正常情况下该语句走的userId索引,当天零点后该sql语句出现索引跳变,走了createTime索引,导致出现慢查询。

+

+**2.问题处理方式**

+

+ 生产定位到问题后,因该sql的查询场景为前端触发,当天为账单日,请求量大,DBA通过kill脚本临时进行处理,同时准备增加强制索引优化的紧急版本,通过加上强制索引force index(userId)处理索引跳变,DBA也同步在备库删除createTime索引观察效果,准备进行主备切换尝试解决,但在备库执行索引删除后查看执行计划发现又走了time_activity索引,最后通过发布增加强制索引优化的紧急版本进行解决。

+

+**3.问题分析**

+

+MySQL优化器选择索引的目的是找到一个最优的执行方案,并用最小的代价去执行语句,扫描行数是影响执行代价的重要因素,扫描行数越少,意味着访问磁盘数据次数越少,消耗的cpu资源越少,除此之外,优化器还会结合是否使用临时表,以及是否排序等因素综合判断。

+

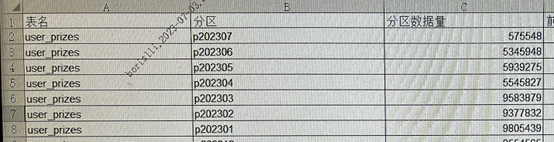

+出现索引跳变的这个sql有order by create_time,且create_time为索引,user_prizes表是按月分区的,数据总量为1亿400多万,通过统计生产数据量分布情况发现,近几个月的分区数据量如下:

+

+

+

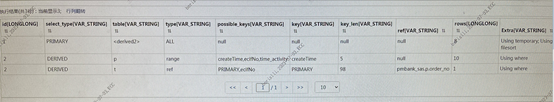

+ 该sql7月1日零点后查询的是4月1日之后的数据,3月份分区的数据量为958万多,4月之后分区数量都保持在500多万。4月份之后分区数据减少了,可能是这个原因导致优化器认为走时间索引createTime的区分度更高,同时还可以避免排序,因而选择了时间索引。查看索引跳变后的执行计划如下:

+

+

+

+走createTime索引虽然可以避免排序,但从执行计划的type=range可看出为索引范围的扫描,根据索引createTime扫描记录,通过索引叶子节点的主键值回表查找完整记录,然后判断记录中满足sql过滤条件的数据,再将结果进行返回,而该语句为查找满足条件的1000条数据,正常情况下一个user_id满足条件的数据量不会超过1000条,要找到所有满足条件的记录就是索引范围的扫描加回表查询,加上查询范围内的数据量大,因此走createTime索引就会非常慢。

+

+**4.总结**

+

+由于mysql在真正执行语句的时候,并不能准确的知道满足这个条件的记录有多少,只能通过统计信息来估算记录,而优化器并不是非常智能的,就有可能发生索引跳变的情况,这种情况很难在测试的时候复现出来,生产也可能是突然出现,所以我们只能在使用上尽量的去降低索引发生跳变的可能性,尽量避免出现该问题。我们可以在创建索引和使用sql的时候通过以下几个点进行检视。

+

+(1) 索引的创建

+

+ 创建索引的时候要注意尽量避免创建单列的时间字段(createTime、updateTime)索引,避免留坑,因为很多场景都可能用到时间字段进行排序,有排序的情况若排序字段又是单列索引字段,就可能引起索引跳变,如果需要使用时间字段作为索引时,尽量使用联合索引,且时间字段放在后面;高效的索引应遵循高区分度字段+避免排序的原则。

+

+ 创建索引的时候也要尽量避免索引重复,且一张表的索引个数也要控制好,索引过多也会影响增删改的效率。

+

+(2) sql的检视

+

+ 检视历史和新增的sql是否有order by,且order by的第一个字段是否有单列索引,这种存在索引跳变的风险,需要具体分析后进行优化;

+

+ 写sql语句的时候,尽可能简单化,像union、排序等尽量少在sql中实现,减少sql慢查询的风险。

\ No newline at end of file

diff --git a/docs/zsxq/share/spring-upgrade-copy-problem.md b/docs/zsxq/share/spring-upgrade-copy-problem.md

new file mode 100644

index 0000000..07b2f5c

--- /dev/null

+++ b/docs/zsxq/share/spring-upgrade-copy-problem.md

@@ -0,0 +1,146 @@

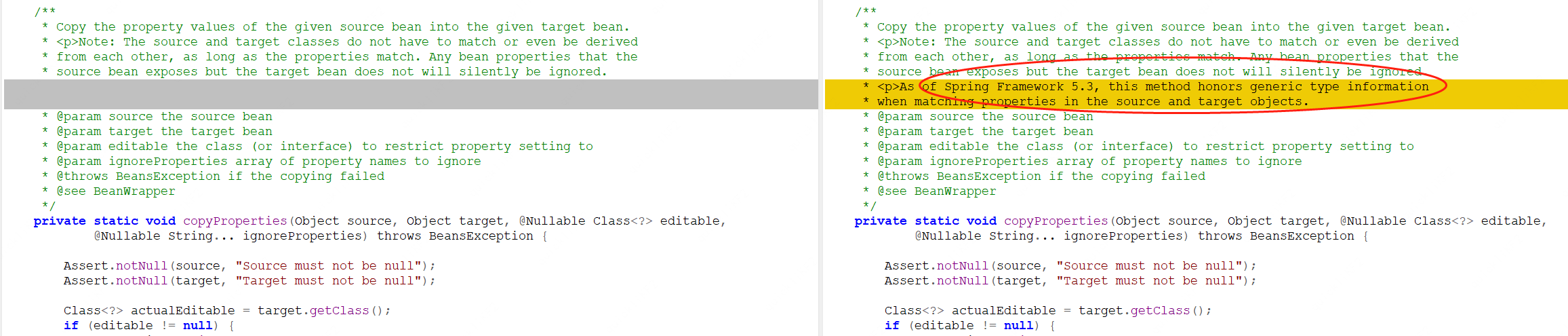

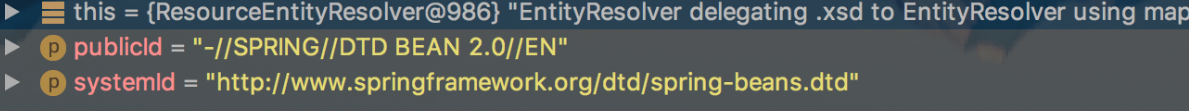

+最近内部组件升级到spring5.3.x的时候对象拷贝内容不全,定位分析总结如下(可直接拉到最后看结论和解决办法):

+

+**1.现象:**

+

+源对象的类里有个内部类的成员变量,是List类型,,List的元素类型是自己的内部静态类

+

+目标对象的类里有个内部类的成员变量,也是List类型,List的元素类型是自己的内部静态类

+

+源对象的代码示例如下(省略了get set方法):

+

+```java

+/**

+ * 源对象

+ * @author dabin

+ *

+ */

+public class Rsp_07300240_01 {

+ private int totals;

+ private List contracts;//合同列表

+ static public class Contract{

+ private String constractId;//合同编号

+ private String constractName;//合同名称

+ private String type;//合同类型

+ private String fileId;//fps文件id

+ private String fileHash;//fps文件hash

+ @Override

+ public String toString() {

+ StringBuilder builder = new StringBuilder();

+ builder.append("Rsp_07300240_01.Contract [constractId=");

+ builder.append(constractId);

+ builder.append(", constractName=");

+ builder.append(constractName);

+ builder.append(", type=");

+ builder.append(type);

+ builder.append(", fileId=");

+ builder.append(fileId);

+ builder.append(", fileHash=");

+ builder.append(fileHash);

+ builder.append("]");

+ return builder.toString();

+ }

+ }

+}

+```

+

+目标对象的代码示例如下(省略了get set方法):

+

+```java

+public class Rsp_04301099_01 {

+ @RmbField(seq = 1, title = "总条数")

+ private int totals;

+ @RmbField(seq = 2, title = "合同列表")

+ // 这里是自己的内部类

+ private List contracts;// 合同列表

+ static public class Contract{

+ private String constractId;//合同编号

+ private String constractName;//合同名称

+ private String type;//合同类型

+ private String fileId;//fps文件id

+ private String fileHash;//fps文件hash

+@Override

+ public String toString() {

+ StringBuilder builder = new StringBuilder();

+ builder.append("Rsp_04301099_01.Contract [constractId=");

+ builder.append(constractId);

+ builder.append(", constractName=");

+ builder.append(constractName);

+ builder.append(", type=");

+ builder.append(type);

+ builder.append(", fileId=");

+ builder.append(fileId);

+ builder.append(", fileHash=");

+ builder.append(fileHash);

+ builder.append("]");

+ return builder.toString();

+ }

+ }

+}

+```

+

+单元测试验证代码如下:

+

+```java

+public class SpringBeanCopyUtilTest {

+ @Test

+ public void testBeanCopy() {

+ Rsp_07300240_01 orgResp = new Rsp_07300240_01();

+ orgResp.setTotals(100);

+ List contracts = new ArrayList<>();

+ Rsp_07300240_01.Contract cc = new Rsp_07300240_01.Contract();

+ cc.setConstractId("aaa");

+ contracts.add(cc);

+ orgResp.setContracts(contracts);

+ Rsp_04301099_01 destResp = new Rsp_04301099_01();

+ System.out.println("源对象的值:" + orgResp);

+ System.out.println("复制前的值:" + destResp);

+ BeanUtils.copyProperties(orgResp, destResp);

+ System.out.println("Spring版本" + BeanUtils.class.getPackage().getImplementationVersion());

+ System.out.println("复制后的值:" + destResp);

+// if (destResp.getContracts() != null && destResp.getContracts().size() > 0) {

+// System.out.println("复制后的list成员类型是:" + destResp.getContracts().get(0));

+// }

+ }

+}

+```

+

+分别依赖spring 5.2.4和5.3.9版本,运行结果如下:

+

+```java

+源对象的值:Rsp_07300240_01 [totals=100, contracts=[Rsp_07300240_01.Contract [constractId=aaa, constractName=null, type=null, fileId=null, fileHash=null]]]

+复制前的值:Rsp_04301099_01 [totals=0, contracts=null]

+

+Spring版本5.2.4.RELEASE

+复制后的值:Rsp_04301099_01 [totals=100, contracts=[Rsp_07300240_01.Contract [constractId=aaa, constractName=null, type=null, fileId=null, fileHash=null]]]

+

+Spring版本5.3.9

+复制后的值:Rsp_04301099_01 [totals=100, contracts=null]

+```

+

+**2.分析**

+

+可以看到在依赖spring 5.3.x的时候,contracts的值是没有复制过来的。

+

+但是也可以看到在依赖spring 5.2.x的时候,contracts的值是直接设置的引用,List的成员变量类型是 Rsp_07300240_01.Contract,Rsp_04301099_01.Contract。

+

+这个其实也是有问题的。但是为啥在业务逻辑中没有暴雷呢?

+

+经核实,业务代码中,是在返回应答对象之前执行的 org.springframework.beans.BeanUtils.copyProperties 操作,执行完之后,立即返回了对象,然后内部使用的框架,直接使用jackson进行系列化,此时类型信息已经擦除,不涉及类型转换,所以正常生成了json字符串。

+

+而上面示例中被注释的代码里,如果启用的话,测试的时候就会立即报错,提示类型转换异常。

+

+对比代码可以发现:

+

+

+

+经过一番搜索,原来是在2019年的时候就有人向Spring社区提了bug,然后spring增加了泛型判断逻辑,杜绝了错误的赋值,在5.3.x中修复了这个bug。

+

+https://github.com/spring-projects/spring-framework/issues/24187

+

+由于平时大部分使用场景都是执行BeanUtils.copyProperties后立即取出里面的对象进行操作,这种情况下,就会提前触发bug,然后调用方自己想办法规避掉spring bug。

+

+恰好内部使用的xx框架在BeanUtils.copyProperties之后没有显式的操作成员对象,因此一直没有触发bug,直到升级到spring 5.3.x时才暴雷。

+

+**3.解决办法:**

+

+先回退版本,然后检视所有调用BeanUtils.copyProperties的地方,针对触发bug的这种场景优化代码,比如把两个内部静态class合并使用一个公共的class。

\ No newline at end of file

diff --git a/package-lock.json b/package-lock.json

index 45fa65f..57fab08 100644

--- a/package-lock.json

+++ b/package-lock.json

@@ -2351,6 +2351,13 @@

"integrity": "sha512-I4BD3L+6AWiUobfxZ49DlU43gtI+FTHSv9pE2Zekg6KjMpre4ByusaljW3vYSLJrvQ1ck1hUaeVu8HVlY3vzHg==",

"dev": true

},

+ "node_modules/@types/prop-types": {

+ "version": "15.7.5",

+ "resolved": "https://registry.npmmirror.com/@types/prop-types/-/prop-types-15.7.5.tgz",

+ "integrity": "sha512-JCB8C6SnDoQf0cNycqd/35A7MjcnK+ZTqE7judS6o7utxUCg6imJg3QK2qzHKszlTjcj2cn+NwMB2i96ubpj7w==",