diff --git a/docs/.vuepress/config.ts b/docs/.vuepress/config.ts

index 8fa92a8..63869db 100644

--- a/docs/.vuepress/config.ts

+++ b/docs/.vuepress/config.ts

@@ -8,7 +8,7 @@ import { gitPlugin } from '@vuepress/plugin-git'

export default defineUserConfig({

lang: "zh-CN",

- title: "Java学习&面试指南-程序员大彬",

+ title: "大彬",

description: "Java学习、面试指南,涵盖大部分 Java 程序员所需要掌握的核心知识",

base: "/",

dest: './public',

diff --git a/docs/.vuepress/navbar.ts b/docs/.vuepress/navbar.ts

index 6713299..d2fcdc3 100644

--- a/docs/.vuepress/navbar.ts

+++ b/docs/.vuepress/navbar.ts

@@ -215,6 +215,54 @@ export default navbar([

},

]

},

+

+ {

+ text: "源码解读",

+ icon: "source",

+ children: [

+ {

+ text: "Spring",

+ children: [

+ {text: "整体架构", link: "/source/spring/1-architect.md", icon: "book"},

+ {text: "IOC 容器基本实现", link: "/source/spring/2-ioc-overview", icon: "book"},

+ {text: "IOC默认标签解析(上)", link: "/source/spring/3-ioc-tag-parse-1", icon: "book"},

+ {text: "IOC默认标签解析(下)", link: "/source/spring/4-ioc-tag-parse-2", icon: "book"},

+ {text: "IOC之自定义标签解析", link: "/source/spring/5-ioc-tag-custom.md", icon: "book"},

+ {text: "IOC-开启 bean 的加载", link: "/source/spring/6-bean-load", icon: "book"},

+ {text: "IOC之bean创建", link: "/source/spring/7-bean-build", icon: "book"},

+ {text: "IOC属性填充", link: "/source/spring/8-ioc-attribute-fill", icon: "book"},

+ {text: "IOC之循环依赖处理", link: "/source/spring/9-ioc-circular-dependency", icon: "book"},

+ {text: "IOC之bean 的初始化", link: "/source/spring/10-bean-initial", icon: "book"},

+ {text: "ApplicationContext容器refresh过程", link: "/source/spring/11-application-refresh", icon: "book"},

+ {text: "AOP的使用及AOP自定义标签", link: "/source/spring/12-aop-custom-tag", icon: "book"},

+ {text: "创建AOP代理之获取增强器", link: "/source/spring/13-aop-proxy-advisor", icon: "book"},

+ {text: "AOP代理的生成", link: "/source/spring/14-aop-proxy-create", icon: "book"},

+ {text: "AOP目标方法和增强方法的执行", link: "/source/spring/15-aop-advice-create", icon: "book"},

+ {text: "@Transactional注解的声明式事物介绍", link: "/source/spring/16-transactional", icon: "book"},

+ {text: "Spring事务是怎么通过AOP实现的?", link: "/source/spring/17-spring-transaction-aop", icon: "book"},

+ {text: "事务增强器", link: "/source/spring/18-transaction-advice", icon: "book"},

+ {text: "事务的回滚和提交", link: "/source/spring/19-transaction-rollback-commit", icon: "book"},

+ ]

+ },

+ {

+ text: "SpringMVC",

+ children: [

+ {text: "文件上传和拦截器", link: "/source/spring-mvc/1-overview", icon: "book"},

+ {text: "导读篇", link: "/source/spring-mvc/2-guide", icon: "book"},

+ {text: "场景分析", link: "/source/spring-mvc/3-scene", icon: "book"},

+ {text: "事务的回滚和提交", link: "/source/spring-mvc/4-fileupload-interceptor", icon: "book"},

+ ]

+ },

+ {

+ text: "MyBatis(更新中)",

+ children: [

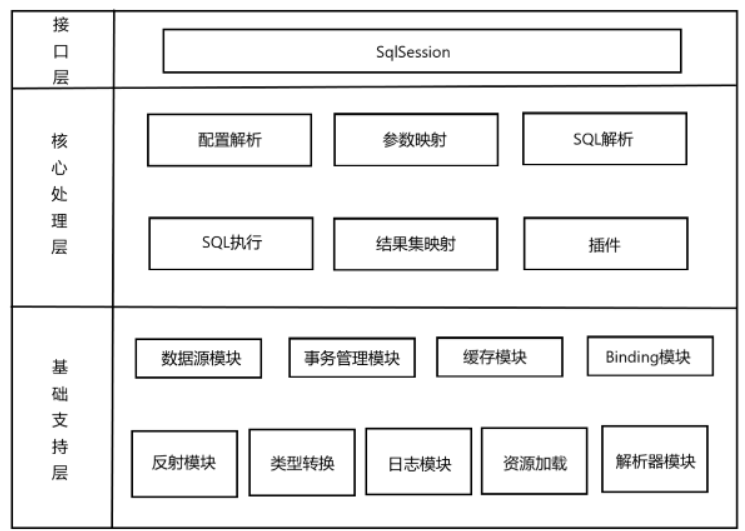

+ {text: "整体架构", link: "/source/mybatis/1-overview", icon: "book"},

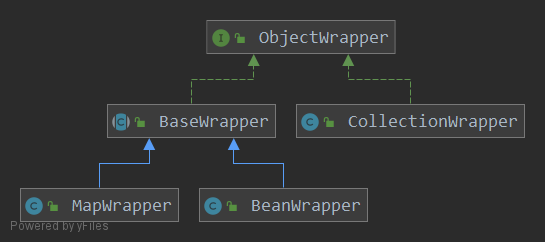

+ {text: "反射模块", link: "/source/mybatis/2-reflect", icon: "book"},

+ ]

+ },

+

+ ]

+ },

//{

// text: "场景题",

// icon: "design",

diff --git a/docs/README.md b/docs/README.md

index f38c835..9f8ba39 100644

--- a/docs/README.md

+++ b/docs/README.md

@@ -47,10 +47,6 @@ projects:

[ ](https://www.zhihu.com/people/dai-shu-bin-13)

[

](https://www.zhihu.com/people/dai-shu-bin-13)

[ ](https://github.com/Tyson0314/java-books)

-## 秋招提前批信息汇总

-

-[秋招提前批及正式批信息汇总(含内推)](https://docs.qq.com/sheet/DYW9ObnpobXNRTXpq?tab=BB08J2)

-

## 面试手册电子版

本网站所有内容已经汇总成**PDF电子版**,**PDF电子版**在我的[**学习圈**](zsxq/introduce.md)可以获取~

diff --git a/docs/advance/distributed/2-distributed-lock.md b/docs/advance/distributed/2-distributed-lock.md

index a269865..1016022 100644

--- a/docs/advance/distributed/2-distributed-lock.md

+++ b/docs/advance/distributed/2-distributed-lock.md

@@ -181,6 +181,8 @@ public class RedisTest {

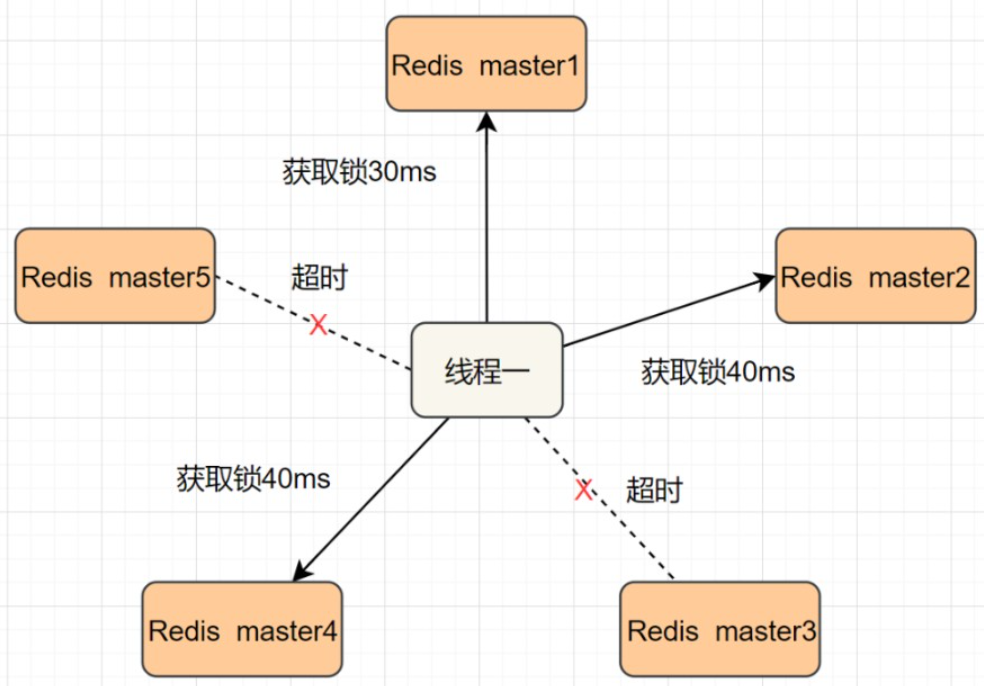

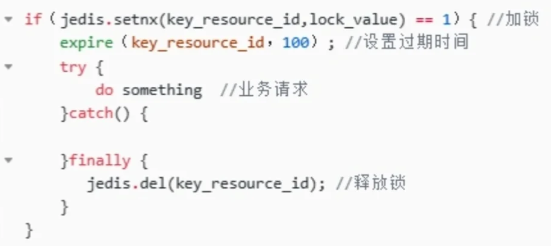

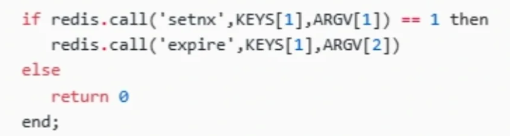

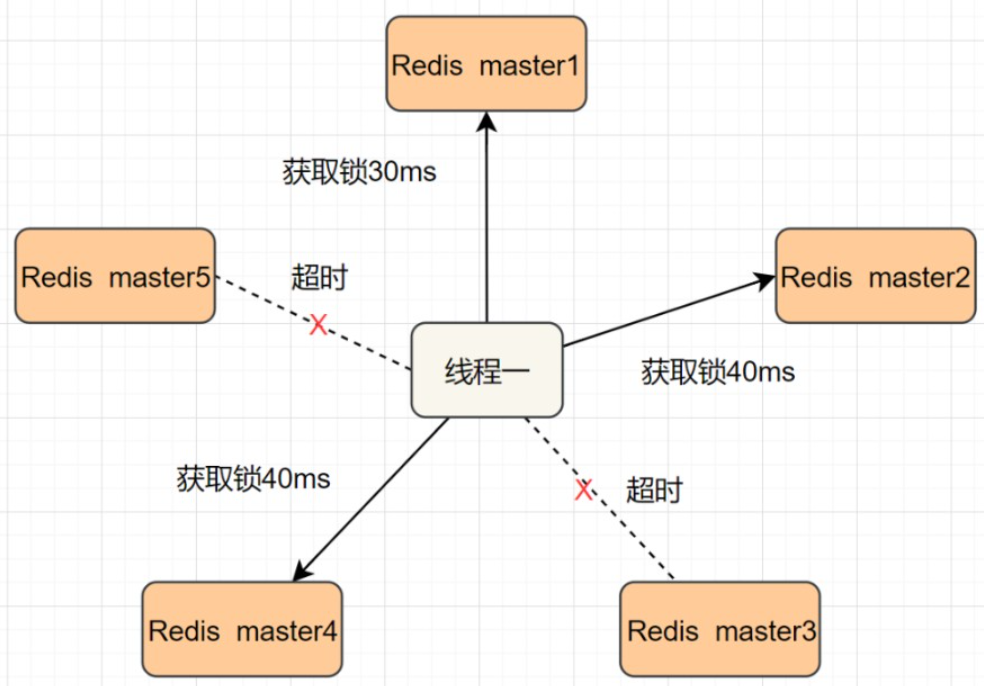

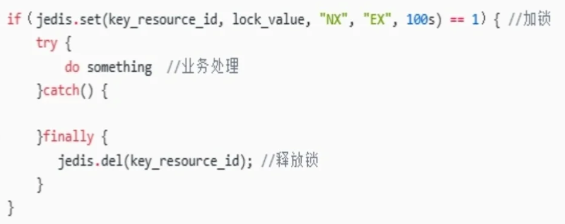

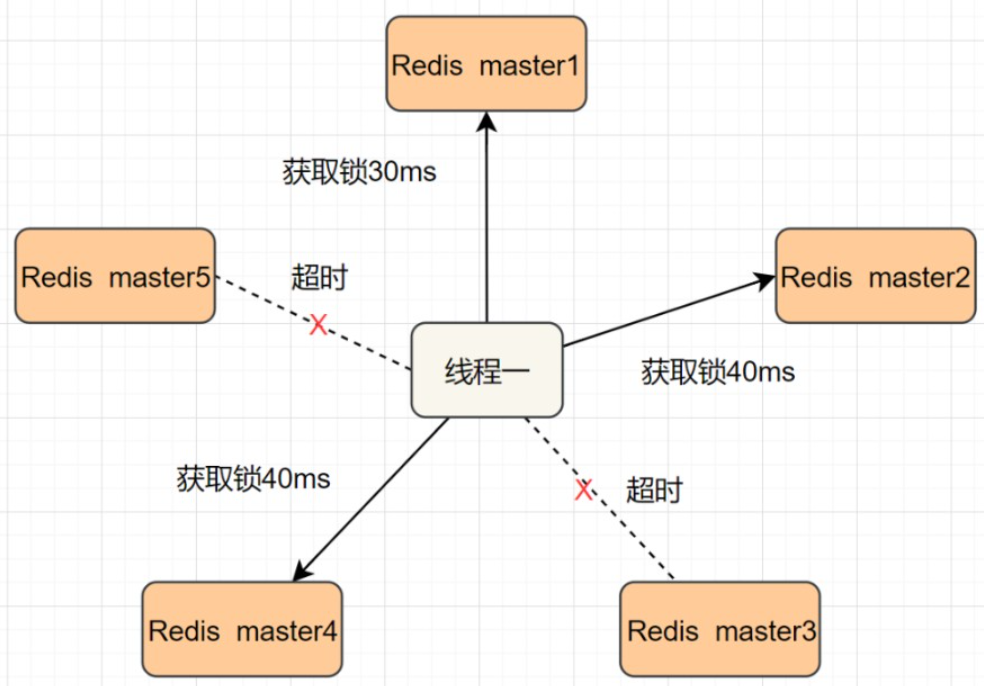

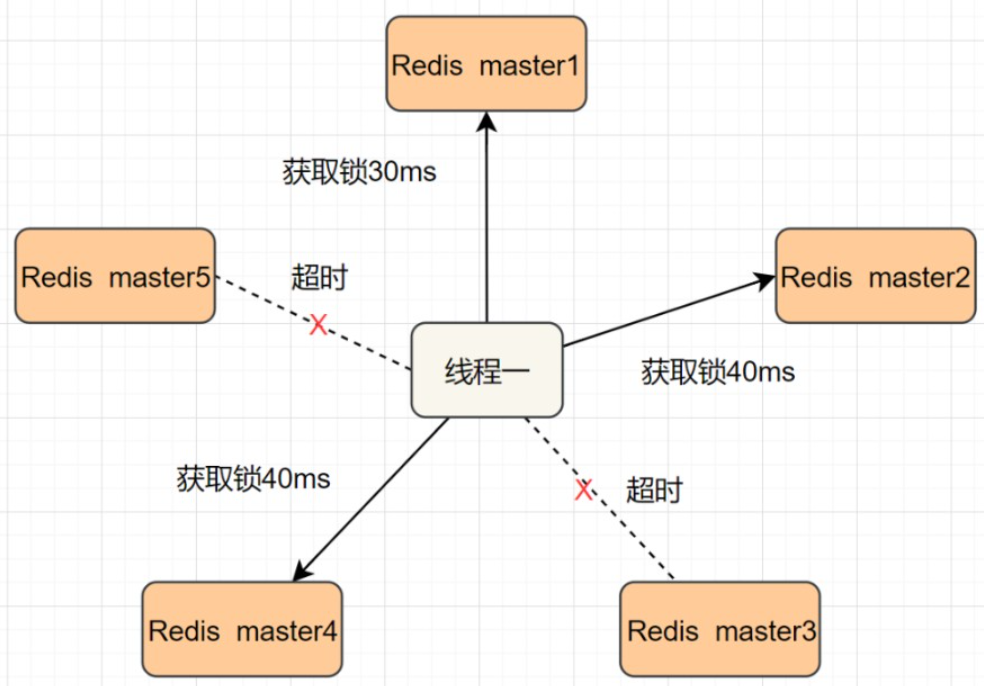

前面的方案是基于**Redis单机版**的分布式锁讨论,还不是很完美。因为Redis一般都是集群部署的。

+

+

如果线程一在`Redis`的`master`节点上拿到了锁,但是加锁的`key`还没同步到`slave`节点。恰好这时,`master`节点发生故障,一个`slave`节点就会升级为`master`节点。线程二就可以顺理成章获取同个`key`的锁啦,但线程一也已经拿到锁了,锁的安全性就没了。

为了解决这个问题,Redis作者antirez提出一种高级的分布式锁算法:**Redlock**。它的核心思想是这样的:

@@ -189,6 +191,8 @@ public class RedisTest {

我们假设当前有5个Redis master节点,在5台服务器上面运行这些Redis实例。

+

+

RedLock的实现步骤:

1. 获取当前时间,以毫秒为单位。

@@ -204,6 +208,8 @@ RedLock的实现步骤:

- 如果大于等于3个节点加锁成功,并且使用的时间小于锁的有效期,即可认定加锁成功啦。

- 如果获取锁失败,解锁!

+Redisson 实现了 redLock 版本的锁,有兴趣的小伙伴,可以去了解一下。

+

### 基于ZooKeeper的实现方式

ZooKeeper是一个为分布式应用提供一致性服务的开源组件,它内部是一个分层的文件系统目录树结构,规定同一个目录下只能有一个唯一文件名。基于ZooKeeper实现分布式锁的步骤如下:

diff --git a/docs/advance/distributed/4-micro-service.md b/docs/advance/distributed/4-micro-service.md

index 286e61b..aec218d 100644

--- a/docs/advance/distributed/4-micro-service.md

+++ b/docs/advance/distributed/4-micro-service.md

@@ -47,9 +47,15 @@ head:

## 分布式和微服务的区别

-从概念理解,分布式服务架构强调的是服务化以及服务的**分散化**,微服务则更强调服务的**专业化和精细分工**;

+微服务解决的是系统复杂度问题,一般来说是业务问题,即在一个系统中承担职责太多了,需要打散,便于理解和维护,进而提升系统的开发效率和运行效率,微服务一般来说是针对应用层面的。

-从实践的角度来看,**微服务架构通常是分布式服务架构**,反之则未必成立。

+分布式解决的是系统性能问题,即解决系统部署上单点的问题,尽量让组成系统的子系统分散在不同的机器上进而提高系统的吞吐能力。

+

+两者概念层面也是不一样的,微服务是设计层面的东西,一般考虑如何将系统从逻辑上进行拆分,也就是垂直拆分;

+

+而分布式是部署层面的东西,即强调物理层面的组成,即系统的各子系统部署在不同计算机上。

+

+微服务可以是分布式的,即可以将不同服务部署在不同计算机上,当然如果量小也可以部署在单机上。

一句话概括:分布式:分散部署;微服务:分散能力。

diff --git a/docs/advance/excellent-article/10-file-upload.md b/docs/advance/excellent-article/10-file-upload.md

index f483d02..0064765 100644

--- a/docs/advance/excellent-article/10-file-upload.md

+++ b/docs/advance/excellent-article/10-file-upload.md

@@ -345,9 +345,7 @@ public abstract class SliceUploadTemplate implements SliceUploadStrategy {

本示例代码在电脑配置为4核内存8G情况下,上传24G大小的文件,上传时间需要30多分钟,主要时间耗费在前端的**md5**值计算,后端写入的速度还是比较快。

-如果项目组觉得自建文件服务器太花费时间,且项目的需求仅仅只是上传下载,那么推荐使用阿里的oss服务器,其介绍可以查看官网:

-

-> https://help.aliyun.com/product/31815.html

+如果项目组觉得自建文件服务器太花费时间,且项目的需求仅仅只是上传下载,那么推荐使用阿里的oss服务器。

阿里的oss它本质是一个对象存储服务器,而非文件服务器,因此如果有涉及到大量删除或者修改文件的需求,oss可能就不是一个好的选择。

diff --git a/docs/advance/excellent-article/29-idempotent-design.md b/docs/advance/excellent-article/29-idempotent-design.md

index 3ab7b34..6cf7d5b 100644

--- a/docs/advance/excellent-article/29-idempotent-design.md

+++ b/docs/advance/excellent-article/29-idempotent-design.md

@@ -12,6 +12,7 @@ head:

- name: description

content: 努力打造最优质的Java学习网站

---

+

## 接口的幂等性如何设计?

分布式系统中的某个接口,该如何保证幂等性?

diff --git a/docs/advance/excellent-article/30-yi-di-duo-huo.md b/docs/advance/excellent-article/30-yi-di-duo-huo.md

new file mode 100644

index 0000000..75657f1

--- /dev/null

+++ b/docs/advance/excellent-article/30-yi-di-duo-huo.md

@@ -0,0 +1,563 @@

+---

+sidebar: heading

+title: 异地多活

+category: 优质文章

+tag:

+ - 架构

+head:

+ - - meta

+ - name: keywords

+ content: 异地多活,同城灾备,同城双活,两地三中心,异地双活,异地多活

+ - - meta

+ - name: description

+ content: 努力打造最优质的Java学习网站

+---

+

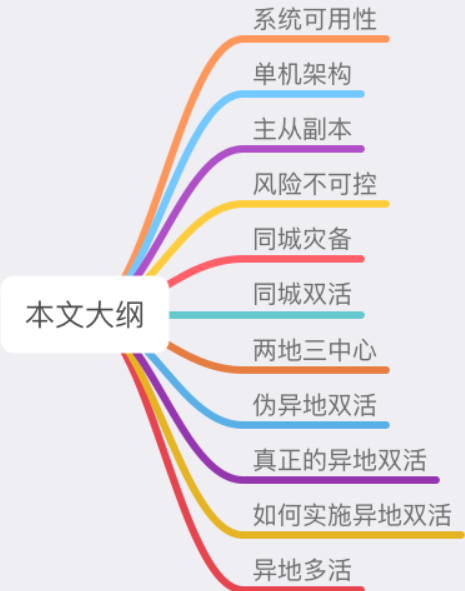

+在软件开发领域,「异地多活」是分布式系统架构设计的一座高峰,很多人经常听过它,但很少人理解其中的原理。

+

+**异地多活到底是什么?为什么需要异地多活?它到底解决了什么问题?究竟是怎么解决的?**

+

+这些疑问,想必是每个程序看到异地多活这个名词时,都想要搞明白的问题。

+

+有幸,我曾经深度参与过一个中等互联网公司,建设异地多活系统的设计与实施过程。所以今天,我就来和你聊一聊异地多活背后的的实现原理。

+

+认真读完这篇文章,我相信你会对异地多活架构,有更加深刻的理解。

+

+**这篇文章干货很多,希望你可以耐心读完。**

+

+

+

+

+

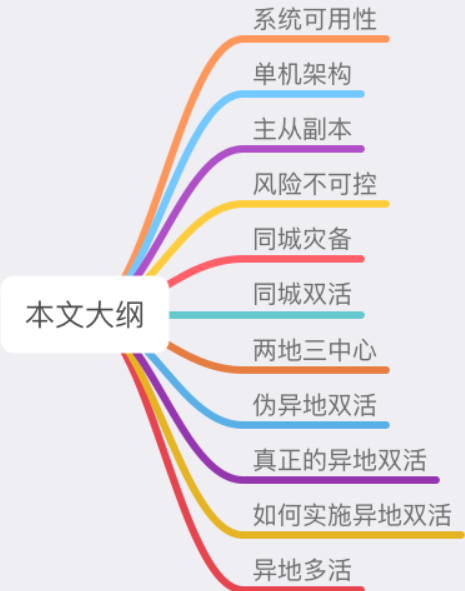

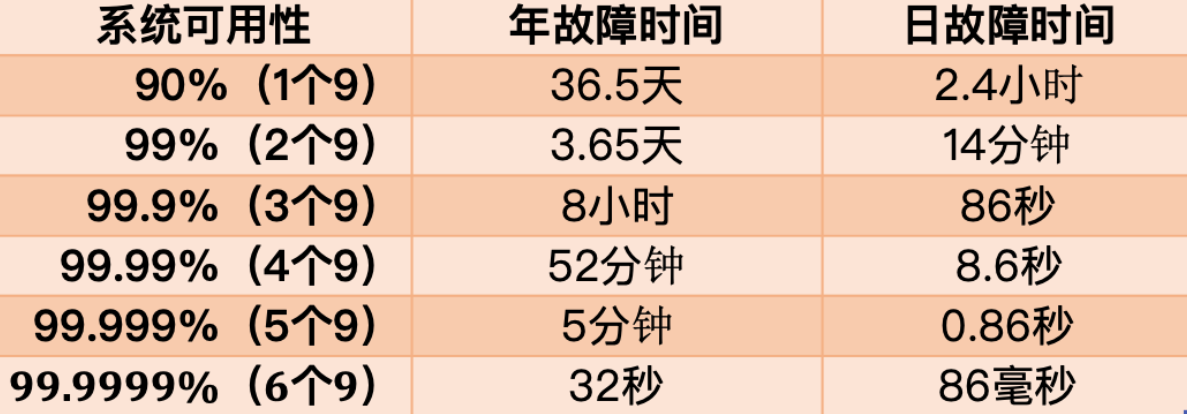

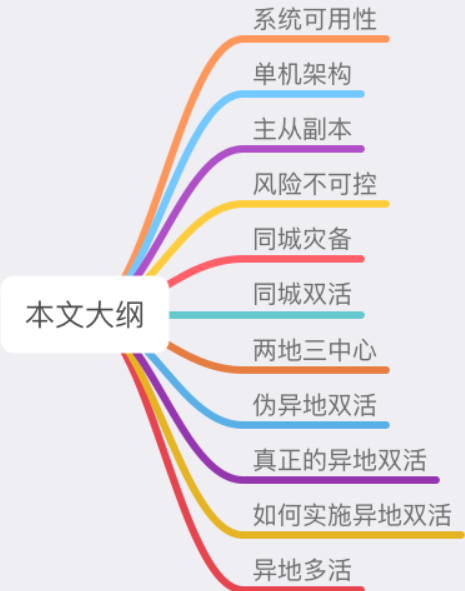

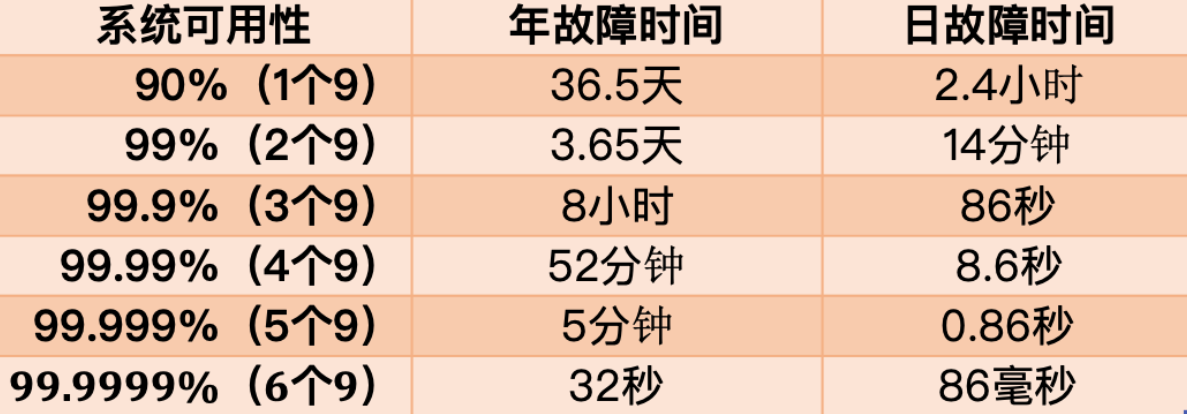

+# 01 系统可用性

+

+要想理解异地多活,我们需要从架构设计的原则说起。

+

+现如今,我们开发一个软件系统,对其要求越来越高,如果你了解一些「架构设计」的要求,就知道一个好的软件架构应该遵循以下 3 个原则:

+

+1. 高性能

+2. 高可用

+3. 易扩展

+

+其中,高性能意味着系统拥有更大流量的处理能力,更低的响应延迟。例如 1 秒可处理 10W 并发请求,接口响应时间 5 ms 等等。

+

+易扩展表示系统在迭代新功能时,能以最小的代价去扩展,系统遇到流量压力时,可以在不改动代码的前提下,去扩容系统。

+

+而「高可用」这个概念,看起来很抽象,怎么理解它呢?通常用 2 个指标来衡量:

+

+- **平均故障间隔 MTBF**(Mean Time Between Failure):表示两次故障的间隔时间,也就是系统「正常运行」的平均时间,这个时间越长,说明系统稳定性越高

+- **故障恢复时间 MTTR**(Mean Time To Repair):表示系统发生故障后「恢复的时间」,这个值越小,故障对用户的影响越小

+

+可用性与这两者的关系:

+

+> 可用性(Availability)= MTBF / (MTBF + MTTR) * 100%

+

+这个公式得出的结果是一个「比例」,通常我们会用「N 个 9」来描述一个系统的可用性。

+

+

+

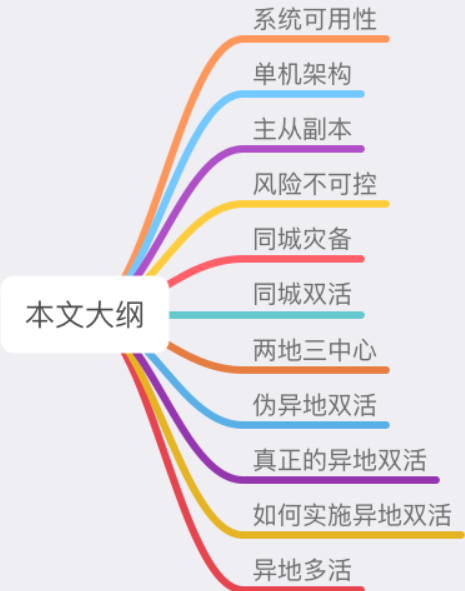

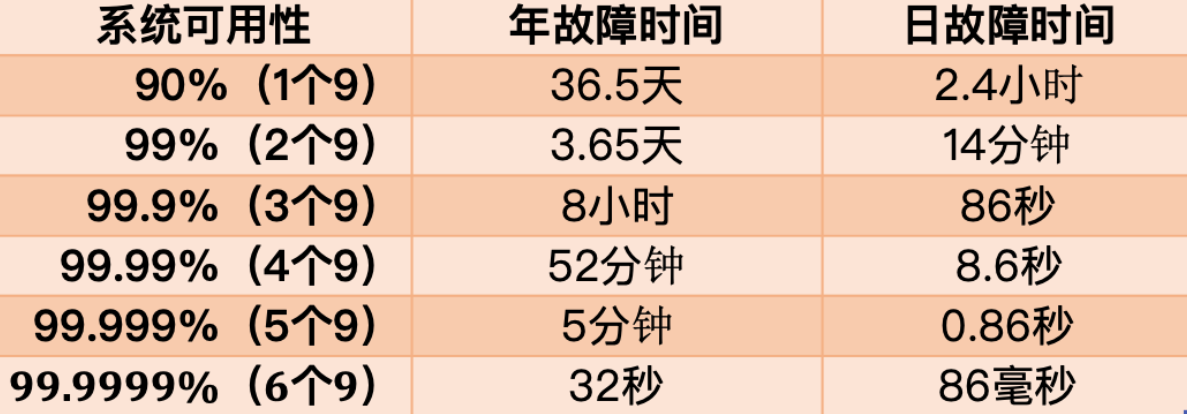

+从这张图你可以看到,要想达到 4 个 9 以上的可用性,平均每天故障时间必须控制在 10 秒以内。

+

+也就是说,只有故障的时间「越短」,整个系统的可用性才会越高,每提升 1 个 9,都会对系统提出更高的要求。

+

+我们都知道,系统发生故障其实是不可避免的,尤其是规模越大的系统,发生问题的概率也越大。这些故障一般体现在 3 个方面:

+

+1. **硬件故障**:CPU、内存、磁盘、网卡、交换机、路由器

+2. **软件问题**:代码 Bug、版本迭代

+3. **不可抗力**:地震、水灾、火灾、战争

+

+这些风险随时都有可能发生。所以,在面对故障时,我们的系统能否以「最快」的速度恢复,就成为了可用性的关键。

+

+可如何做到快速恢复呢?

+

+这篇文章要讲的「异地多活」架构,就是为了解决这个问题,而提出的高效解决方案。

+

+下面,我会从一个最简单的系统出发,带你一步步演化出一个支持「异地多活」的系统架构。

+

+在这个过程中,你会看到一个系统会遇到哪些可用性问题,以及为什么架构要这样演进,从而理解异地多活架构的意义。

+

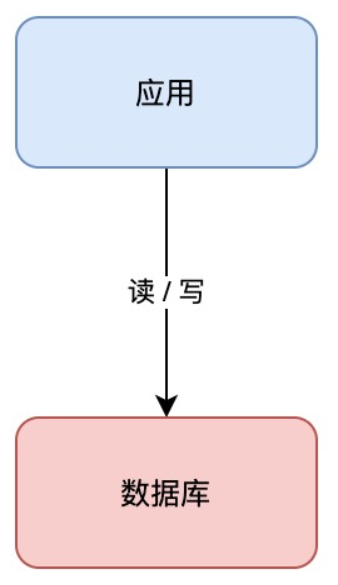

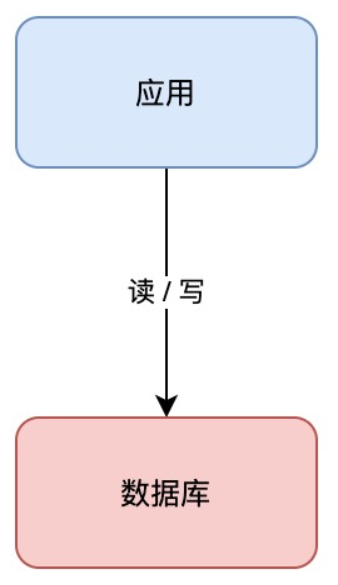

+# 02 单机架构

+

+我们从最简单的开始讲起。

+

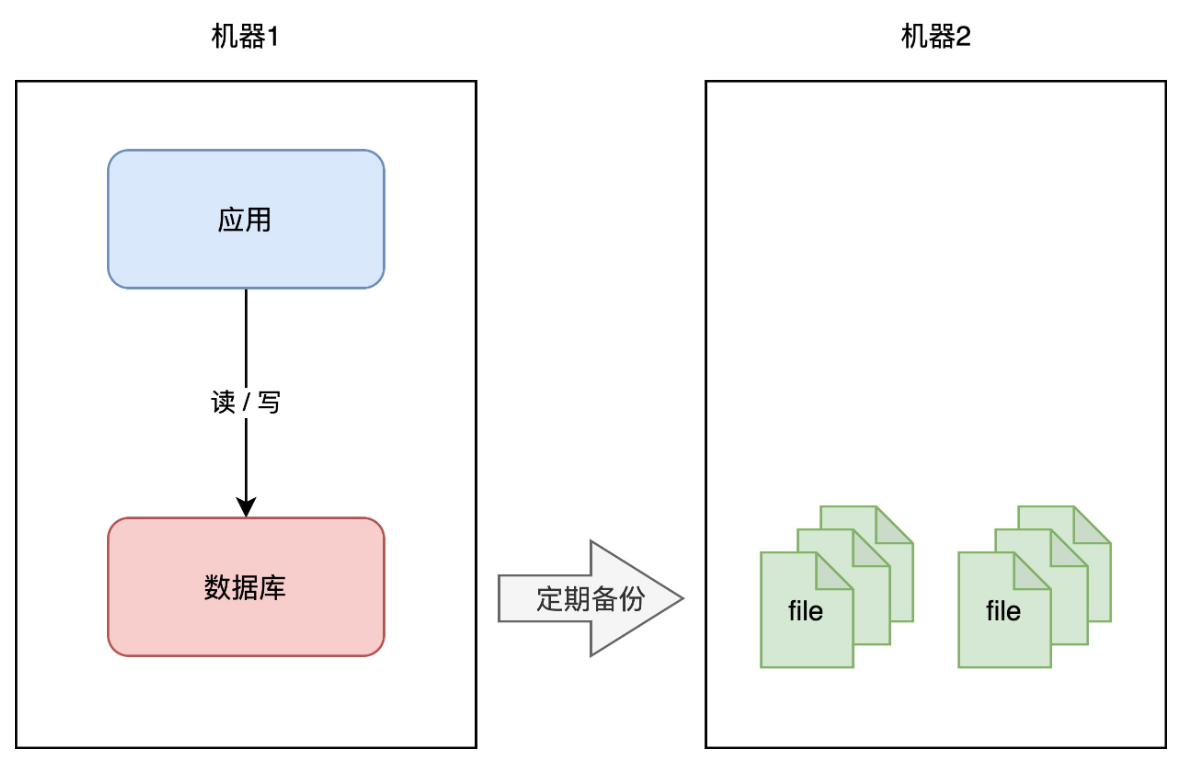

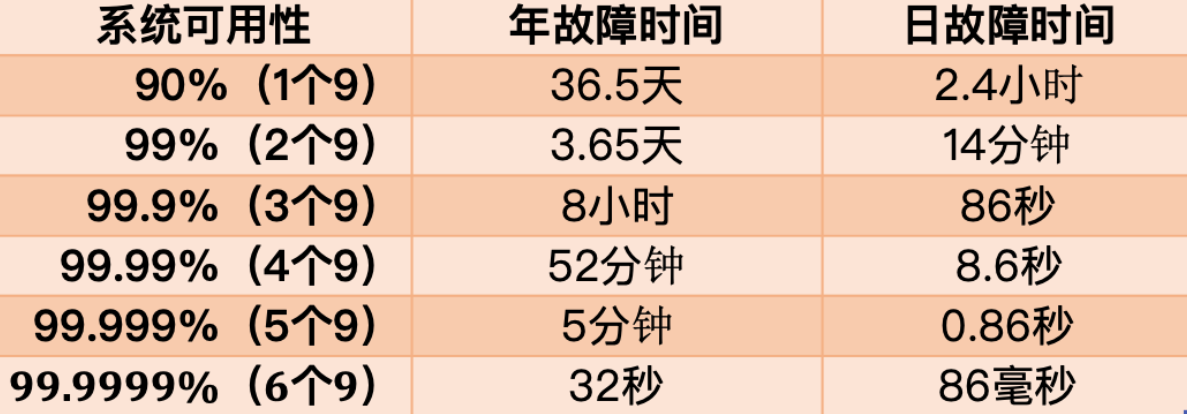

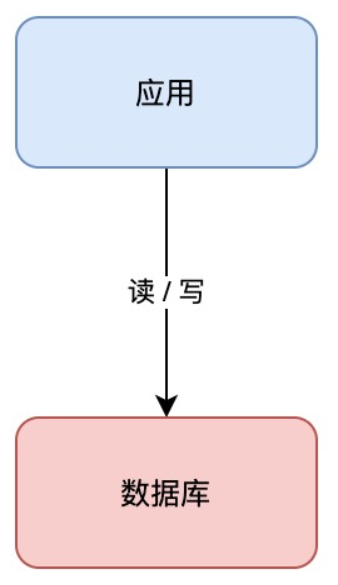

+假设你的业务处于起步阶段,体量非常小,那你的架构是这样的:

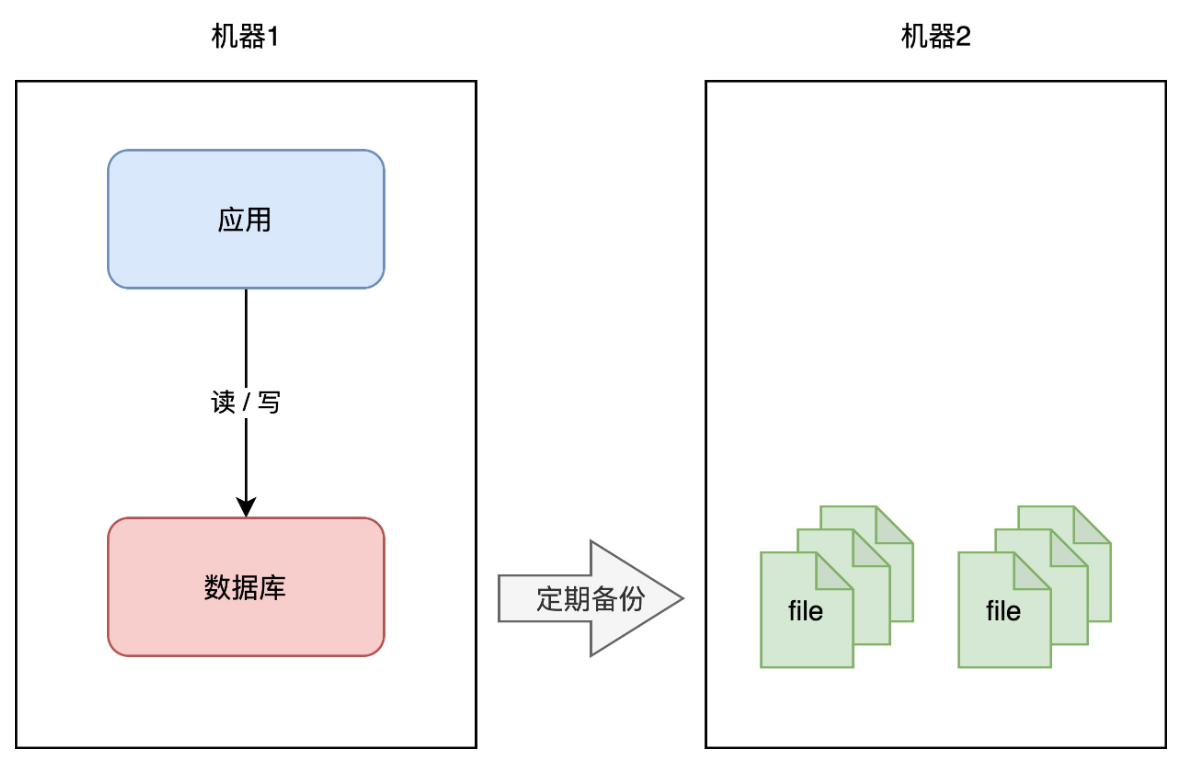

+

+

+

+这个架构模型非常简单,客户端请求进来,业务应用读写数据库,返回结果,非常好理解。

+

+但需要注意的是,这里的数据库是「单机」部署的,所以它有一个致命的缺点:一旦遭遇意外,例如磁盘损坏、操作系统异常、误删数据,那这意味着所有数据就全部「丢失」了,这个损失是巨大的。

+

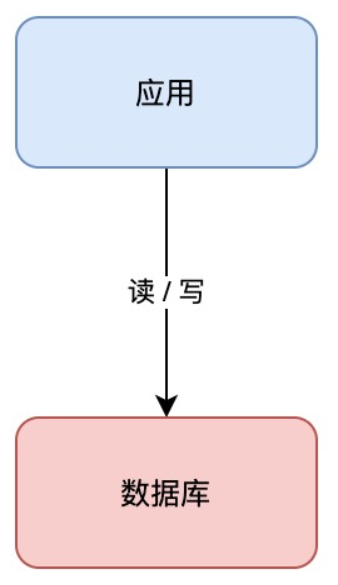

+如何避免这个问题呢?我们很容易想到一个方案:**备份**。

+

+

+

+你可以对数据做备份,把数据库文件「定期」cp 到另一台机器上,这样,即使原机器丢失数据,你依旧可以通过备份把数据「恢复」回来,以此保证数据安全。

+

+这个方案实施起来虽然比较简单,但存在 2 个问题:

+

+1. **恢复需要时间**:业务需先停机,再恢复数据,停机时间取决于恢复的速度,恢复期间服务「不可用」

+2. **数据不完整**:因为是定期备份,数据肯定不是「最新」的,数据完整程度取决于备份的周期

+

+很明显,你的数据库越大,意味故障恢复时间越久。那按照前面我们提到的「高可用」标准,这个方案可能连 1 个 9 都达不到,远远无法满足我们对可用性的要求。

+

+那有什么更好的方案,既可以快速恢复业务?还能尽可能保证数据完整性呢?

+

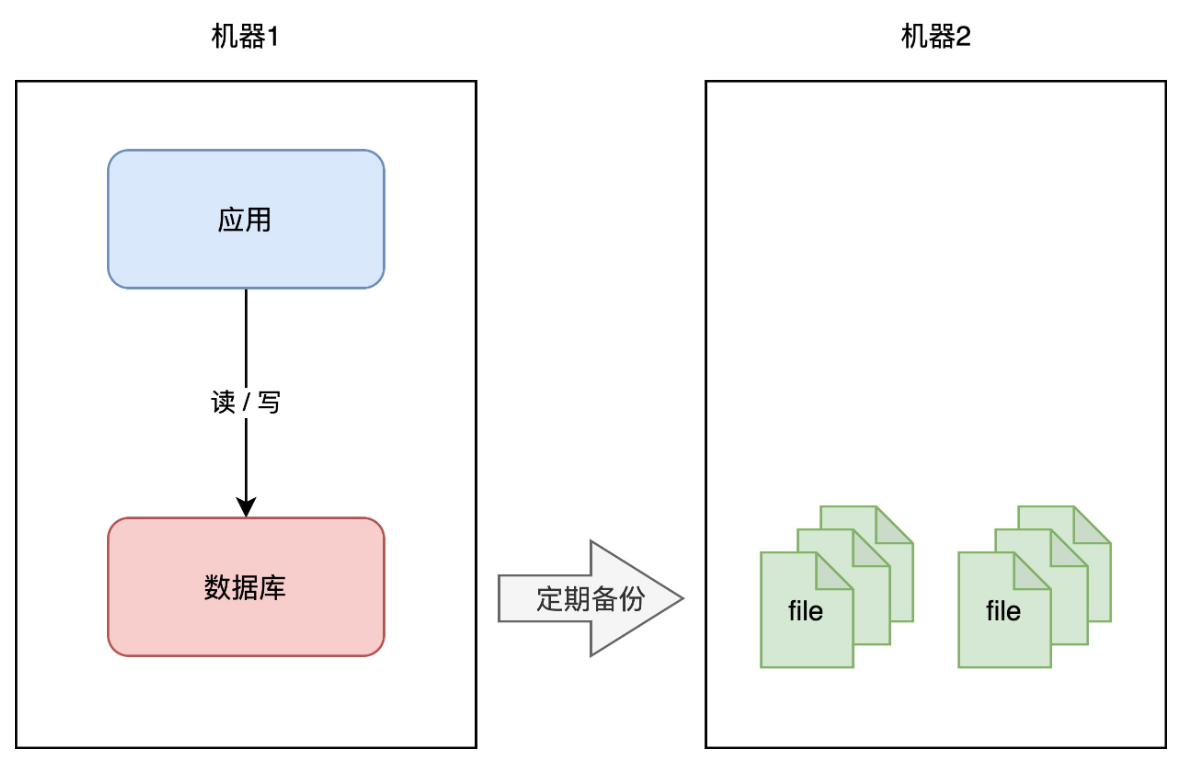

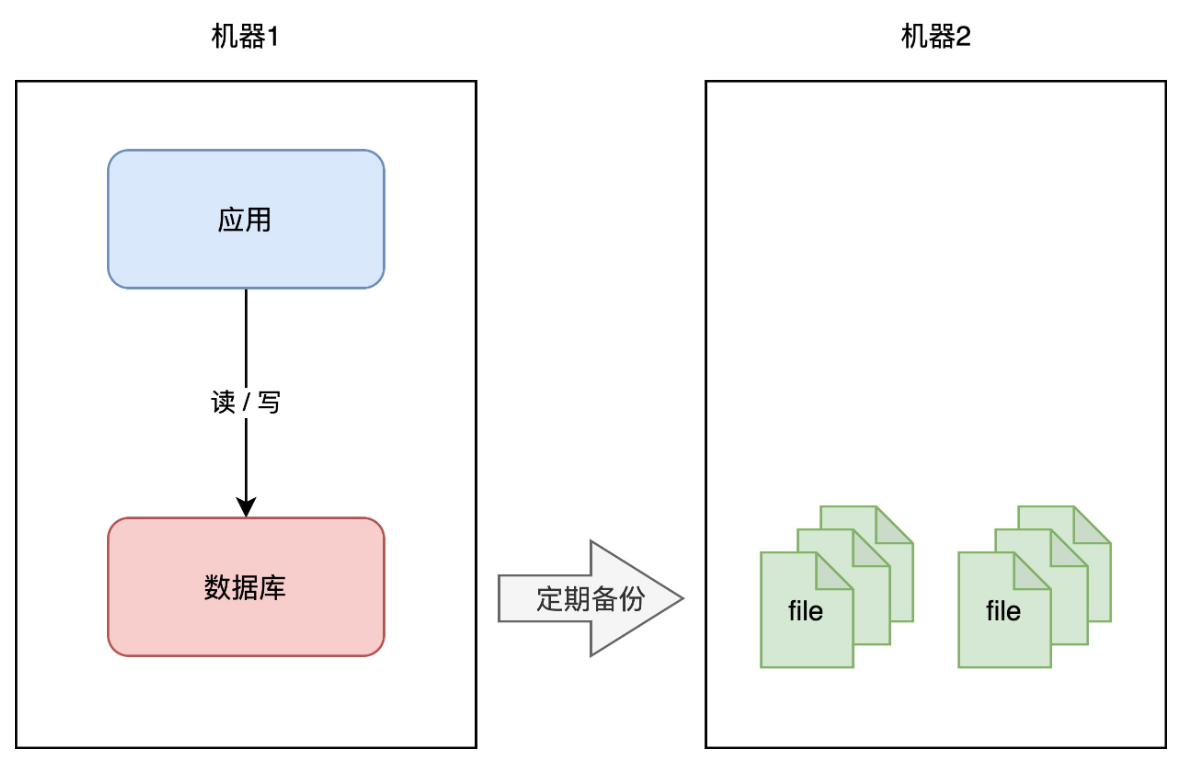

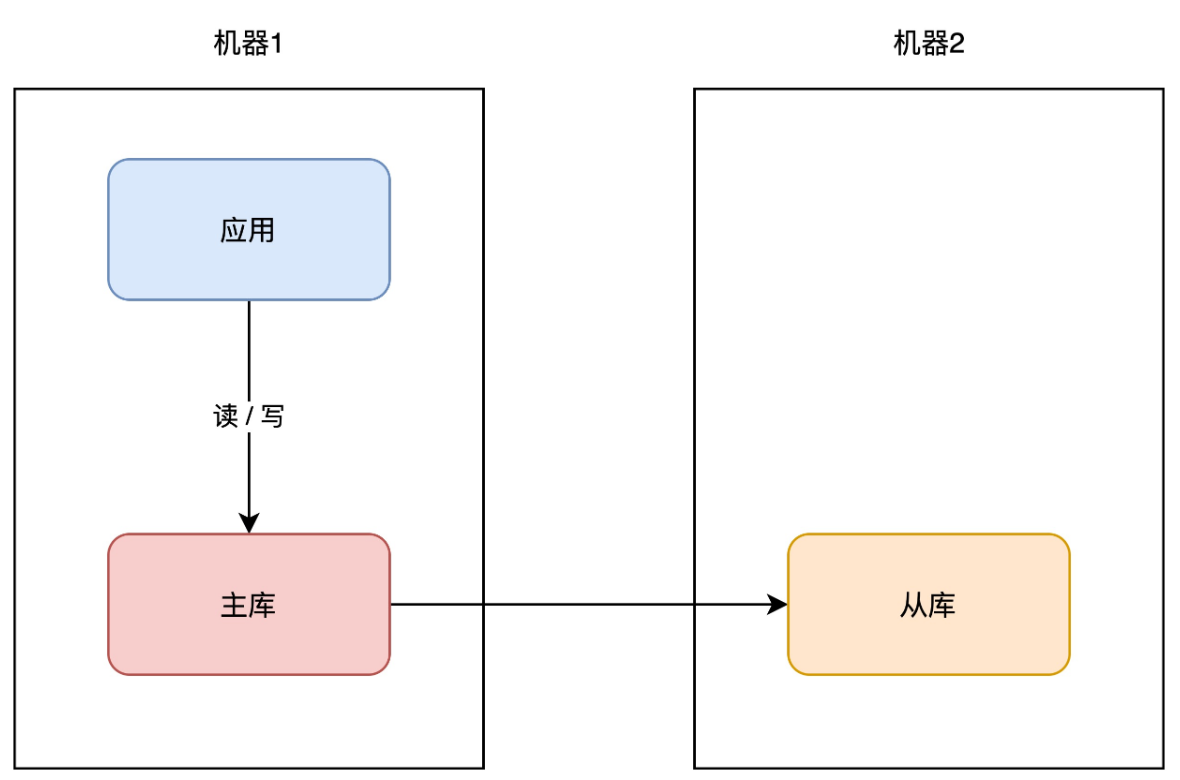

+这时你可以采用这个方案:**主从副本**。

+

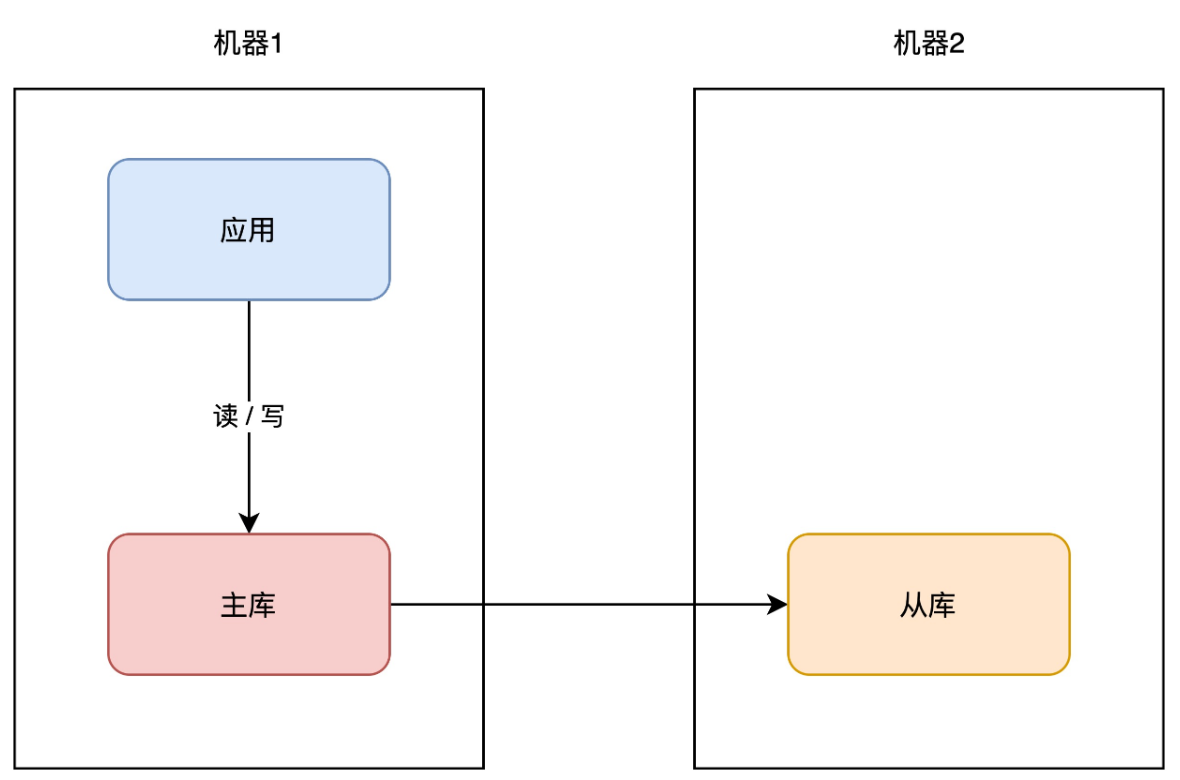

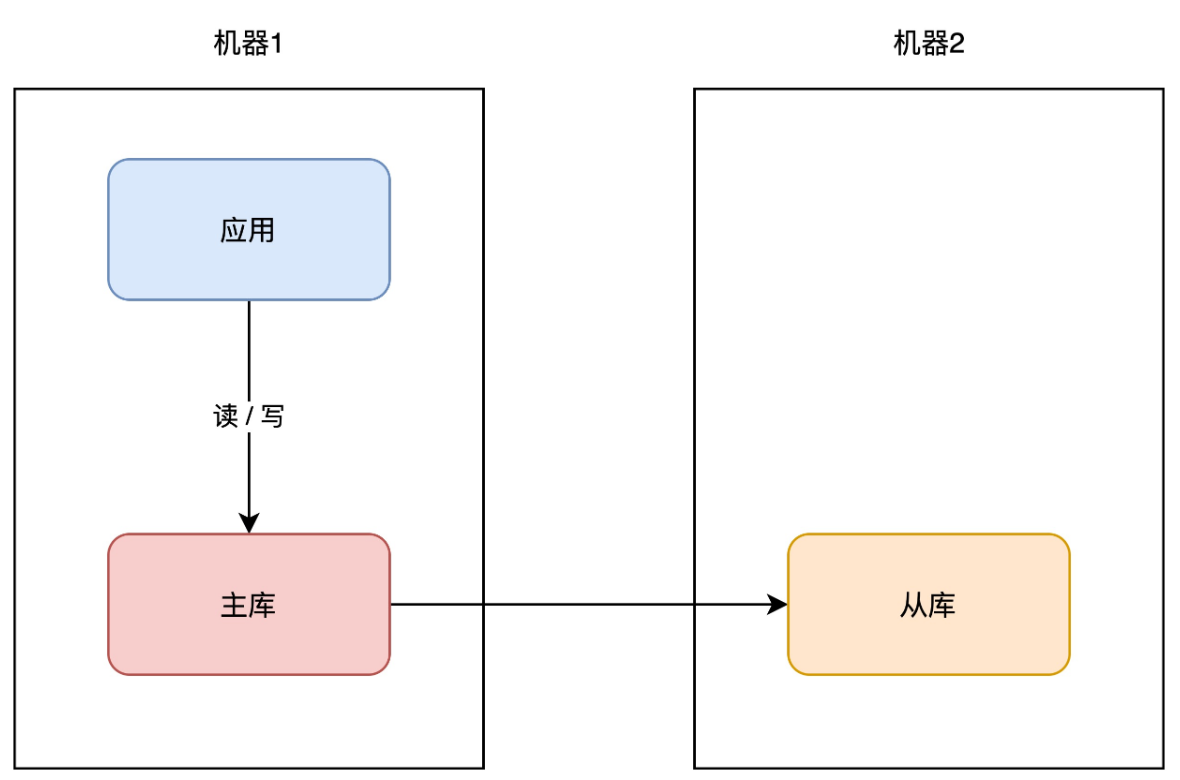

+# 03 主从副本

+

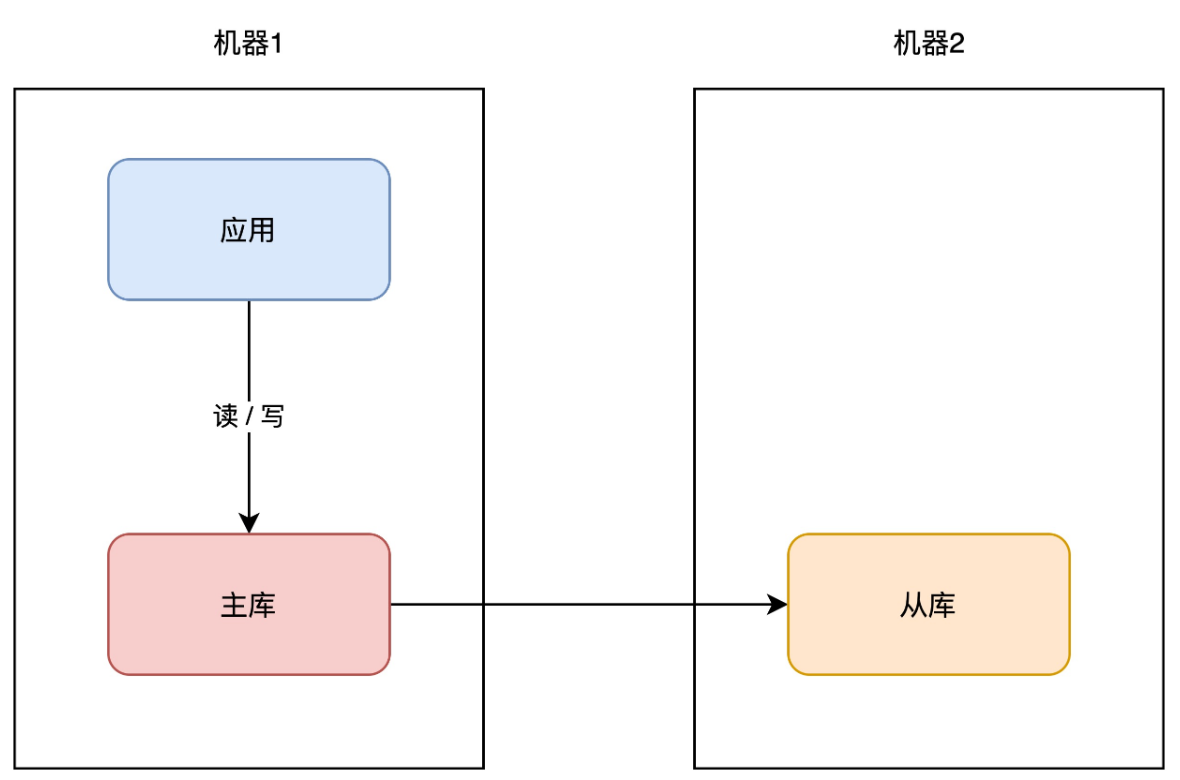

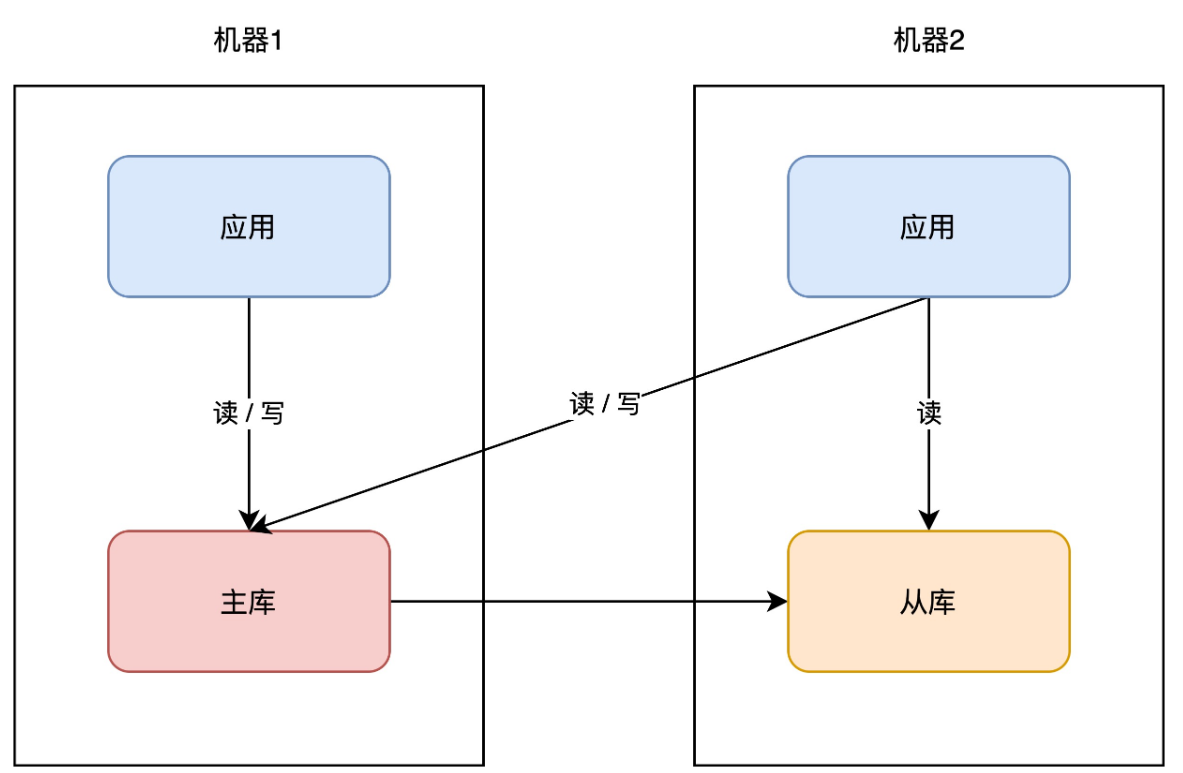

+你可以在另一台机器上,再部署一个数据库实例,让这个新实例成为原实例的「副本」,让两者保持「实时同步」,就像这样:

+

+

+

+我们一般把原实例叫作主库(master),新实例叫作从库(slave)。这个方案的优点在于:

+

+- **数据完整性高**:主从副本实时同步,数据「差异」很小

+- **抗故障能力提升**:主库有任何异常,从库可随时「切换」为主库,继续提供服务

+- **读性能提升**:业务应用可直接读从库,分担主库「压力」读压力

+

+这个方案不错,不仅大大提高了数据库的可用性,还提升了系统的读性能。

+

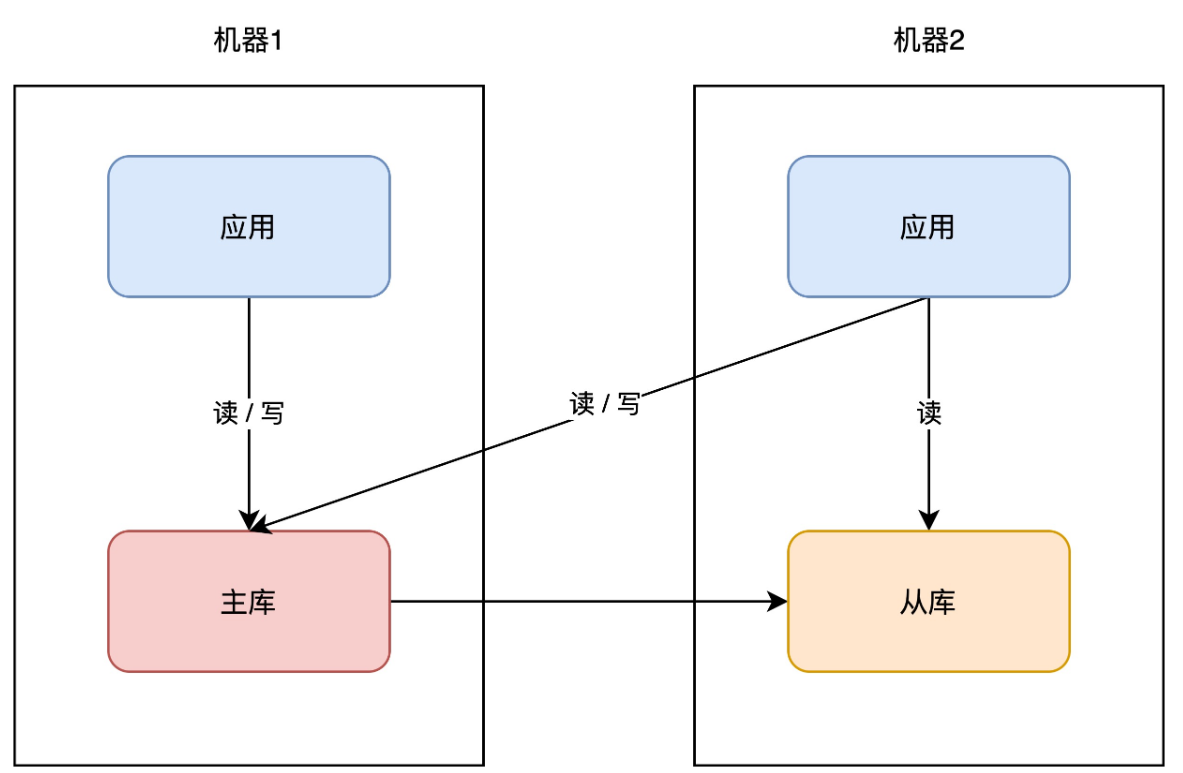

+同样的思路,你的「业务应用」也可以在其它机器部署一份,避免单点。因为业务应用通常是「无状态」的(不像数据库那样存储数据),所以直接部署即可,非常简单。

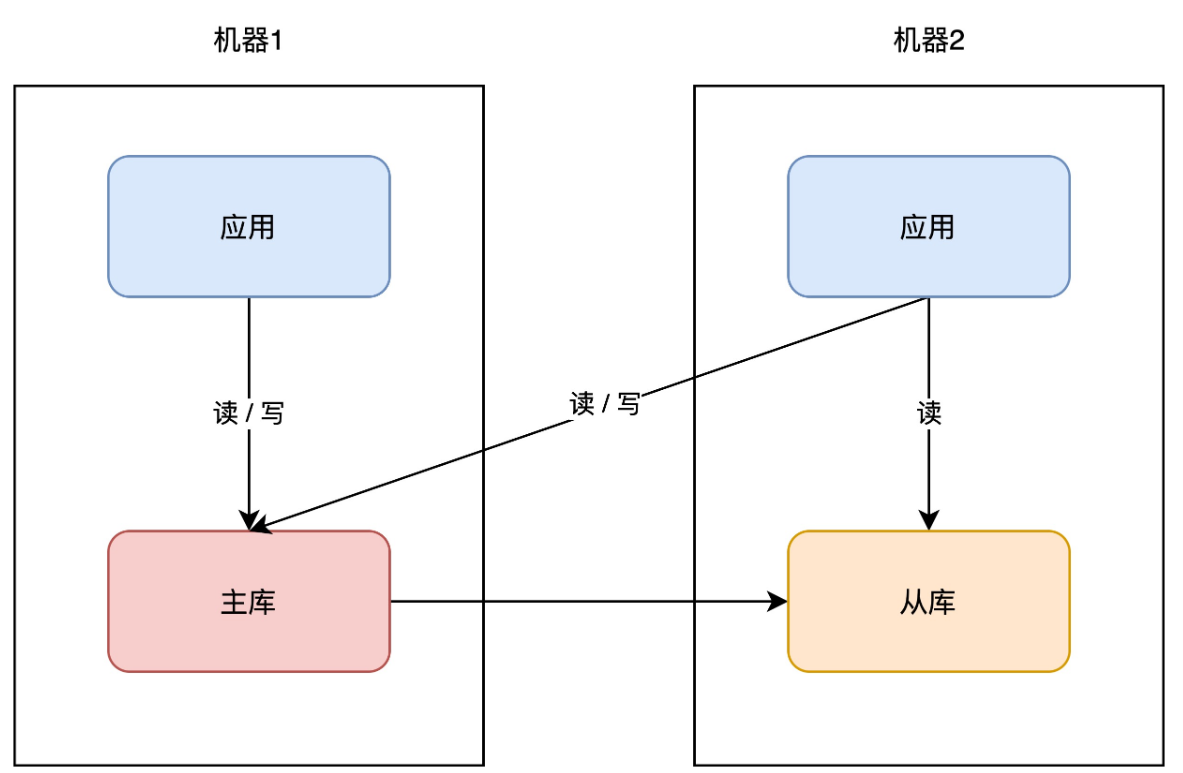

+

+

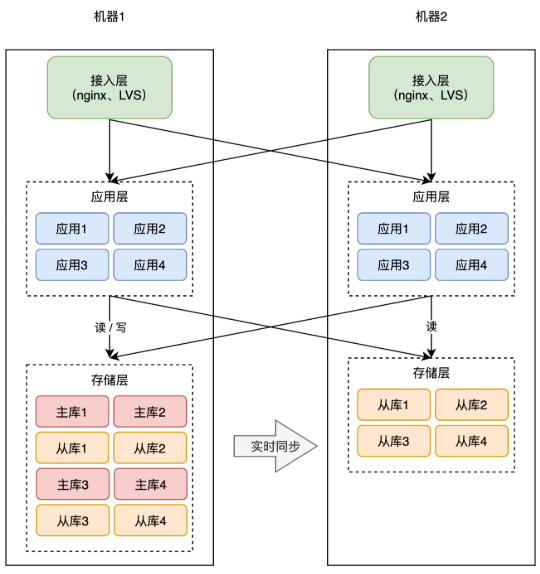

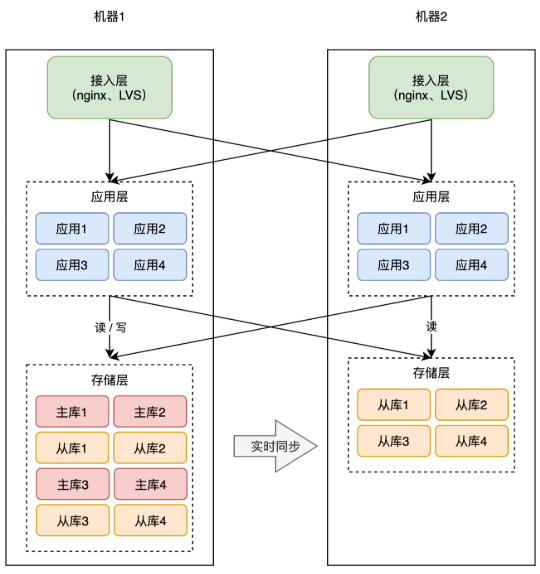

+

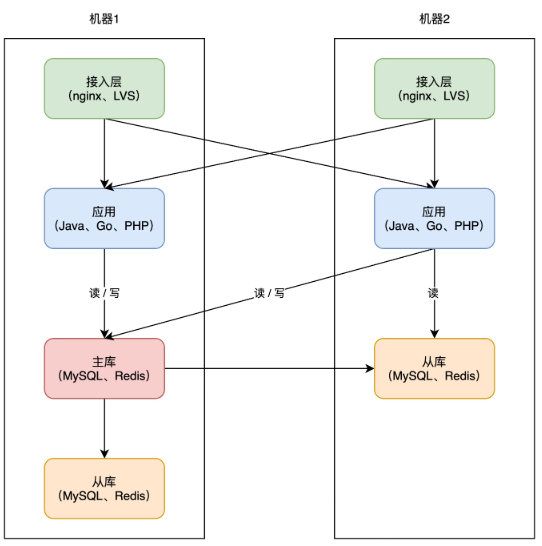

+因为业务应用部署了多个,所以你现在还需要部署一个「接入层」,来做请求的「负载均衡」(一般会使用 nginx 或 LVS),这样当一台机器宕机后,另一台机器也可以「接管」所有流量,持续提供服务。

+

+

+

+从这个方案你可以看出,提升可用性的关键思路就是:**冗余**。

+

+没错,担心一个实例故障,那就部署多个实例,担心一个机器宕机,那就部署多台机器。

+

+到这里,你的架构基本已演变成主流方案了,之后开发新的业务应用,都可以按照这种模式去部署。

+

+

+

+但这种方案还有什么风险吗?

+

+# 04 风险不可控

+

+现在让我们把视角下放,把焦点放到具体的「部署细节」上来。

+

+按照前面的分析,为了避免单点故障,你的应用虽然部署了多台机器,但这些机器的分布情况,我们并没有去深究。

+

+而一个机房有很多服务器,这些服务器通常会分布在一个个「机柜」上,如果你使用的这些机器,刚好在一个机柜,还是存在风险。

+

+如果恰好连接这个机柜的交换机 / 路由器发生故障,那么你的应用依旧有「不可用」的风险。

+

+> 虽然交换机 / 路由器也做了路线冗余,但不能保证一定不出问题。

+

+部署在一个机柜有风险,那把这些机器打散,分散到不同机柜上,是不是就没问题了?

+

+这样确实会大大降低出问题的概率。但我们依旧不能掉以轻心,因为无论怎么分散,它们总归还是在一个相同的环境下:**机房**。

+

+那继续追问,机房会不会发生故障呢?

+

+一般来讲,建设一个机房的要求其实是很高的,地理位置、温湿度控制、备用电源等等,机房厂商会在各方面做好防护。但即使这样,我们每隔一段时间还会看到这样的新闻:

+

+- 2015 年 5 月 27 日,杭州市某地光纤被挖断,近 3 亿用户长达 5 小时无法访问支付宝

+- 2021 年 7 月 13 日,B 站部分服务器机房发生故障,造成整站持续 3 个小时无法访问

+- 2021 年 10 月 9 日,富途证券服务器机房发生电力闪断故障,造成用户 2 个小时无法登陆、交易

+- …

+

+可见,即使机房级别的防护已经做得足够好,但只要有「概率」出问题,那现实情况就有可能发生。虽然概率很小,但一旦真的发生,影响之大可见一斑。

+

+看到这里你可能会想,机房出现问题的概率也太小了吧,工作了这么多年,也没让我碰上一次,有必要考虑得这么复杂吗?

+

+但你有没有思考这样一个问题:**不同体量的系统,它们各自关注的重点是什么?**

+

+体量很小的系统,它会重点关注「用户」规模、增长,这个阶段获取用户是一切。等用户体量上来了,这个阶段会重点关注「性能」,优化接口响应时间、页面打开速度等等,这个阶段更多是关注用户体验。

+

+等体量再大到一定规模后你会发现,「可用性」就变得尤为重要。像微信、支付宝这种全民级的应用,如果机房发生一次故障,那整个影响范围可以说是非常巨大的。

+

+所以,再小概率的风险,我们在提高系统可用性时,也不能忽视。

+

+分析了风险,再说回我们的架构。那到底该怎么应对机房级别的故障呢?

+

+没错,还是**冗余**。

+

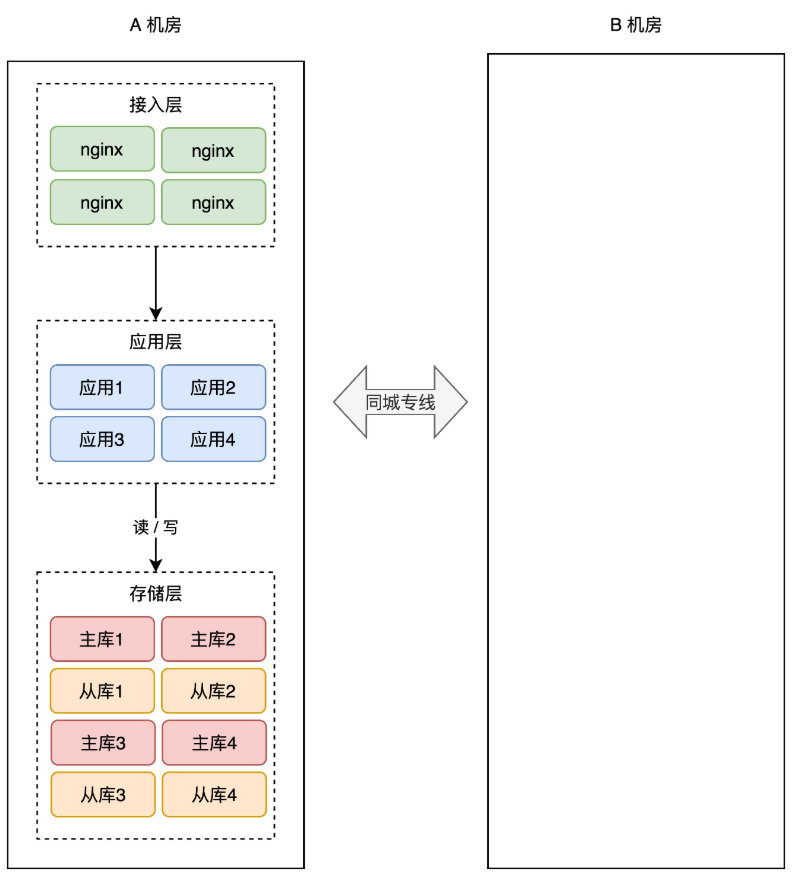

+# 05 同城灾备

+

+想要抵御「机房」级别的风险,那应对方案就不能局限在一个机房内了。

+

+现在,你需要做机房级别的冗余方案,也就是说,你需要再搭建一个机房,来部署你的服务。

+

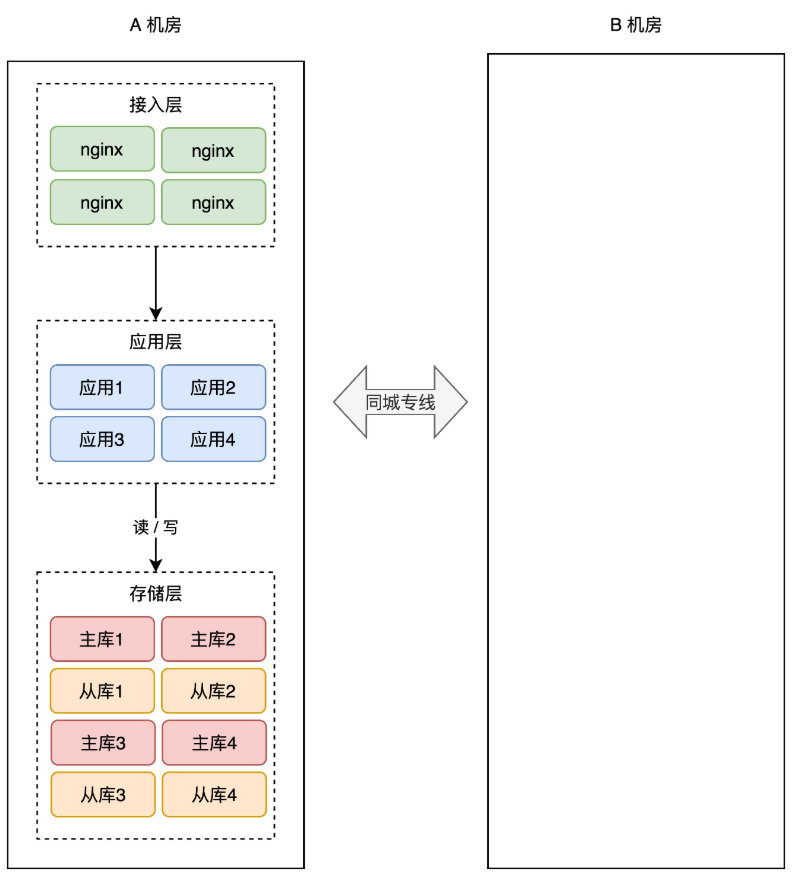

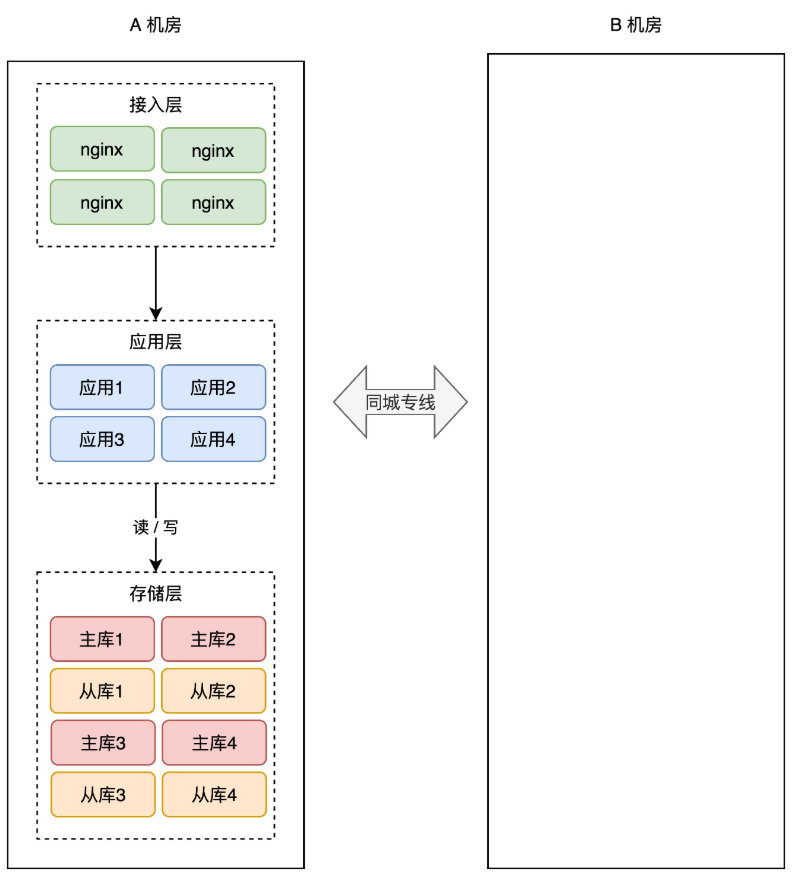

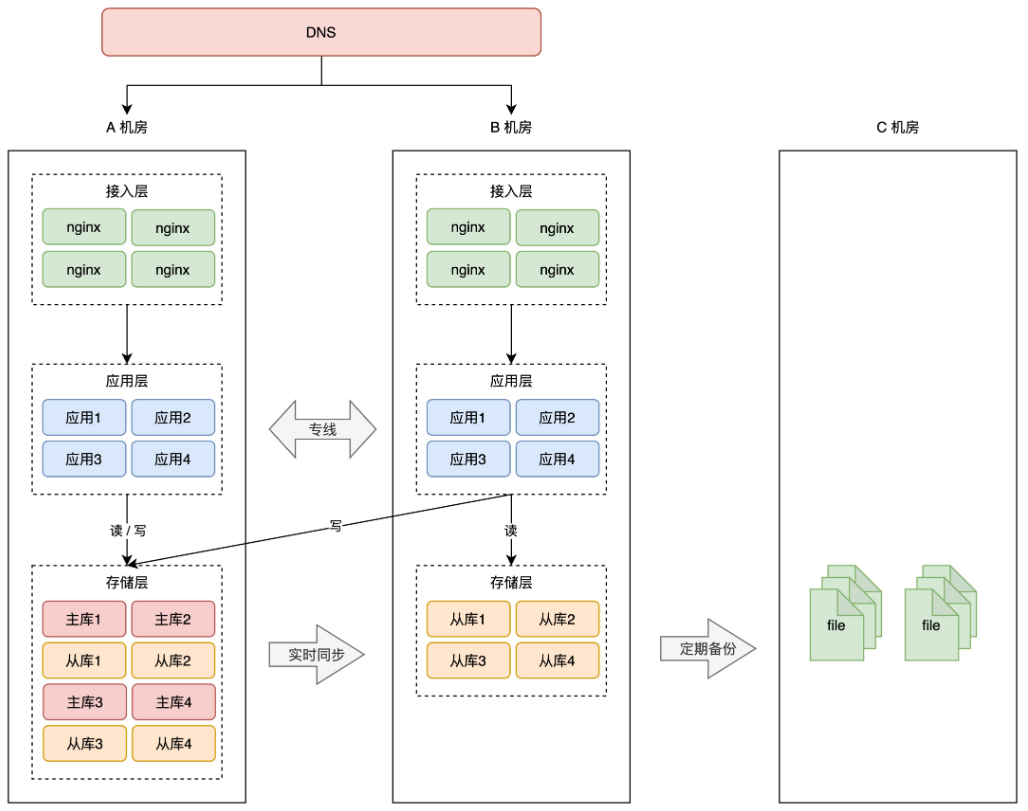

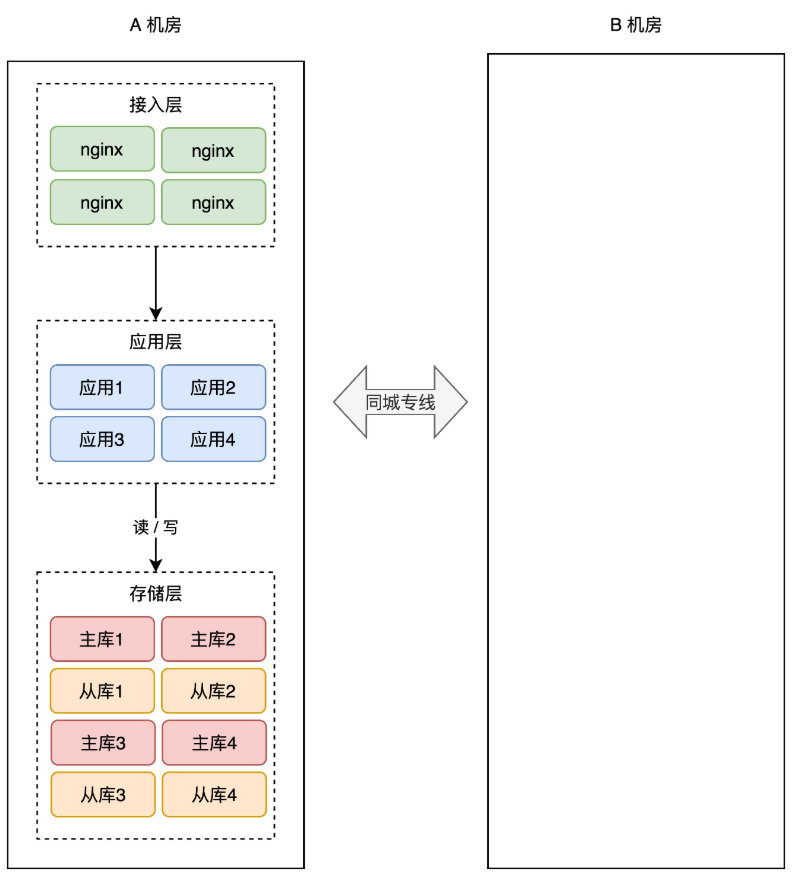

+简单起见,你可以在「同一个城市」再搭建一个机房,原机房我们叫作 A 机房,新机房叫 B 机房,这两个机房的网络用一条「专线」连通。

+

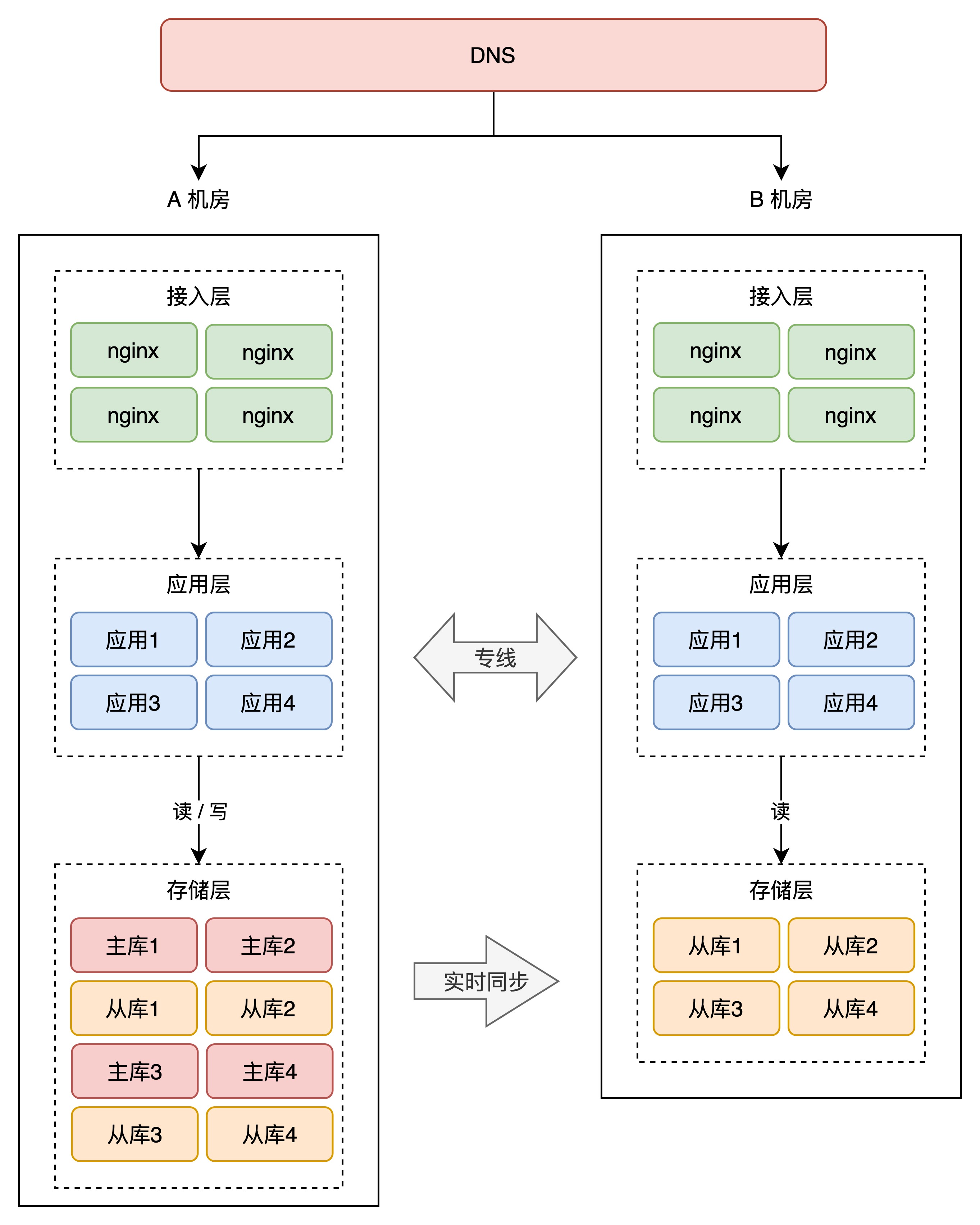

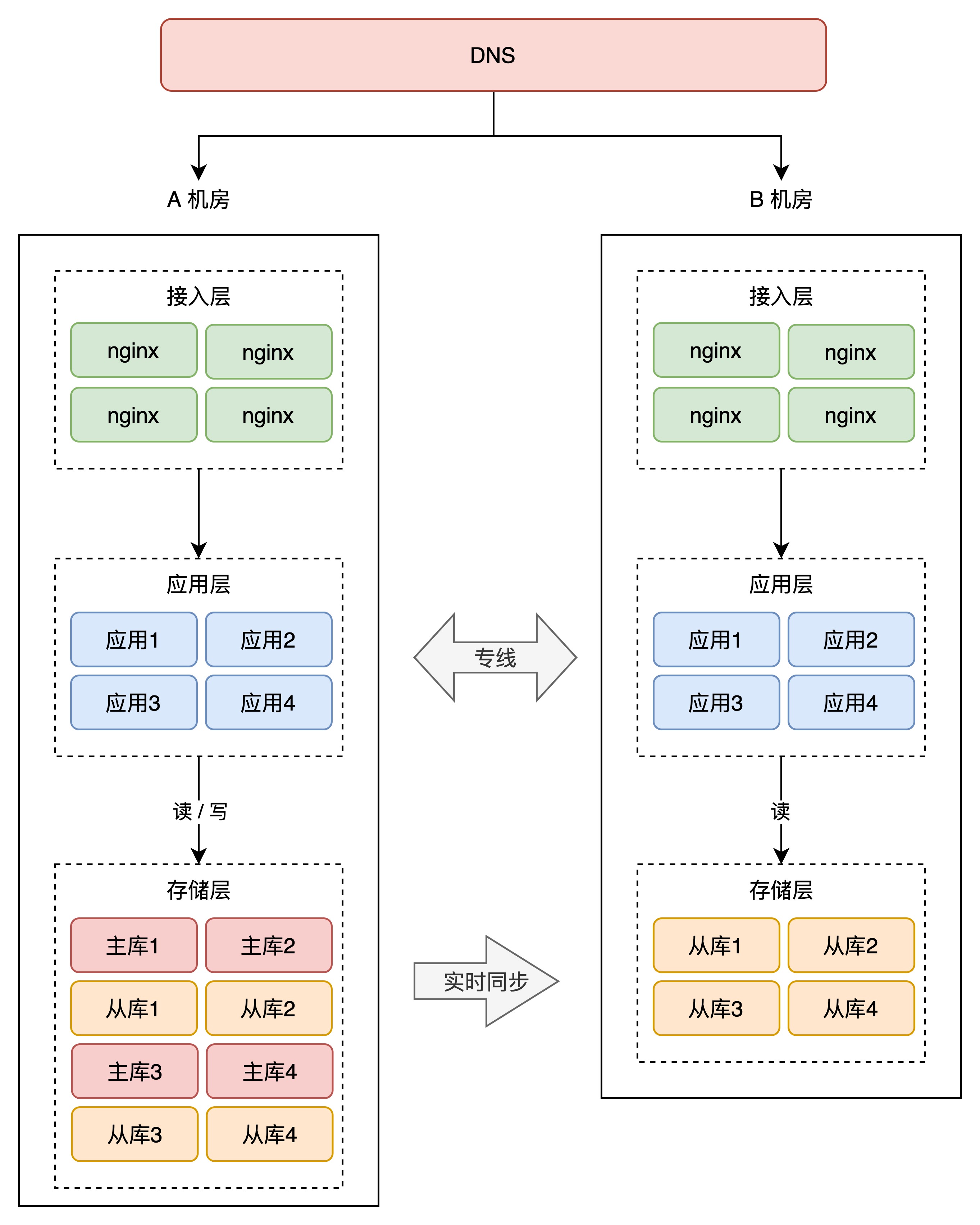

+

+

+有了新机房,怎么把它用起来呢?这里还是要优先考虑「数据」风险。

+

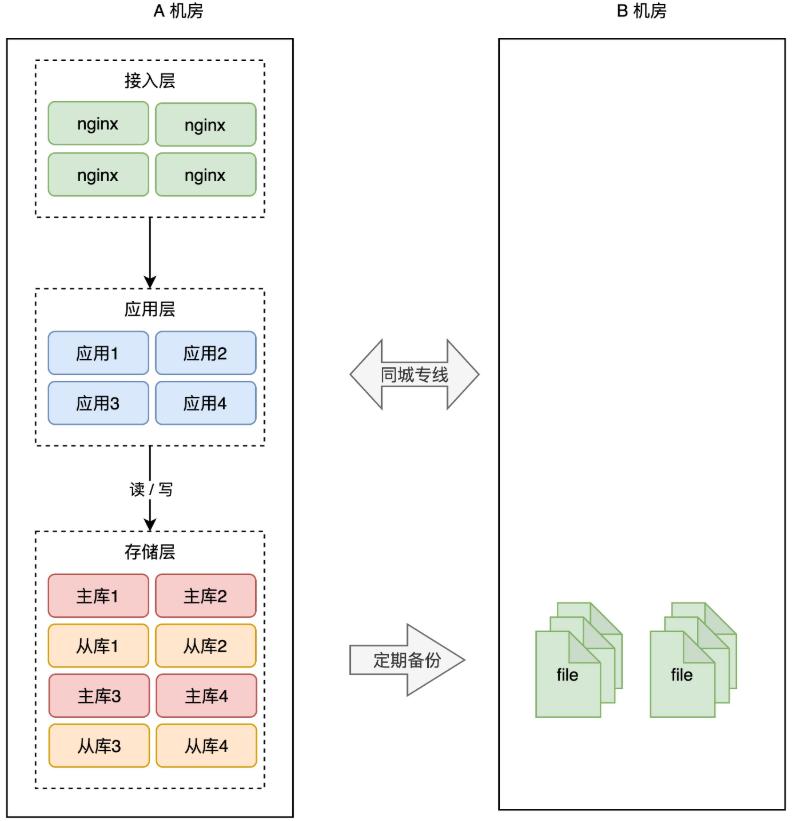

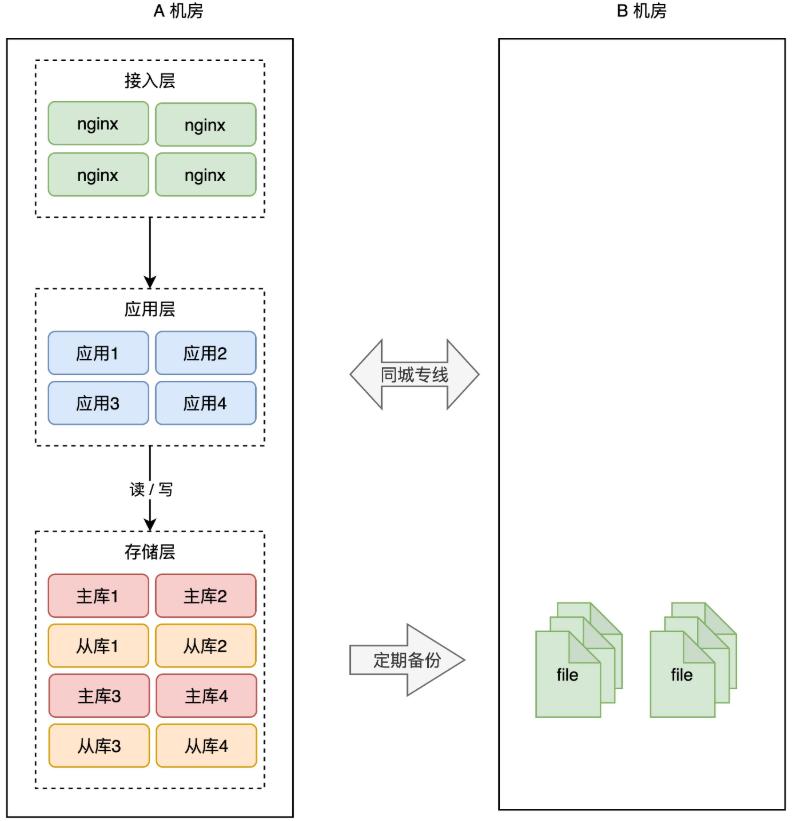

+为了避免 A 机房故障导致数据丢失,所以我们需要把数据在 B 机房也存一份。最简单的方案还是和前面提到的一样:**备份**。

+

+A 机房的数据,定时在 B 机房做备份(拷贝数据文件),这样即使整个 A 机房遭到严重的损坏,B 机房的数据不会丢,通过备份可以把数据「恢复」回来,重启服务。

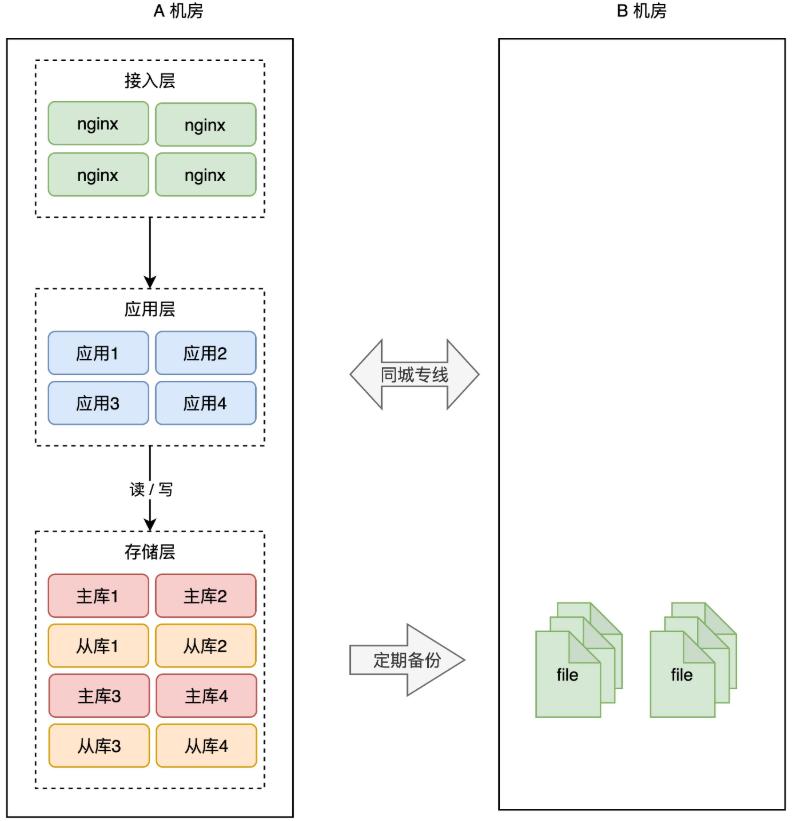

+

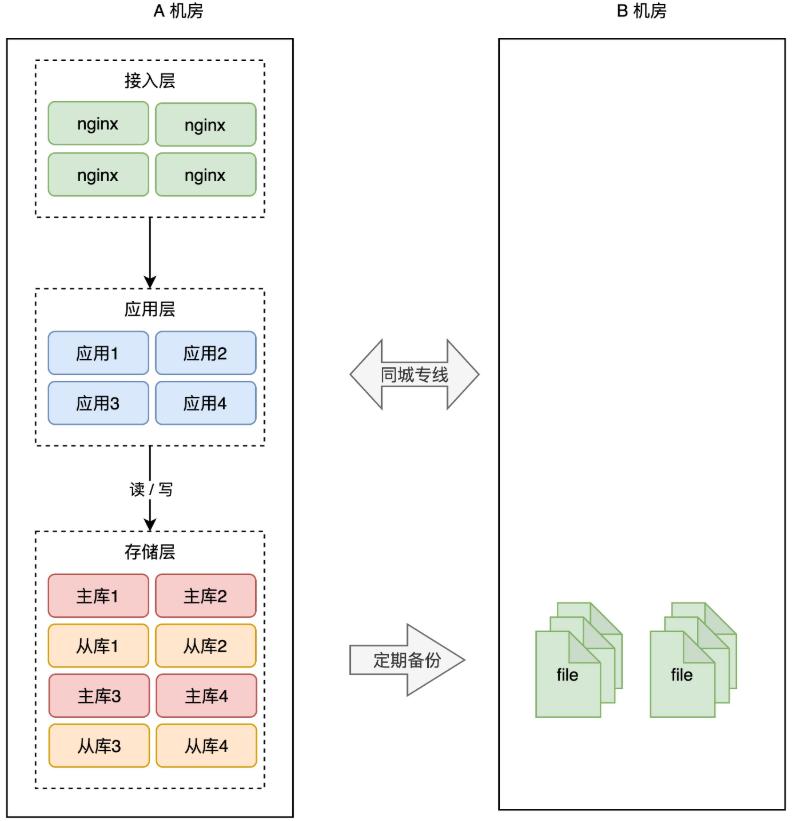

+

+

+这种方案,我们称之为「**冷备**」。为什么叫冷备呢?因为 B 机房只做备份,不提供实时服务,它是冷的,只会在 A 机房故障时才会启用。

+

+但备份的问题依旧和之前描述的一样:数据不完整、恢复数据期间业务不可用,整个系统的可用性还是无法得到保证。

+

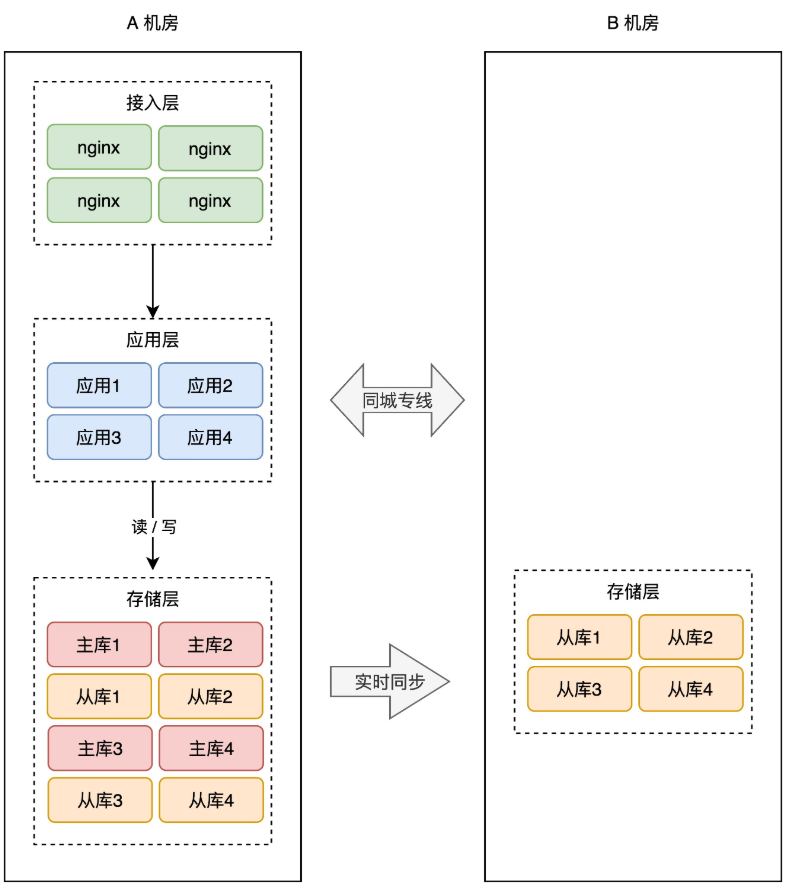

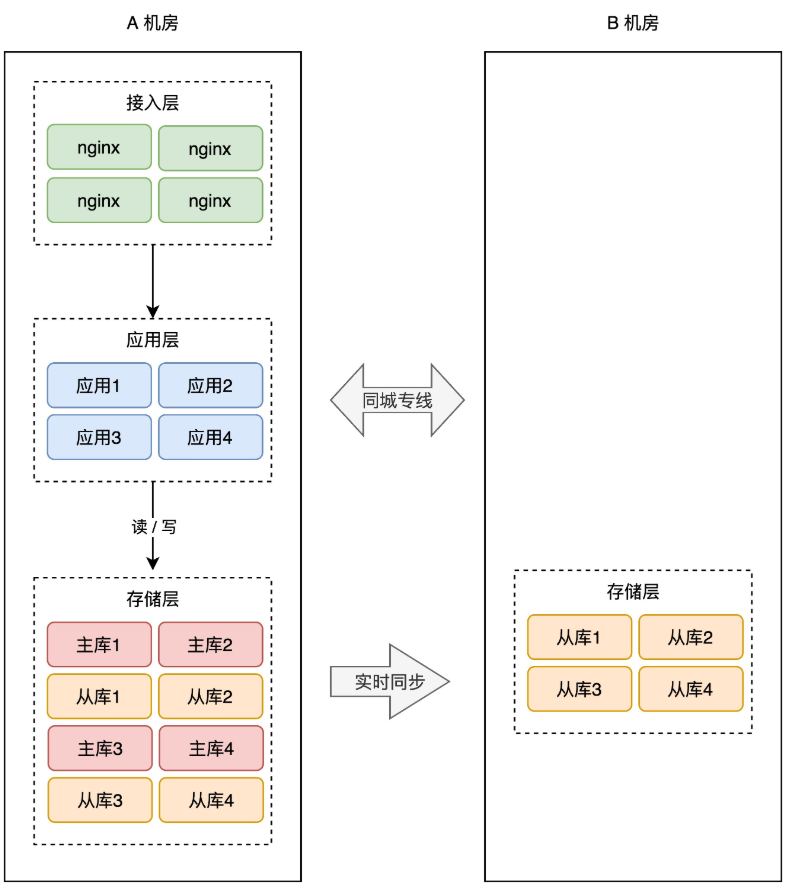

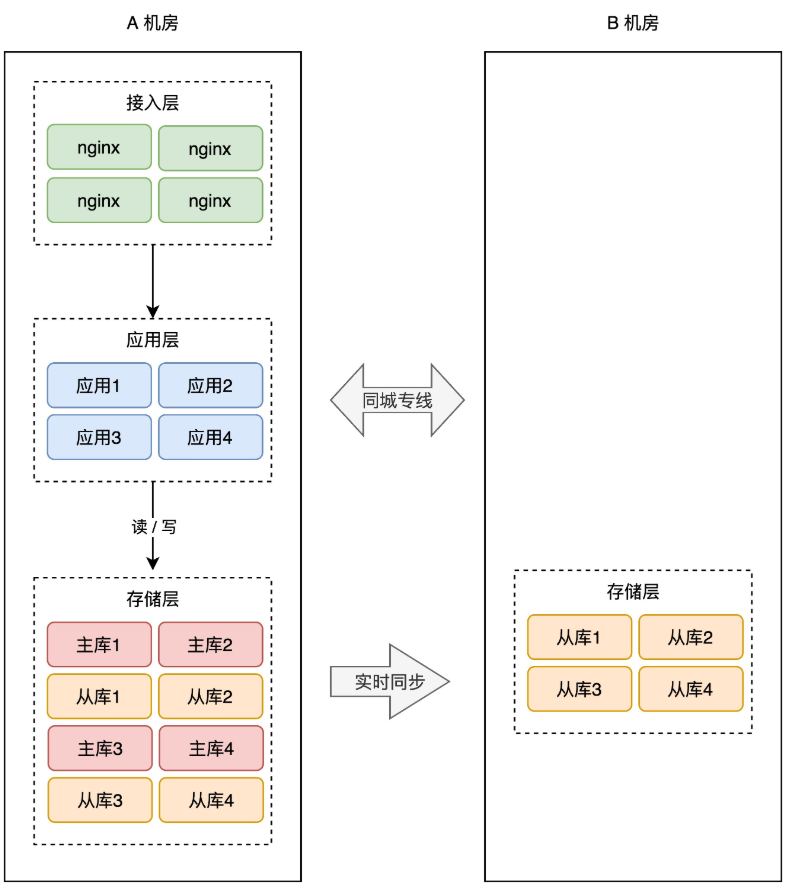

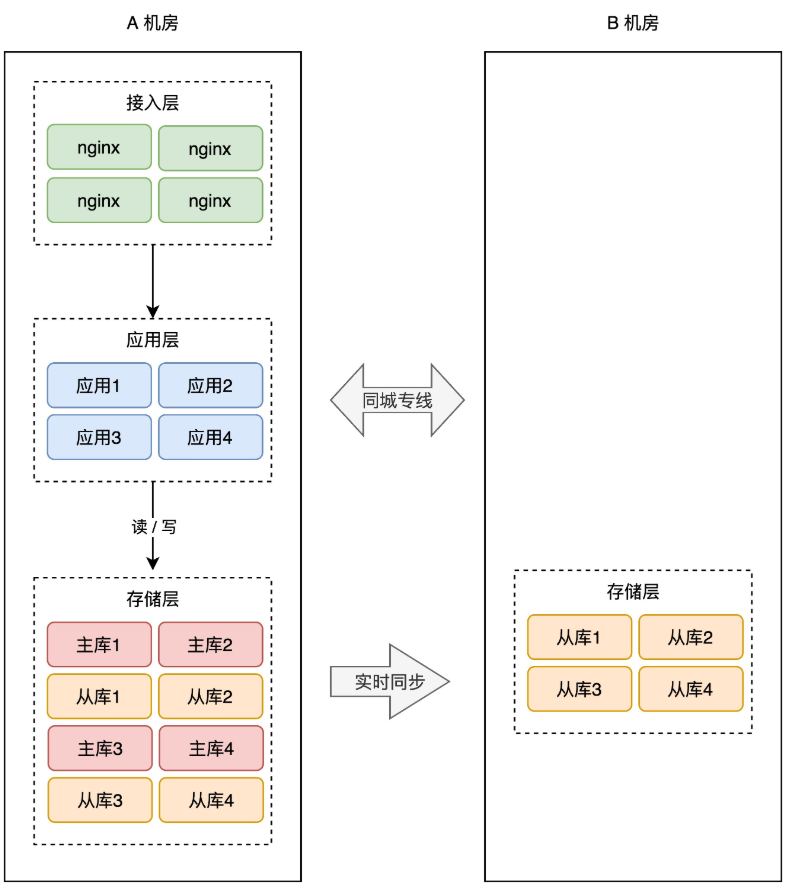

+所以,我们还是需要用「主从副本」的方式,在 B 机房部署 A 机房的数据副本,架构就变成了这样:

+

+

+

+这样,就算整个 A 机房挂掉,我们在 B 机房也有比较「完整」的数据。

+

+数据是保住了,但这时你需要考虑另外一个问题:**如果 A 机房真挂掉了,要想保证服务不中断,你还需要在 B 机房「紧急」做这些事情**:

+

+1. B 机房所有从库提升为主库

+2. 在 B 机房部署应用,启动服务

+3. 部署接入层,配置转发规则

+4. DNS 指向 B 机房接入层,接入流量,业务恢复

+

+看到了么?A 机房故障后,B 机房需要做这么多工作,你的业务才能完全「恢复」过来。

+

+你看,整个过程需要人为介入,且需花费大量时间来操作,恢复之前整个服务还是不可用的,这个方案还是不太爽,如果能做到故障后立即「切换」,那就好了。

+

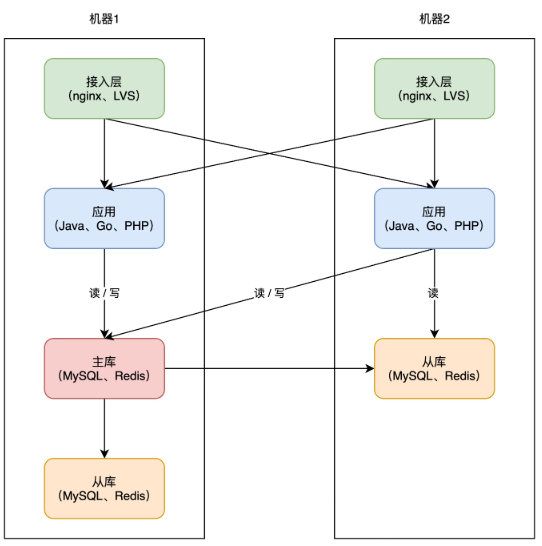

+因此,要想缩短业务恢复的时间,你必须把这些工作在 B 机房「提前」做好,也就是说,你需要在 B 机房提前部署好接入层、业务应用,等待随时切换。架构就变成了这样:

+

+

+

+这样的话,A 机房整个挂掉,我们只需要做 2 件事即可:

+

+1. B 机房所有从库提升为主库

+2. DNS 指向 B 机房接入层,接入流量,业务恢复

+

+这样一来,恢复速度快了很多。

+

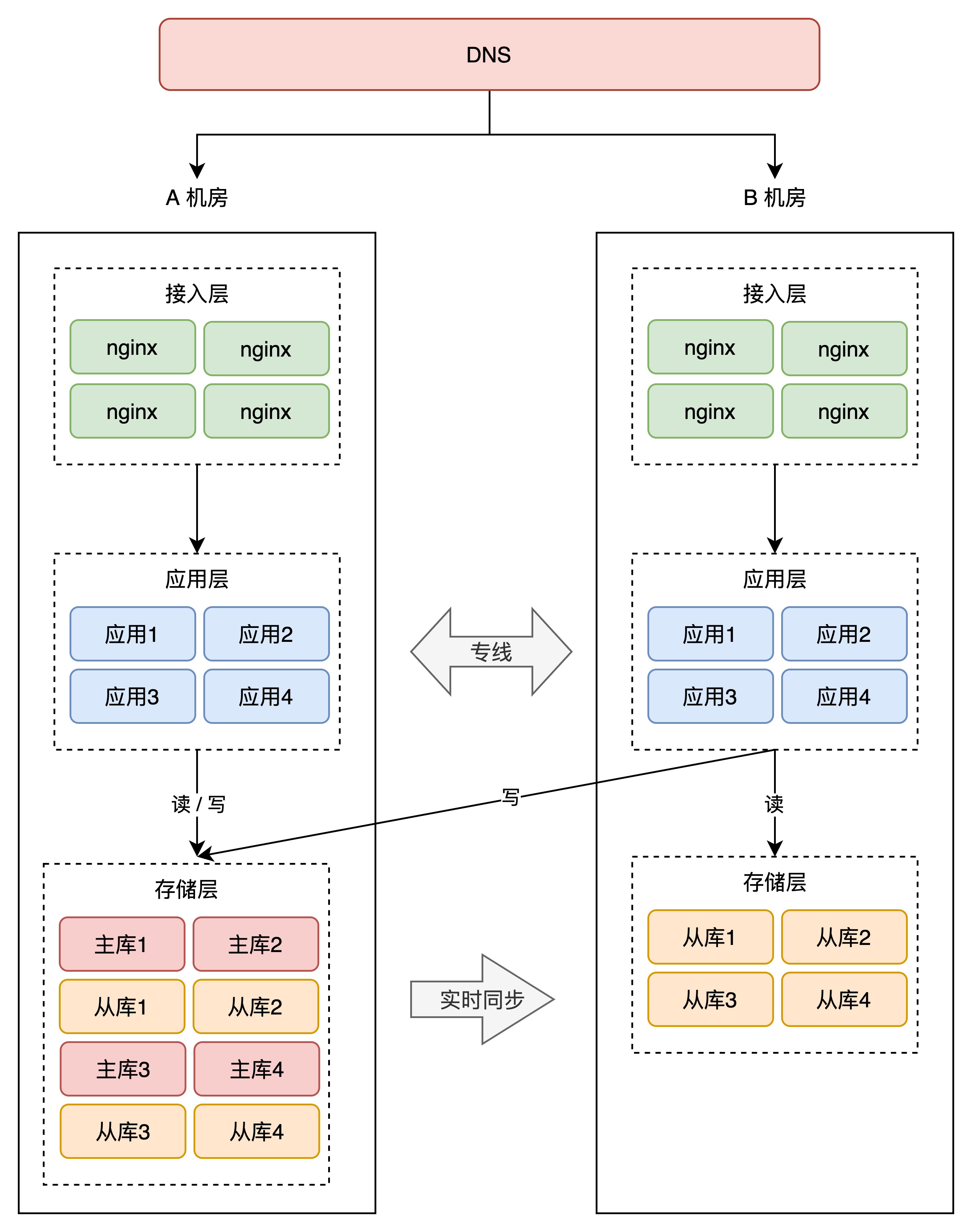

+到这里你会发现,B 机房从最开始的「空空如也」,演变到现在,几乎是「镜像」了一份 A 机房的所有东西,从最上层的接入层,到中间的业务应用,到最下层的存储。两个机房唯一的区别是,**A 机房的存储都是主库,而 B 机房都是从库**。

+

+这种方案,我们把它叫做「**热备**」。

+

+热的意思是指,B 机房处于「待命」状态,A 故障后 B 可以随时「接管」流量,继续提供服务。热备相比于冷备最大的优点是:**随时可切换**。

+

+无论是冷备还是热备,因为它们都处于「备用」状态,所以我们把这两个方案统称为:**同城灾备**。

+

+同城灾备的最大优势在于,我们再也不用担心「机房」级别的故障了,一个机房发生风险,我们只需把流量切换到另一个机房即可,可用性再次提高,是不是很爽?(后面还有更爽的)

+

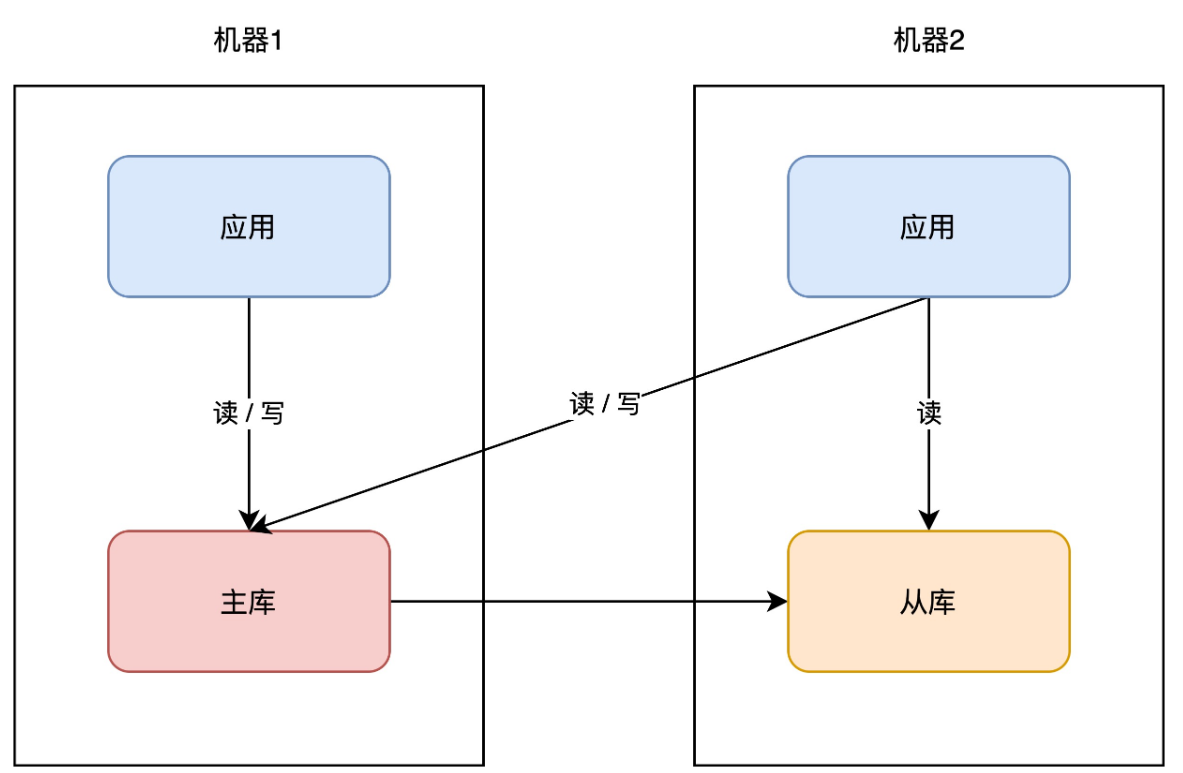

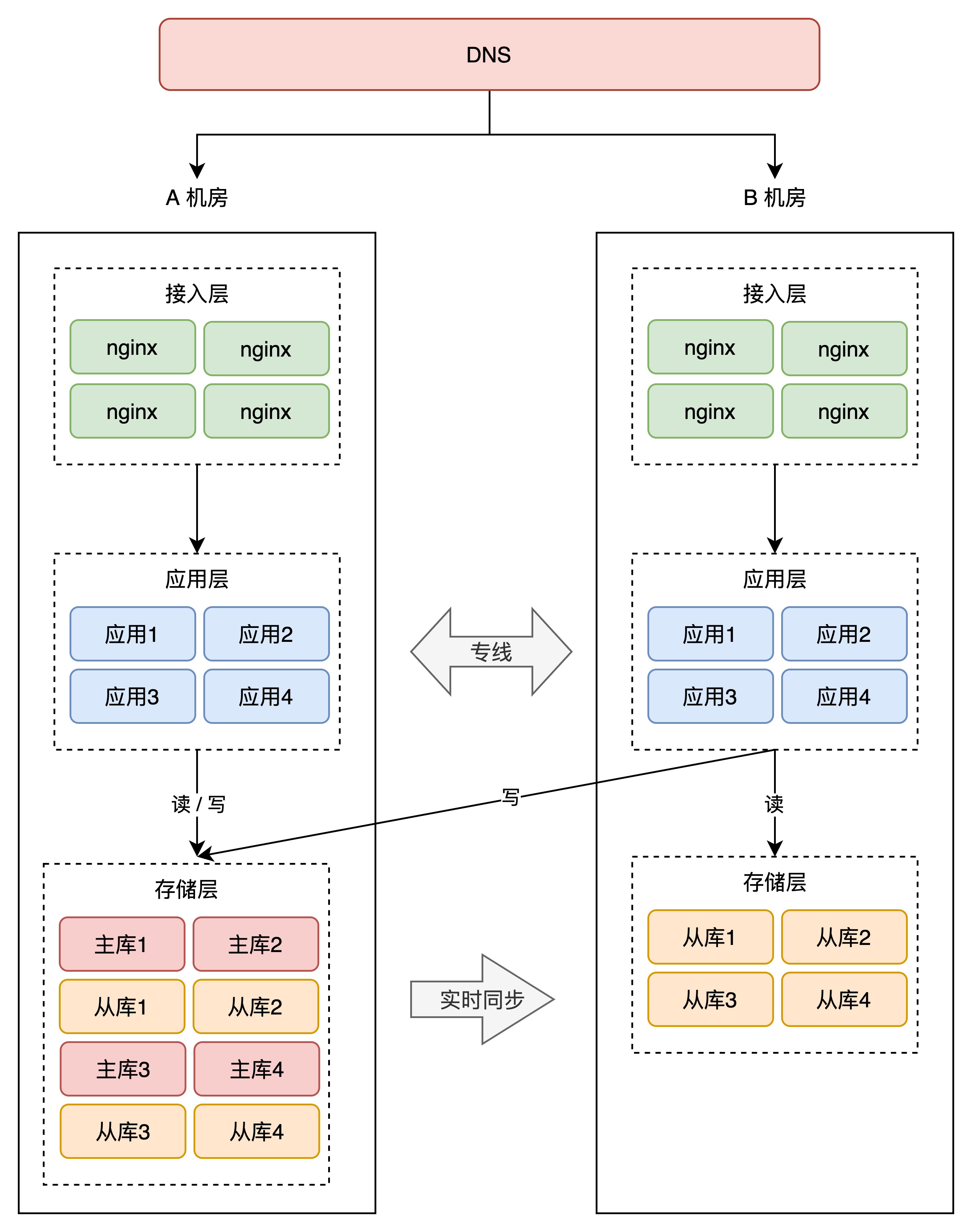

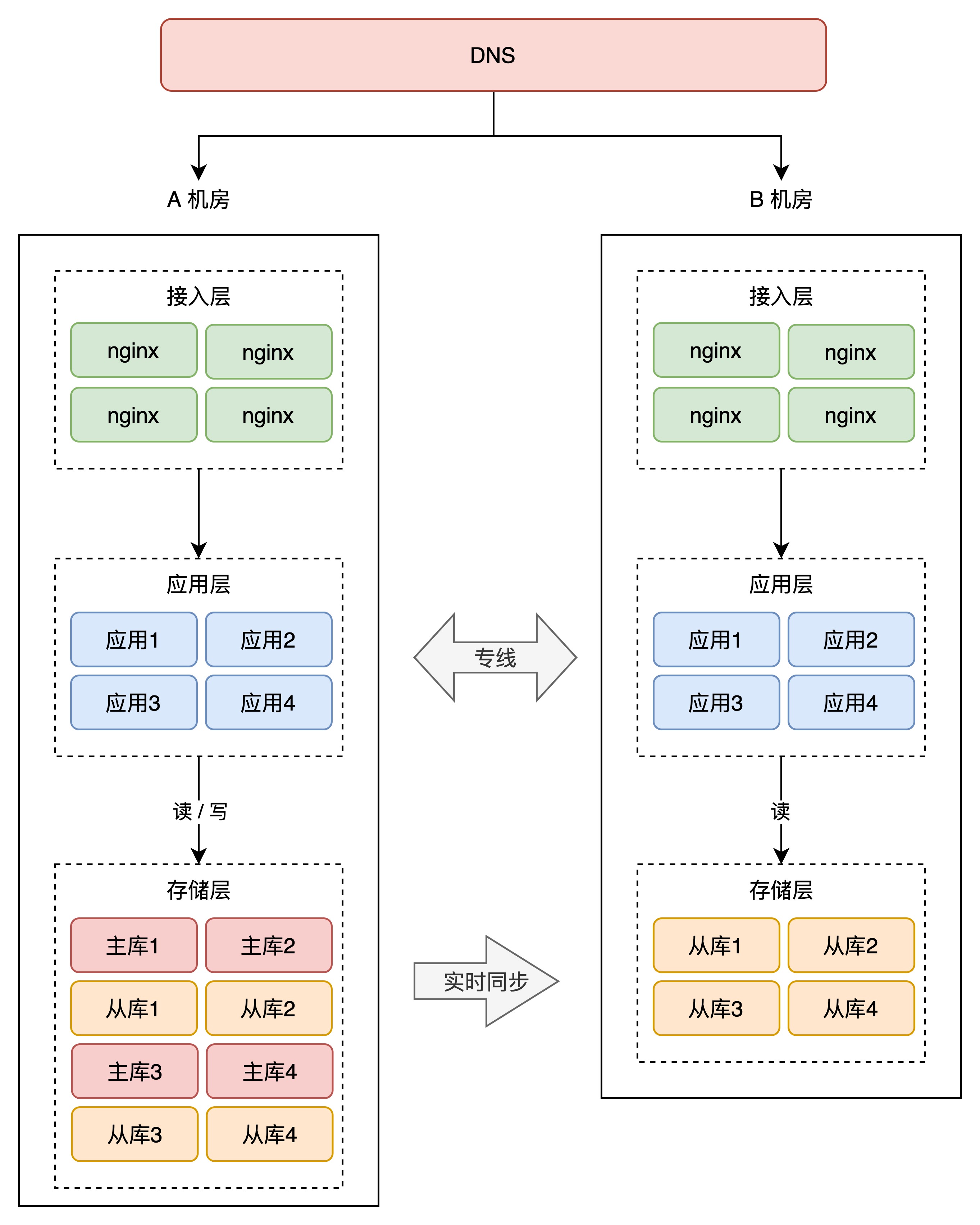

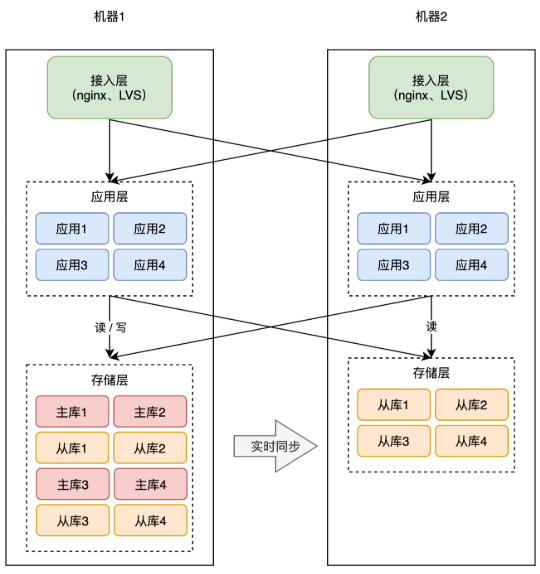

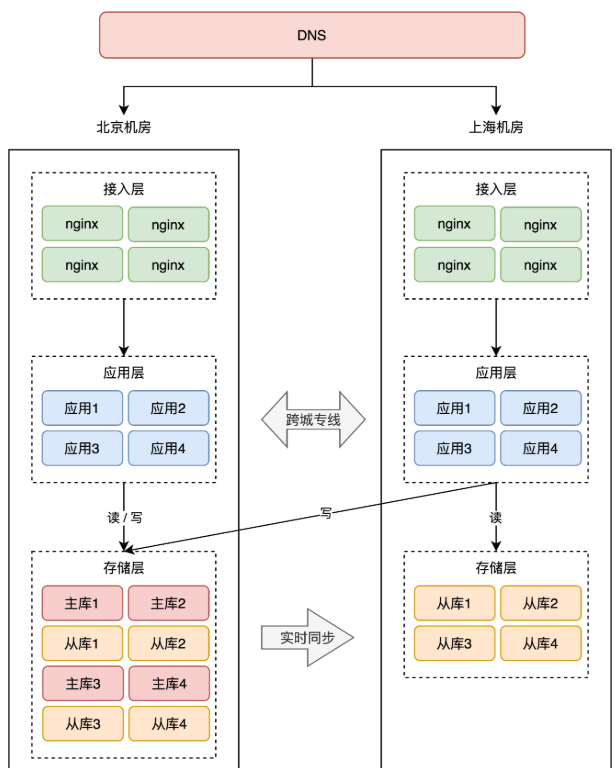

+# 06 同城双活

+

+我们继续来看这个架构。

+

+虽然我们有了应对机房故障的解决方案,但这里有个问题是我们不能忽视的:**A 机房挂掉,全部流量切到 B 机房,B 机房能否真的如我们所愿,正常提供服务?**

+

+这是个值得思考的问题。

+

+这就好比有两支军队 A 和 B,A 军队历经沙场,作战经验丰富,而 B 军队只是后备军,除了有军人的基本素养之外,并没有实战经验,战斗经验基本为 0。

+

+如果 A 军队丧失战斗能力,需要 B 军队立即顶上时,作为指挥官的你,肯定也会担心 B 军队能否真的担此重任吧?

+

+我们的架构也是如此,此时的 B 机房虽然是随时「待命」状态,但 A 机房真的发生故障,我们要把全部流量切到 B 机房,其实是不敢百分百保证它可以「如期」工作的。

+

+你想,我们在一个机房内部署服务,还总是发生各种各样的问题,例如:发布应用的版本不一致、系统资源不足、操作系统参数不一样等等。现在多部署一个机房,这些问题只会增多,不会减少。

+

+另外,从「成本」的角度来看,我们新部署一个机房,需要购买服务器、内存、硬盘、带宽资源,花费成本也是非常高昂的,只让它当一个后备军,未免也太「大材小用」了!

+

+因此,我们需要让 B 机房也接入流量,实时提供服务,这样做的好处,**一是可以实时训练这支后备军,让它达到与 A 机房相同的作战水平,随时可切换,二是 B 机房接入流量后,可以分担 A 机房的流量压力**。这才是把 B 机房资源优势,发挥最大化的最好方案!

+

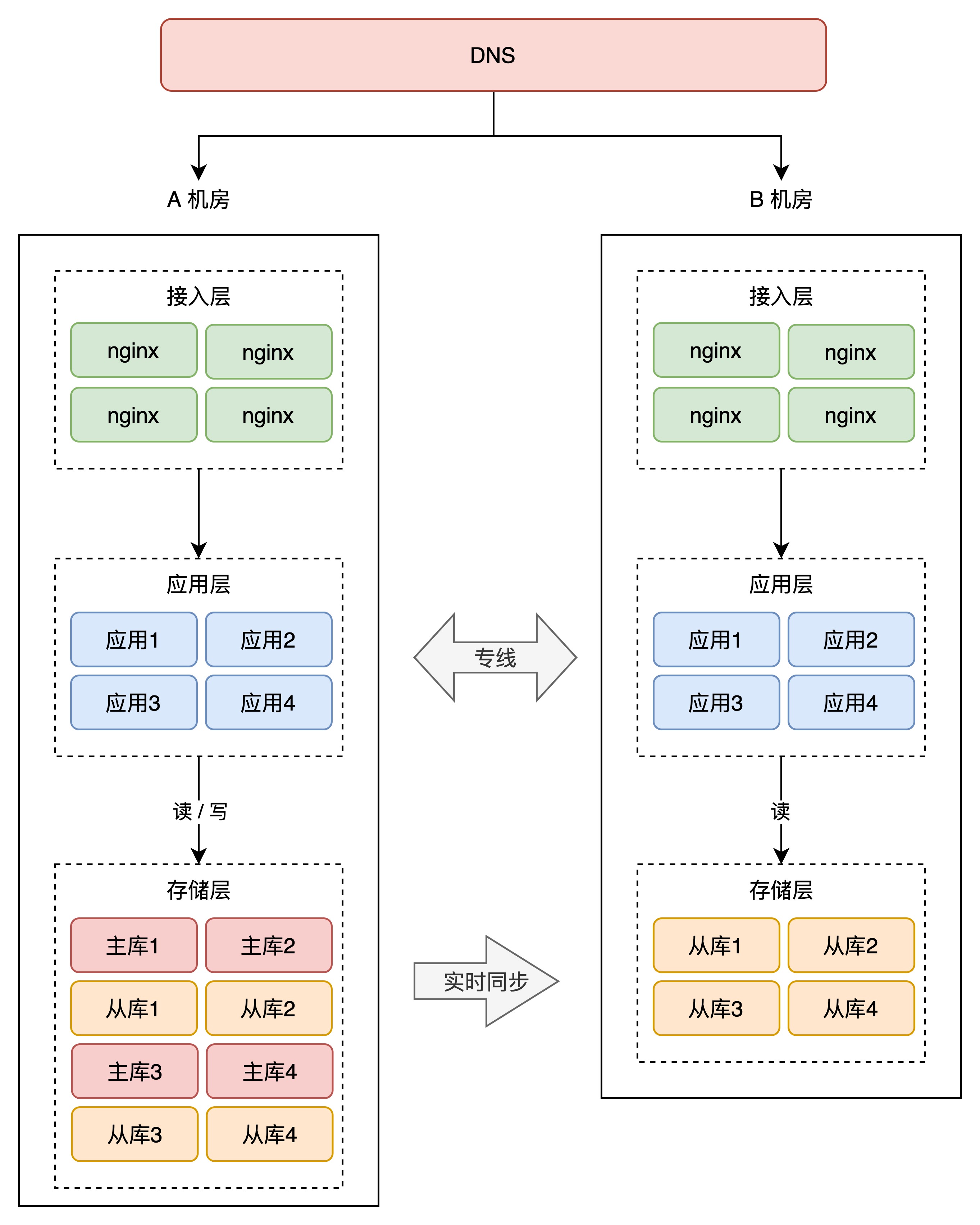

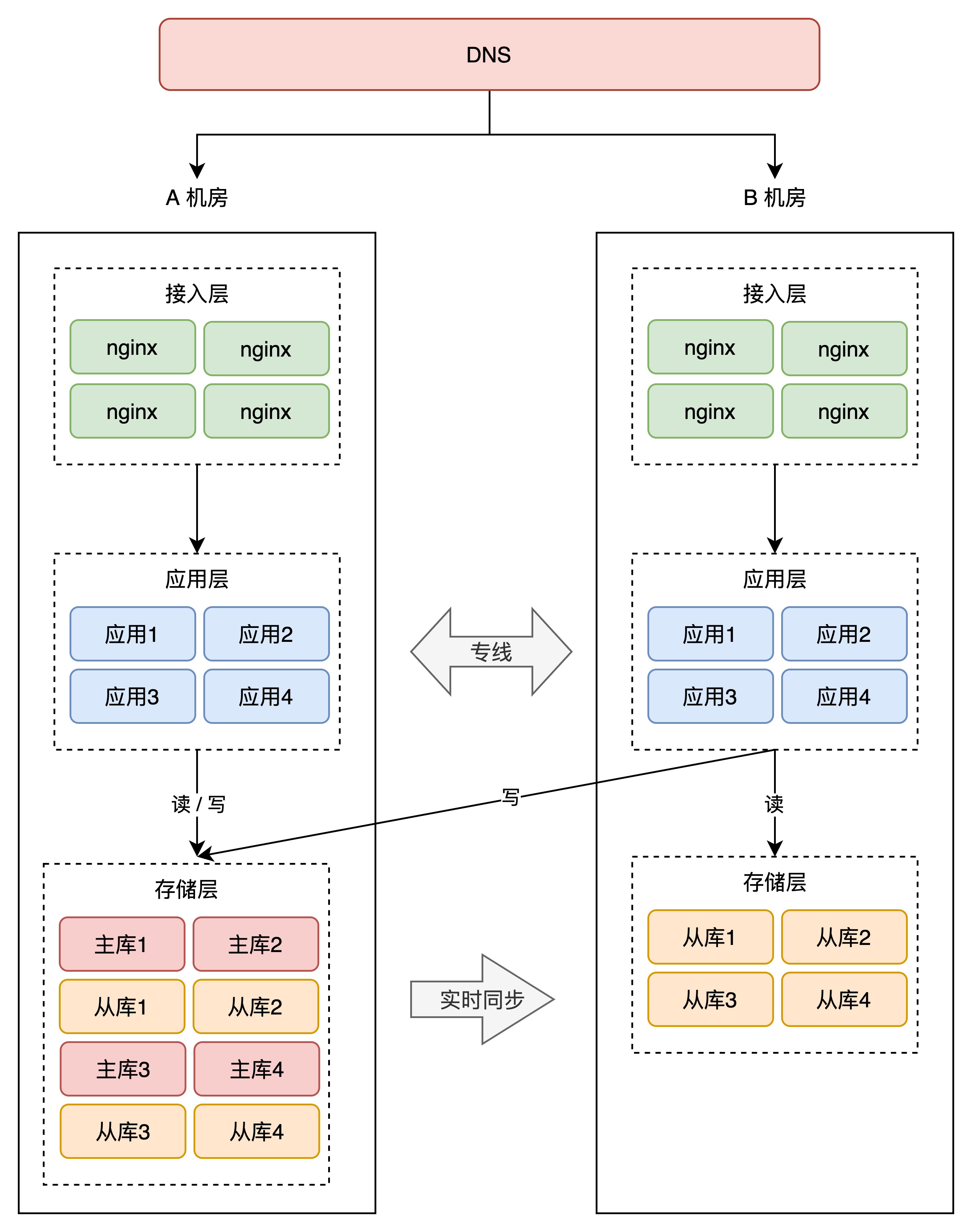

+那怎么让 B 机房也接入流量呢?很简单,就是把 B 机房的接入层 IP 地址,加入到 DNS 中,这样,B 机房从上层就可以有流量进来了。

+

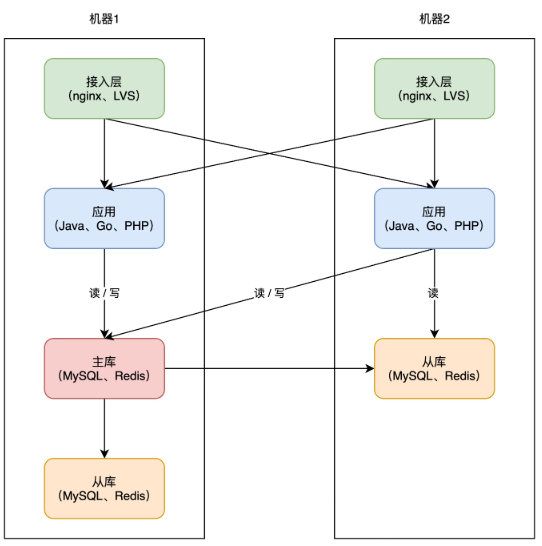

+

+

+但这里有一个问题:别忘了,B 机房的存储,现在可都是 A 机房的「从库」,从库默认可都是「不可写」的,B 机房的写请求打到本机房存储上,肯定会报错,这还是不符合我们预期。怎么办?

+

+这时,你就需要在「业务应用」层做改造了。

+

+你的业务应用在操作数据库时,需要区分「读写分离」(一般用中间件实现),即两个机房的「读」流量,可以读任意机房的存储,但「写」流量,只允许写 A 机房,因为主库在 A 机房。

+

+

+

+这会涉及到你用的所有存储,例如项目中用到了 MySQL、Redis、MongoDB 等等,操作这些数据库,都需要区分读写请求,所以这块需要一定的业务「改造」成本。

+

+因为 A 机房的存储都是主库,所以我们把 A 机房叫做「主机房」,B 机房叫「从机房」。

+

+两个机房部署在「同城」,物理距离比较近,而且两个机房用「专线」网络连接,虽然跨机房访问的延迟,比单个机房内要大一些,但整体的延迟还是可以接受的。

+

+业务改造完成后,B 机房可以慢慢接入流量,从 10%、30%、50% 逐渐覆盖到 100%,你可以持续观察 B 机房的业务是否存在问题,有问题及时修复,逐渐让 B 机房的工作能力,达到和 A 机房相同水平。

+

+现在,因为 B 机房实时接入了流量,此时如果 A 机房挂了,那我们就可以「大胆」地把 A 的流量,全部切换到 B 机房,完成快速切换!

+

+到这里你可以看到,我们部署的 B 机房,在物理上虽然与 A 有一定距离,但整个系统从「逻辑」上来看,我们是把这两个机房看做一个「整体」来规划的,也就是说,相当于把 2 个机房当作 1 个机房来用。

+

+这种架构方案,比前面的同城灾备更「进了一步」,B 机房实时接入了流量,还能应对随时的故障切换,这种方案我们把它叫做「**同城双活**」。

+

+因为两个机房都能处理业务请求,这对我们系统的内部维护、改造、升级提供了更多的可实施空间(流量随时切换),现在,整个系统的弹性也变大了,是不是更爽了?

+

+那这种架构有什么问题呢?

+

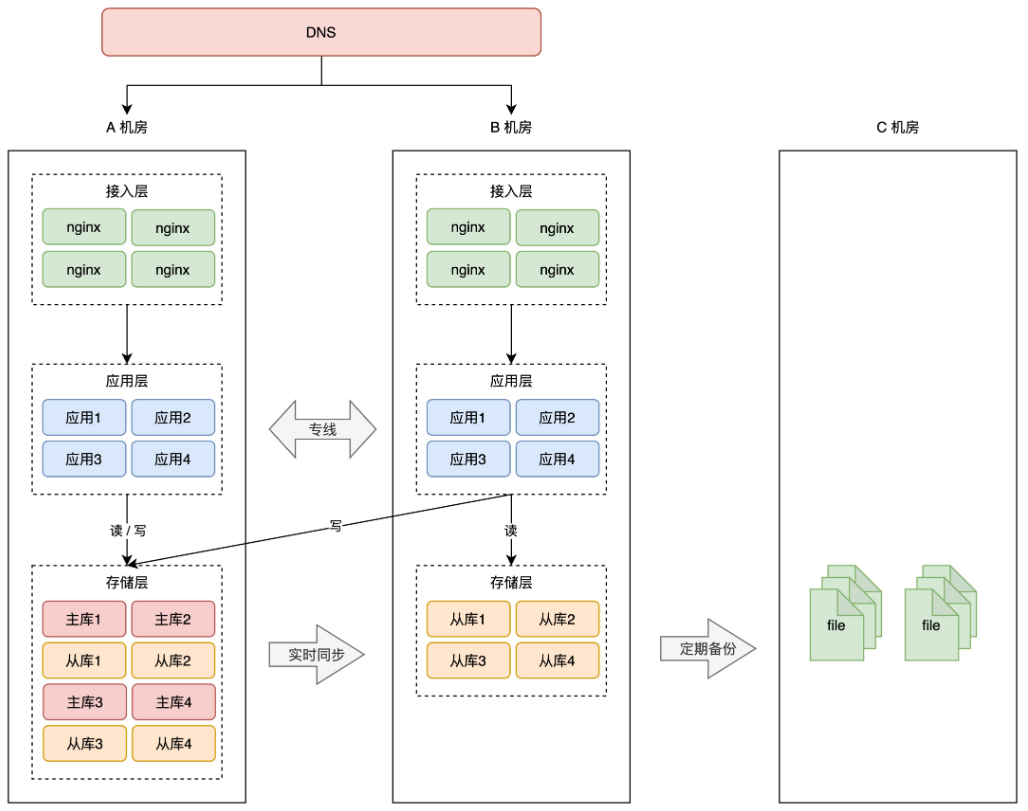

+# 07 两地三中心

+

+还是回到风险上来说。

+

+虽然我们把 2 个机房当做一个整体来规划,但这 2 个机房在物理层面上,还是处于「一个城市」内,如果是整个城市发生自然灾害,例如地震、水灾(河南水灾刚过去不久),那 2 个机房依旧存在「全局覆没」的风险。

+

+真是防不胜防啊?怎么办?没办法,继续冗余。

+

+但这次冗余机房,就不能部署在同一个城市了,你需要把它放到距离更远的地方,部署在「异地」。

+

+> 通常建议两个机房的距离要在 1000 公里以上,这样才能应对城市级别的灾难。

+

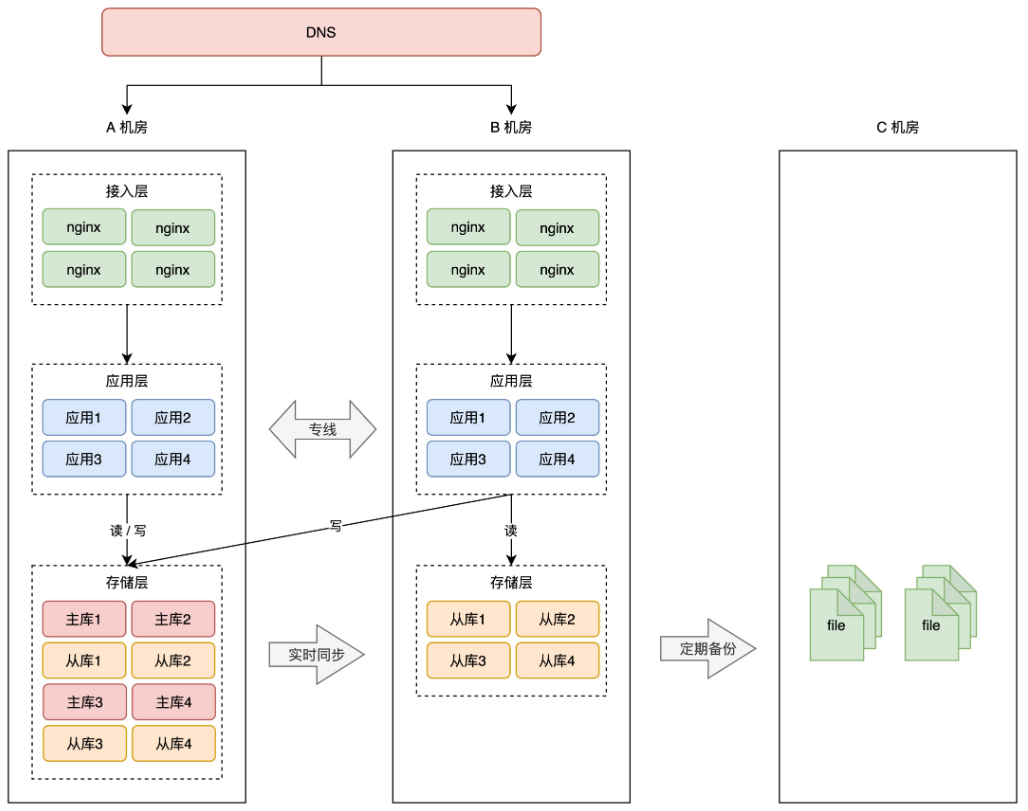

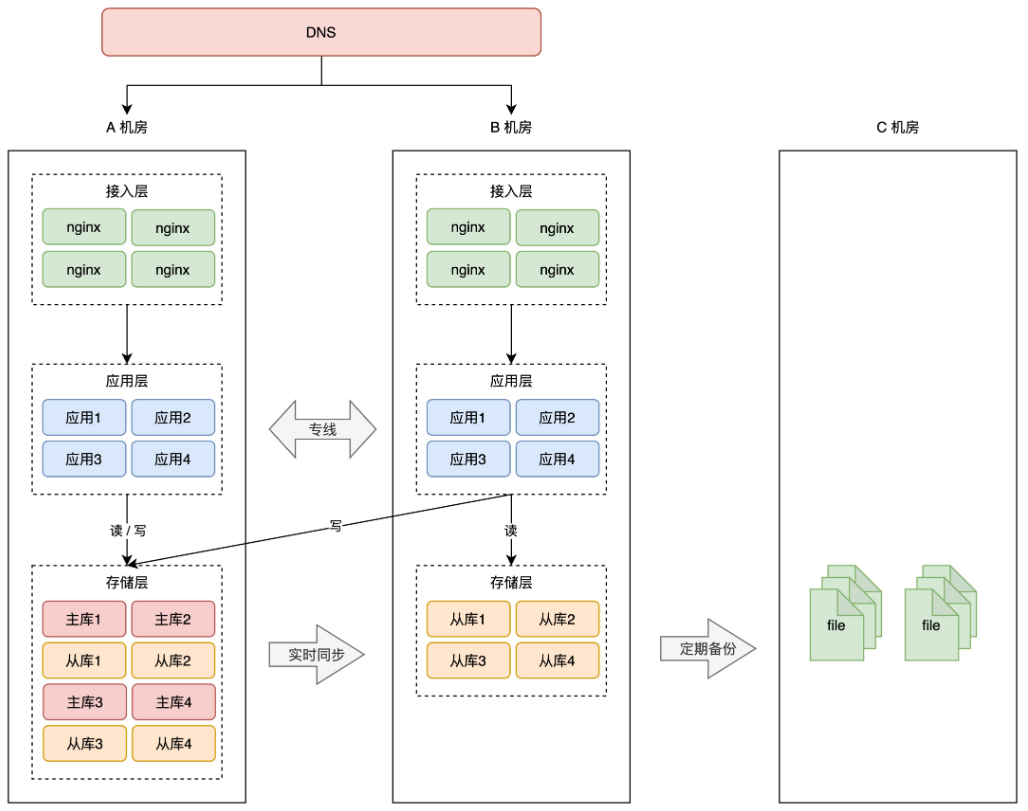

+假设之前的 A、B 机房在北京,那这次新部署的 C 机房可以放在上海。

+

+按照前面的思路,把 C 机房用起来,最简单粗暴的方案还就是做「冷备」,即定时把 A、B 机房的数据,在 C 机房做备份,防止数据丢失。

+

+

+

+这种方案,就是我们经常听到的「**两地三中心**」。

+

+**两地是指 2 个城市,三中心是指有 3 个机房,其中 2 个机房在同一个城市,并且同时提供服务,第 3 个机房部署在异地,只做数据灾备。**

+

+这种架构方案,通常用在银行、金融、政企相关的项目中。它的问题还是前面所说的,启用灾备机房需要时间,而且启用后的服务,不确定能否如期工作。

+

+所以,要想真正的抵御城市级别的故障,越来越多的互联网公司,开始实施「**异地双活**」。

+

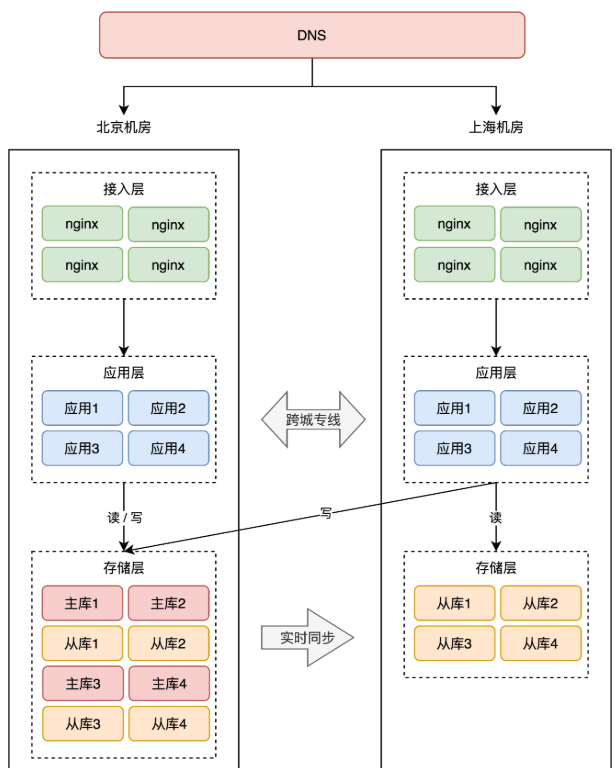

+# 08 伪异地双活

+

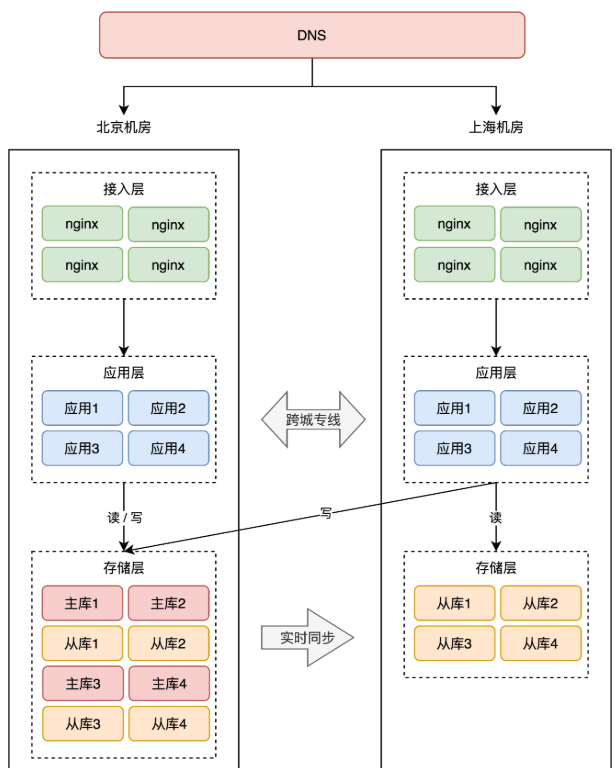

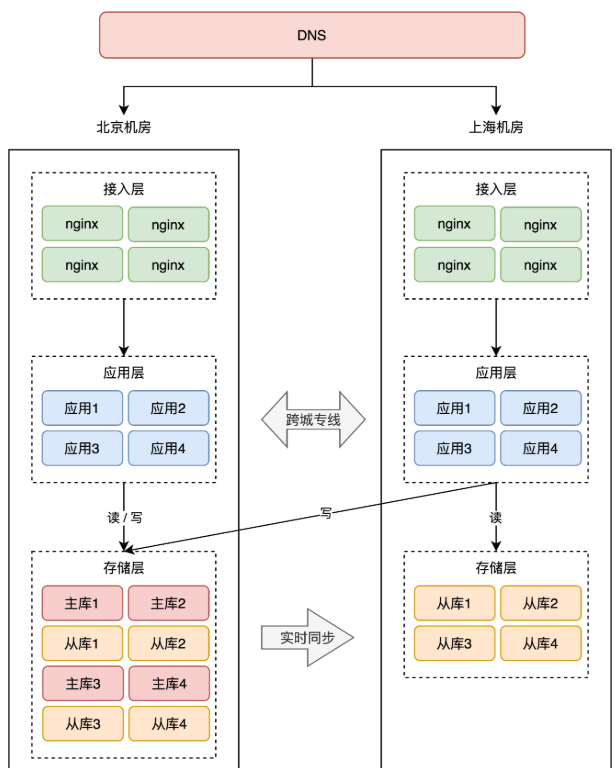

+这里,我们还是分析 2 个机房的架构情况。我们不再把 A、B 机房部署在同一个城市,而是分开部署,例如 A 机房放在北京,B 机房放在上海。

+

+前面我们讲了同城双活,那异地双活是不是直接「照搬」同城双活的模式去部署就可以了呢?

+

+事情没你想的那么简单。

+

+如果还是按照同城双活的架构来部署,那异地双活的架构就是这样的:

+

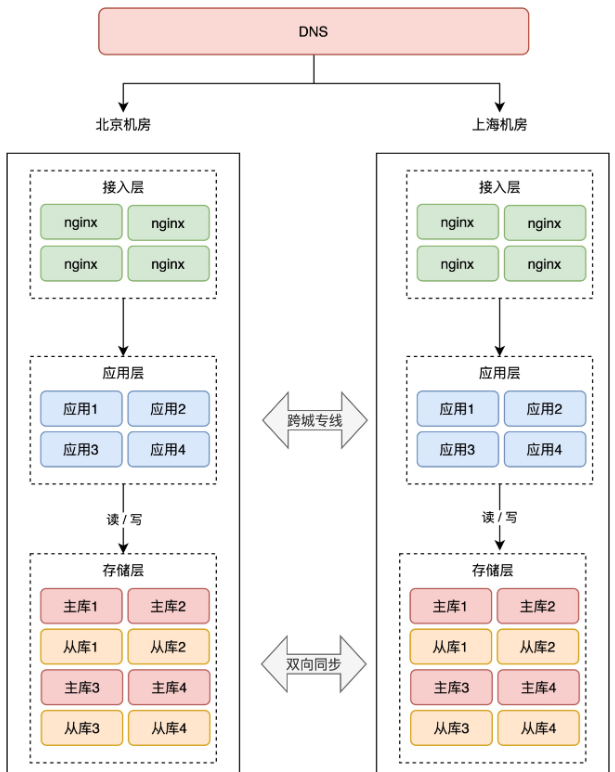

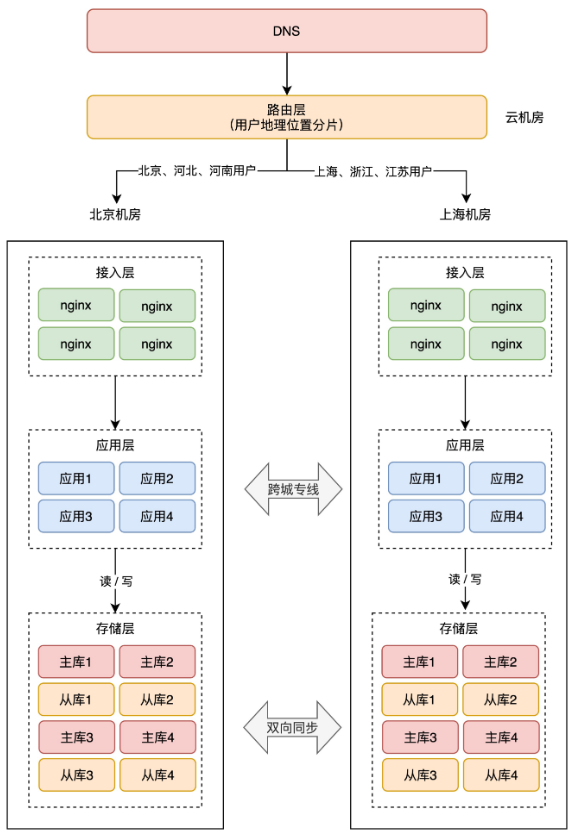

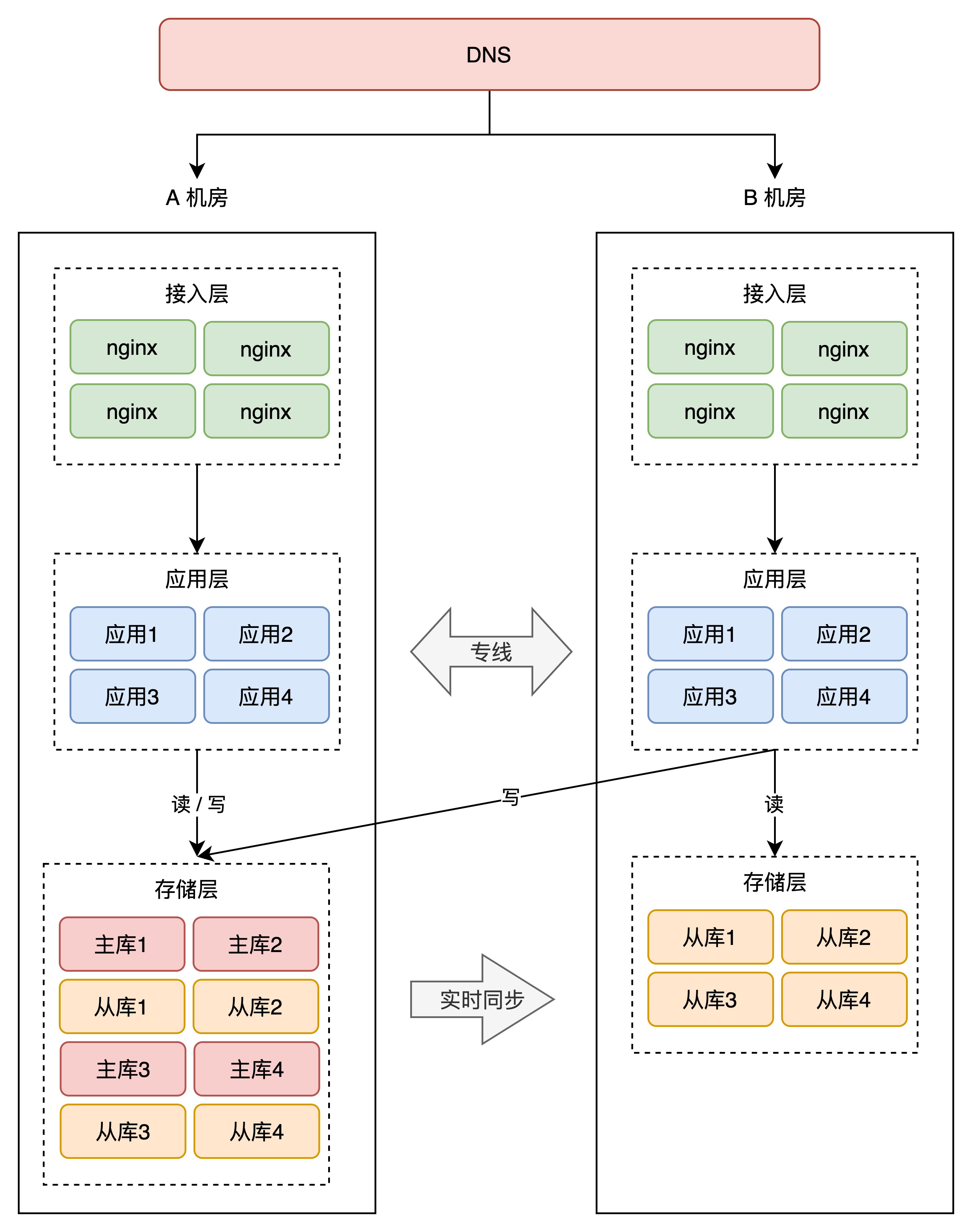

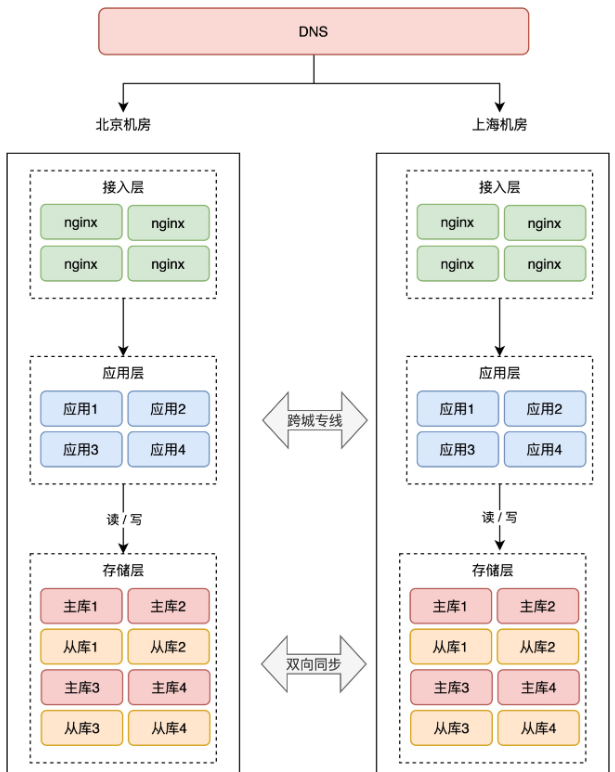

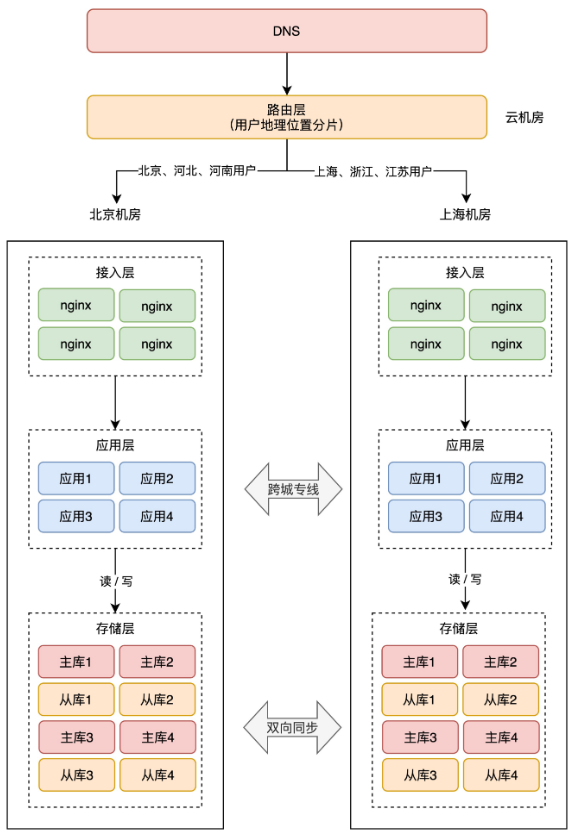

+

+

+注意看,两个机房的网络是通过「跨城专线」连通的。

+

+此时两个机房都接入流量,那上海机房的请求,可能要去读写北京机房的存储,这里存在一个很大的问题:**网络延迟**。

+

+因为两个机房距离较远,受到物理距离的限制,现在,两地之间的网络延迟就变成了「**不可忽视**」的因素了。

+

+北京到上海的距离大约 1300 公里,即使架设一条高速的「网络专线」,光纤以光速传输,一个来回也需要近 10ms 的延迟。

+

+况且,网络线路之间还会经历各种路由器、交换机等网络设备,实际延迟可能会达到 30ms ~ 100ms,如果网络发生抖动,延迟甚至会达到 1 秒。

+

+> 不止是延迟,远距离的网络专线质量,是远远达不到机房内网络质量的,专线网络经常会发生延迟、丢包、甚至中断的情况。总之,不能过度信任和依赖「跨城专线」。

+

+你可能会问,这点延迟对业务影响很大吗?影响非常大!

+

+试想,一个客户端请求打到上海机房,上海机房要去读写北京机房的存储,一次跨机房访问延迟就达到了 30ms,这大致是机房内网网络(0.5 ms)访问速度的 60 倍(30ms / 0.5ms),一次请求慢 60 倍,来回往返就要慢 100 倍以上。

+

+而我们在 App 打开一个页面,可能会访问后端几十个 API,每次都跨机房访问,整个页面的响应延迟有可能就达到了**秒级**,这个性能简直惨不忍睹,难以接受。

+

+看到了么,虽然我们只是简单的把机房部署在了「异地」,但「同城双活」的架构模型,在这里就不适用了,还是按照这种方式部署,这是「伪异地双活」!

+

+那如何做到真正的异地双活呢?

+

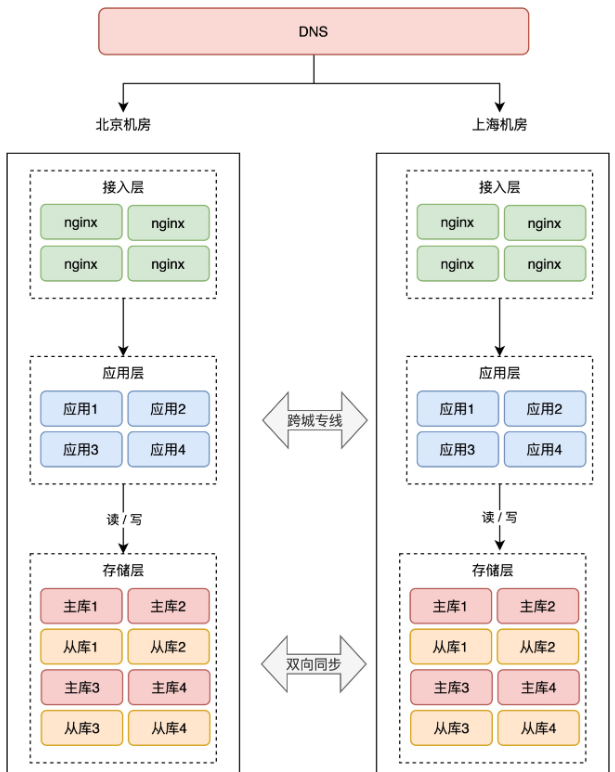

+# 09 真正的异地双活

+

+既然「跨机房」调用延迟是不容忽视的因素,那我们只能尽量避免跨机房「调用」,规避这个延迟问题。

+

+也就是说,上海机房的应用,不能再「跨机房」去读写北京机房的存储,只允许读写上海本地的存储,实现「就近访问」,这样才能避免延迟问题。

+

+还是之前提到的问题:上海机房存储都是从库,不允许写入啊,除非我们只允许上海机房接入「读流量」,不接收「写流量」,否则无法满足不再跨机房的要求。

+

+很显然,只让上海机房接收读流量的方案不现实,因为很少有项目是只有读流量,没有写流量的。所以这种方案还是不行,这怎么办?

+

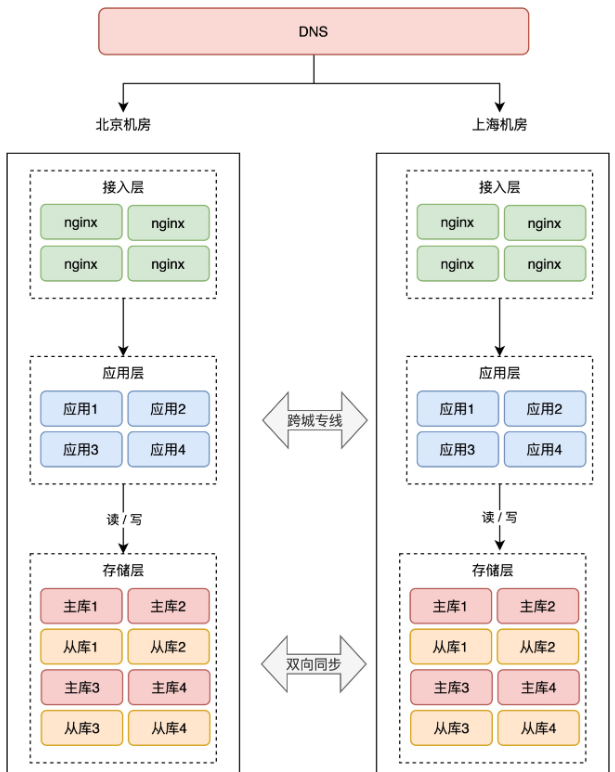

+此时,你就必须在「**存储层**」做改造了。

+

+要想上海机房读写本机房的存储,那上海机房的存储不能再是北京机房的从库,而是也要变为「主库」。

+

+你没看错,两个机房的存储必须都是「**主库**」,而且两个机房的数据还要「**互相同步**」数据,即客户端无论写哪一个机房,都能把这条数据同步到另一个机房。

+

+因为只有两个机房都拥有「全量数据」,才能支持任意切换机房,持续提供服务。

+

+怎么实现这种「双主」架构呢?它们之间如何互相同步数据?

+

+如果你对 MySQL 有所了解,MySQL 本身就提供了双主架构,它支持双向复制数据,但平时用的并不多。而且 Redis、MongoDB 等数据库并没有提供这个功能,所以,你必须开发对应的「数据同步中间件」来实现双向同步的功能。

+

+此外,除了数据库这种有状态的软件之外,你的项目通常还会使用到消息队列,例如 RabbitMQ、Kafka,这些也是有状态的服务,所以它们也需要开发双向同步的中间件,支持任意机房写入数据,同步至另一个机房。

+

+看到了么,这一下子复杂度就上来了,单单针对每个数据库、队列开发同步中间件,就需要投入很大精力了。

+

+> 业界也开源出了很多数据同步中间件,例如阿里的 Canal、RedisShake、MongoShake,可分别在两个机房同步 MySQL、Redis、MongoDB 数据。

+>

+> 很多有能力的公司,也会采用自研同步中间件的方式来做,例如饿了么、携程、美团都开发了自己的同步中间件。

+>

+> 我也有幸参与设计开发了 MySQL、Redis/Codis、MongoDB 的同步中间件,有时间写一篇文章详细聊聊实现细节,欢迎持续关注。:)

+

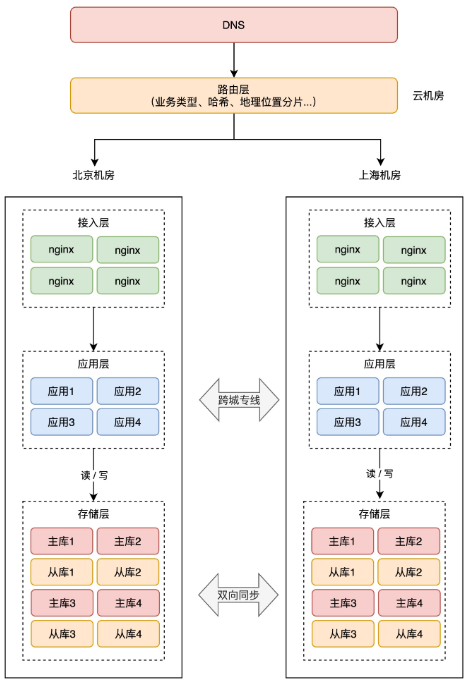

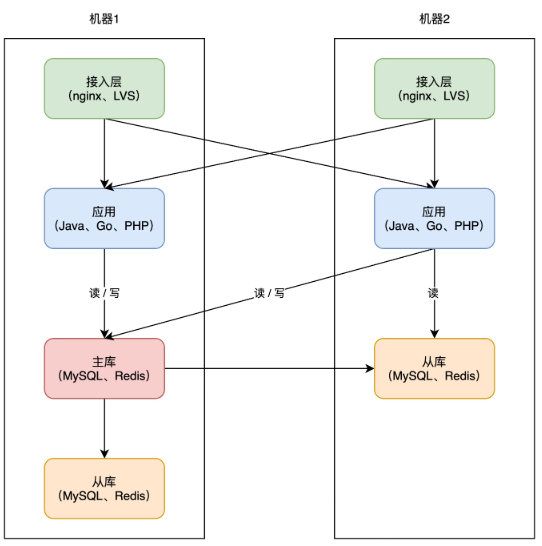

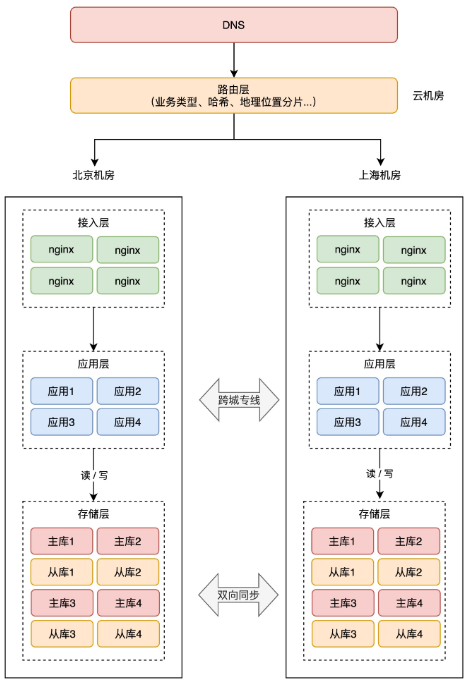

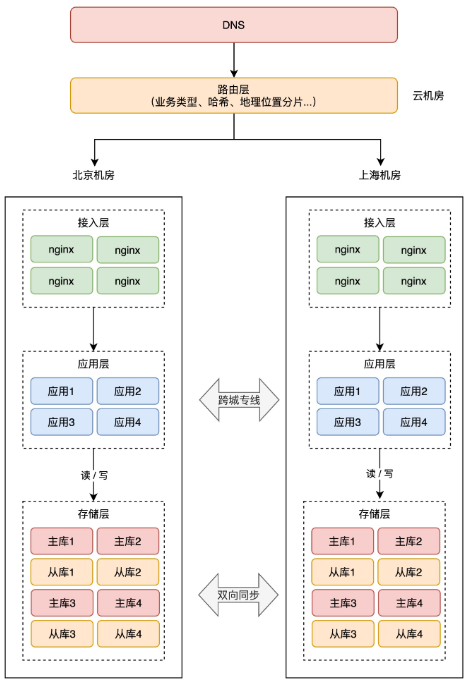

+现在,整个架构就变成了这样:

+

+

+

+注意看,两个机房的存储层都互相同步数据的。有了数据同步中间件,就可以达到这样的效果:

+

+- 北京机房写入 X = 1

+- 上海机房写入 Y = 2

+- 数据通过中间件双向同步

+- 北京、上海机房都有 X = 1、Y = 2 的数据

+

+这里我们用中间件双向同步数据,就不用再担心专线问题,专线出问题,我们的中间件可以自动重试,直到成功,达到数据最终一致。

+

+但这里还会遇到一个问题,两个机房都可以写,操作的不是同一条数据那还好,如果修改的是同一条的数据,发生冲突怎么办?

+

+- 用户短时间内发了 2 个修改请求,都是修改同一条数据

+- 一个请求落在北京机房,修改 X = 1(还未同步到上海机房)

+- 另一个请求落在上海机房,修改 X = 2(还未同步到北京机房)

+- 两个机房以哪个为准?

+

+也就是说,在很短的时间内,同一个用户修改同一条数据,两个机房无法确认谁先谁后,数据发生「冲突」。

+

+这是一个很严重的问题,系统发生故障并不可怕,可怕的是数据发生「错误」,因为修正数据的成本太高了。我们一定要避免这种情况的发生。解决这个问题,有 2 个方案。

+

+**第一个方案**,数据同步中间件要有自动「合并」数据、解决「冲突」的能力。

+

+这个方案实现起来比较复杂,要想合并数据,就必须要区分出「先后」顺序。我们很容易想到的方案,就是以「时间」为标尺,以「后到达」的请求为准。

+

+但这种方案需要两个机房的「时钟」严格保持一致才行,否则很容易出现问题。例如:

+

+- 第 1 个请求落到北京机房,北京机房时钟是 10:01,修改 X = 1

+- 第 2 个请求落到上海机房,上海机房时钟是 10:00,修改 X = 2

+

+因为北京机房的时间「更晚」,那最终结果就会是 X = 1。但这里其实应该以第 2 个请求为准,X = 2 才对。

+

+可见,完全「依赖」时钟的冲突解决方案,不太严谨。

+

+所以,通常会采用第二种方案,从「源头」就避免数据冲突的发生。

+

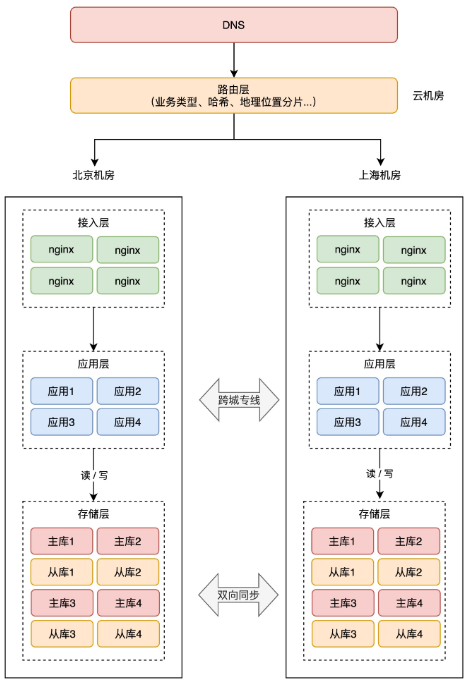

+# 10 如何实施异地双活

+

+既然自动合并数据的方案实现成本高,那我们就要想,能否从源头就「避免」数据冲突呢?

+

+这个思路非常棒!

+

+从源头避免数据冲突的思路是:**在最上层接入流量时,就不要让冲突的情况发生**。

+

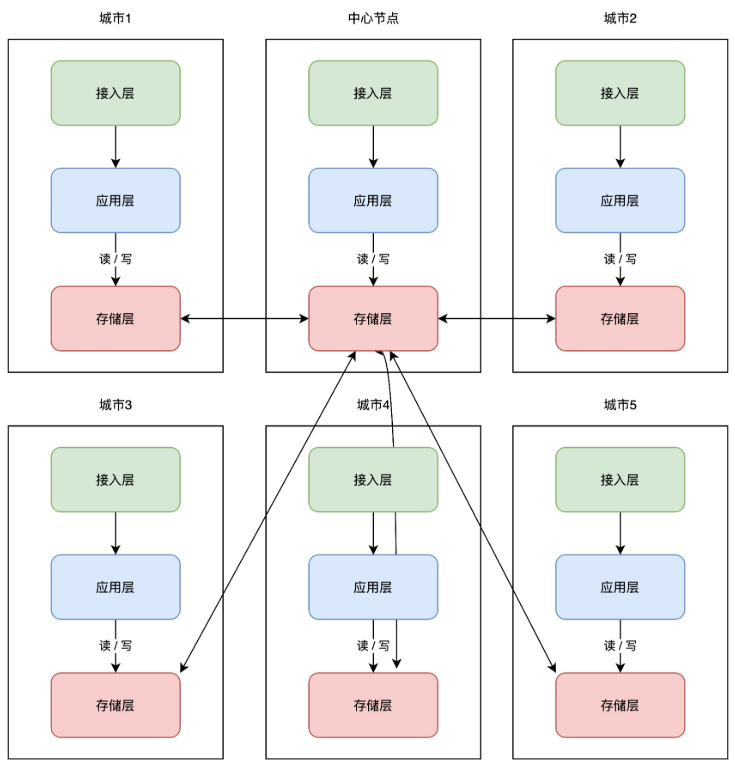

+具体来讲就是,要在最上层就把用户「区分」开,部分用户请求固定打到北京机房,其它用户请求固定打到上海 机房,进入某个机房的用户请求,之后的所有业务操作,都在这一个机房内完成,从根源上避免「跨机房」。

+

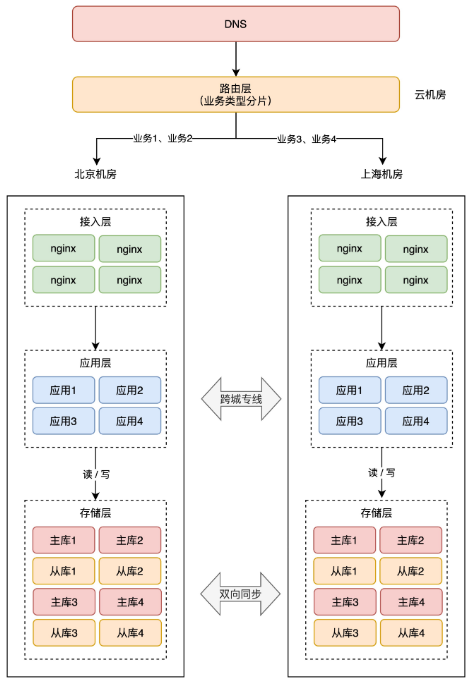

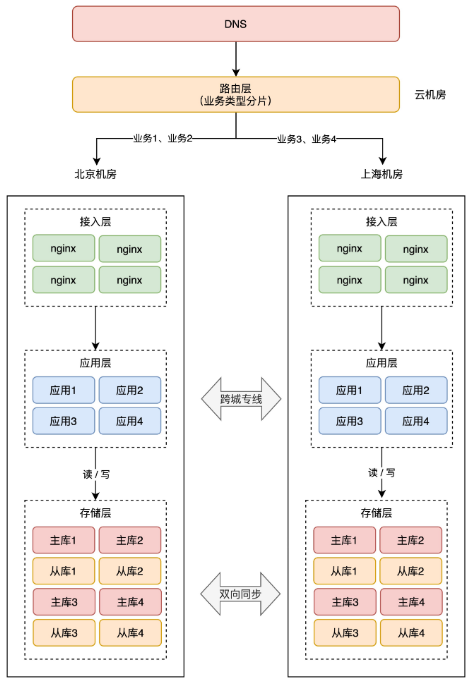

+所以这时,你需要在接入层之上,再部署一个「路由层」(通常部署在云服务器上),自己可以配置路由规则,把用户「分流」到不同的机房内。

+

+

+

+但这个路由规则,具体怎么定呢?有很多种实现方式,最常见的我总结了 3 类:

+

+1. 按业务类型分片

+2. 直接哈希分片

+3. 按地理位置分片

+

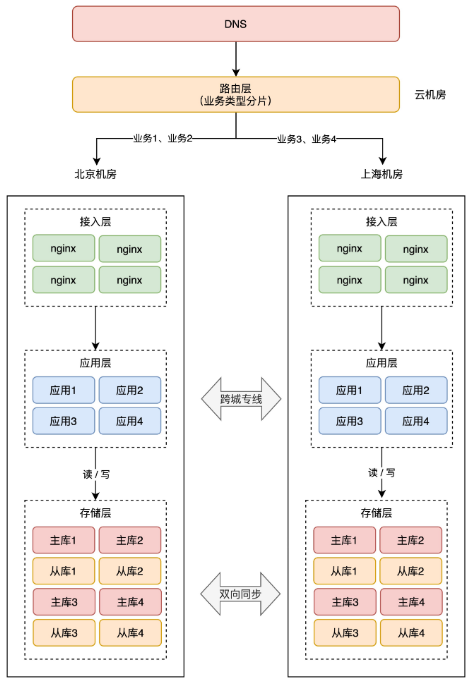

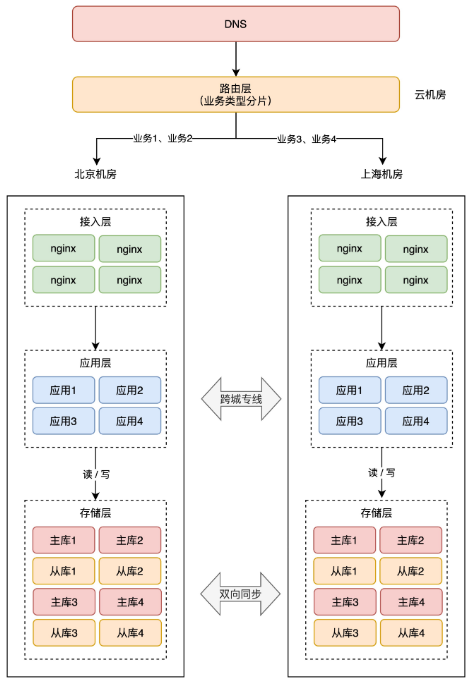

+**1、按业务类型分片**

+

+这种方案是指,按应用的「业务类型」来划分。

+

+举例:假设我们一共有 4 个应用,北京和上海机房都部署这些应用。但应用 1、2 只在北京机房接入流量,在上海机房只是热备。应用 3、4 只在上海机房接入流量,在北京机房是热备。

+

+这样一来,应用 1、2 的所有业务请求,只读写北京机房存储,应用 3、4 的所有请求,只会读写上海机房存储。

+

+

+

+这样按业务类型分片,也可以避免同一个用户修改同一条数据。

+

+> 这里按业务类型在不同机房接入流量,还需要考虑多个应用之间的依赖关系,要尽可能的把完成「相关」业务的应用部署在同一个机房,避免跨机房调用。

+>

+> 例如,订单、支付服务有依赖关系,会产生互相调用,那这 2 个服务在 A 机房接入流量。社区、发帖服务有依赖关系,那这 2 个服务在 B 机房接入流量。

+

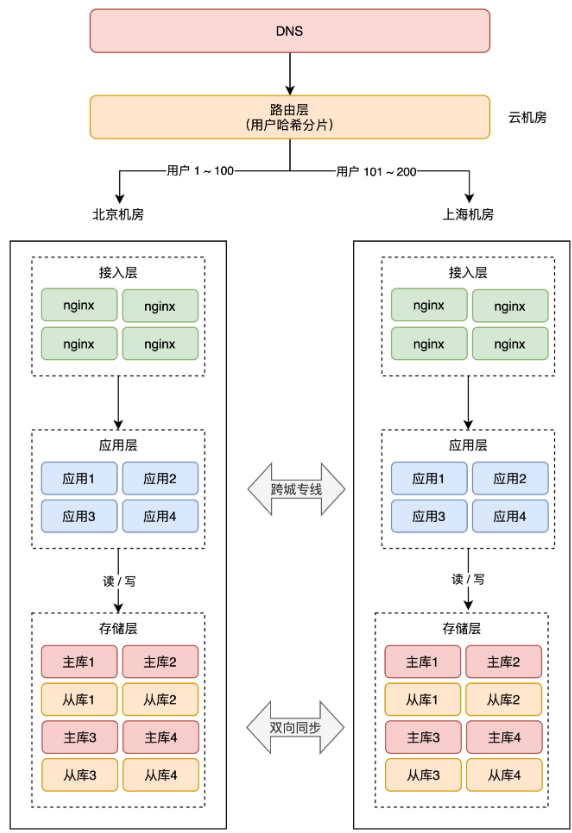

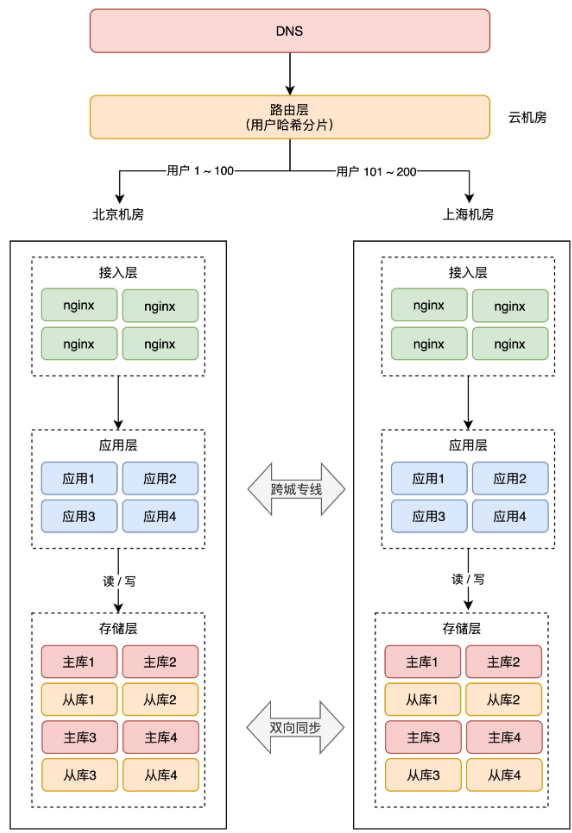

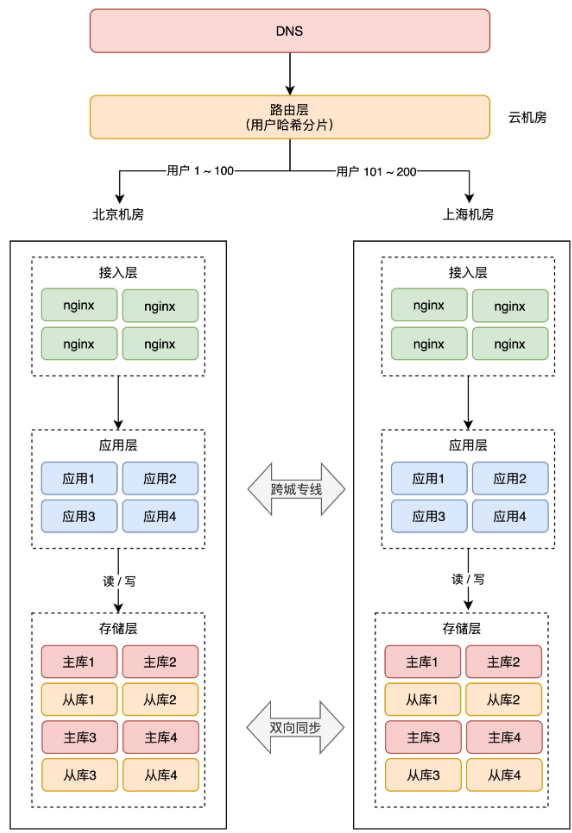

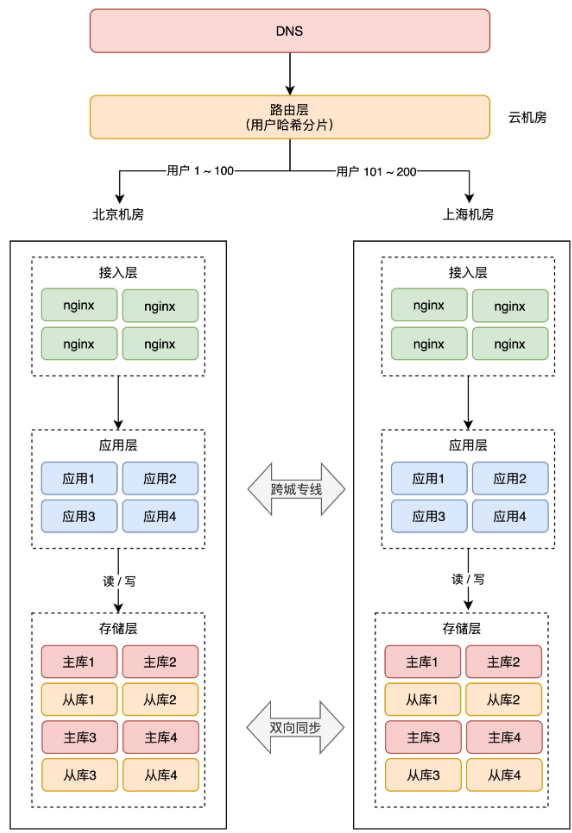

+**2、直接哈希分片**

+

+这种方案就是,最上层的路由层,会根据用户 ID 计算「哈希」取模,然后从路由表中找到对应的机房,之后把请求转发到指定机房内。

+

+举例:一共 200 个用户,根据用户 ID 计算哈希值,然后根据路由规则,把用户 1 - 100 路由到北京机房,101 - 200 用户路由到上海机房,这样,就避免了同一个用户修改同一条数据的情况发生。

+

+

+

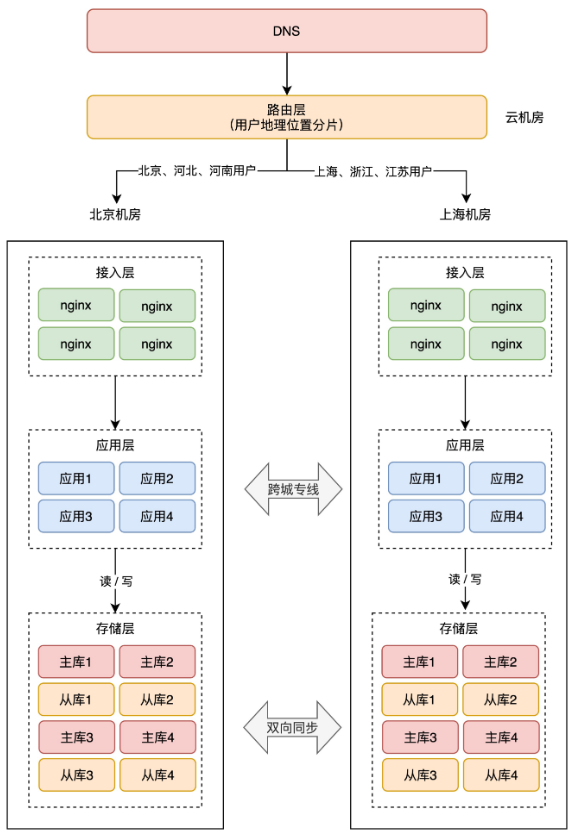

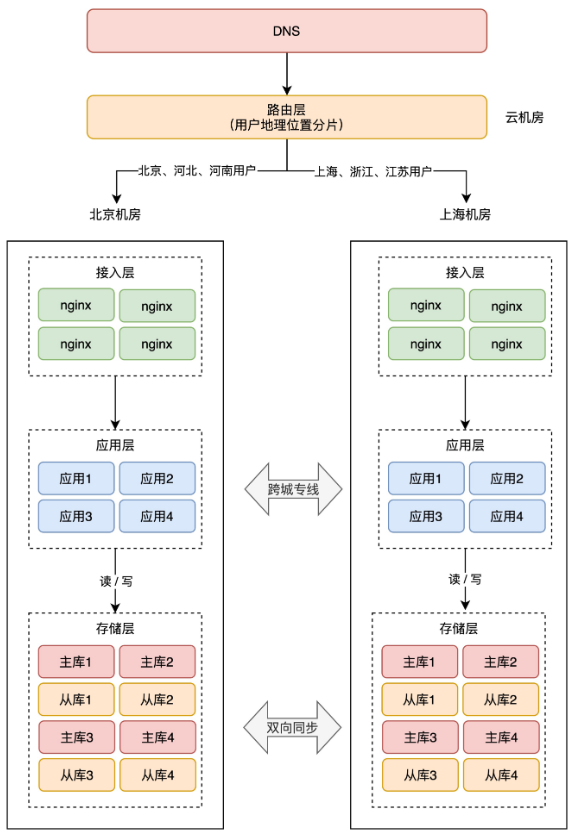

+**3、按地理位置分片**

+

+这种方案,非常适合与地理位置密切相关的业务,例如打车、外卖服务就非常适合这种方案。

+

+拿外卖服务举例,你要点外卖肯定是「就近」点餐,整个业务范围相关的有商家、用户、骑手,它们都是在相同的地理位置内的。

+

+针对这种特征,就可以在最上层,按用户的「地理位置」来做分片,分散到不同的机房。

+

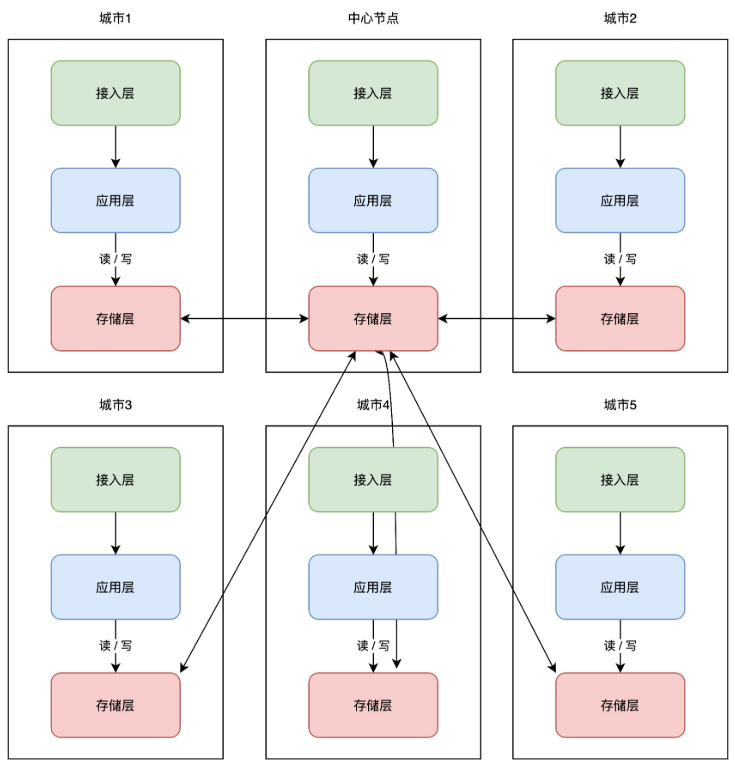

+举例:北京、河北地区的用户点餐,请求只会打到北京机房,而上海、浙江地区的用户,请求则只会打到上海机房。这样的分片规则,也能避免数据冲突。

+

+

+

+> 提醒:这 3 种常见的分片规则,第一次看不太好理解,建议配合图多理解几遍。搞懂这 3 个分片规则,你才能真正明白怎么做异地多活。

+

+总之,分片的核心思路在于,**让同一个用户的相关请求,只在一个机房内完成所有业务「闭环」,不再出现「跨机房」访问**。

+

+阿里在实施这种方案时,给它起了个名字,叫做「**单元化**」。

+

+> 当然,最上层的路由层把用户分片后,理论来说同一个用户只会落在同一个机房内,但不排除程序 Bug 导致用户会在两个机房「漂移」。

+>

+> 安全起见,每个机房在写存储时,还需要有一套机制,能够检测「数据归属」,应用层操作存储时,需要通过中间件来做「兜底」,避免不该写本机房的情况发生。(篇幅限制,这里不展开讲,理解思路即可)

+

+现在,两个机房就可以都接收「读写」流量(做好分片的请求),底层存储保持「双向」同步,两个机房都拥有全量数据,当任意机房故障时,另一个机房就可以「接管」全部流量,实现快速切换,简直不要太爽。

+

+不仅如此,因为机房部署在异地,我们还可以更细化地「优化」路由规则,让用户访问就近的机房,这样整个系统的性能也会大大提升。

+

+> 这里还有一种情况,是无法做数据分片的:**全局数据**。例如系统配置、商品库存这类需要强一致的数据,这类服务依旧只能采用写主机房,读从机房的方案,不做双活。

+>

+> 双活的重点,是要优先保证「核心」业务先实现双活,并不是「全部」业务实现双活。

+

+至此,我们才算实现了真正的「**异地双活**」!

+

+> 到这里你可以看出,完成这样一套架构,需要投入的成本是巨大的。

+>

+> 路由规则、路由转发、数据同步中间件、数据校验兜底策略,不仅需要开发强大的中间件,同时还要业务配合改造(业务边界划分、依赖拆分)等一些列工作,没有足够的人力物力,这套架构很难实施。

+

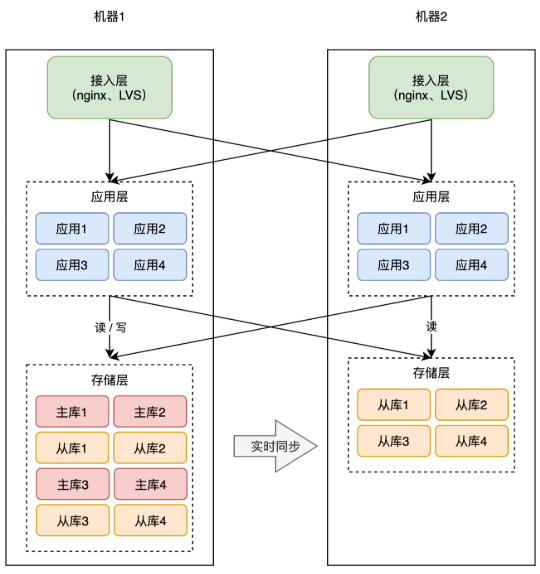

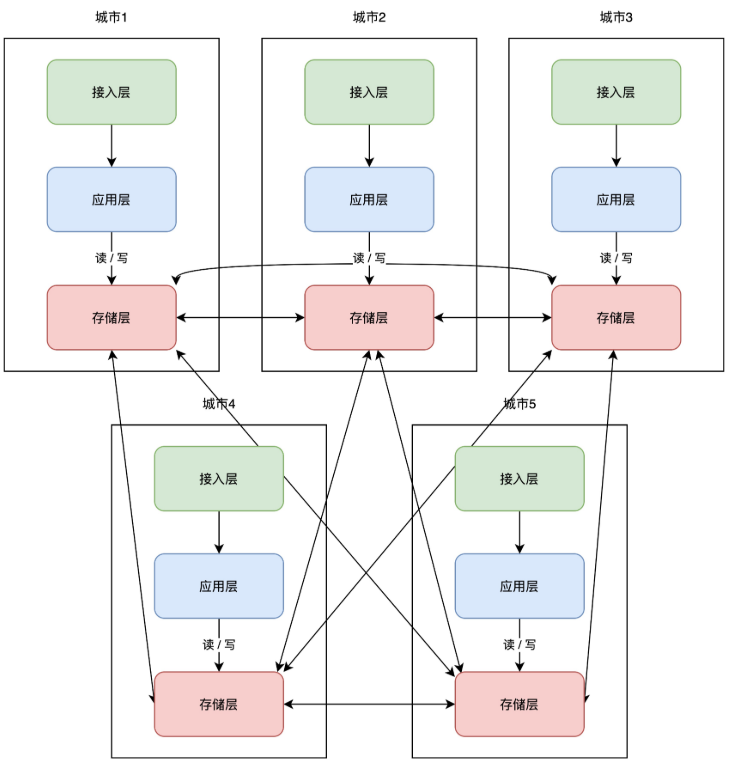

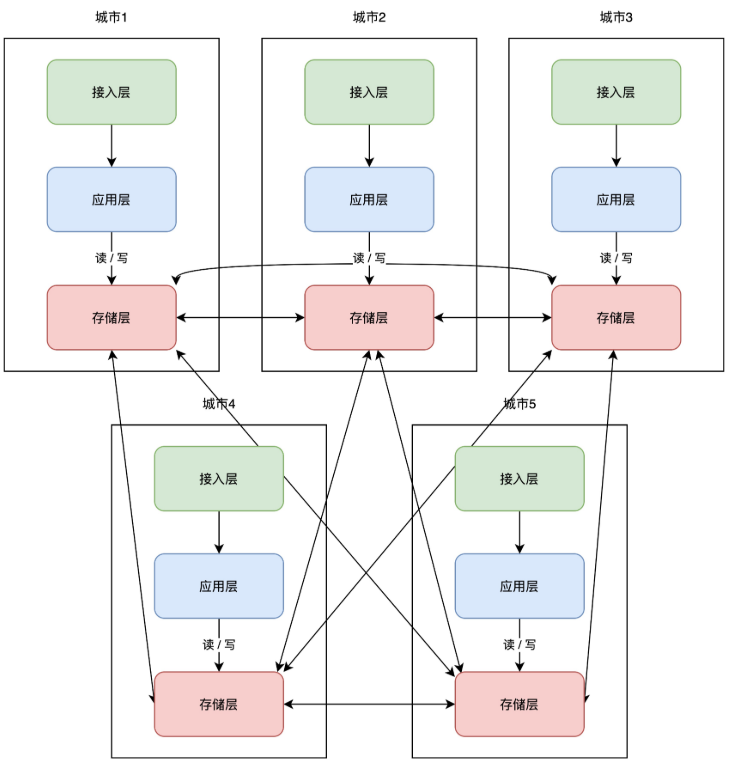

+# 11 异地多活

+

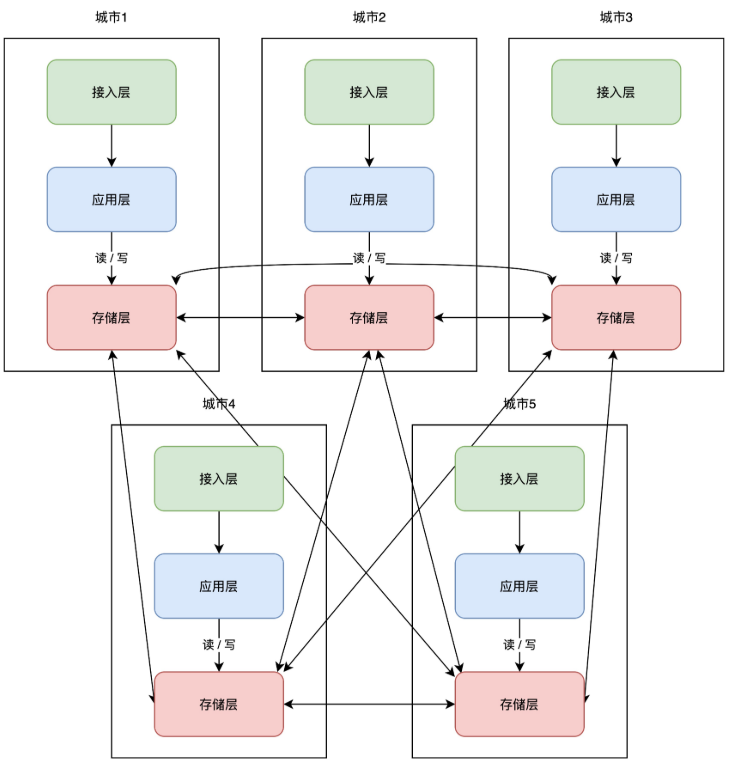

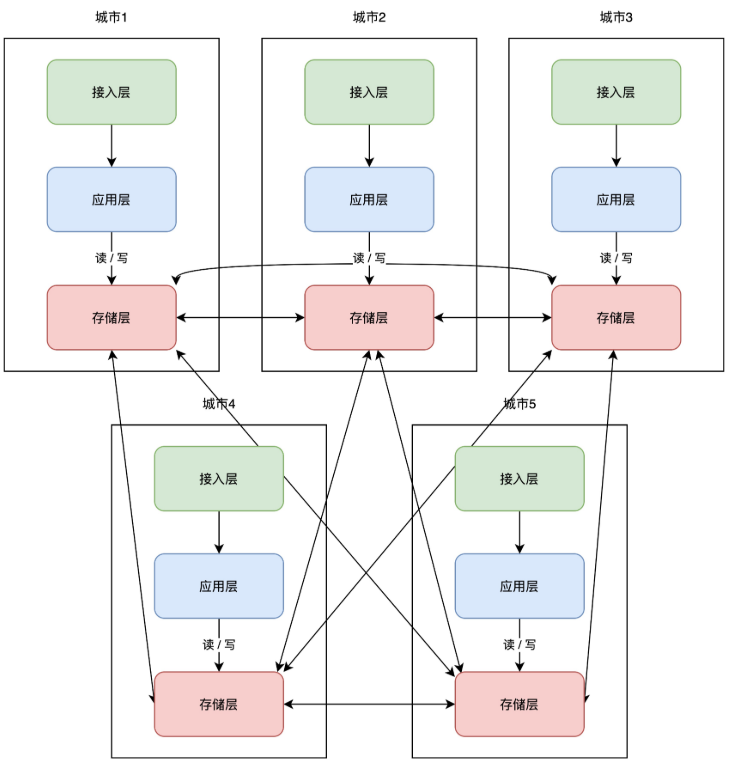

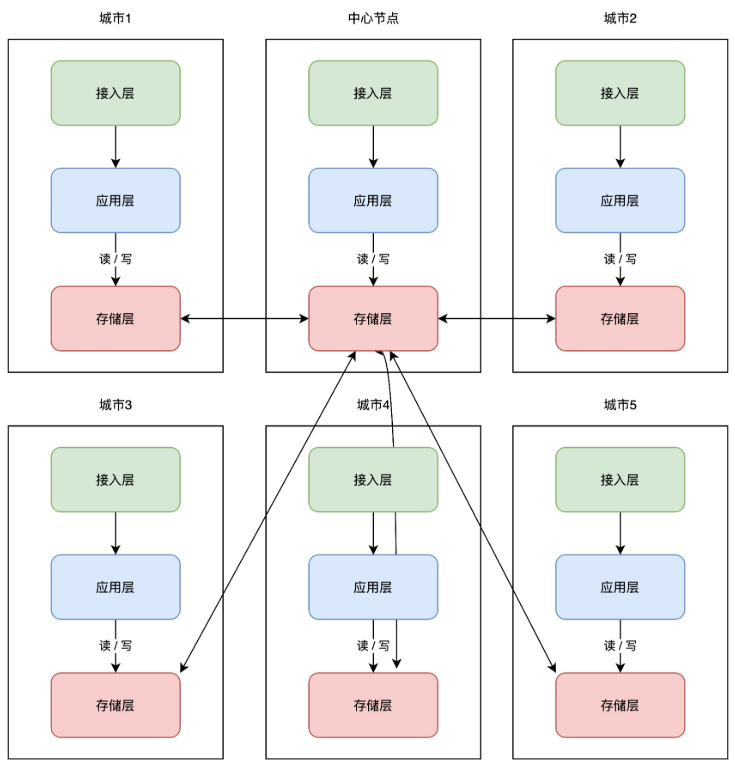

+理解了异地双活,那「异地多活」顾名思义,就是在异地双活的基础上,部署多个机房即可。架构变成了这样:

+

+

+

+这些服务按照「单元化」的部署方式,可以让每个机房部署在任意地区,随时扩展新机房,你只需要在最上层定义好分片规则就好了。

+

+但这里还有一个小问题,随着扩展的机房越来越多,当一个机房写入数据后,需要同步的机房也越来越多,这个实现复杂度会比较高。

+

+所以业界又把这一架构又做了进一步优化,把「网状」架构升级为「星状」:

+

+

+

+这种方案必须设立一个「中心机房」,任意机房写入数据后,都只同步到中心机房,再由中心机房同步至其它机房。

+

+这样做的好处是,一个机房写入数据,只需要同步数据到中心机房即可,不需要再关心一共部署了多少个机房,实现复杂度大大「简化」。

+

+但与此同时,这个中心机房的「稳定性」要求会比较高。不过也还好,即使中心机房发生故障,我们也可以把任意一个机房,提升为中心机房,继续按照之前的架构提供服务。

+

+至此,我们的系统彻底实现了「**异地多活**」!

+

+多活的优势在于,**可以任意扩展机房「就近」部署。任意机房发生故障,可以完成快速「切换」**,大大提高了系统的可用性。

+

+同时,我们也再也不用担心系统规模的增长,因为这套架构具有极强的「**扩展能力**」。

+

+怎么样?我们从一个最简单的应用,一路优化下来,到最终的架构方案,有没有帮你彻底理解异地多活呢?

+

+# 总结

+

+好了,总结一下这篇文章的重点。

+

+1、一个好的软件架构,应该遵循高性能、高可用、易扩展 3 大原则,其中「高可用」在系统规模变得越来越大时,变得尤为重要

+

+2、系统发生故障并不可怕,能以「最快」的速度恢复,才是高可用追求的目标,异地多活是实现高可用的有效手段

+

+3、提升高可用的核心是「冗余」,备份、主从副本、同城灾备、同城双活、两地三中心、异地双活,异地多活都是在做冗余

+

+4、同城灾备分为「冷备」和「热备」,冷备只备份数据,不提供服务,热备实时同步数据,并做好随时切换的准备

+

+5、同城双活比灾备的优势在于,两个机房都可以接入「读写」流量,提高可用性的同时,还提升了系统性能。虽然物理上是两个机房,但「逻辑」上还是当做一个机房来用

+

+6、两地三中心是在同城双活的基础上,额外部署一个异地机房做「灾备」,用来抵御「城市」级别的灾害,但启用灾备机房需要时间

+

+7、异地双活才是抵御「城市」级别灾害的更好方案,两个机房同时提供服务,故障随时可切换,可用性高。但实现也最复杂,理解了异地双活,才能彻底理解异地多活

+

+8、异地多活是在异地双活的基础上,任意扩展多个机房,不仅又提高了可用性,还能应对更大规模的流量的压力,扩展性最强,是实现高可用的最终方案

+

+# 后记

+

+这篇文章我从「宏观」层面,向你介绍了异地多活架构的「核心」思路,整篇文章的信息量还是很大的,如果不太好理解,我建议你多读几遍。

+

+因为篇幅限制,很多细节我并没有展开来讲。这篇文章更像是讲异地多活的架构之「道」,而真正实施的「术」,要考虑的点其实也非常繁多,因为它需要开发强大的「基础设施」才可以完成实施。

+

+不仅如此,要想真正实现异地多活,还需要遵循一些原则,例如业务梳理、业务分级、数据分类、数据最终一致性保障、机房切换一致性保障、异常处理等等。同时,相关的运维设施、监控体系也要能跟得上才行。

+

+宏观上需要考虑业务(微服务部署、依赖、拆分、SDK、Web 框架)、基础设施(服务发现、流量调度、持续集成、同步中间件、自研存储),微观上要开发各种中间件,还要关注中间件的高性能、高可用、容错能力,其复杂度之高,只有亲身参与过之后才知道。

+

+我曾经有幸参与过,存储层同步中间件的设计与开发,实现过「跨机房」同步 MySQL、Redis、MongoDB 的中间件,踩过的坑也非常多。当然,这些中间件的设计思路也非常有意思,有时间单独分享一下这些中间件的设计思路。

+

+值得提醒你的是,只有真正理解了「异地双活」,才能彻底理解「异地多活」。在我看来,从同城双活演变为异地双活的过程,是最为复杂的,最核心的东西包括,**业务单元化划分、存储层数据双向同步、最上层的分片逻辑**,这些是实现异地多活的重中之重。

+

diff --git a/docs/advance/excellent-article/31-mysql-data-sync-es.md b/docs/advance/excellent-article/31-mysql-data-sync-es.md

new file mode 100644

index 0000000..8d43d94

--- /dev/null

+++ b/docs/advance/excellent-article/31-mysql-data-sync-es.md

@@ -0,0 +1,503 @@

+---

+sidebar: heading

+title: MySQL数据如何实时同步到ES

+category: 优质文章

+tag:

+ - MySQL

+head:

+ - - meta

+ - name: keywords

+ content: MySQL,ES,elasticsearch,数据同步

+ - - meta

+ - name: description

+ content: 努力打造最优质的Java学习网站

+---

+

+

+## 前言

+

+我们一般会使用MySQL用来存储数据,用Es来做全文检索和特殊查询,那么如何将数据优雅的从MySQL同步到Es呢?我们一般有以下几种方式:

+

+1.**双写**。在代码中先向MySQL中写入数据,然后紧接着向Es中写入数据。这个方法的缺点是代码严重耦合,需要手动维护MySQL和Es数据关系,非常不便于维护。

+

+2.**发MQ,异步执行**。在执行完向Mysql中写入数据的逻辑后,发送MQ,告诉消费端这个数据需要写入Es,消费端收到消息后执行向Es写入数据的逻辑。这个方式的优点是Mysql和Es数据维护分离,开发Mysql和Es的人员只需要关心各自的业务。缺点是依然需要维护发送、接收MQ的逻辑,并且引入了MQ组件,增加了系统的复杂度。

+

+3.**使用Datax进行全量数据同步**。这个方式优点是可以完全不用写维护数据关系的代码,各自只需要关心自己的业务,对代码侵入性几乎为零。缺点是Datax是一种全量同步数据的方式,不使用实时同步。如果系统对数据时效性不强,可以考虑此方式。

+

+4.**使用Canal进行实时数据同步**。这个方式具有跟Datax一样的优点,可以完全不用写维护数据关系的代码,各自只需要关心自己的业务,对代码侵入性几乎为零。与Datax不同的是Canal是一种实时同步数据的方式,对数据时效性较强的系统,我们会采用Canal来进行实时数据同步。

+

+那么就让我们来看看Canal是如何使用的。

+

+## 官网

+

+https://github.com/alibaba/canal

+

+## 1.Canal简介

+

+

+

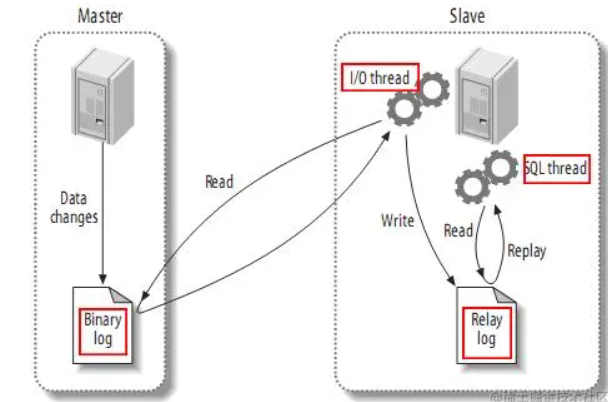

+**canal [kə'næl]** ,译意为水道/管道/沟渠,主要用途是基于 MySQL 数据库增量日志解析,提供增量数据订阅和消费

+

+早期阿里巴巴因为杭州和美国双机房部署,存在跨机房同步的业务需求,实现方式主要是基于业务 trigger 获取增量变更。从 2010 年开始,业务逐步尝试数据库日志解析获取增量变更进行同步,由此衍生出了大量的数据库增量订阅和消费业务。

+

+基于日志增量订阅和消费的业务包括

+

+- 数据库镜像

+- 数据库实时备份

+- 索引构建和实时维护(拆分异构索引、倒排索引等)

+- 业务 cache 刷新

+- 带业务逻辑的增量数据处理

+

+当前的 canal 支持源端 MySQL 版本包括 5.1.x , 5.5.x , 5.6.x , 5.7.x , 8.0.x

+

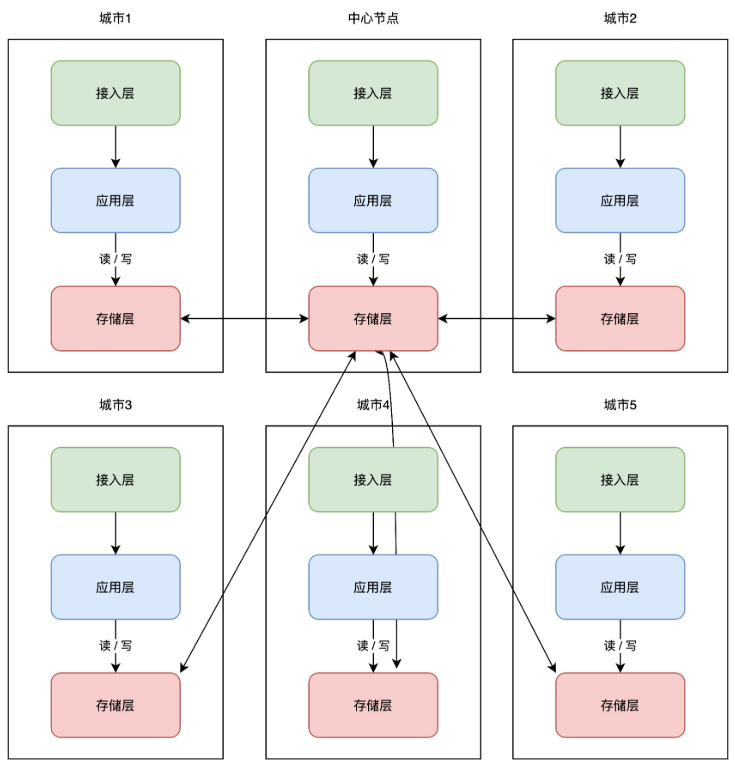

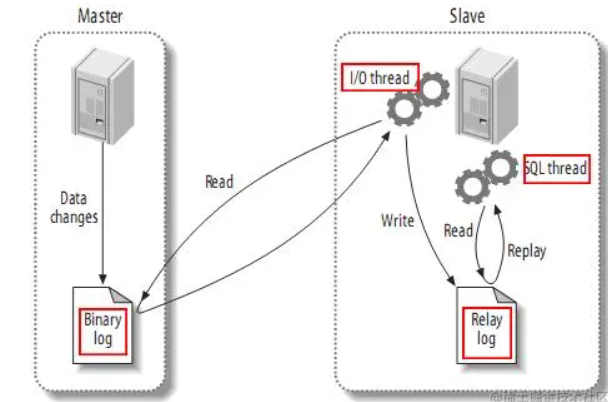

+### **MySQL主备复制原理**

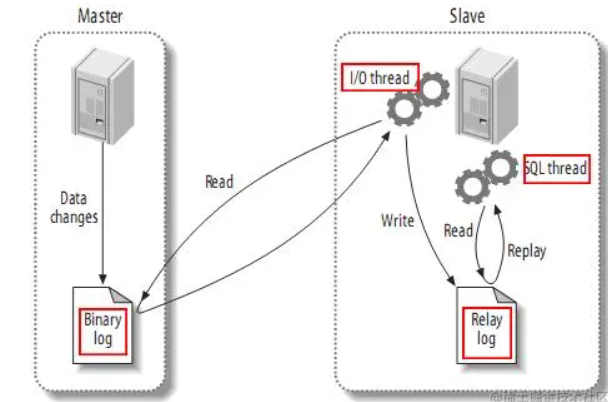

+

+

+

+- MySQL master 将数据变更写入二进制日志( binary log, 其中记录叫做二进制日志事件binary log events,可以通过 show binlog events 进行查看)

+- MySQL slave 将 master 的 binary log events 拷贝到它的中继日志(relay log)

+- MySQL slave 重放 relay log 中事件,将数据变更反映它自己的数据

+

+### **canal工作原理**

+

+- canal 模拟 MySQL slave 的交互协议,伪装自己为 MySQL slave ,向 MySQL master 发送dump 协议

+- MySQL master 收到 dump 请求,开始推送 binary log 给 slave (即 canal )

+- canal 解析 binary log 对象(原始为 byte 流)

+

+## 2.开启MySQL Binlog

+

+- 对于自建 MySQL , 需要先开启 Binlog 写入功能,配置 binlog-format 为 ROW 模式,my.cnf 中配置如下

+

+```ini

+[mysqld]

+log-bin=mysql-bin # 开启 binlog

+binlog-format=ROW # 选择 ROW 模式

+server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复

+lua

+## 复制代码注意:针对阿里云 RDS for MySQL , 默认打开了 binlog , 并且账号默认具有 binlog dump 权限 , 不需要任何权限或者 binlog 设置,可以直接跳过这一步

+```

+

+- 授权 canal 链接 MySQL 账号具有作为 MySQL slave 的权限, 如果已有账户可直接 grant

+

+```sql

+CREATE USER canal IDENTIFIED BY 'canal';

+GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

+-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;

+FLUSH PRIVILEGES;

+```

+

+注意:Mysql版本为8.x时启动canal可能会出现“caching_sha2_password Auth failed”错误,这是因为8.x创建用户时默认的密码加密方式为**caching_sha2_password**,与canal的方式不一致,所以需要将canal用户的密码加密方式修改为**mysql_native_password**

+

+```sql

+ALTER USER 'canal'@'%' IDENTIFIED WITH mysql_native_password BY 'canal'; #更新一下用户密码

+FLUSH PRIVILEGES; #刷新权限

+```

+

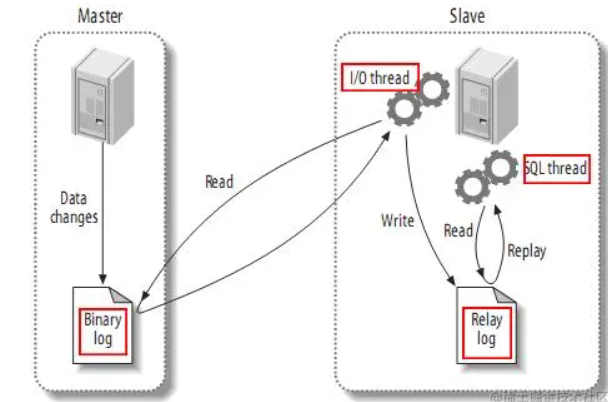

+## 3.安装Canal

+

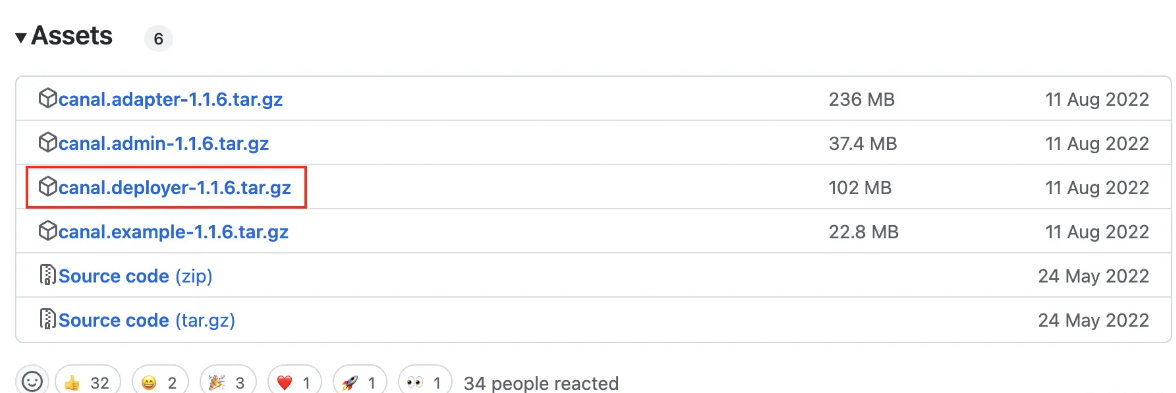

+### 3.1 下载Canal

+

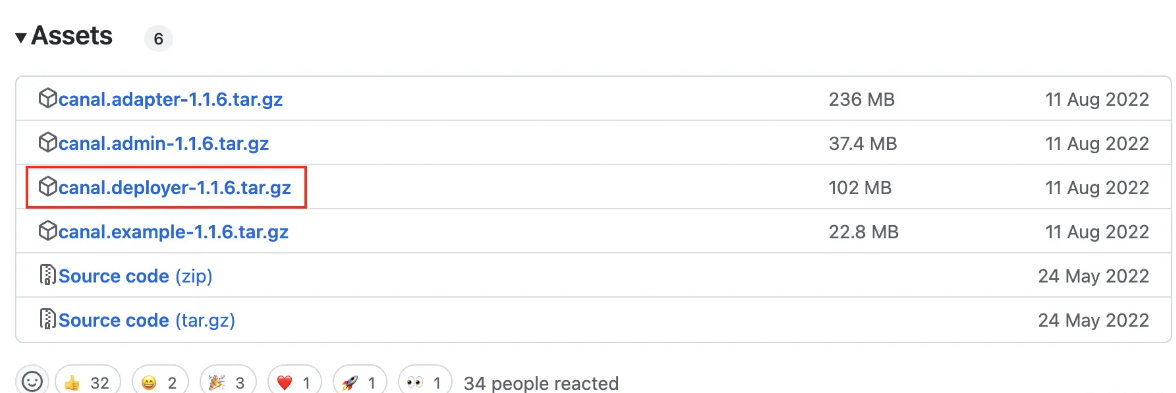

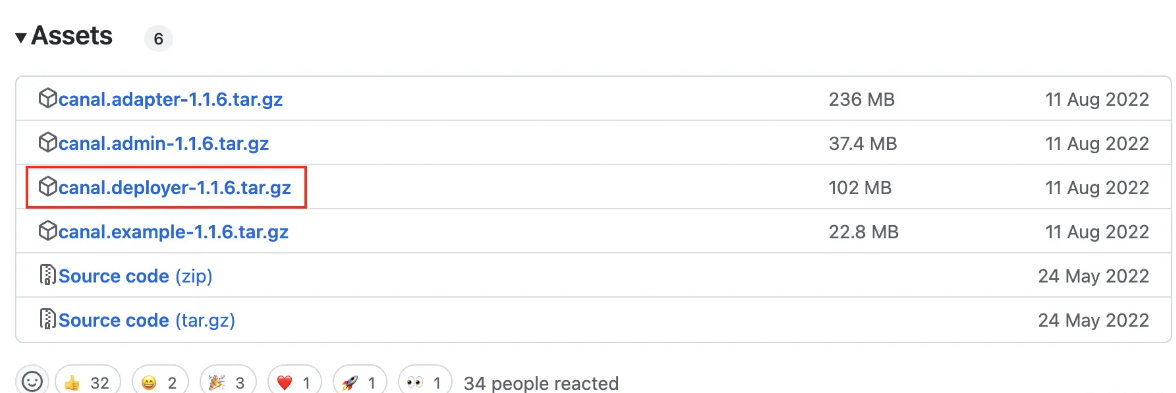

+**点击下载地址,选择版本后点击canal.deployer文件下载**

+

+

+

+### 3.2 修改配置文件

+

+打开目录下conf/example/instance.properties文件,主要修改以下内容

+

+```ini

+## mysql serverId,不要和 mysql 的 server_id 重复

+canal.instance.mysql.slaveId = 10

+#position info,需要改成自己的数据库信息

+canal.instance.master.address = 127.0.0.1:3306

+#username/password,需要改成自己的数据库信息,与刚才添加的用户保持一致

+canal.instance.dbUsername = canal

+canal.instance.dbPassword = canal

+```

+

+### 3.3 启动和关闭

+

+```bash

+#进入文件目录下的bin文件夹

+#启动

+sh startup.sh

+#关闭

+sh stop.sh

+```

+

+## 4.Springboot集成Canal

+

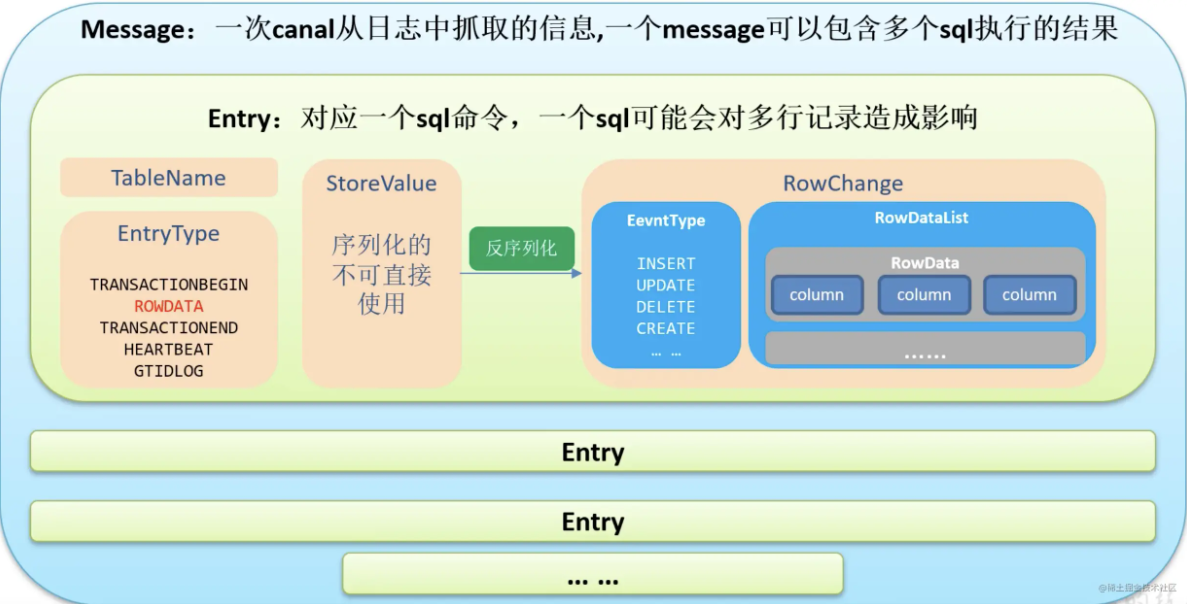

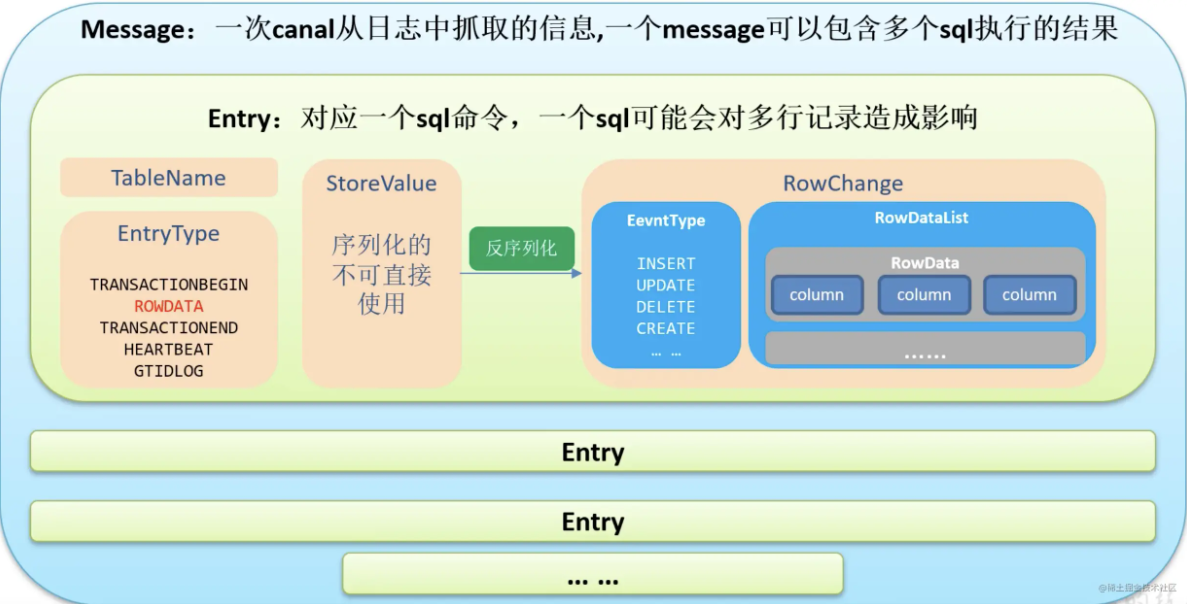

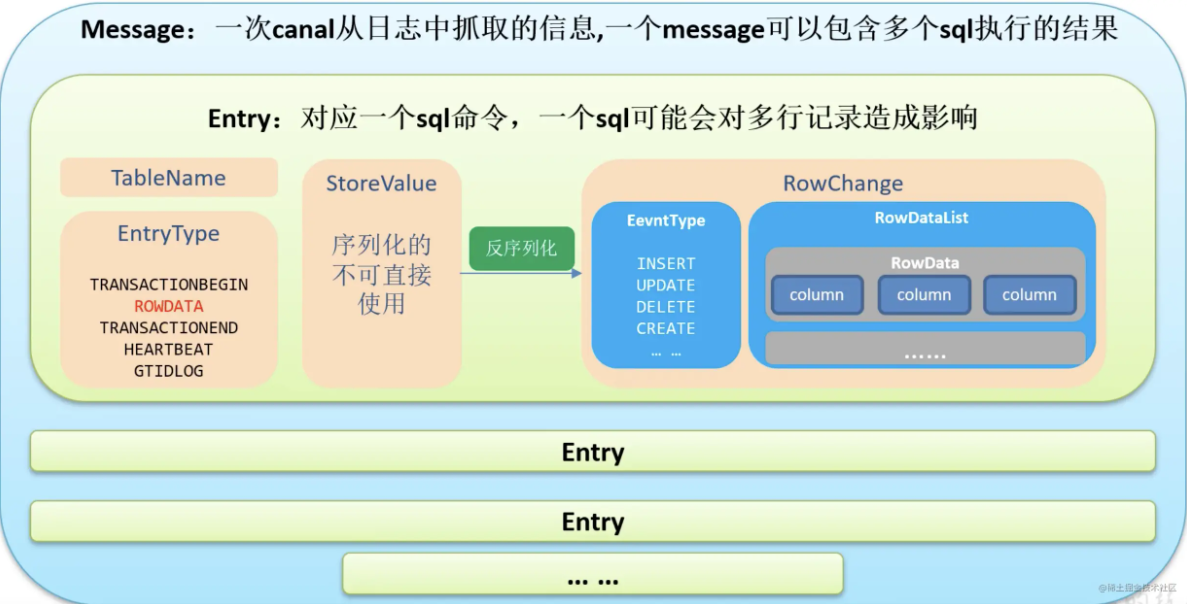

+### 4.1 Canal数据结构

+

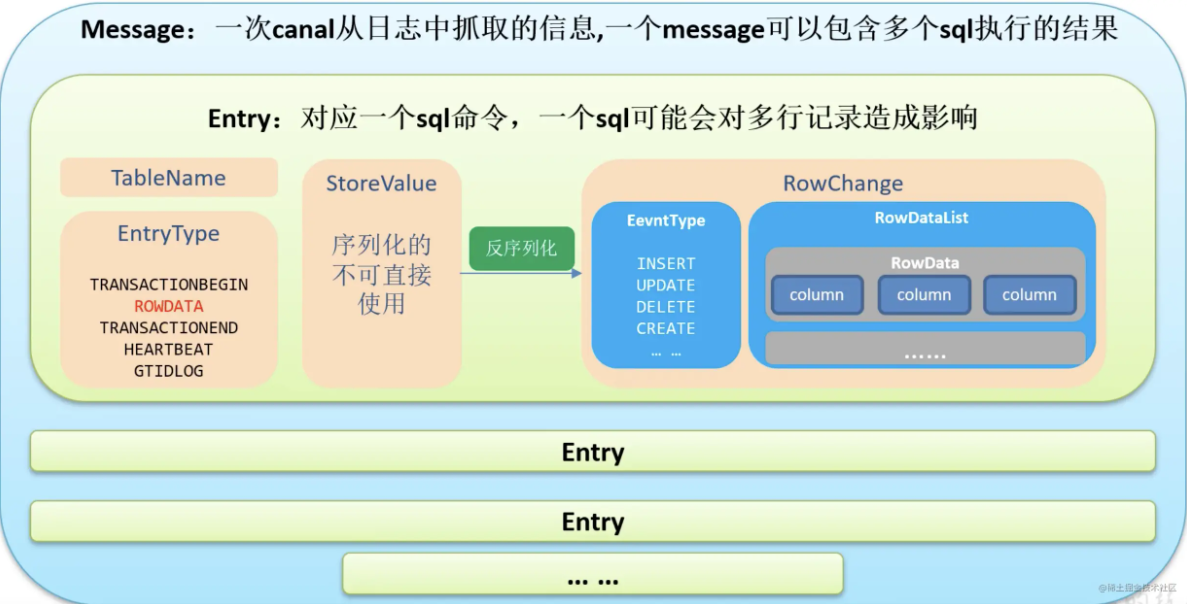

+

+

+### 4.2 引入依赖

+

+```xml

+

+

+ com.alibaba.otter

+ canal.client

+ 1.1.6

+

+

+

+

+

+ com.alibaba.otter

+ canal.protocol

+ 1.1.6

+

+

+

+

+ co.elastic.clients

+ elasticsearch-java

+ 8.4.3

+

+

+

+

+ jakarta.json

+ jakarta.json-api

+ 2.0.1

+

+```

+

+### 4.3 application.yaml

+

+```yaml

+custom:

+ elasticsearch:

+ host: localhost #主机

+ port: 9200 #端口

+ username: elastic #用户名

+ password: 3bf24a76 #密码

+```

+

+### 4.4 EsClient

+

+```java

+@Setter

+@ConfigurationProperties(prefix = "custom.elasticsearch")

+@Configuration

+public class EsClient {

+

+ /**

+ * 主机

+ */

+ private String host;

+

+ /**

+ * 端口

+ */

+ private Integer port;

+

+ /**

+ * 用户名

+ */

+ private String username;

+

+ /**

+ * 密码

+ */

+ private String password;

+

+

+ @Bean

+ public ElasticsearchClient elasticsearchClient() {

+ CredentialsProvider credentialsProvider = new BasicCredentialsProvider();

+ credentialsProvider.setCredentials(

+ AuthScope.ANY, new UsernamePasswordCredentials(username, password));

+

+ // Create the low-level client

+ RestClient restClient = RestClient.builder(new HttpHost(host, port))

+ .setHttpClientConfigCallback(httpAsyncClientBuilder ->

+ httpAsyncClientBuilder.setDefaultCredentialsProvider(credentialsProvider))

+ .build();

+ // Create the transport with a Jackson mapper

+ RestClientTransport transport = new RestClientTransport(

+ restClient, new JacksonJsonpMapper());

+ // Create the transport with a Jackson mapper

+ return new ElasticsearchClient(transport);

+ }

+}

+```

+

+### 4.5 Music实体类

+

+```java

+@Data

+@Builder

+@NoArgsConstructor

+@AllArgsConstructor

+public class Music {

+

+ /**

+ * id

+ */

+ private String id;

+

+ /**

+ * 歌名

+ */

+ private String name;

+

+ /**

+ * 歌手名

+ */

+ private String singer;

+

+ /**

+ * 封面图地址

+ */

+ private String imageUrl;

+

+ /**

+ * 歌曲地址

+ */

+ private String musicUrl;

+

+ /**

+ * 歌词地址

+ */

+ private String lrcUrl;

+

+ /**

+ * 歌曲类型id

+ */

+ private String typeId;

+

+ /**

+ * 是否被逻辑删除,1 是,0 否

+ */

+ private Integer isDeleted;

+

+ /**

+ * 创建时间

+ */

+ @JsonFormat(shape = JsonFormat.Shape.STRING, pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

+ private Date createTime;

+

+ /**

+ * 更新时间

+ */

+ @JsonFormat(shape = JsonFormat.Shape.STRING, pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

+ private Date updateTime;

+

+}

+```

+

+### 4.6 CanalClient

+

+```java

+@Slf4j

+@Component

+public class CanalClient {

+

+ @Resource

+ private ElasticsearchClient client;

+

+

+ /**

+ * 实时数据同步程序

+ *

+ * @throws InterruptedException

+ * @throws InvalidProtocolBufferException

+ */

+ public void run() throws InterruptedException, IOException {

+ CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(

+ "localhost", 11111), "example", "", "");

+

+ while (true) {

+ //连接

+ connector.connect();

+ //订阅数据库

+ connector.subscribe("cloudmusic_music.music");

+ //获取数据

+ Message message = connector.get(100);

+

+ List entryList = message.getEntries();

+ if (CollectionUtils.isEmpty(entryList)) {

+ //没有数据,休息一会

+ TimeUnit.SECONDS.sleep(2);

+ } else {

+ for (CanalEntry.Entry entry : entryList) {

+ //获取类型

+ CanalEntry.EntryType entryType = entry.getEntryType();

+

+ //判断类型是否为ROWDATA

+ if (CanalEntry.EntryType.ROWDATA.equals(entryType)) {

+ //获取序列化后的数据

+ ByteString storeValue = entry.getStoreValue();

+ //反序列化数据

+ CanalEntry.RowChange rowChange = CanalEntry.RowChange.parseFrom(storeValue);

+ //获取当前事件操作类型

+ CanalEntry.EventType eventType = rowChange.getEventType();

+ //获取数据集

+ List rowDataList = rowChange.getRowDatasList();

+

+ if (eventType == CanalEntry.EventType.INSERT) {

+ log.info("------新增操作------");

+

+ List musicList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ musicList.add(createMusic(rowData.getAfterColumnsList()));

+ }

+ //es批量新增文档

+ index(musicList);

+ //打印新增集合

+ log.info(Arrays.toString(musicList.toArray()));

+ } else if (eventType == CanalEntry.EventType.UPDATE) {

+ log.info("------更新操作------");

+

+ List beforeMusicList = new ArrayList<>();

+ List afterMusicList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ //更新前

+ beforeMusicList.add(createMusic(rowData.getBeforeColumnsList()));

+ //更新后

+ afterMusicList.add(createMusic(rowData.getAfterColumnsList()));

+ }

+ //es批量更新文档

+ index(afterMusicList);

+ //打印更新前集合

+ log.info("更新前:{}", Arrays.toString(beforeMusicList.toArray()));

+ //打印更新后集合

+ log.info("更新后:{}", Arrays.toString(afterMusicList.toArray()));

+ } else if (eventType == CanalEntry.EventType.DELETE) {

+ //删除操作

+ log.info("------删除操作------");

+

+ List idList = new ArrayList<>();

+ for (CanalEntry.RowData rowData : rowDataList) {

+ for (CanalEntry.Column column : rowData.getBeforeColumnsList()) {

+ if("id".equals(column.getName())) {

+ idList.add(column.getValue());

+ break;

+ }

+ }

+ }

+ //es批量删除文档

+ delete(idList);

+ //打印删除id集合

+ log.info(Arrays.toString(idList.toArray()));

+ }

+ }

+ }

+ }

+ }

+ }

+

+ /**

+ * 根据canal获取的数据创建Music对象

+ *

+ * @param columnList

+ * @return

+ */

+ private Music createMusic(List columnList) {

+ Music music = new Music();

+ DateTimeFormatter formatter = DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss");

+

+ for (CanalEntry.Column column : columnList) {

+ switch (column.getName()) {

+ case "id" -> music.setId(column.getValue());

+ case "name" -> music.setName(column.getValue());

+ case "singer" -> music.setSinger(column.getValue());

+ case "image_url" -> music.setImageUrl(column.getValue());

+ case "music_url" -> music.setMusicUrl(column.getValue());

+ case "lrc_url" -> music.setLrcUrl(column.getValue());

+ case "type_id" -> music.setTypeId(column.getValue());

+ case "is_deleted" -> music.setIsDeleted(Integer.valueOf(column.getValue()));

+ case "create_time" ->

+ music.setCreateTime(Date.from(LocalDateTime.parse(column.getValue(), formatter).atZone(ZoneId.systemDefault()).toInstant()));

+ case "update_time" ->

+ music.setUpdateTime(Date.from(LocalDateTime.parse(column.getValue(), formatter).atZone(ZoneId.systemDefault()).toInstant()));

+ default -> {

+ }

+ }

+ }

+

+ return music;

+ }

+

+ /**

+ * es批量新增、更新文档(不存在:新增, 存在:更新)

+ *

+ * @param musicList 音乐集合

+ * @throws IOException

+ */

+ private void index(List musicList) throws IOException {

+ BulkRequest.Builder br = new BulkRequest.Builder();

+

+ musicList.forEach(music -> br

+ .operations(op -> op

+ .index(idx -> idx

+ .index("music")

+ .id(music.getId())

+ .document(music))));

+

+ client.bulk(br.build());

+ }

+

+ /**

+ * es批量删除文档

+ *

+ * @param idList 音乐id集合

+ * @throws IOException

+ */

+ private void delete(List idList) throws IOException {

+ BulkRequest.Builder br = new BulkRequest.Builder();

+

+ idList.forEach(id -> br

+ .operations(op -> op

+ .delete(idx -> idx

+ .index("music")

+ .id(id))));

+

+ client.bulk(br.build());

+ }

+

+}

+```

+

+### 4.7 ApplicationContextAware

+

+```java

+@Component

+public class ApplicationContextUtil implements ApplicationContextAware {

+

+ private static ApplicationContext applicationContext;

+

+ @Override

+ public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

+ ApplicationContextUtil.applicationContext = applicationContext;

+ }

+

+ public static T getBean (Class classType) {

+ return applicationContext.getBean(classType);

+ }

+

+}

+```

+

+### 4.8 main

+

+```java

+@Slf4j

+@SpringBootApplication

+public class CanalApplication {

+ public static void main(String[] args) throws InterruptedException, IOException {

+ SpringApplication.run(CanalApplication.class, args);

+ log.info("数据同步程序启动");

+

+ CanalClient client = ApplicationContextUtil.getBean(CanalClient.class);

+ client.run();

+ }

+}

+```

+

+## 5.总结

+

+那么以上就是Canal组件的介绍啦,希望大家都能有所收获~

+

diff --git "a/docs/advance/excellent-article/MySQL\344\270\255N\344\270\252\345\206\231SQL\347\232\204\345\245\275\344\271\240\346\203\257.md" "b/docs/advance/excellent-article/MySQL\344\270\255N\344\270\252\345\206\231SQL\347\232\204\345\245\275\344\271\240\346\203\257.md"

new file mode 100644

index 0000000..9a2241a

--- /dev/null

+++ "b/docs/advance/excellent-article/MySQL\344\270\255N\344\270\252\345\206\231SQL\347\232\204\345\245\275\344\271\240\346\203\257.md"

@@ -0,0 +1,91 @@

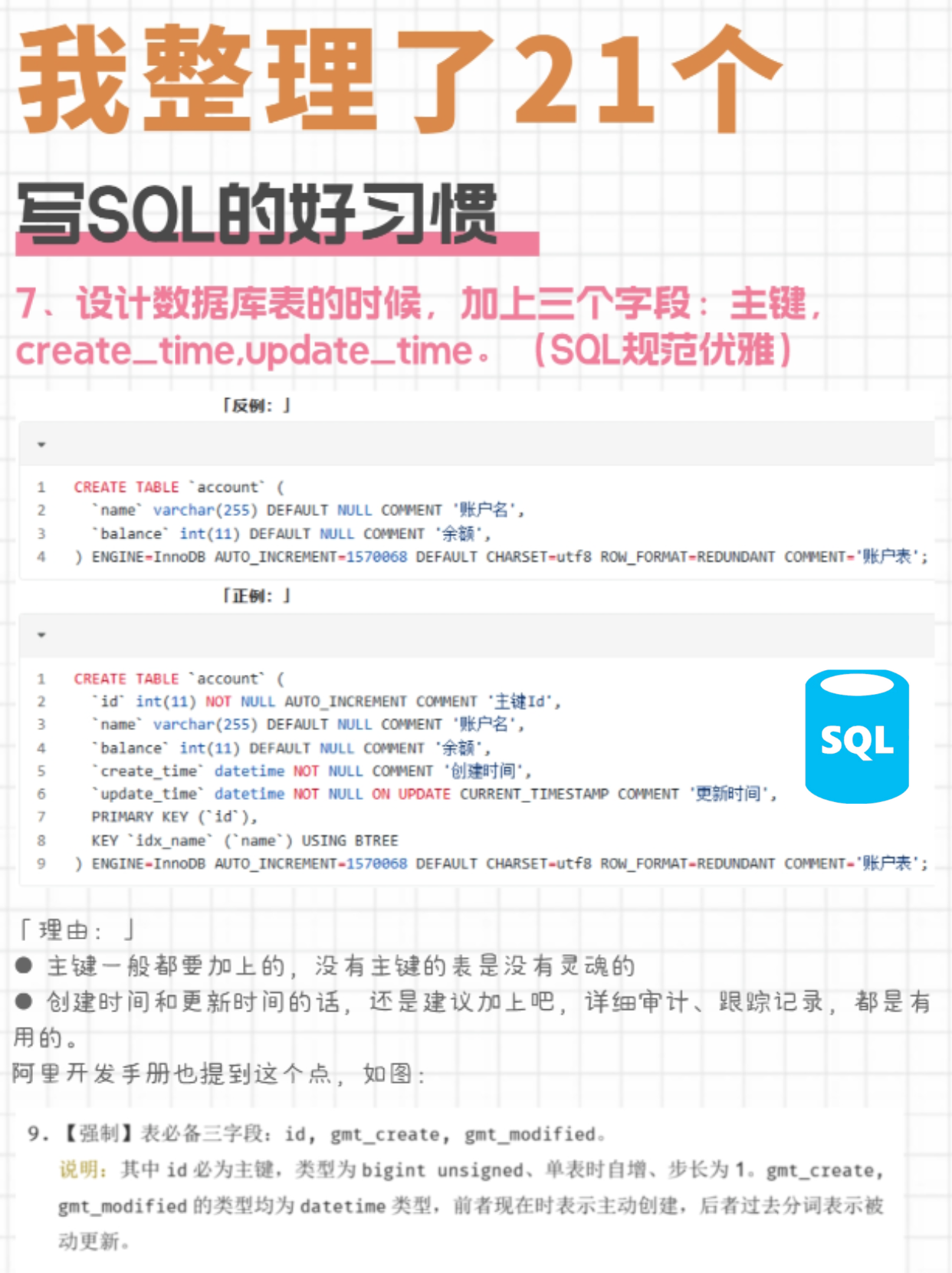

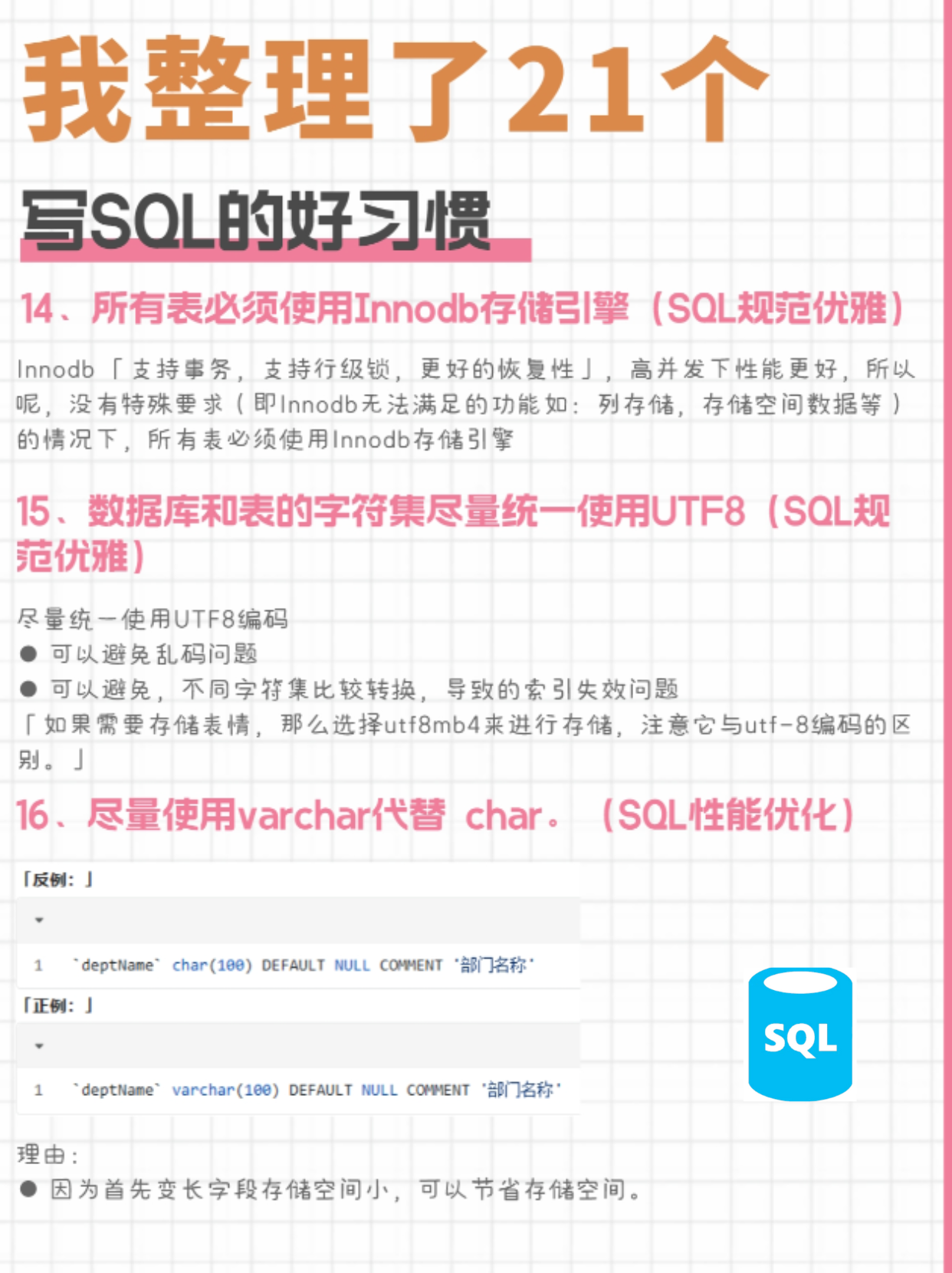

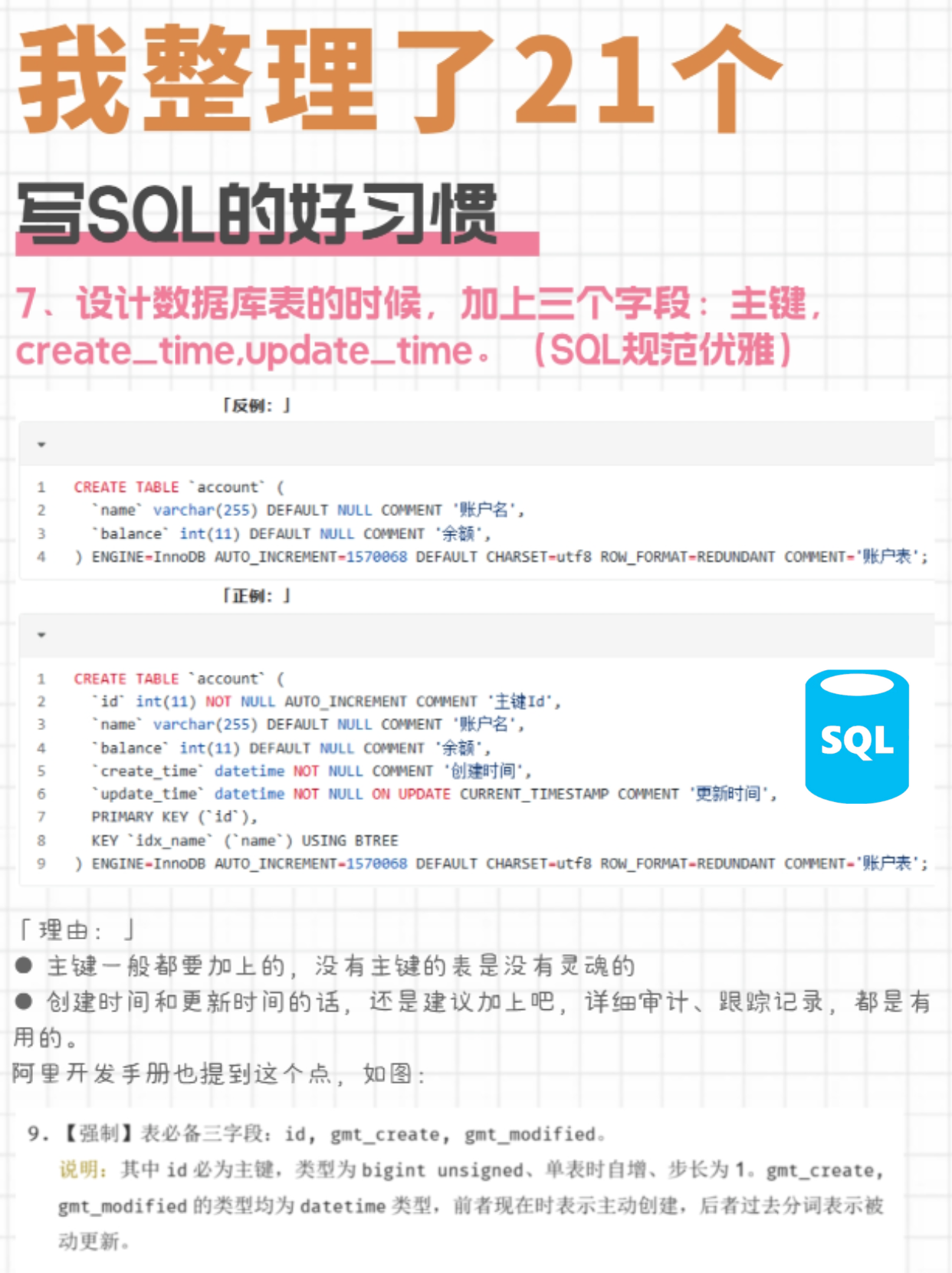

+MySQL中编写SQL时,遵循良好的习惯能够提高查询性能、保障数据一致性、提升代码可读性和维护性。以下列举了多个编写SQL的好习惯

+

+#### 1.使用EXPLAIN分析查询计划

+

+在编写或优化复杂查询时,先使用EXPLAIN命令查看查询执行计划,理解MySQL如何执行查询、访问哪些表、使用哪种类型的联接以及索引的使用情况。

+

+好处:有助于识别潜在的性能瓶颈,如全表扫描、错误的索引选择、过多的临时表或文件排序等,从而针对性地优化查询或调整索引结构。

+

+#### 2.避免全表扫描

+

+2. 习惯:尽可能利用索引来避免全表扫描,尤其是在处理大表时。确保在WHERE、JOIN条件和ORDER BY、GROUP BY子句中使用的列有适当的索引。

+

+好处:极大地减少数据访问量,提高查询性能,减轻I/O压力。

+

+#### 3. 为表和字段添加注释

+

+3. 习惯:在创建表时,为表和每个字段添加有意义的注释,描述其用途、数据格式、业务规则等信息。

+

+好处:提高代码可读性和可维护性,帮助其他开发人员快速理解表结构和字段含义,减少沟通成本和误解。

+

+#### 4. 明确指定INSERT语句的列名

+

+习惯:在INSERT语句中显式列出要插入数据的列名,即使插入所有列也应如此。

+

+好处:避免因表结构变化导致的插入错误,增强代码的健壮性,同时也提高了语句的清晰度。

+

+#### 5. 格式化SQL语句

+

+习惯:保持SQL语句的格式整洁,使用一致的大小写(如关键词大写、表名和列名小写),合理缩进,避免过长的单行语句。

+

+好处:提高代码可读性,便于审查、调试和团队协作。

+

+#### 6. 使用LIMIT限制结果集大小

+

+习惯:在执行SELECT、DELETE或UPDATE操作时,若不需要处理全部数据,务必使用LIMIT子句限制结果集大小,特别是在生产环境中。

+

+好处:防止因误操作导致大量数据被修改或删除,降低风险,同时也能提高查询性能。

+

+#### 7.使用JOIN语句代替子查询

+

+习惯:在可能的情况下,优先使用JOIN操作代替嵌套的子查询,特别是在处理多表关联查询时。

+

+好处:许多情况下JOIN的执行效率高于子查询,而且JOIN语句通常更易于理解和优化。

+

+#### 8.避免在WHERE子句中对NULL进行比较

+

+习惯:使用IS NULL和IS NOT NULL来检查字段是否为NULL,而不是直接与NULL进行等值或不等值比较。

+

+好处:正确处理NULL值,避免逻辑错误和未预期的结果。

+

+#### 9.避免在查询中使用SELECT

+

+习惯:明确列出需要的列名,而不是使用SELECT *从表中获取所有列。

+

+好处:减少网络传输的数据量,降低I/O开销,提高查询性能,同时也有利于代码的清晰性和可维护性。

+

+#### 10. 数据库对象命名规范

+

+习惯:遵循一致且有意义的命名约定,如使用小写字母、下划线分隔单词,避免使用MySQL保留字,保持表名、列名、索引名等的简洁性和一致性。

+

+好处:提高代码可读性,减少命名冲突,便于团队协作和维护。

+

+#### 11. 事务管理

+

+习惯:对一系列需要保持原子性的操作使用事务管理,确保数据的一致性。

+

+好处:在发生异常时能够回滚未完成的操作,避免数据处于不一致状态。

+

+#### 12.适时使用索引覆盖

+

+习惯:对于只查询索引列且不需要访问数据行的查询(如计数、统计),创建覆盖索引以避免回表操作。

+

+好处:极大提升查询性能,减少I/O开销。

+

+#### 13.遵循第三范式或适当反范式

+

+习惯:根据业务需求和查询模式,合理设计表结构,遵循第三范式以减少数据冗余和更新异常,或适当反范式以优化查询性能。

+

+好处:保持数据一致性,减少数据维护成本,或提高查询效率。

+

+#### 14.使用预编译语句(PreparedStatement)

+

+习惯:在应用程序中使用预编译语句(如Java中的PreparedStatement)执行SQL,特别是对于动态拼接SQL语句的情况。

+

+好处:避免SQL注入攻击,提高查询性能,减少数据库服务器的解析开销。

+

+#### 15.定期分析与优化表和索引

+

+习惯:定期运行ANALYZE TABLE收集统计信息,以便MySQL优化器做出更准确的查询计划决策。根据查询性能监控结果,适时调整索引或重构表结构。

+

+好处:确保数据库持续高效运行,适应不断变化的业务需求和数据分布。

\ No newline at end of file

diff --git "a/docs/advance/excellent-article/\345\256\236\347\216\260\345\274\202\346\255\245\347\274\226\347\250\213\357\274\214\346\210\221\346\234\211\345\205\253\347\247\215\346\226\271\345\274\217\357\274\201.md" "b/docs/advance/excellent-article/\345\256\236\347\216\260\345\274\202\346\255\245\347\274\226\347\250\213\357\274\214\346\210\221\346\234\211\345\205\253\347\247\215\346\226\271\345\274\217\357\274\201.md"

new file mode 100644

index 0000000..92ca41f

--- /dev/null

+++ "b/docs/advance/excellent-article/\345\256\236\347\216\260\345\274\202\346\255\245\347\274\226\347\250\213\357\274\214\346\210\221\346\234\211\345\205\253\347\247\215\346\226\271\345\274\217\357\274\201.md"

@@ -0,0 +1,430 @@

+# 实现异步编程,我有八种方式!

+

+## **一、前言**

+

+> 异步执行对于开发者来说并不陌生,在实际的开发过程中,很多场景多会使用到异步,相比同步执行,异步可以大大缩短请求链路耗时时间,比如:**发送短信、邮件、异步更新等**,这些都是典型的可以通过异步实现的场景。

+

+## **二、异步的八种实现方式**

+

+1. 线程Thread

+2. Future

+3. 异步框架`CompletableFuture`

+4. Spring注解@Async

+5. Spring `ApplicationEvent`事件

+6. 消息队列

+7. 第三方异步框架,比如Hutool的`ThreadUtil`

+8. Guava异步

+

+## **三、什么是异步?**

+

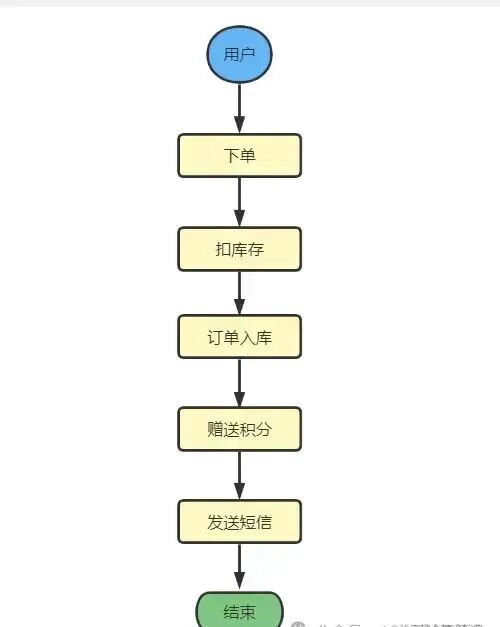

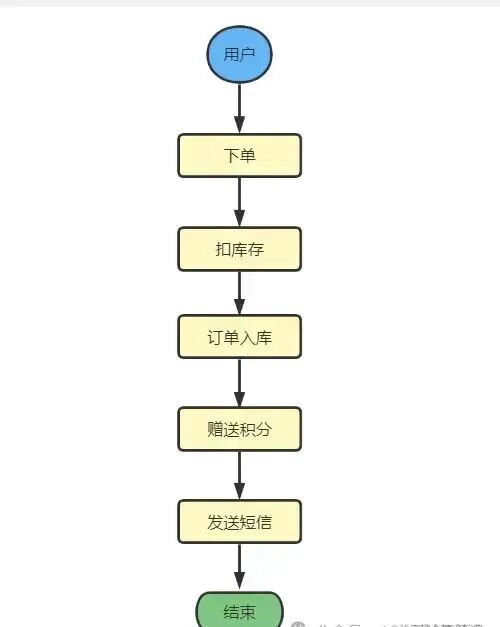

+首先我们先看一个常见的用户下单的场景:

+

+

+

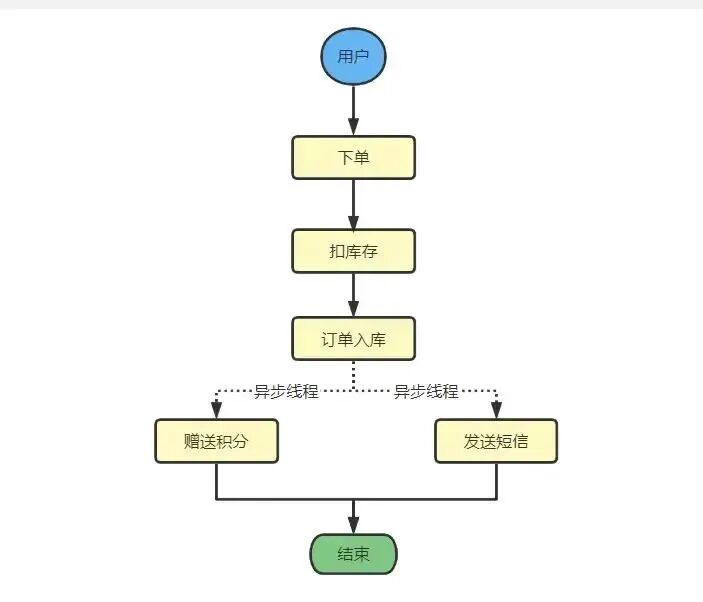

+在同步操作中,我们执行到 **发送短信** 的时候,我们必须等待这个方法彻底执行完才能执行 **赠送积分** 这个操作,如果 **赠送积分** 这个动作执行时间较长,发送短信需要等待,这就是典型的同步场景。

+

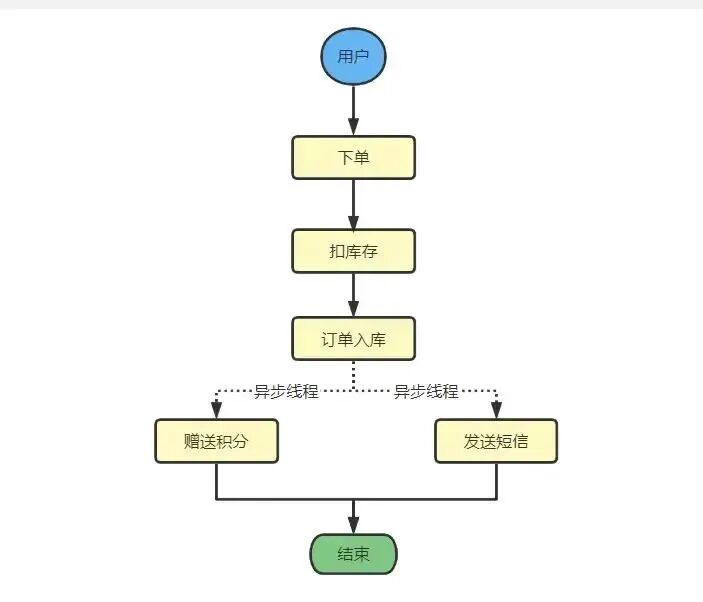

+实际上,发送短信和赠送积分没有任何的依赖关系,通过异步,我们可以实现`赠送积分`和`发送短信`这两个操作能够同时进行,比如:

+

+

+

+这就是所谓的异步,是不是非常简单,下面就说说异步的几种实现方式吧。

+

+## **四、异步编程**

+

+#### **4.1 线程异步**

+

+```java

+public class AsyncThread extends Thread {

+

+ @Override

+ public void run() {

+ System.out.println("Current thread name:" + Thread.currentThread().getName() + " Send email success!");

+ }

+

+ public static void main(String[] args) {

+ AsyncThread asyncThread = new AsyncThread();

+ asyncThread.run();

+ }

+}

+```

+

+当然如果每次都创建一个`Thread`线程,频繁的创建、销毁,浪费系统资源,我们可以采用线程池:

+

+```java

+private ExecutorService executorService = Executors.newCachedThreadPool();

+

+public void fun() {

+ executorService.submit(new Runnable() {

+ @Override

+ public void run() {

+ log.info("执行业务逻辑...");

+ }

+ });

+}

+```

+

+可以将业务逻辑封装到`Runnable`或`Callable`中,交由线程池来执行。

+

+#### **4.2 Future异步**

+

+```java

+@Slf4j

+public class FutureManager {

+

+ public String execute() throws Exception {

+

+ ExecutorService executor = Executors.newFixedThreadPool(1);

+ Future future = executor.submit(new Callable() {

+ @Override

+ public String call() throws Exception {

+

+ System.out.println(" --- task start --- ");

+ Thread.sleep(3000);

+ System.out.println(" --- task finish ---");

+ return "this is future execute final result!!!";

+ }

+ });

+

+ //这里需要返回值时会阻塞主线程

+ String result = future.get();

+ log.info("Future get result: {}", result);

+ return result;

+ }

+

+ @SneakyThrows

+ public static void main(String[] args) {

+ FutureManager manager = new FutureManager();

+ manager.execute();

+ }

+}

+```

+

+输出结果:

+

+```

+ --- task start ---

+ --- task finish ---

+ Future get result: this is future execute final result!!!

+```

+

+##### **4.2.1 Future的不足之处**

+

+Future的不足之处的包括以下几点:

+

+1️⃣ 无法被动接收异步任务的计算结果:虽然我们可以主动将异步任务提交给线程池中的线程来执行,但是待异步任务执行结束之后,主线程无法得到任务完成与否的通知,它需要通过get方法主动获取任务执行的结果。

+

+2️⃣ Future件彼此孤立:有时某一个耗时很长的异步任务执行结束之后,你想利用它返回的结果再做进一步的运算,该运算也会是一个异步任务,两者之间的关系需要程序开发人员手动进行绑定赋予,Future并不能将其形成一个任务流(pipeline),每一个Future都是彼此之间都是孤立的,所以才有了后面的`CompletableFuture`,`CompletableFuture`就可以将多个Future串联起来形成任务流。

+

+3️⃣ Futrue没有很好的错误处理机制:截止目前,如果某个异步任务在执行发的过程中发生了异常,调用者无法被动感知,必须通过捕获get方法的异常才知晓异步任务执行是否出现了错误,从而在做进一步的判断处理。

+

+#### **4.3 CompletableFuture实现异步**

+

+```java

+public class CompletableFutureCompose {

+

+ /**

+ * thenAccept子任务和父任务公用同一个线程

+ */

+ @SneakyThrows

+ public static void thenRunAsync() {

+ CompletableFuture cf1 = CompletableFuture.supplyAsync(() -> {

+ System.out.println(Thread.currentThread() + " cf1 do something....");

+ return 1;

+ });

+ CompletableFuture cf2 = cf1.thenRunAsync(() -> {

+ System.out.println(Thread.currentThread() + " cf2 do something...");

+ });

+ //等待任务1执行完成

+ System.out.println("cf1结果->" + cf1.get());

+ //等待任务2执行完成

+ System.out.println("cf2结果->" + cf2.get());

+ }

+

+ public static void main(String[] args) {

+ thenRunAsync();

+ }

+}

+```

+

+我们不需要显式使用`ExecutorService,CompletableFuture `内部使用了`ForkJoinPool`来处理异步任务,如果在某些业务场景我们想自定义自己的异步线程池也是可以的。

+

+#### **4.4 Spring的@Async异步**

+

+##### **4.4.1 自定义异步线程池**

+

+```

+/**

+ * 线程池参数配置,多个线程池实现线程池隔离,@Async注解,默认使用系统自定义线程池,可在项目中设置多个线程池,在异步调用的时候,指明需要调用的线程池名称,比如:@Async("taskName")

+ *

+ * @author: jacklin

+ * @since: 2021/5/18 11:44

+ **/

+@EnableAsync

+@Configuration

+public class TaskPoolConfig {

+

+ /**

+ * 自定义线程池

+ *

+ * @author: jacklin

+ * @since: 2021/11/16 17:41

+ **/

+ @Bean("taskExecutor")

+ public Executor taskExecutor() {

+ //返回可用处理器的Java虚拟机的数量 12

+ int i = Runtime.getRuntime().availableProcessors();

+ System.out.println("系统最大线程数 : " + i);

+ ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

+ //核心线程池大小

+ executor.setCorePoolSize(16);

+ //最大线程数

+ executor.setMaxPoolSize(20);

+ //配置队列容量,默认值为Integer.MAX_VALUE

+ executor.setQueueCapacity(99999);

+ //活跃时间

+ executor.setKeepAliveSeconds(60);

+ //线程名字前缀

+ executor.setThreadNamePrefix("asyncServiceExecutor -");

+ //设置此执行程序应该在关闭时阻止的最大秒数,以便在容器的其余部分继续关闭之前等待剩余的任务完成他们的执行

+ executor.setAwaitTerminationSeconds(60);

+ //等待所有的任务结束后再关闭线程池

+ executor.setWaitForTasksToCompleteOnShutdown(true);

+ return executor;

+ }

+}

+```

+

+##### **4.4.2 AsyncService**

+

+```java

+public interface AsyncService {

+

+ MessageResult sendSms(String callPrefix, String mobile, String actionType, String content);

+

+ MessageResult sendEmail(String email, String subject, String content);

+}

+

+@Slf4j

+@Service

+public class AsyncServiceImpl implements AsyncService {

+

+ @Autowired

+ private IMessageHandler mesageHandler;

+

+ @Override

+ @Async("taskExecutor")

+ public MessageResult sendSms(String callPrefix, String mobile, String actionType, String content) {

+ try {

+

+ Thread.sleep(1000);

+ mesageHandler.sendSms(callPrefix, mobile, actionType, content);

+

+ } catch (Exception e) {

+ log.error("发送短信异常 -> ", e)

+ }

+ }

+

+

+ @Override

+ @Async("taskExecutor")

+ public sendEmail(String email, String subject, String content) {

+ try {

+

+ Thread.sleep(1000);

+ mesageHandler.sendsendEmail(email, subject, content);

+

+ } catch (Exception e) {

+ log.error("发送email异常 -> ", e)

+ }

+ }

+}

+```

+

+在实际项目中, 使用`@Async`调用线程池,推荐等方式是是使用自定义线程池的模式,不推荐直接使用@Async直接实现异步。

+

+#### **4.5 Spring ApplicationEvent事件实现异步**

+

+##### **4.5.1 定义事件**

+

+```java

+public class AsyncSendEmailEvent extends ApplicationEvent {

+

+ /**

+ * 邮箱

+ **/

+ private String email;

+

+ /**

+ * 主题

+ **/

+ private String subject;

+

+ /**

+ * 内容

+ **/

+ private String content;

+

+ /**

+ * 接收者

+ **/

+ private String targetUserId;

+

+}

+```

+

+##### **4.5.2 定义事件处理器**

+

+```java

+@Slf4j

+@Component

+public class AsyncSendEmailEventHandler implements ApplicationListener {

+

+ @Autowired

+ private IMessageHandler mesageHandler;

+

+ @Async("taskExecutor")

+ @Override

+ public void onApplicationEvent(AsyncSendEmailEvent event) {

+ if (event == null) {

+ return;

+ }

+

+ String email = event.getEmail();

+ String subject = event.getSubject();

+ String content = event.getContent();

+ String targetUserId = event.getTargetUserId();

+ mesageHandler.sendsendEmailSms(email, subject, content, targerUserId);

+ }

+}

+```

+

+另外,可能有些时候采用ApplicationEvent实现异步的使用,当程序出现异常错误的时候,需要考虑补偿机制,那么这时候可以结合Spring Retry重试来帮助我们避免这种异常造成数据不一致问题。

+

+#### **4.6 消息队列**

+

+##### **4.6.1 回调事件消息生产者**

+

+```

+@Slf4j

+@Component

+public class CallbackProducer {

+

+ @Autowired

+ AmqpTemplate amqpTemplate;

+

+ public void sendCallbackMessage(CallbackDTO allbackDTO, final long delayTimes) {

+

+ log.info("生产者发送消息,callbackDTO,{}", callbackDTO);

+

+ amqpTemplate.convertAndSend(CallbackQueueEnum.QUEUE_GENSEE_CALLBACK.getExchange(), CallbackQueueEnum.QUEUE_GENSEE_CALLBACK.getRoutingKey(), JsonMapper.getInstance().toJson(genseeCallbackDTO), new MessagePostProcessor() {

+ @Override

+ public Message postProcessMessage(Message message) throws AmqpException {

+ //给消息设置延迟毫秒值,通过给消息设置x-delay头来设置消息从交换机发送到队列的延迟时间

+ message.getMessageProperties().setHeader("x-delay", delayTimes);

+ message.getMessageProperties().setCorrelationId(callbackDTO.getSdkId());

+ return message;

+ }

+ });

+ }

+}

+```

+

+##### **4.6.2 回调事件消息消费者**

+

+```

+@Slf4j

+@Component

+@RabbitListener(queues = "message.callback", containerFactory = "rabbitListenerContainerFactory")

+public class CallbackConsumer {

+

+ @Autowired

+ private IGlobalUserService globalUserService;

+

+ @RabbitHandler

+ public void handle(String json, Channel channel, @Headers Map map) throws Exception {

+

+ if (map.get("error") != null) {

+ //否认消息

+ channel.basicNack((Long) map.get(AmqpHeaders.DELIVERY_TAG), false, true);

+ return;

+ }

+

+ try {

+

+ CallbackDTO callbackDTO = JsonMapper.getInstance().fromJson(json, CallbackDTO.class);

+ //执行业务逻辑

+ globalUserService.execute(callbackDTO);

+ //消息消息成功手动确认,对应消息确认模式acknowledge-mode: manual

+ channel.basicAck((Long) map.get(AmqpHeaders.DELIVERY_TAG), false);

+

+ } catch (Exception e) {

+ log.error("回调失败 -> {}", e);

+ }

+ }

+}

+```

+

+#### **4.7 ThreadUtil异步工具类**

+

+```java

+@Slf4j

+public class ThreadUtils {

+

+ public static void main(String[] args) {

+ for (int i = 0; i < 3; i++) {

+ ThreadUtil.execAsync(() -> {

+ ThreadLocalRandom threadLocalRandom = ThreadLocalRandom.current();

+ int number = threadLocalRandom.nextInt(20) + 1;

+ System.out.println(number);

+ });

+ log.info("当前第:" + i + "个线程");

+ }

+

+ log.info("task finish!");

+ }

+}

+```

+

+#### **4.8 Guava异步**

+

+`Guava`的`ListenableFuture`顾名思义就是可以监听的`Future`,是对java原生Future的扩展增强。我们知道Future表示一个异步计算任务,当任务完成时可以得到计算结果。

+

+如果我们希望一旦计算完成就拿到结果展示给用户或者做另外的计算,就必须使用另一个线程不断的查询计算状态。这样做,代码复杂,而且效率低下。

+

+使用**Guava ListenableFuture**可以帮我们检测Future是否完成了,不需要再通过get()方法苦苦等待异步的计算结果,如果完成就自动调用回调函数,这样可以减少并发程序的复杂度。

+

+`ListenableFuture`是一个接口,它从`jdk`的`Future`接口继承,添加了`void addListener(Runnable listener, Executor executor)`方法。

+

+我们看下如何使用`ListenableFuture`。首先需要定义`ListenableFuture`的实例:

+

+```java

+ListeningExecutorService executorService = MoreExecutors.listeningDecorator(Executors.newCachedThreadPool());

+ final ListenableFuture listenableFuture = executorService.submit(new Callable() {

+ @Override

+ public Integer call() throws Exception {

+ log.info("callable execute...")

+ TimeUnit.SECONDS.sleep(1);

+ return 1;

+ }

+ });

+```

+

+首先通过`MoreExecutors`类的静态方法`listeningDecorator`方法初始化一个`ListeningExecutorService`的方法,然后使用此实例的`submit`方法即可初始化`ListenableFuture`对象。

+

+`ListenableFuture`要做的工作,在Callable接口的实现类中定义,这里只是休眠了1秒钟然后返回一个数字1,有了`ListenableFuture`实例,可以执行此Future并执行Future完成之后的回调函数。

+

+```java

+ Futures.addCallback(listenableFuture, new FutureCallback() {

+ @Override

+ public void onSuccess(Integer result) {

+ //成功执行...

+ System.out.println("Get listenable future's result with callback " + result);

+ }

+

+ @Override

+ public void onFailure(Throwable t) {

+ //异常情况处理...

+ t.printStackTrace();

+ }

+});

+```

\ No newline at end of file

diff --git a/docs/advance/system-design/2-order-timeout-auto-cancel.md b/docs/advance/system-design/2-order-timeout-auto-cancel.md

index 5ffaf4e..b100f91 100644

--- a/docs/advance/system-design/2-order-timeout-auto-cancel.md

+++ b/docs/advance/system-design/2-order-timeout-auto-cancel.md

@@ -42,11 +42,11 @@ head:

对上述的任务,我们给一个专业的名字来形容,那就是延时任务。那么这里就会产生一个问题,这个延时任务和定时任务的区别究竟在哪里呢?一共有如下几点区别

-定时任务有明确的触发时间,延时任务没有

+1、定时任务有明确的触发时间,延时任务没有

-定时任务有执行周期,而延时任务在某事件触发后一段时间内执行,没有执行周期

+2、定时任务有执行周期,而延时任务在某事件触发后一段时间内执行,没有执行周期

-定时任务一般执行的是批处理操作是多个任务,而延时任务一般是单个任务

+3、定时任务一般执行的是批处理操作是多个任务,而延时任务一般是单个任务

下面,我们以判断订单是否超时为例,进行方案分析

@@ -340,13 +340,13 @@ public class HashedWheelTimerTest {

- 集群扩展相当麻烦

- 因为内存条件限制的原因,比如下单未付款的订单数太多,那么很容易就出现 OOM 异常

-## 方案 4:redis 缓存

+## 方案 4:Redis 缓存

### 思路一

利用 redis 的 zset,zset 是一个有序集合,每一个元素(member)都关联了一个 score,通过 score 排序来取集合中的值

-添加元素:ZADD key score member [[score member][score member] …]

+添加元素:ZADD key score member [score member …]

按顺序查询元素:ZRANGE key start stop [WITHSCORES]

@@ -619,11 +619,11 @@ ps:redis 的 pub/sub 机制存在一个硬伤,官网内容如下

### 思路

-我们可以采用 rabbitMQ 的延时队列。RabbitMQ 具有以下两个特性,可以实现延迟队列

+我们可以采用 RabbitMQ 的延时队列。RabbitMQ 具有以下两个特性,可以实现延迟队列

RabbitMQ 可以针对 Queue 和 Message 设置 x-message-tt,来控制消息的生存时间,如果超时,则消息变为 dead letter

-lRabbitMQ 的 Queue 可以配置 x-dead-letter-exchange 和 x-dead-letter-routing-key(可选)两个参数,用来控制队列内出现了 deadletter,则按照这两个参数重新路由。结合以上两个特性,就可以模拟出延迟消息的功能,具体的,我改天再写一篇文章,这里再讲下去,篇幅太长。

+lRabbitMQ 的 Queue 可以配置 x-dead-letter-exchange 和 x-dead-letter-routing-key(可选)两个参数,用来控制队列内出现了 deadletter,则按照这两个参数重新路由。结合以上两个特性,就可以模拟出延迟消息的功能。

### 优点

diff --git a/docs/advance/system-design/README.md b/docs/advance/system-design/README.md

index 79b8eb1..15ef840 100644

--- a/docs/advance/system-design/README.md

+++ b/docs/advance/system-design/README.md

@@ -26,6 +26,8 @@

怎么加入[知识星球](https://topjavaer.cn/zsxq/introduce.html)?

-**扫描以下二维码**领取50元的优惠券即可加入。星球定价**158**元,减去**50**元的优惠券,等于说只需要**108**元的价格就可以加入,服务期一年,**每天不到三毛钱**(0.29元),相比培训班几万块的学费,非常值了,星球提供的服务可以说**远超**门票价格了。

+**扫描以下二维码**领取50元的优惠券即可加入。星球定价**188**元,减去**50**元的优惠券,等于说只需要**138**元的价格就可以加入,服务期一年,**每天只要4毛钱**(0.37元),相比培训班几万块的学费,非常值了,星球提供的服务可以说**远超**门票价格了。

-

\ No newline at end of file

+随着星球内容不断积累,星球定价也会不断**上涨**(最初原价**68**元,现在涨到**188**元了,后面还会持续**上涨**),所以,想提升自己的小伙伴要趁早加入,**早就是优势**(优惠券只有50个名额,用完就恢复**原价**了)。

+

+

\ No newline at end of file

diff --git a/docs/campus-recruit/interview/3-baidu.md b/docs/campus-recruit/interview/3-baidu.md

index d5918e5..3cd2f26 100644

--- a/docs/campus-recruit/interview/3-baidu.md

+++ b/docs/campus-recruit/interview/3-baidu.md

@@ -36,6 +36,18 @@

- 刷脏页的流程

- 算法题:平方根

+> 分享一份大彬精心整理的大厂面试手册,包含计**算机基础、Java基础、多线程、JVM、数据库、Redis、Spring、Mybatis、SpringMVC、SpringBoot、分布式、微服务、设计模式、架构、校招社招分享**等高频面试题,非常实用,有小伙伴靠着这份手册拿过字节offer~

+>

+>

+>

+>

+>

+> 需要的小伙伴可以自行**下载**:

+>

+> 链接:https://pan.xunlei.com/s/VNgU60NQQNSDaEy9z955oufbA1?pwd=y9fy#

+>

+> 备用链接:https://pan.quark.cn/s/cbbb681e7c19

+

## 面经3

- 自我介绍

@@ -104,6 +116,12 @@

-**最后给大家分享一份精心整理的大厂高频面试题PDF,需要的小伙伴可以自行下载:**

+最后给大家分享**200多本计算机经典书籍PDF电子书**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,感兴趣的小伙伴可以自取:

+

+

+

+

+

+**200多本计算机经典书籍PDF电子书**:https://pan.xunlei.com/s/VNlmlh9jBl42w0QH2l4AJaWGA1?pwd=j8eq#

-[大厂面试手册](http://mp.weixin.qq.com/s?__biz=Mzg2OTY1NzY0MQ==&mid=2247485445&idx=1&sn=1c6e224b9bb3da457f5ee03894493dbc&chksm=ce98f543f9ef7c55325e3bf336607a370935a6c78dbb68cf86e59f5d68f4c51d175365a189f8#rd)

\ No newline at end of file

+备用链接:https://pan.quark.cn/s/3f1321952a16

\ No newline at end of file

diff --git a/docs/campus-recruit/interview/4-ali.md b/docs/campus-recruit/interview/4-ali.md

index 2c99b2e..00b2a7a 100644

--- a/docs/campus-recruit/interview/4-ali.md

+++ b/docs/campus-recruit/interview/4-ali.md

@@ -48,6 +48,18 @@

24. 操作系统的内存管理的页面淘汰 算法 ,介绍下LRU(最近最少使用算法 )

25. B+树的特点与优势

+> 分享一份大彬精心整理的大厂面试手册,包含计**算机基础、Java基础、多线程、JVM、数据库、Redis、Spring、Mybatis、SpringMVC、SpringBoot、分布式、微服务、设计模式、架构、校招社招分享**等高频面试题,非常实用,有小伙伴靠着这份手册拿过字节offer~

+>

+>

+>

+>

+>

+> 需要的小伙伴可以自行**下载**:

+>

+> 链接:https://pan.xunlei.com/s/VNgU60NQQNSDaEy9z955oufbA1?pwd=y9fy#

+>

+> 备用链接:https://pan.quark.cn/s/cbbb681e7c19

+

## 面经3

- 自我介绍,说简历里没有的东西

@@ -74,6 +86,14 @@

- 服务注册的时候发现没有注册成功会是什么原因。

- 讲讲你认为的rpc和service mesh之间的关系。

-**最后给大家分享一份精心整理的大厂高频面试题PDF,需要的小伙伴可以自行下载:**

-[大厂面试手册](http://mp.weixin.qq.com/s?__biz=Mzg2OTY1NzY0MQ==&mid=2247485445&idx=1&sn=1c6e224b9bb3da457f5ee03894493dbc&chksm=ce98f543f9ef7c55325e3bf336607a370935a6c78dbb68cf86e59f5d68f4c51d175365a189f8#rd)

\ No newline at end of file

+

+最后给大家分享**200多本计算机经典书籍PDF电子书**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,感兴趣的小伙伴可以自取:

+

+

+

+

+

+**200多本计算机经典书籍PDF电子书**:https://pan.xunlei.com/s/VNlmlh9jBl42w0QH2l4AJaWGA1?pwd=j8eq#

+

+备用链接:https://pan.quark.cn/s/3f1321952a16

\ No newline at end of file

diff --git a/docs/campus-recruit/interview/5-kuaishou.md b/docs/campus-recruit/interview/5-kuaishou.md

index 1b24e6d..539a84a 100644

--- a/docs/campus-recruit/interview/5-kuaishou.md

+++ b/docs/campus-recruit/interview/5-kuaishou.md

@@ -67,6 +67,18 @@

1. 对于部门的业务、技术栈

2. 对我的建议、和整个面试的感觉

+> 分享一份大彬精心整理的大厂面试手册,包含计**算机基础、Java基础、多线程、JVM、数据库、Redis、Spring、Mybatis、SpringMVC、SpringBoot、分布式、微服务、设计模式、架构、校招社招分享**等高频面试题,非常实用,有小伙伴靠着这份手册拿过字节offer~

+>

+>

+>

+>

+>

+> 需要的小伙伴可以自行**下载**:

+>

+> 链接:https://pan.xunlei.com/s/VNgU60NQQNSDaEy9z955oufbA1?pwd=y9fy#

+>

+> 备用链接:https://pan.quark.cn/s/cbbb681e7c19

+

## 面经1-二面

> **Java基础**

@@ -307,6 +319,14 @@ while (true) {

-**最后给大家分享一份精心整理的大厂高频面试题PDF,需要的小伙伴可以自行下载:**

-[大厂面试手册](http://mp.weixin.qq.com/s?__biz=Mzg2OTY1NzY0MQ==&mid=2247485445&idx=1&sn=1c6e224b9bb3da457f5ee03894493dbc&chksm=ce98f543f9ef7c55325e3bf336607a370935a6c78dbb68cf86e59f5d68f4c51d175365a189f8#rd)

\ No newline at end of file

+

+最后给大家分享**200多本计算机经典书籍PDF电子书**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,感兴趣的小伙伴可以自取:

+

+

+

+

+

+**200多本计算机经典书籍PDF电子书**:https://pan.xunlei.com/s/VNlmlh9jBl42w0QH2l4AJaWGA1?pwd=j8eq#

+

+备用链接:https://pan.quark.cn/s/3f1321952a16

\ No newline at end of file

diff --git a/docs/campus-recruit/interview/6-meituan.md b/docs/campus-recruit/interview/6-meituan.md

index 43a1b71..32cb5bf 100644

--- a/docs/campus-recruit/interview/6-meituan.md

+++ b/docs/campus-recruit/interview/6-meituan.md

@@ -68,3 +68,12 @@

+最后给大家分享**200多本计算机经典书籍PDF电子书**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,感兴趣的小伙伴可以自取:

+

+

+

+

+

+**200多本计算机经典书籍PDF电子书**:https://pan.xunlei.com/s/VNlmlh9jBl42w0QH2l4AJaWGA1?pwd=j8eq#

+

+备用链接:https://pan.quark.cn/s/3f1321952a16

\ No newline at end of file

diff --git a/docs/campus-recruit/share/2-years-tech-upgrade.md b/docs/campus-recruit/share/2-years-tech-upgrade.md

index b2aa471..5322d98 100644

--- a/docs/campus-recruit/share/2-years-tech-upgrade.md

+++ b/docs/campus-recruit/share/2-years-tech-upgrade.md

@@ -58,4 +58,4 @@ head:

**加入方式**:**扫描二维码**领取优惠券即可加入~

-

+

diff --git a/docs/career-plan/3-years-reflect.md b/docs/career-plan/3-years-reflect.md

index 8c4c12c..21e4cfc 100644

--- a/docs/career-plan/3-years-reflect.md

+++ b/docs/career-plan/3-years-reflect.md

@@ -95,5 +95,5 @@ head:

**加入方式**:**扫描二维码**领取优惠券加入(**即将恢复原价**)~

-

+

diff --git a/docs/career-plan/how-to-prepare-job-hopping.md b/docs/career-plan/how-to-prepare-job-hopping.md

index 0dea290..59aee75 100644

--- a/docs/career-plan/how-to-prepare-job-hopping.md

+++ b/docs/career-plan/how-to-prepare-job-hopping.md

@@ -85,4 +85,4 @@ head:

**加入方式**:**扫描二维码**领取优惠券加入(**即将恢复原价**)~

-

+

diff --git a/docs/career-plan/java-or-bigdata.md b/docs/career-plan/java-or-bigdata.md

index d3bbf32..cf98ec1 100644

--- a/docs/career-plan/java-or-bigdata.md

+++ b/docs/career-plan/java-or-bigdata.md

@@ -59,4 +59,4 @@ head:

**加入方式**:**扫描二维码**领取优惠券加入(**即将恢复原价**)~

-

+

diff --git a/docs/computer-basic/network.md b/docs/computer-basic/network.md

index 465d1bc..831488a 100644

--- a/docs/computer-basic/network.md

+++ b/docs/computer-basic/network.md

@@ -41,6 +41,8 @@ head:

怎么加入[知识星球](https://topjavaer.cn/zsxq/introduce.html)?

-**扫描以下二维码**领取50元的优惠券即可加入。星球定价**158**元,减去**50**元的优惠券,等于说只需要**108**元的价格就可以加入,服务期一年,**每天不到三毛钱**(0.29元),相比培训班几万块的学费,非常值了,星球提供的服务可以说**远超**门票价格了。

+**扫描以下二维码**领取50元的优惠券即可加入。星球定价**188**元,减去**50**元的优惠券,等于说只需要**138**元的价格就可以加入,服务期一年,**每天只要4毛钱**(0.37元),相比培训班几万块的学费,非常值了,星球提供的服务可以说**远超**门票价格了。

-

+随着星球内容不断积累,星球定价也会不断**上涨**(最初原价**68**元,现在涨到**188**元了,后面还会持续**上涨**),所以,想提升自己的小伙伴要趁早加入,**早就是优势**(优惠券只有50个名额,用完就恢复**原价**了)。

+

+

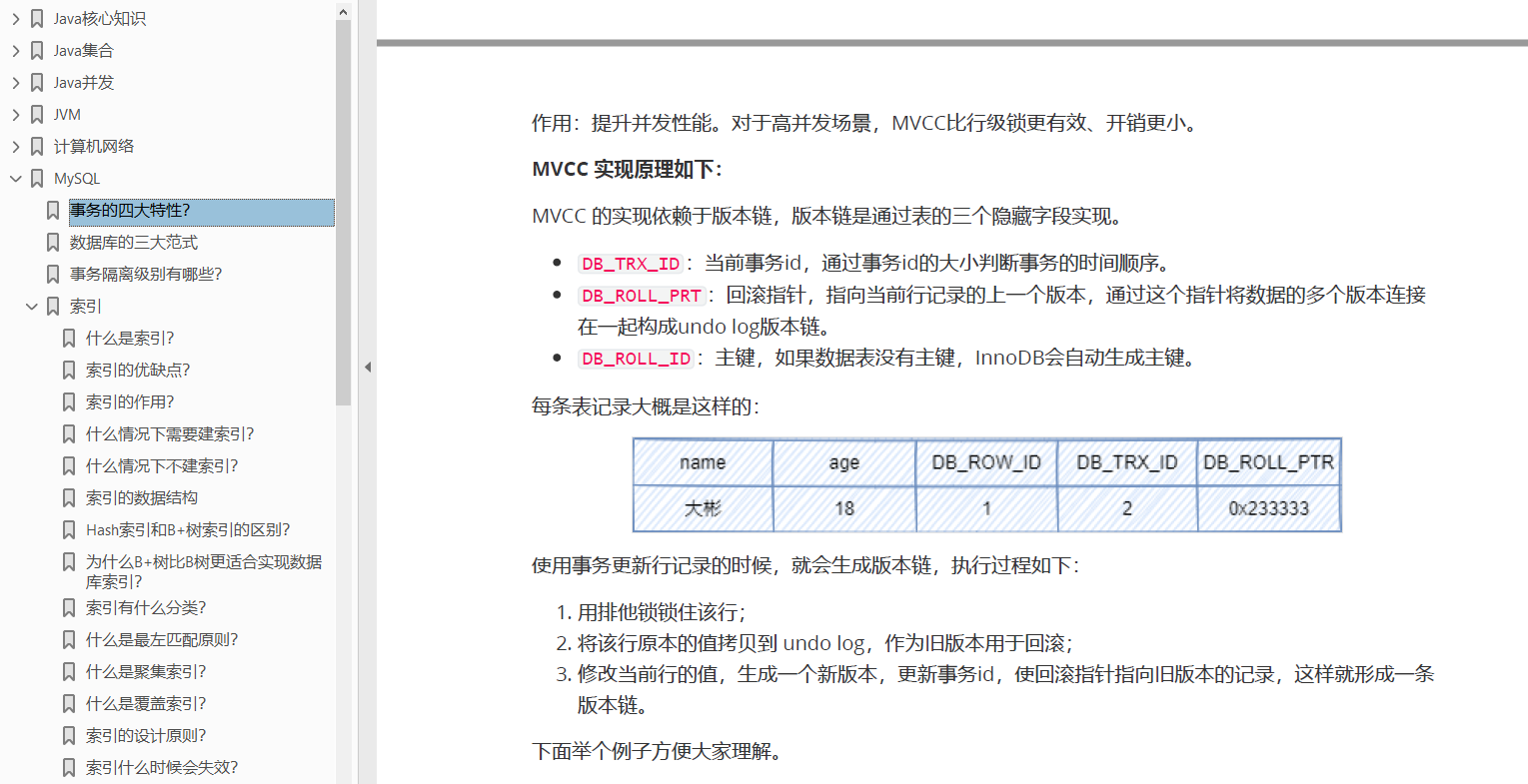

diff --git a/docs/database/mysql.md b/docs/database/mysql.md

index 9559ede..c8b0032 100644

--- a/docs/database/mysql.md

+++ b/docs/database/mysql.md

@@ -20,6 +20,12 @@ head:

:::

+## 更新记录

+

+- 2024.06.05,更新[MySQL查询 limit 1000,10 和limit 10 速度一样快吗?](###MySQL查询 limit 1000,10 和limit 10 速度一样快吗?)

+

+- 2024.5.15,新增[B树和B+树的区别?](###B树和B+树的区别?)

+

## 什么是MySQL

MySQL是一个关系型数据库,它采用表的形式来存储数据。你可以理解成是Excel表格,既然是表的形式存储数据,就有表结构(行和列)。行代表每一行数据,列代表该行中的每个值。列上的值是有数据类型的,比如:整数、字符串、日期等等。

@@ -262,6 +268,18 @@ Index_comment:

- 哈希索引**不支持模糊查询**及多列索引的最左前缀匹配。

- 因为哈希表中会**存在哈希冲突**,所以哈希索引的性能是不稳定的,而B+树索引的性能是相对稳定的,每次查询都是从根节点到叶子节点。

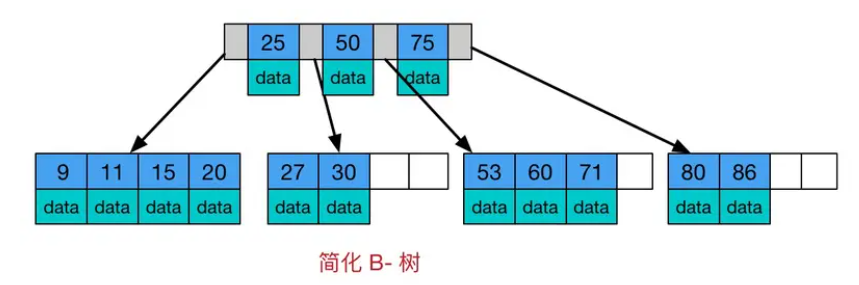

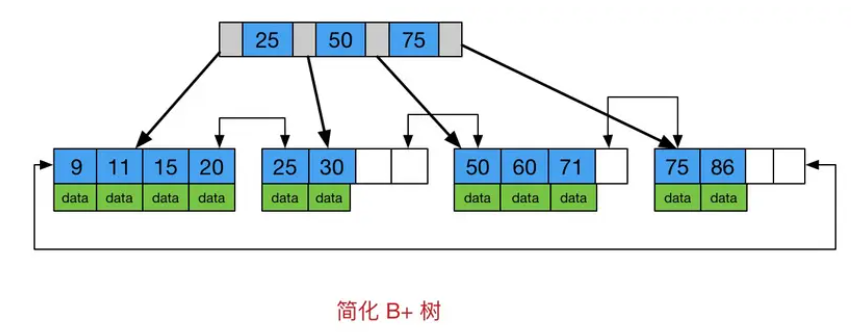

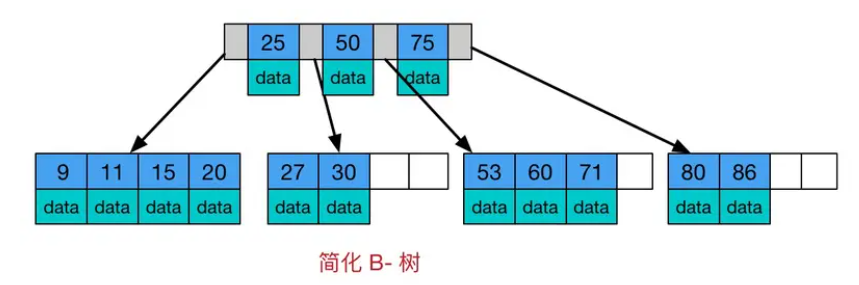

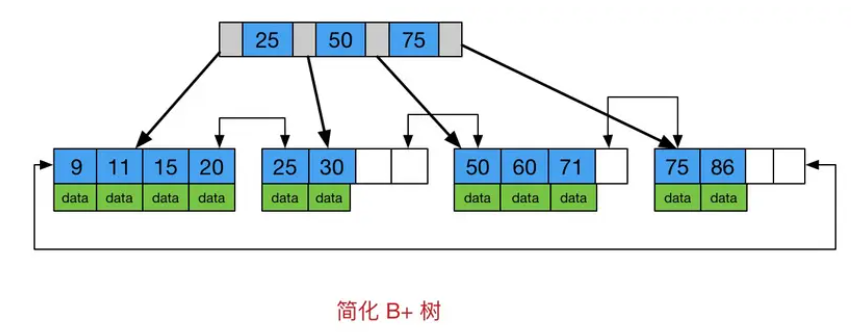

+### B树和B+树的区别?

+

+

+

+

+

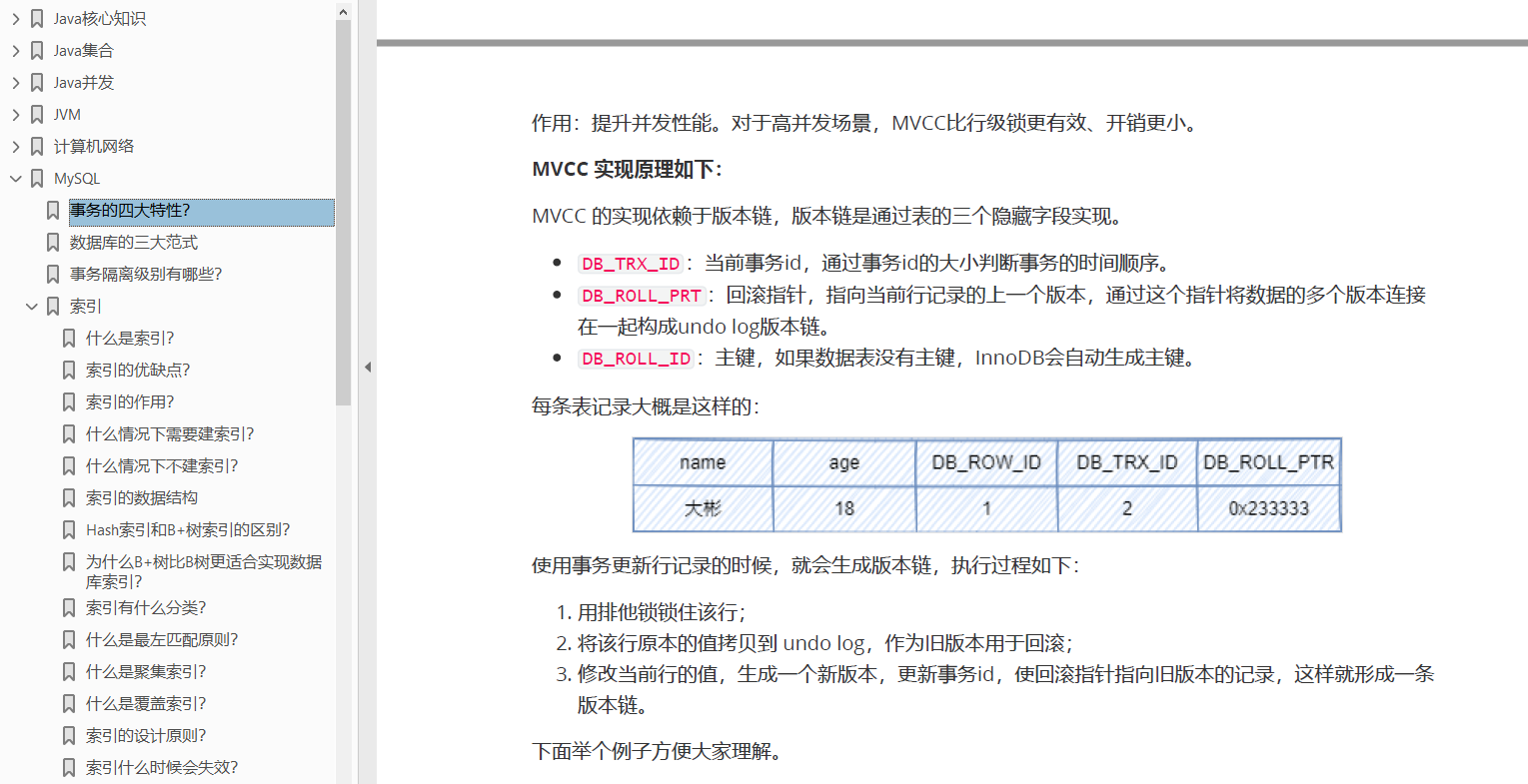

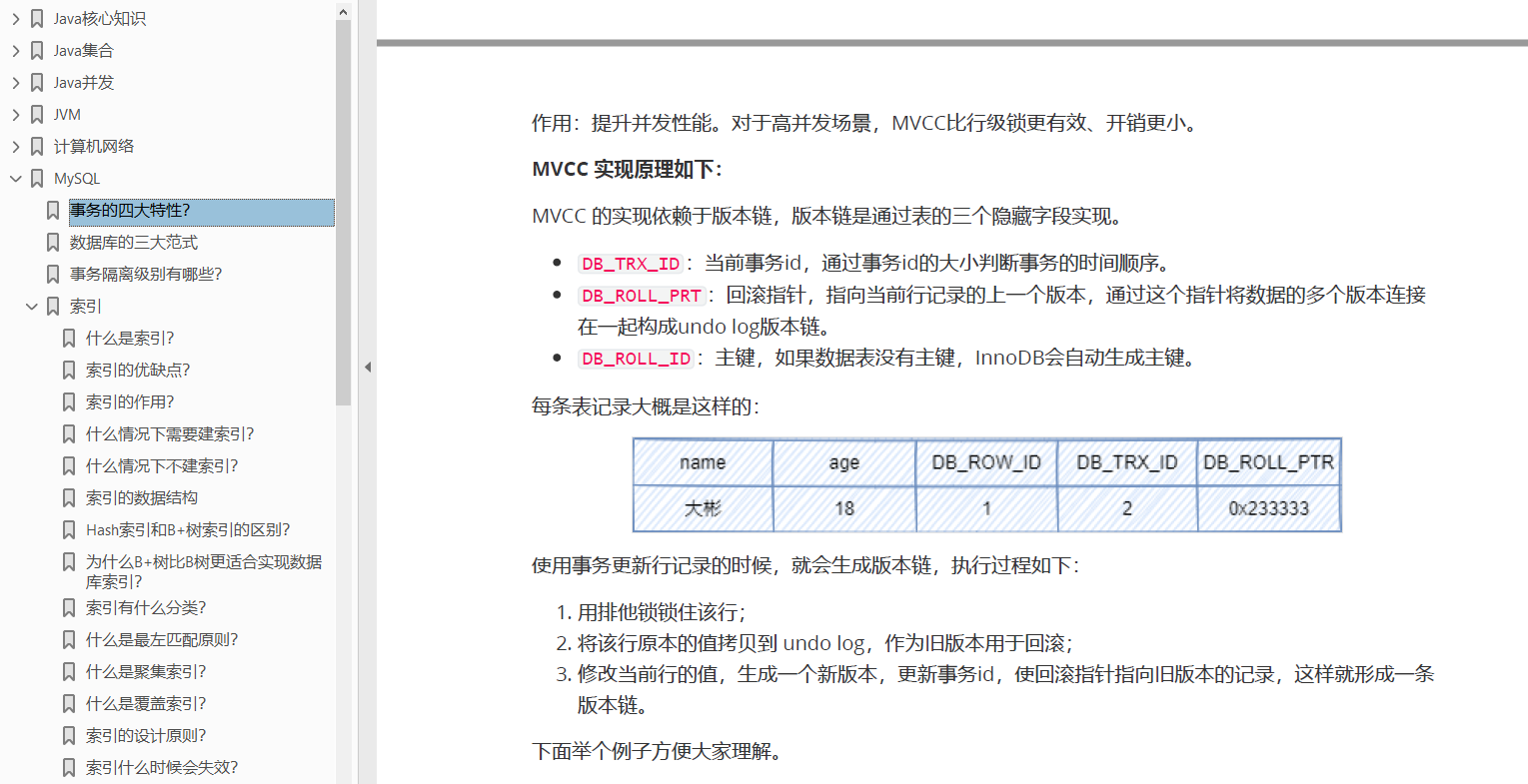

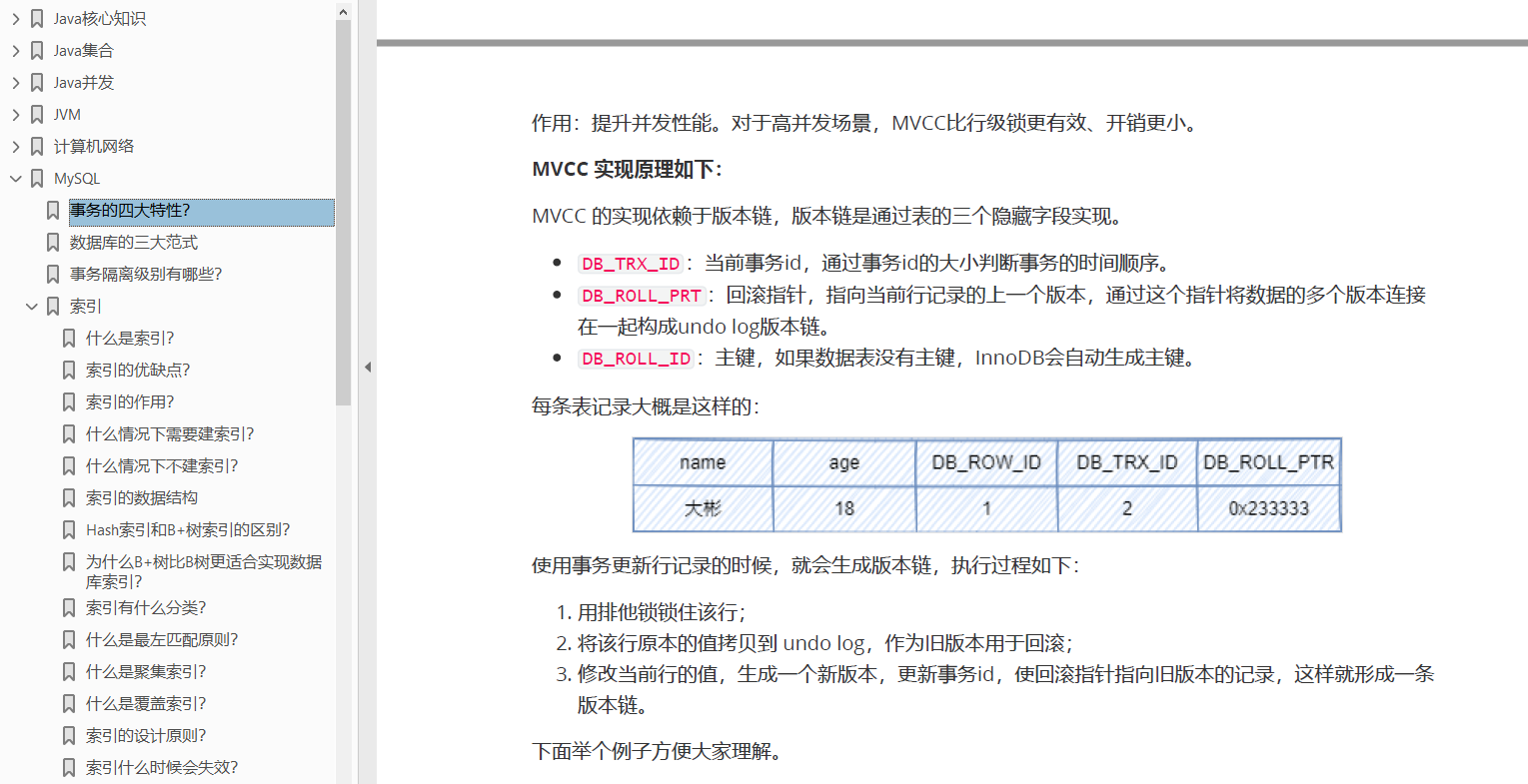

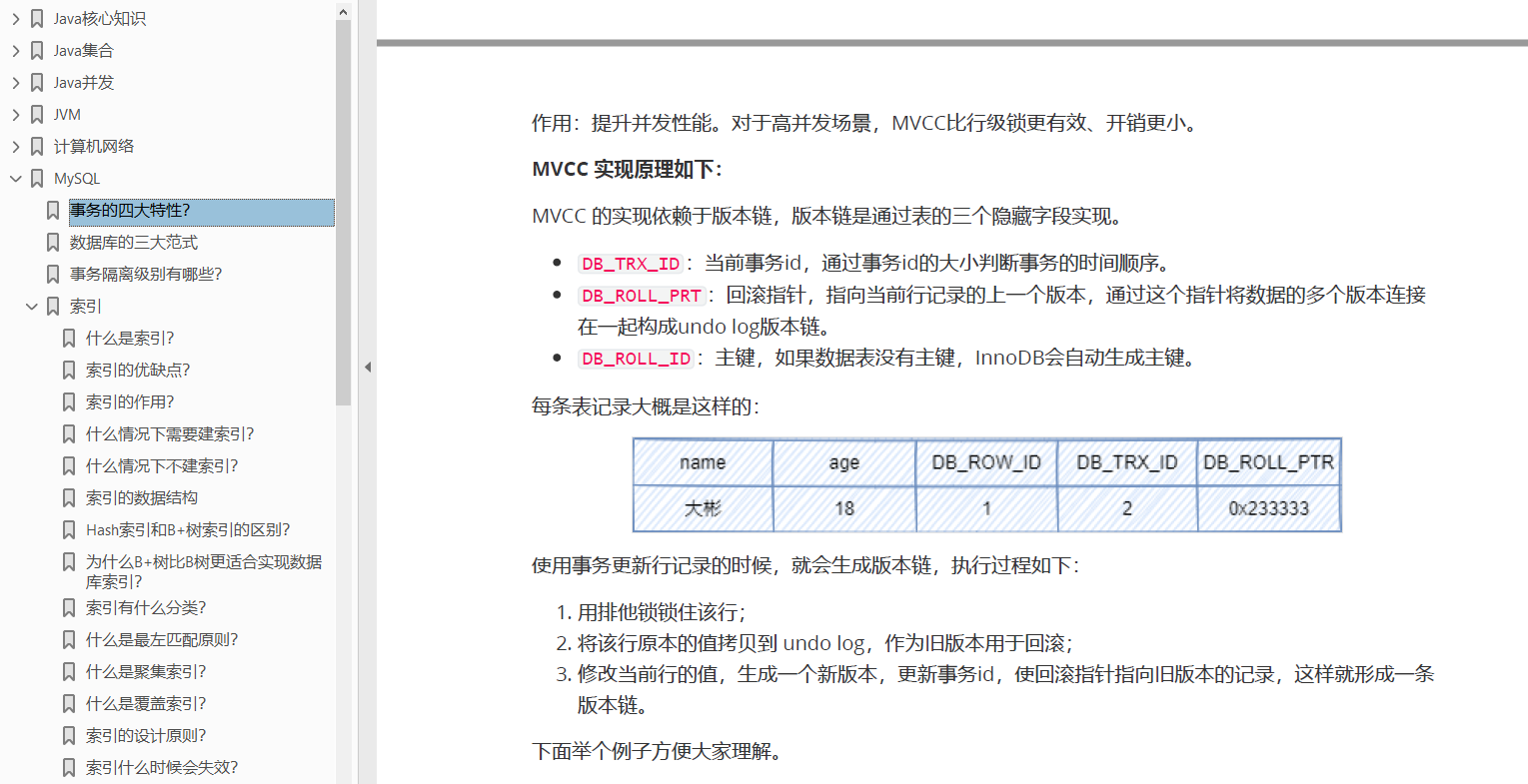

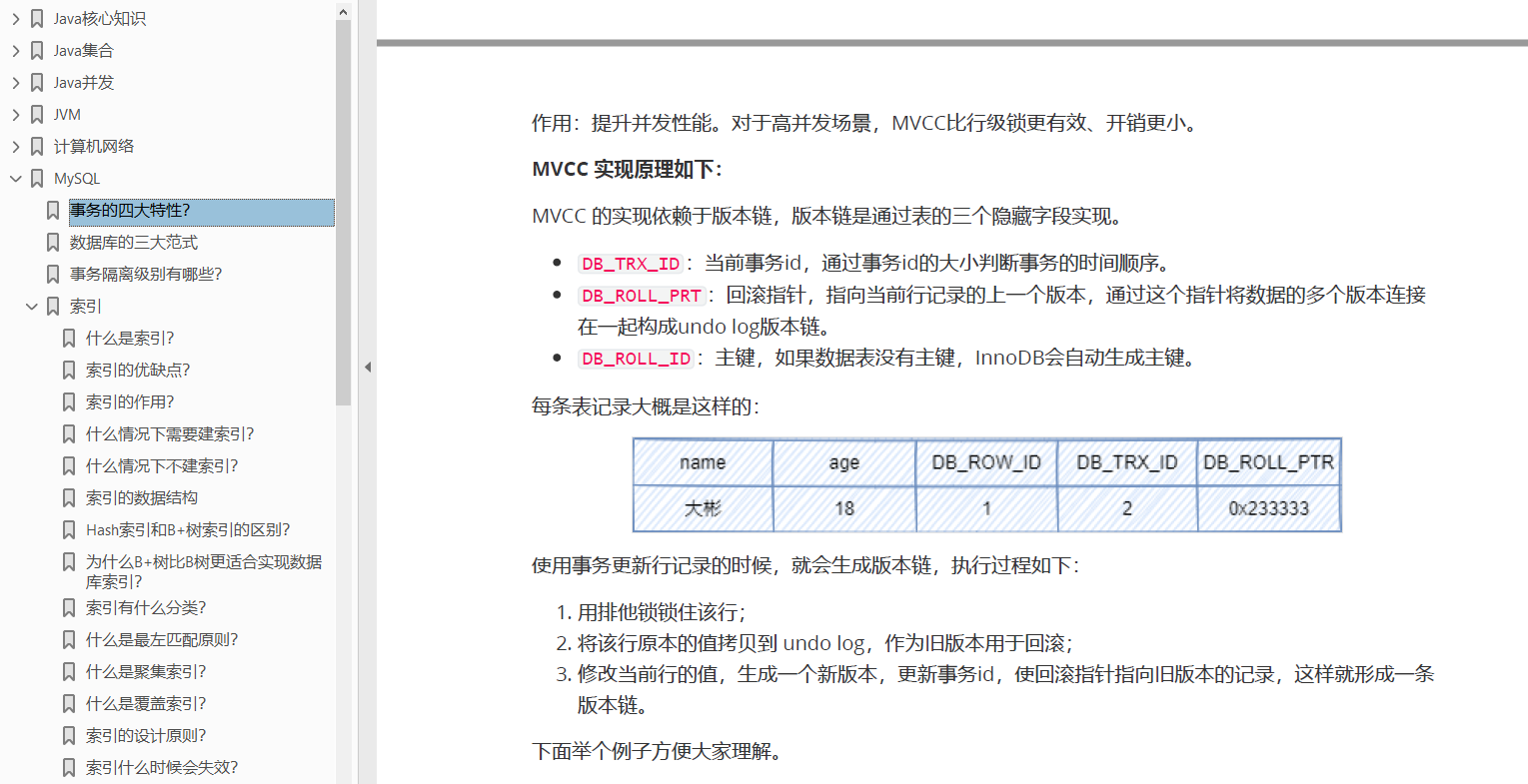

+1. **数据存储方式**:在B树中,每个节点都包含键和对应的值,叶子节点存储了实际的数据记录;而B+树中,仅仅只有叶子节点存储了实际的数据记录,非叶子节点只包含键信息和指向子节点的指针。

+2. **数据检索方式**:在B树中,由于非叶子节点也存储了数据,所以查询时可以直接在非叶子节点找到对应的数据,具有更短的查询路径;

+ 而B+树的所有数据都存储在叶子节点上,只有通过子节点才能获取到完整的数据。

+3. **范围查询效率**:由于B+树的所有数据都存储在叶子节点上,并且叶子节点之间使用链表连接,所以范围查询的效率比较高。而在B树中,范围查询需要通过遍历多个层级的节点,效率相对较低。

+4. **适用场景**:B树适合进行随机读写操作,因为每个节点都包含了数据。而B+树适合进行范围查询和顺序访问,因为数据都存储在叶子节点上,并且叶子节点之间使用链表连接,便于进行顺序遍历。

+

### 为什么B+树比B树更适合实现数据库索引?

- 由于B+树的数据都存储在叶子结点中,叶子结点均为索引,方便扫库,只需要扫一遍叶子结点即可,但是B树因为其分支结点同样存储着数据,我们要找到具体的数据,需要进行一次中序遍历按序来扫,所以B+树更加适合在区间查询的情况,而在数据库中基于范围的查询是非常频繁的,所以通常B+树用于数据库索引。

@@ -1180,4 +1198,38 @@ COUNT(`*`)是SQL92定义的标准统计行数的语法,效率高,MySQL对它

所以,建议使用COUNT(\*)查询表的行数!

+## 存储MD5值应该用VARCHAR还是用CHAR?

+

+首先说说CHAR和VARCHAR的区别:

+

+1、存储长度:

+

+CHAR类型的长度是固定的

+

+当我们当定义CHAR(10),输入的值是"abc",但是它占用的空间一样是10个字节,会包含7个空字节。当输入的字符长度超过指定的数时,CHAR会截取超出的字符。而且,当存储为CHAR的时候,MySQL会自动删除输入字符串末尾的空格。

+

+VARCHAR的长度是可变的

+

+比如VARCHAR(10),然后输入abc三个字符,那么实际存储大小为3个字节。

+

+除此之外,VARCHAR还会保留1个或2个额外的字节来记录字符串的实际长度。如果定义的最大长度小于等于255个字节,那么,就会预留1个字节;如果定义的最大长度大于255个字节,那么就会预留2个字节。

+

+2、存储效率

+

+CHAR类型每次修改后的数据长度不变,效率更高。

+

+VARCHAR每次修改的数据要更新数据长度,效率更低。

+

+3、存储空间

+

+CHAR存储空间是初始的预计长度字符串再加上一个记录字符串长度的字节,可能会存在多余的空间。

+

+VARCHAR存储空间的时候是实际字符串再加上一个记录字符串长度的字节,占用空间较小。

+

+

+

+根据以上的分析,由于MD5是一个定长的值,所以MD5值适合使用CHAR存储。对于固定长度的非常短的列,CHAR比VARCHAR效率也更高。

+

+

+

diff --git "a/docs/database/\344\270\200\346\235\241 SQL \346\237\245\350\257\242\350\257\255\345\217\245\345\246\202\344\275\225\346\211\247\350\241\214\347\232\204.md" "b/docs/database/\344\270\200\346\235\241 SQL \346\237\245\350\257\242\350\257\255\345\217\245\345\246\202\344\275\225\346\211\247\350\241\214\347\232\204.md"

new file mode 100644

index 0000000..94d82b5

--- /dev/null

+++ "b/docs/database/\344\270\200\346\235\241 SQL \346\237\245\350\257\242\350\257\255\345\217\245\345\246\202\344\275\225\346\211\247\350\241\214\347\232\204.md"

@@ -0,0 +1,67 @@

+一条 SQL 查询语句如何执行的

+

+在平常的开发中,可能很多人都是 CRUD,对 SQL 语句的语法很熟练,但是说起一条 SQL 语句在 MySQL 中是怎么执行的却浑然不知,今天大彬就由浅入深,带大家一点点剖析一条 SQL 语句在 MySQL 中是怎么执行的。

+

+比如你执行下面这个 SQL 语句时,我们看到的只是输入一条语句,返回一个结果,却不知道 MySQL 内部的执行过程:

+

+```mysql

+mysql> select * from T where ID=10;

+```

+

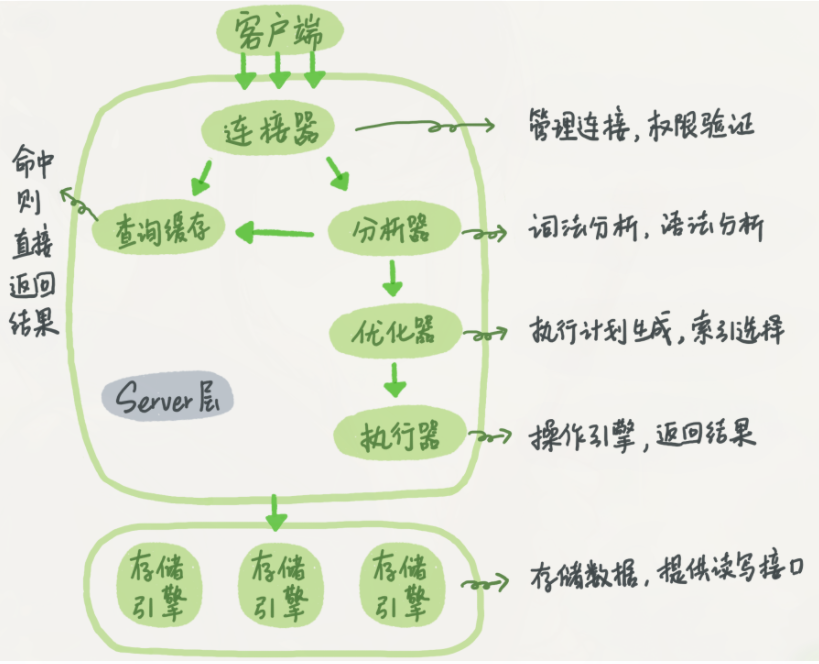

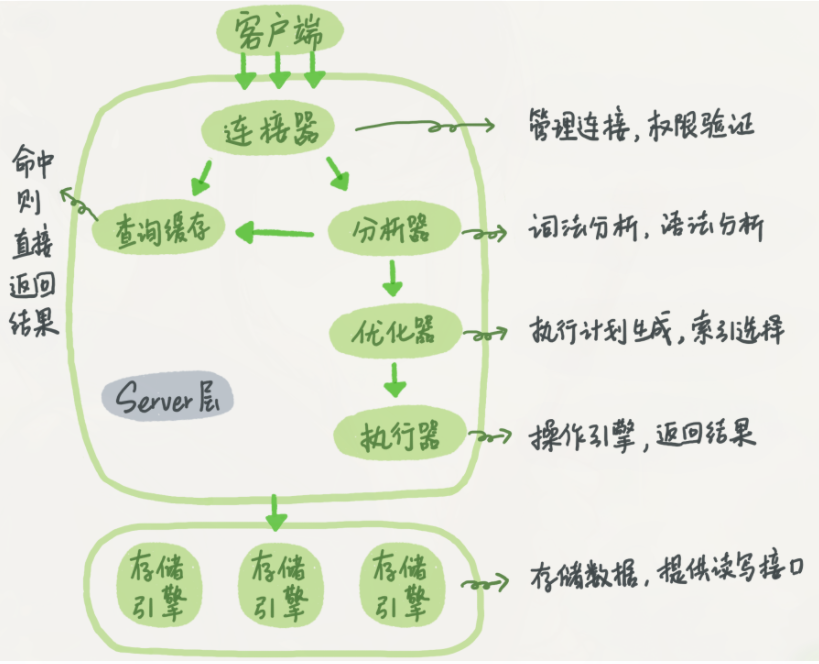

+在剖析这个语句怎么执行之前,我们先看一下 MySQL 的基本架构示意图,能更清楚的看到 SQL 语句在 MySQL 的各个功能模块中的执行过程。

+

+

+

+整体来说,MySQL 可以分为 Server 层和存储引擎两部分。

+

+Server 层包括连接器、查询缓存、分析器、优化器、执行器等,涵盖 MySQL 的大多数核心服务功能,以及所有的内置函数(如日期、时间、数学和加密函数等),所有跨存储引擎的功能都在这一层实现,比如存储过程、触发器、视图等。

+

+### 连接器

+

+如果要操作 MySQL 数据库,我们必须使用 MySQL 客户端来连接 MySQL 服务器,这时候就是服务器中的连接器来负责根客户端建立连接、获取权限、维持和管理连接。

+

+在和服务端完成 TCP 连接后,连接器就要认证身份,需要用到用户名和密码,确保用户有足够的权限执行该SQL语句。

+

+### 查询缓存

+

+建立完连接后,就可以执行查询语句了,来到第二步:查询缓存。

+

+MySQL 拿到第一个查询请求后,会先到查询缓存看看,之前是不是执行过这条语句。之前执行过的语句及其结果可能会以 key-value 对的形式,被直接缓存在内存中,如果你的查询能够直接在这个缓存中找到 key,那么这个 value 就会被直接返回给客户端。

+

+如果语句不在查询缓存中,就会继续后面的执行阶段。执行完成后,执行结果会被存入查询缓存中。你可以看到,如果查询命中缓存,MySQL 不需要执行后面的复杂操作,就可以直接返回结果,这个效率会很高。

+

+### 分析器

+

+如果没有命中缓存,就要开始真正执行语句了,MySQL 首先会对 SQL 语句做解析。

+

+分析器会先做 “词法分析”,MySQL 需要识别出 SQL 里面的字符串分别是什么,代表什么。

+

+做完之后就要做“语法分析”,根据词法分析的结果,语法分析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法。若果语句不对,就会收到错误提醒。

+

+### 优化器

+

+经过了分析器,MySQL 就知道要做什么了,但是在开始执行之前,要先经过优化器的处理。

+

+比如:优化器是在表里面有多个索引的时候,决定使用哪个索引;或者在一个语句有多表关联(join)的时候,决定各个表的连接顺序。

+

+MySQL 会帮我去使用他自己认为的最好的方式去优化这条 SQL 语句,并生成一条条的执行计划,比如你创建了多个索引,MySQL 会依据**成本最小原则**来选择使用对应的索引,这里的成本主要包括两个方面, IO 成本和 CPU 成本。

+

+### 执行器

+

+执行优化之后的执行计划,在开始执行之前,先判断一下用户对这个表有没有执行查询的权限,如果没有,就会返回没有权限的错误;如果有权限,就打开表继续执行。打开表的时候,执行器就会根据表的引擎定义,去使用这个引擎提供的接口。

+

+### 存储引擎

+

+执行器将查询请求发送给存储引擎组件。

+

+存储引擎组件负责具体的数据存储、检索和修改操作。

+

+存储引擎根据执行器的请求,从磁盘或内存中读取或写入相关数据。

+

+### 返回结果

+

+存储引擎将查询结果返回给执行器。

+

+执行器将结果返回给连接器。

+

+最后,连接器将结果发送回客户端,完成整个执行过程。

\ No newline at end of file

diff --git a/docs/framework/mybatis.md b/docs/framework/mybatis.md

index 0337815..b21cb9d 100644

--- a/docs/framework/mybatis.md

+++ b/docs/framework/mybatis.md

@@ -27,6 +27,17 @@ head:

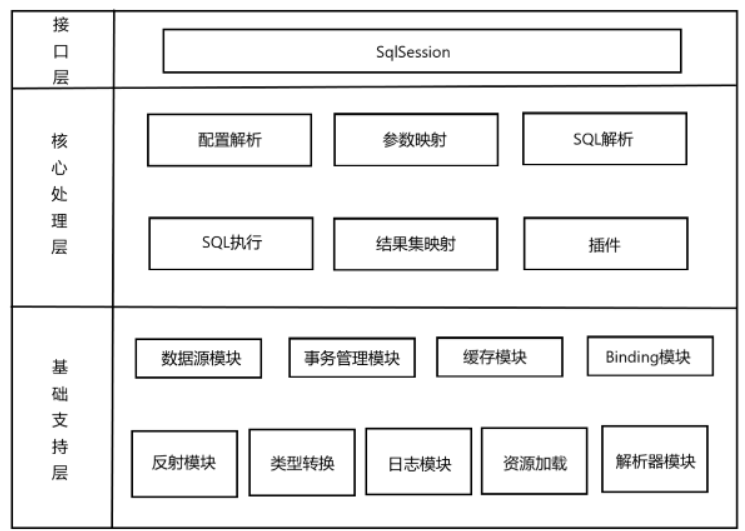

- MyBatis作为持久层框架,其主要思想是将程序中的大量SQL语句剥离出来,配置在配置文件当中,实现SQL的灵活配置。

- 这样做的好处是将SQL与程序代码分离,可以在不修改代码的情况下,直接在配置文件当中修改SQL。

+## 为什么使用Mybatis代替JDBC?

+

+MyBatis 是一种优秀的 ORM(Object-Relational Mapping)框架,与 JDBC 相比,有以下几点优势:

+

+1. 简化了 JDBC 的繁琐操作:使用 JDBC 进行数据库操作需要编写大量的样板代码,如获取连接、创建 Statement/PreparedStatement,设置参数,处理结果集等。而使用 MyBatis 可以将这些操作封装起来,通过简单的配置文件和 SQL 语句就能完成数据库操作,从而大大简化了开发过程。

+2. 提高了 SQL 的可维护性:使用 JDBC 进行数据库操作,SQL 语句通常会散布在代码中的各个位置,当 SQL 语句需要修改时,需要找到所有使用该语句的地方进行修改,这非常不方便,也容易出错。而使用 MyBatis,SQL 语句都可以集中在配置文件中,可以更加方便地修改和维护,同时也提高了 SQL 语句的可读性。

+3. 支持动态 SQL:MyBatis 提供了强大的动态 SQL 功能,可以根据不同的条件生成不同的 SQL 语句,这对于复杂的查询操作非常有用。

+4. 易于集成:MyBatis 可以与 Spring 等流行的框架集成使用,可以通过 XML 或注解配置进行灵活的配置,同时 MyBatis 也提供了非常全面的文档和示例代码,学习和使用 MyBatis 非常方便。

+

+综上所述,使用 MyBatis 可以大大简化数据库操作的代码,提高 SQL 语句的可维护性和可读性,同时还提供了强大的动态 SQL 功能,易于集成使用。因此,相比于直接使用 JDBC,使用 MyBatis 更为便捷、高效和方便。

+

## **ORM是什么**

ORM(Object Relational Mapping),对象关系映射,是一种为了解决关系型数据库数据与简单Java对象(POJO)的映射关系的技术。简单的说,ORM是通过使用描述对象和数据库之间映射的元数据,将程序中的对象自动持久化到关系型数据库中。

@@ -107,7 +118,7 @@ Mybatis仅可以编写针对 `ParameterHandler`、`ResultSetHandler`、`Statemen

编写插件:实现 Mybatis 的 Interceptor 接口并复写 intercept()方法,然后再给插件编写注解,指定要拦截哪一个接口的哪些方法即可,最后在配置文件中配置你编写的插件。

-## .Mybatis 是否支持延迟加载?

+## Mybatis 是否支持延迟加载?

Mybatis 仅支持 association 关联对象和 collection 关联集合对象的延迟加载,association 指的就是一对一,collection 指的就是一对多查询。在 Mybatis 配置文件中,可以配置是否启用延迟加载`lazyLoadingEnabled=true|false`。

diff --git a/docs/framework/spring.md b/docs/framework/spring.md

index 410e4e3..4ea008b 100644

--- a/docs/framework/spring.md

+++ b/docs/framework/spring.md

@@ -102,6 +102,18 @@ AOP有两种实现方式:静态代理和动态代理。

动态代理:代理类在程序运行时创建,AOP框架不会去修改字节码,而是在内存中临时生成一个代理对象,在运行期间对业务方法进行增强,不会生成新类。

+> 分享一份大彬精心整理的大厂面试手册,包含计**算机基础、Java基础、多线程、JVM、数据库、Redis、Spring、Mybatis、SpringMVC、SpringBoot、分布式、微服务、设计模式、架构、校招社招分享**等高频面试题,非常实用,有小伙伴靠着这份手册拿过字节offer~

+>

+>

+>

+>

+>

+> 需要的小伙伴可以自行**下载**:

+>

+> 链接:https://pan.xunlei.com/s/VNgU60NQQNSDaEy9z955oufbA1?pwd=y9fy#

+>

+> 备用链接:https://pan.quark.cn/s/cbbb681e7c19

+

## Spring AOP的实现原理

`Spring`的`AOP`实现原理其实很简单,就是通过**动态代理**实现的。如果我们为`Spring`的某个`bean`配置了切面,那么`Spring`在创建这个`bean`的时候,实际上创建的是这个`bean`的一个代理对象,我们后续对`bean`中方法的调用,实际上调用的是代理类重写的代理方法。而`Spring`的`AOP`使用了两种动态代理,分别是**JDK的动态代理**,以及**CGLib的动态代理**。

@@ -977,4 +989,14 @@ Spring常用的注入方式有:属性注入, 构造方法注入, set 方法注

+> 最后给大家分享**200多本计算机经典书籍PDF电子书**,包括**C语言、C++、Java、Python、前端、数据库、操作系统、计算机网络、数据结构和算法、机器学习、编程人生**等,感兴趣的小伙伴可以自取:

+>

+>

+>

+>

+>

+> **200多本计算机经典书籍PDF电子书**:https://pan.xunlei.com/s/VNlmlh9jBl42w0QH2l4AJaWGA1?pwd=j8eq#

+>

+> 备用链接:https://pan.quark.cn/s/3f1321952a16

+

diff --git a/docs/framework/springboot.md b/docs/framework/springboot.md

index 496473c..a0b52ad 100644

--- a/docs/framework/springboot.md

+++ b/docs/framework/springboot.md

@@ -60,12 +60,78 @@ starter提供了一个自动化配置类,一般命名为 XXXAutoConfiguration

启动类上面的注解是@SpringBootApplication,它也是 Spring Boot 的核心注解,主要组合包含了以下 3 个注解:

+- @SpringBootConfiguration:组合了 @Configuration 注解,实现配置文件的功能。

+- @EnableAutoConfiguration:打开自动配置的功能,也可以关闭某个自动配置的选项,如关闭数据源自动配置功能: @SpringBootApplication(exclude = { DataSourceAutoConfiguration.class })。

+- @ComponentScan:Spring组件扫描。

+

+## 有哪些常用的SpringBoot注解?

+

+- @SpringBootApplication。这个注解是Spring Boot最核心的注解,用在 Spring Boot的主类上,标识这是一个 Spring Boot 应用,用来开启 Spring Boot 的各项能力

+

- @SpringBootConfiguration:组合了 @Configuration 注解,实现配置文件的功能。

- @EnableAutoConfiguration:打开自动配置的功能,也可以关闭某个自动配置的选项,如关闭数据源自动配置功能: @SpringBootApplication(exclude = { DataSourceAutoConfiguration.class })。

- @ComponentScan:Spring组件扫描。

+- @Repository:用于标注数据访问组件,即DAO组件。

+

+- @Service:一般用于修饰service层的组件

+

+- **@RestController**。用于标注控制层组件(如struts中的action),表示这是个控制器bean,并且是将函数的返回值直 接填入HTTP响应体中,是REST风格的控制器;它是@Controller和@ResponseBody的合集。

+

+- **@ResponseBody**。表示该方法的返回结果直接写入HTTP response body中

+

+- **@Component**。泛指组件,当组件不好归类的时候,我们可以使用这个注解进行标注。

+

+- **@Bean**,相当于XML中的``,放在方法的上面,而不是类,意思是产生一个bean,并交给spring管理。

+

+- **@AutoWired**,byType方式。把配置好的Bean拿来用,完成属性、方法的组装,它可以对类成员变量、方法及构造函数进行标注,完成自动装配的工作。

+

+- **@Qualifier**。当有多个同一类型的Bean时,可以用@Qualifier("name")来指定。与@Autowired配合使用

+

+- **@Resource(name="name",type="type")**。没有括号内内容的话,默认byName。与@Autowired干类似的事。

+

+- **@RequestMapping**

+

+ RequestMapping是一个用来处理请求地址映射的注解;提供路由信息,负责URL到Controller中的具体函数的映射,可用于类或方法上。用于类上,表示类中的所有响应请求的方法都是以该地址作为父路径。

+

+- **@RequestParam**

+

+ 用在方法的参数前面。

+

+- ### @Scope

+

+ 用于声明一个Spring`Bean`实例的作用域

+

+- ### @Primary

+

+ 当同一个对象有多个实例时,优先选择该实例。

+

+- ### @PostConstruct

+

+ 用于修饰方法,当对象实例被创建并且依赖注入完成后执行,可用于对象实例的初始化操作。

+

+- ### @PreDestroy

+

+ 用于修饰方法,当对象实例将被Spring容器移除时执行,可用于对象实例持有资源的释放。

+

+- ### @EnableTransactionManagement

+

+ 启用Spring基于注解的事务管理功能,需要和`@Configuration`注解一起使用。

+

+- ### @Transactional

+

+ 表示方法和类需要开启事务,当作用与类上时,类中所有方法均会开启事务,当作用于方法上时,方法开启事务,方法上的注解无法被子类所继承。

+

+- ### @ControllerAdvice

+

+ 常与`@ExceptionHandler`注解一起使用,用于捕获全局异常,能作用于所有controller中。

+

+- ### @ExceptionHandler

+

+ 修饰方法时,表示该方法为处理全局异常的方法。

+

## 自动配置原理

SpringBoot实现自动配置原理图解:

diff --git a/docs/framework/springboot/springboot-cross-domain.md b/docs/framework/springboot/springboot-cross-domain.md

index fa7dac3..b93a909 100644

--- a/docs/framework/springboot/springboot-cross-domain.md

+++ b/docs/framework/springboot/springboot-cross-domain.md

@@ -90,4 +90,4 @@ public class AccountController {

6、打卡学习,**大学自习室的氛围**,一起蜕变成长

-

\ No newline at end of file

+

\ No newline at end of file

diff --git a/docs/framework/springcloud-interview.md b/docs/framework/springcloud-interview.md

index 619e950..f95f36b 100644

--- a/docs/framework/springcloud-interview.md

+++ b/docs/framework/springcloud-interview.md

@@ -24,17 +24,66 @@ head:

:::

+## 更新记录

+

+- 2024.5.15,完善[Spring、SpringMVC、Springboot、 Springcloud 的区别是什么?](##Spring、SpringMVC、Springboot、 Springcloud 的区别是什么?)

## 1、什么是Spring Cloud ?

Spring cloud 流应用程序启动器是基于 Spring Boot 的 Spring 集成应用程序,提供与外部系统的集成。Spring cloud Task,一个生命周期短暂的微服务框架,用于快速构建执行有限数据处理的应用程序。

-## spring、 springboot、 springcloud 的区别是什么?

+

+

+Spring cloud 流应用程序启动器是基于 Spring Boot 的 Spring 集成应用程序,提供与外部系统的集成。Spring cloud Task,一个生命周期短暂的微服务框架,用于快速构建执行有限数据处理的应用程序。

+

+## Spring、SpringMVC、Springboot、 Springcloud 的区别是什么?

+

+### Spring

+

+Spring是一个生态体系(也可以说是技术体系),是集大成者,它包含了Spring Framework、Spring Boot、Spring Cloud等。**它是一个轻量级控制反转(IOC)和面向切面(AOP)的容器框架**,为开发者提供了一个简易的开发方式。

+

+Spring的核心特性思想之一IOC,它实现了容器对Bean对象的管理、降低组件耦合,使各层服务解耦。

+

+Spring的另一个核心特性就是AOP,面向切面编程。面向切面编程需要将程序逻辑分解为称为所谓关注点的不同部分。跨越应用程序多个点的功能称为跨领域问题,这些跨领域问题在概念上与应用程序的业务逻辑分离。有许多常见的例子,如日志记录,声明式事务,安全性,缓存等。

+

+**如果说IOC依赖注入可以帮助我们将应用程序对象相互分离,那么AOP可以帮助我们将交叉问题与它们所影响的对象分离。二者目的都是使服务解耦,使开发简易。**

+

+当然,除了Spring 的两大核心功能,还有如下这些,如:

+

+- Spring JDBC

+- Spring MVC

+- Spring ORM

+- Spring Test

-Spring是一个生态体系(也可以说是技术体系),是集大成者,它包含了Spring Framework、Spring Boot、Spring Cloud等。

+### SpringMVC

+

+Spring与MVC可以更好地解释什么是SpringMVC,MVC为现代web项目开发的一种很常见的模式,简言之C(控制器)将V(视图、用户客户端)与M(模块,业务)分开构成了MVC ,业内常见的MVC模式的开发框架有Struts。

+

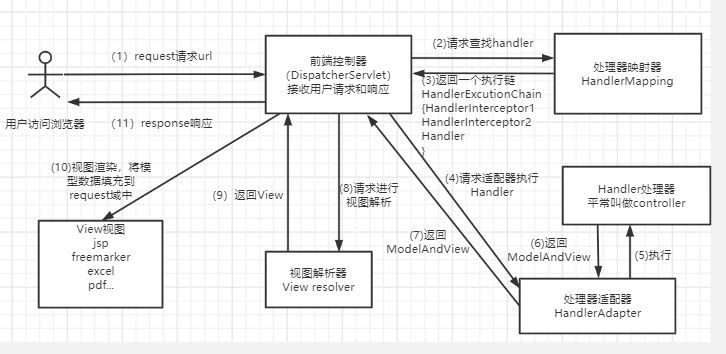

+Spring MVC是Spring的一部分,主要用于开发WEB应用和网络接口,它是Spring的一个模块,通过DispatcherServlet, ModelAndView 和View Resolver,让应用开发变得很容易。

+

+### SpringBoot

+

+SpringBoot是一套整合了框架的框架。

+

+它的初衷:解决Spring框架配置文件的繁琐、搭建服务的复杂性。

+

+它的设计理念:**约定优于配置**(convention over configuration)。

+

+基于此理念实现了**自动配置**,且降低项目搭建的复杂度。

+

+搭建一个接口服务,通过SpringBoot几行代码即可实现。基于Spring Boot,不是说原来的配置没有了,而是Spring Boot有一套默认配置,我们可以把它看做比较通用的约定,而Spring Boot遵循的是**约定优于配置**原则,同时,如果你需要使用到Spring以往提供的各种复杂但功能强大的配置功能,Spring Boot一样支持。

+

+在Spring Boot中,你会发现引入的所有包都是starter形式,如:

+

+- spring-boot-starter-web-services,针对SOAP Web Services

+- spring-boot-starter-web,针对Web应用与网络接口

+- spring-boot-starter-jdbc,针对JDBC

+- spring-boot-starter-cache,针对缓存支持

Spring Boot是基于 Spring 框架开发的用于开发 Web 应用程序的框架,它帮助开发人员快速搭建和配置一个独立的、可执行的、基于 Spring 的应用程序,从而减少了繁琐和重复的配置工作。

+### Spring Cloud

+

Spring Cloud事实上是一整套基于Spring Boot的微服务解决方案。它为开发者提供了很多工具,用于快速构建分布式系统的一些通用模式,例如:配置管理、注册中心、服务发现、限流、网关、链路追踪等。Spring Boot是build anything,而Spring Cloud是coordinate anything,Spring Cloud的每一个微服务解决方案都是基于Spring Boot构建的。

## 2、什么是微服务?

diff --git a/docs/framework/springmvc.md b/docs/framework/springmvc.md

index e6a39b6..6bf2369 100644