diff --git a/README.md b/README.md

index c86501d0598..b5e832382ec 100755

--- a/README.md

+++ b/README.md

@@ -1,6 +1,9 @@

-推荐你通过在线阅读网站进行阅读,体验更好,速度更快!地址:[javaguide.cn](https://javaguide.cn/)。

+# JavaGuide

-[ ](https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html)

+> I recommend reading through online reading websites for a better experience and faster speed!

+> 📚 Address: [javaguide.cn](https://javaguide.cn/)

+

+[

](https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html)

+> I recommend reading through online reading websites for a better experience and faster speed!

+> 📚 Address: [javaguide.cn](https://javaguide.cn/)

+

+[ ](https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html)

](https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html)

@@ -10,437 +13,129 @@

-> - **面试专版**:准备 Java 面试的小伙伴可以考虑面试专版:**[《Java 面试指北 》](./docs/zhuanlan/java-mian-shi-zhi-bei.md)** (质量很高,专为面试打造,配合 JavaGuide 食用)。

-> - **知识星球**:专属面试小册/一对一交流/简历修改/专属求职指南,欢迎加入 **[JavaGuide 知识星球](./docs/about-the-author/zhishixingqiu-two-years.md)**(点击链接即可查看星球的详细介绍,一定确定自己真的需要再加入)。

-> - **使用建议** :有水平的面试官都是顺着项目经历挖掘技术问题。一定不要死记硬背技术八股文!详细的学习建议请参考:[JavaGuide 使用建议](./docs/javaguide/use-suggestion.md)。

-> - **求个Star**:如果觉得 JavaGuide 的内容对你有帮助的话,还请点个免费的 Star,这是对我最大的鼓励,感谢各位一起同行,共勉!Github 地址:[https://github.com/Snailclimb/JavaGuide](https://github.com/Snailclimb/JavaGuide) 。

-> - **转载须知**:以下所有文章如非文首说明为转载皆为 JavaGuide 原创,转载请在文首注明出处。如发现恶意抄袭/搬运,会动用法律武器维护自己的权益。让我们一起维护一个良好的技术创作环境!

+---

+

+> - **Interview Special Edition**: Preparing for Java interviews? Check out the Interview Special Edition: **[Java Interview Guide](./docs/zhuanlan/java-mian-shi-zhi-bei.md)** — high quality and tailored for interview prep, meant to be used alongside JavaGuide.

+> - **Knowledge Planet**: For exclusive interview booklets, one-on-one communication, resume help, and job-seeking guidance, consider joining **[JavaGuide Knowledge Planet](./docs/about-the-author/zhishixingqiu-two-years.md)**.

+> - **Usage Suggestions**: Don't memorize jargon! Interviewers care about real-world application. Check out our [Usage Suggestions](./docs/javaguide/use-suggestion.md).

+> - **Request a Star**: If JavaGuide helps you, please ⭐ the project — it means a lot! GitHub: [https://github.com/Snailclimb/JavaGuide](https://github.com/Snailclimb/JavaGuide)

+> - **Reprint Notice**: All articles are original unless otherwise noted. Please include a source link when sharing. Unauthorized use may result in legal action.

-

+

-

-每种方式都有各自的优势,根据实际场景选择最合适的才是王道。下面再对这三种方式做一个简单的对比,以供大家实际开发中选择正确的存放时间的数据类型:

-

-| 类型 | 存储空间 | 日期格式 | 日期范围 | 是否带时区信息 |

-| ------------ | -------- | ------------------------------ | ------------------------------------------------------------ | -------------- |

-| DATETIME | 5~8 字节 | YYYY-MM-DD hh:mm:ss[.fraction] | 1000-01-01 00:00:00[.000000] ~ 9999-12-31 23:59:59[.999999] | 否 |

-| TIMESTAMP | 4~7 字节 | YYYY-MM-DD hh:mm:ss[.fraction] | 1970-01-01 00:00:01[.000000] ~ 2038-01-19 03:14:07[.999999] | 是 |

-| 数值型时间戳 | 4 字节 | 全数字如 1578707612 | 1970-01-01 00:00:01 之后的时间 | 否 |

-

-**选择建议小结:**

-

-- `TIMESTAMP` 的核心优势在于其内建的时区处理能力。数据库负责 UTC 存储和基于会话时区的自动转换,简化了需要处理多时区应用的开发。如果应用需要处理多时区,或者希望数据库能自动管理时区转换,`TIMESTAMP` 是自然的选择(注意其时间范围限制,也就是 2038 年问题)。

-- 如果应用场景不涉及时区转换,或者希望应用程序完全控制时区逻辑,并且需要表示 2038 年之后的时间,`DATETIME` 是更稳妥的选择。

-- 如果极度关注比较性能,或者需要频繁跨系统传递时间数据,并且可以接受可读性的牺牲(或总是在应用层转换),数值时间戳是一个强大的选项。

-

-

+Insert a

diff --git a/docs/database/mysql/transaction-isolation-level.md b/docs/database/mysql/transaction-isolation-level.md

index 52ad40f4a47..46b60051291 100644

--- a/docs/database/mysql/transaction-isolation-level.md

+++ b/docs/database/mysql/transaction-isolation-level.md

@@ -1,33 +1,33 @@

---

-title: MySQL事务隔离级别详解

-category: 数据库

+title: Detailed Explanation of MySQL Transaction Isolation Levels

+category: Database

tag:

- MySQL

---

-> 本文由 [SnailClimb](https://github.com/Snailclimb) 和 [guang19](https://github.com/guang19) 共同完成。

+> This article is co-authored by [SnailClimb](https://github.com/Snailclimb) and [guang19](https://github.com/guang19).

-关于事务基本概览的介绍,请看这篇文章的介绍:[MySQL 常见知识点&面试题总结](./mysql-questions-01.md#MySQL-事务)

+For an overview of transactions, please refer to this article: [Summary of Common MySQL Knowledge Points & Interview Questions](./mysql-questions-01.md#MySQL-%E4%BA%8B%E5%8A%A1)

-## 事务隔离级别总结

+## Summary of Transaction Isolation Levels

-SQL 标准定义了四个隔离级别:

+The SQL standard defines four isolation levels:

-- **READ-UNCOMMITTED(读取未提交)** :最低的隔离级别,允许读取尚未提交的数据变更,可能会导致脏读、幻读或不可重复读。

-- **READ-COMMITTED(读取已提交)** :允许读取并发事务已经提交的数据,可以阻止脏读,但是幻读或不可重复读仍有可能发生。

-- **REPEATABLE-READ(可重复读)** :对同一字段的多次读取结果都是一致的,除非数据是被本身事务自己所修改,可以阻止脏读和不可重复读,但幻读仍有可能发生。

-- **SERIALIZABLE(可串行化)** :最高的隔离级别,完全服从 ACID 的隔离级别。所有的事务依次逐个执行,这样事务之间就完全不可能产生干扰,也就是说,该级别可以防止脏读、不可重复读以及幻读。

+- **READ-UNCOMMITTED**: The lowest isolation level, allowing reading of uncommitted data changes, which may lead to dirty reads, phantom reads, or non-repeatable reads.

+- **READ-COMMITTED**: Allows reading of data that has been committed by concurrent transactions, preventing dirty reads, but phantom reads or non-repeatable reads may still occur.

+- **REPEATABLE-READ**: Ensures that multiple reads of the same field yield consistent results unless the data is modified by the transaction itself. It prevents dirty reads and non-repeatable reads, but phantom reads may still occur.

+- **SERIALIZABLE**: The highest isolation level, fully compliant with the ACID isolation level. All transactions are executed sequentially, preventing any interference between transactions, meaning this level can prevent dirty reads, non-repeatable reads, and phantom reads.

----

+______________________________________________________________________

-| 隔离级别 | 脏读 | 不可重复读 | 幻读 |

-| :--------------: | :--: | :--------: | :--: |

-| READ-UNCOMMITTED | √ | √ | √ |

-| READ-COMMITTED | × | √ | √ |

-| REPEATABLE-READ | × | × | √ |

-| SERIALIZABLE | × | × | × |

+| Isolation Level | Dirty Read | Non-repeatable Read | Phantom Read |

+| :--------------: | :--------: | :-----------------: | :----------: |

+| READ-UNCOMMITTED | √ | √ | √ |

+| READ-COMMITTED | × | √ | √ |

+| REPEATABLE-READ | × | × | √ |

+| SERIALIZABLE | × | × | × |

-MySQL InnoDB 存储引擎的默认支持的隔离级别是 **REPEATABLE-READ(可重读)**。我们可以通过`SELECT @@tx_isolation;`命令来查看,MySQL 8.0 该命令改为`SELECT @@transaction_isolation;`

+The default isolation level supported by the MySQL InnoDB storage engine is **REPEATABLE-READ**. We can check this using the command `SELECT @@tx_isolation;`, which in MySQL 8.0 has changed to `SELECT @@transaction_isolation;`

```sql

MySQL> SELECT @@tx_isolation;

@@ -38,78 +38,34 @@ MySQL> SELECT @@tx_isolation;

+-----------------+

```

-从上面对 SQL 标准定义了四个隔离级别的介绍可以看出,标准的 SQL 隔离级别定义里,REPEATABLE-READ(可重复读)是不可以防止幻读的。

+From the introduction above regarding the four isolation levels defined by the SQL standard, it can be seen that the standard SQL isolation level definition does not prevent phantom reads for REPEATABLE-READ.

-但是!InnoDB 实现的 REPEATABLE-READ 隔离级别其实是可以解决幻读问题发生的,主要有下面两种情况:

+However! The REPEATABLE-READ isolation level implemented by InnoDB can actually resolve the issue of phantom reads, mainly in the following two situations:

-- **快照读**:由 MVCC 机制来保证不出现幻读。

-- **当前读**:使用 Next-Key Lock 进行加锁来保证不出现幻读,Next-Key Lock 是行锁(Record Lock)和间隙锁(Gap Lock)的结合,行锁只能锁住已经存在的行,为了避免插入新行,需要依赖间隙锁。

+- **Snapshot Read**: Ensured by the MVCC mechanism to prevent phantom reads.

+- **Current Read**: Uses Next-Key Lock for locking to prevent phantom reads. Next-Key Lock is a combination of row locks (Record Lock) and gap locks (Gap Lock). Row locks can only lock existing rows, and to prevent the insertion of new rows, gap locks are relied upon.

-因为隔离级别越低,事务请求的锁越少,所以大部分数据库系统的隔离级别都是 **READ-COMMITTED** ,但是你要知道的是 InnoDB 存储引擎默认使用 **REPEATABLE-READ** 并不会有任何性能损失。

+Since lower isolation levels require fewer locks for transaction requests, most database systems use **READ-COMMITTED** as the default isolation level. However, it is important to note that the InnoDB storage engine's default use of **REPEATABLE-READ** does not incur any performance loss.

-InnoDB 存储引擎在分布式事务的情况下一般会用到 SERIALIZABLE 隔离级别。

+In distributed transactions, the InnoDB storage engine generally uses the SERIALIZABLE isolation level.

-《MySQL 技术内幕:InnoDB 存储引擎(第 2 版)》7.7 章这样写到:

+Chapter 7.7 of "MySQL Internals: InnoDB Storage Engine (2nd Edition)" states:

-> InnoDB 存储引擎提供了对 XA 事务的支持,并通过 XA 事务来支持分布式事务的实现。分布式事务指的是允许多个独立的事务资源(transactional resources)参与到一个全局的事务中。事务资源通常是关系型数据库系统,但也可以是其他类型的资源。全局事务要求在其中的所有参与的事务要么都提交,要么都回滚,这对于事务原有的 ACID 要求又有了提高。另外,在使用分布式事务时,InnoDB 存储引擎的事务隔离级别必须设置为 SERIALIZABLE。

+> The InnoDB storage engine provides support for XA transactions and uses XA transactions to support the implementation of distributed transactions. Distributed transactions allow multiple independent transactional resources to participate in a global transaction. Transactional resources are typically relational database systems, but can also include other types of resources. A global transaction requires that all participating transactions either commit or roll back, which raises the original ACID requirements for transactions. Additionally, when using distributed transactions, the transaction isolation level of the InnoDB storage engine must be set to SERIALIZABLE.

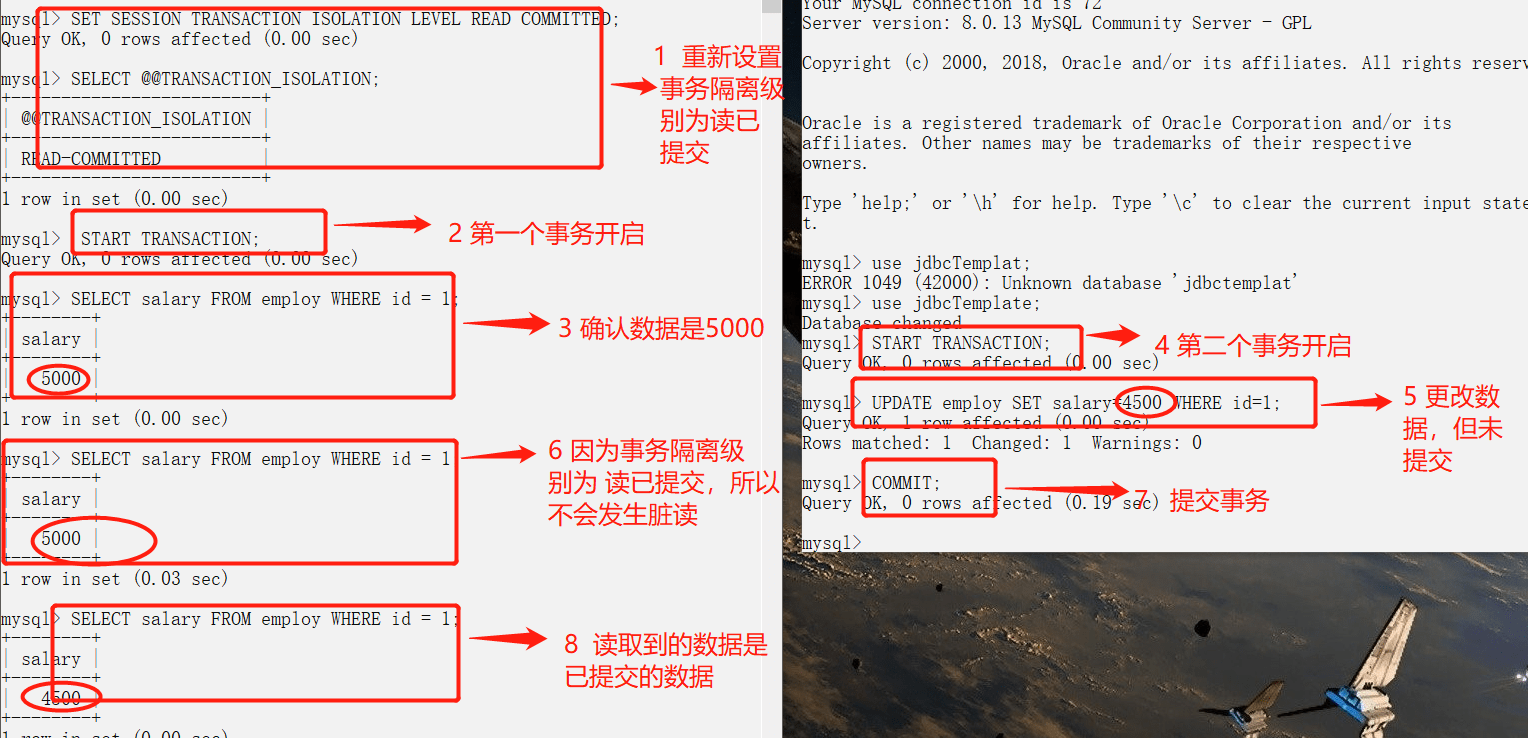

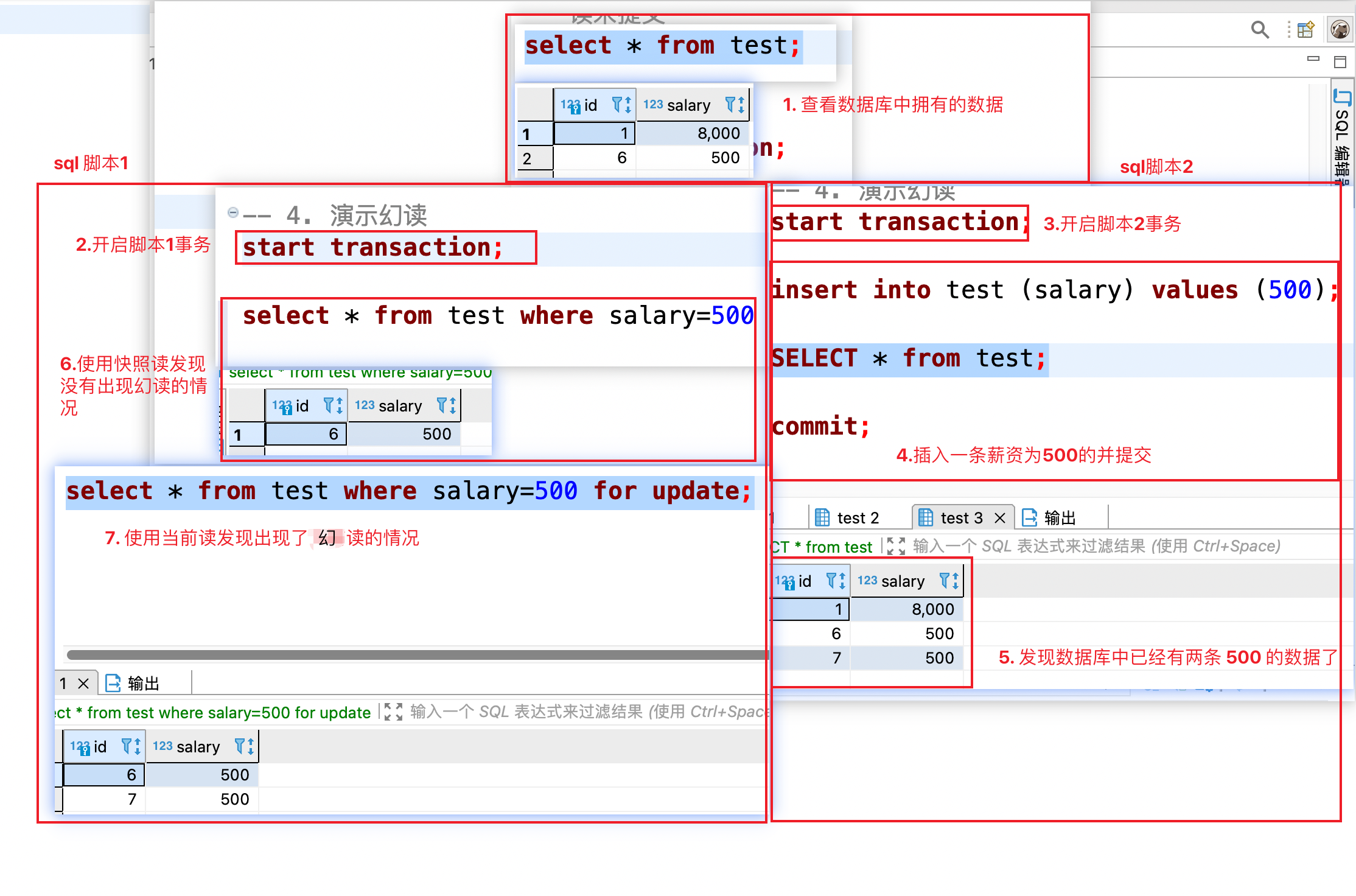

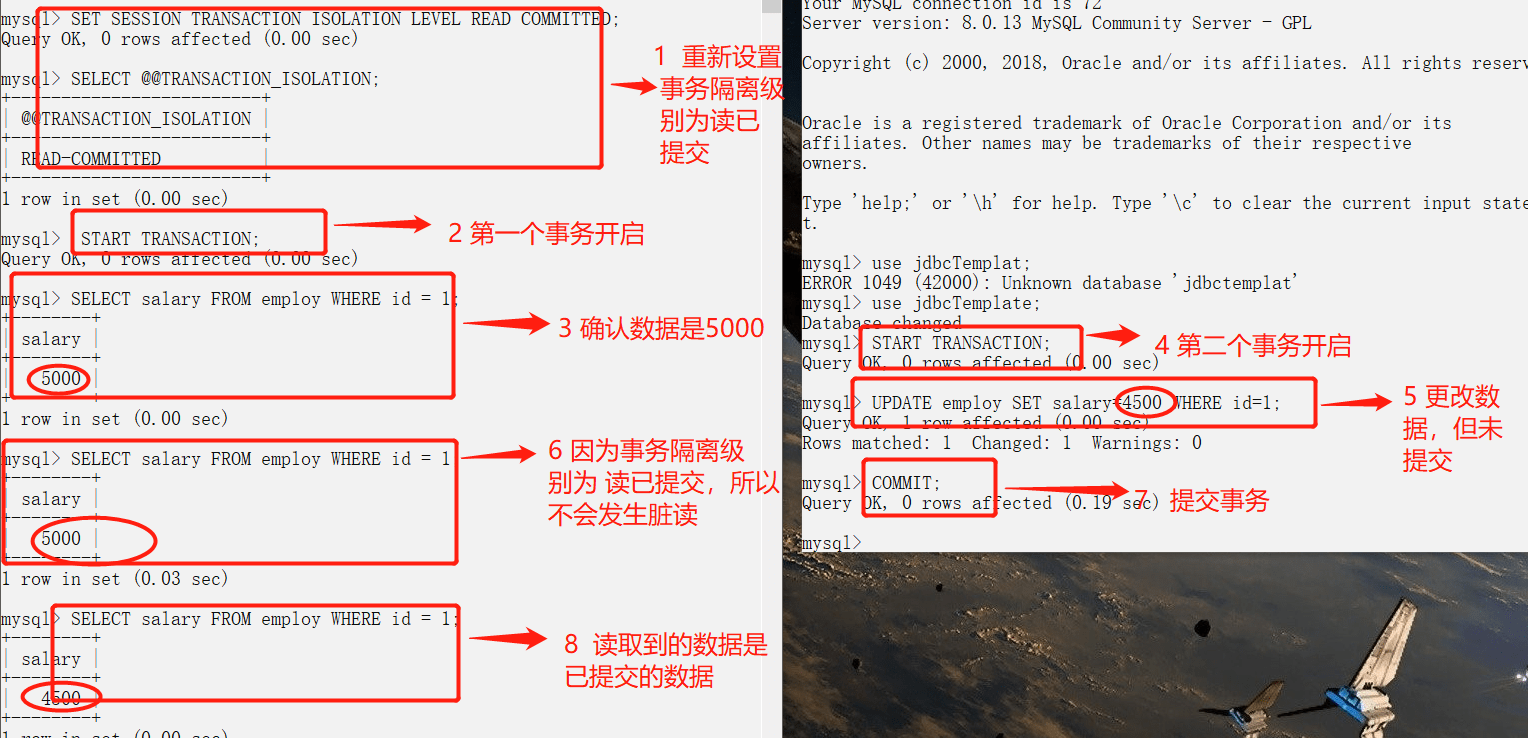

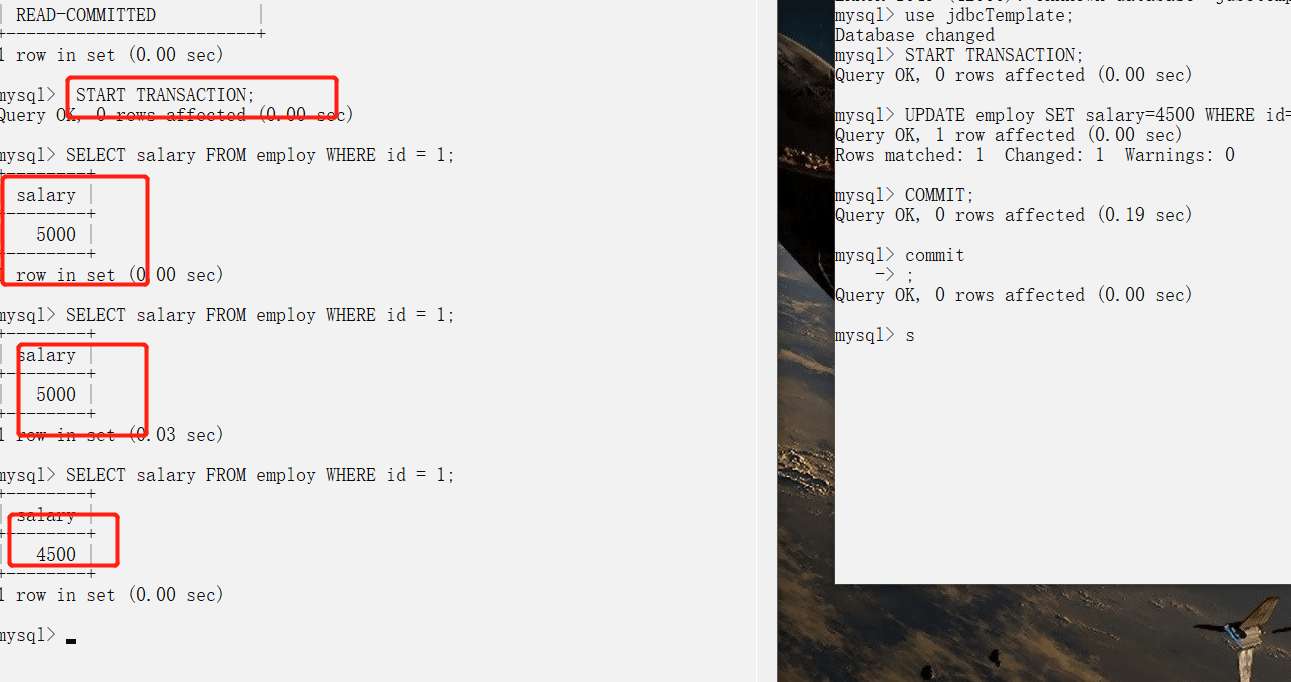

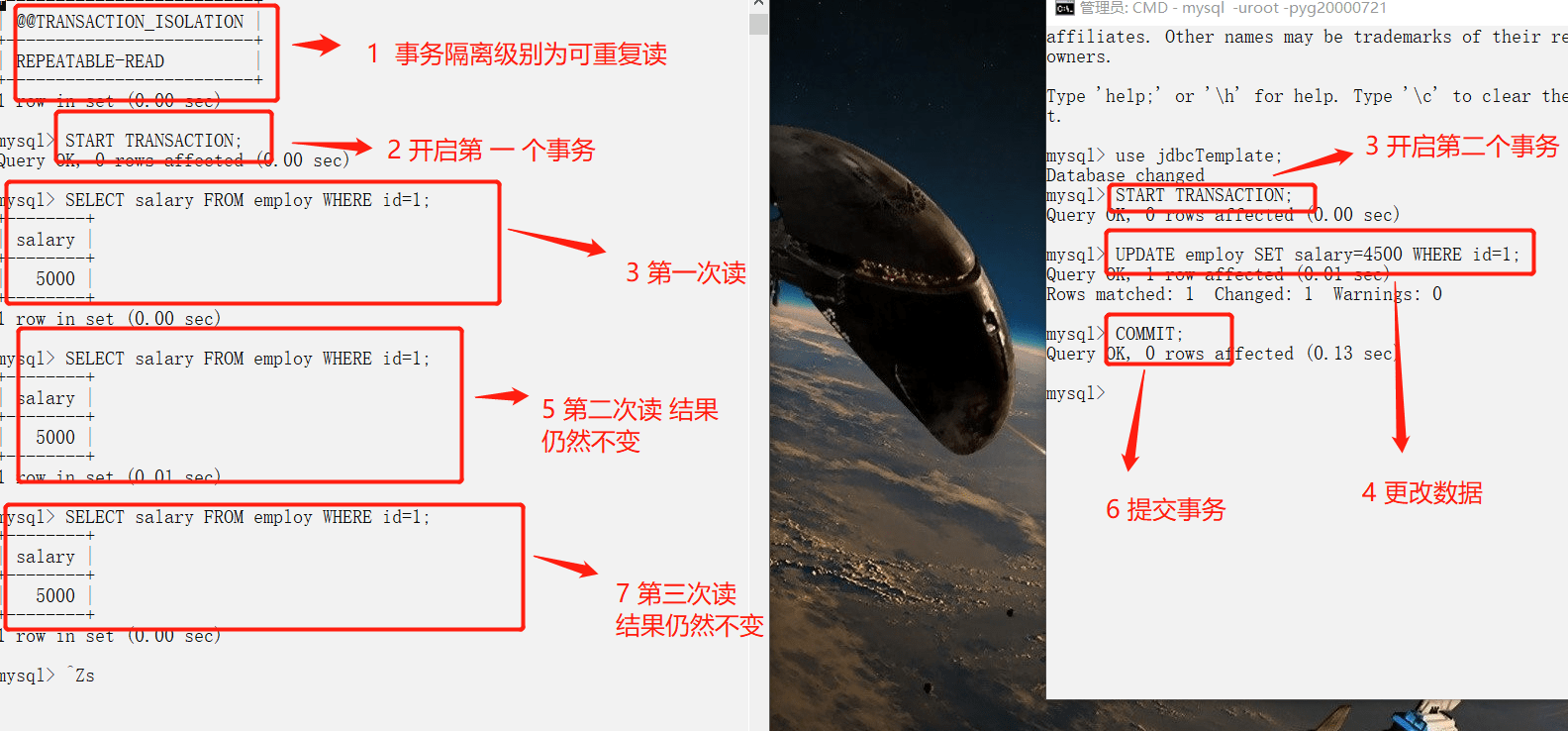

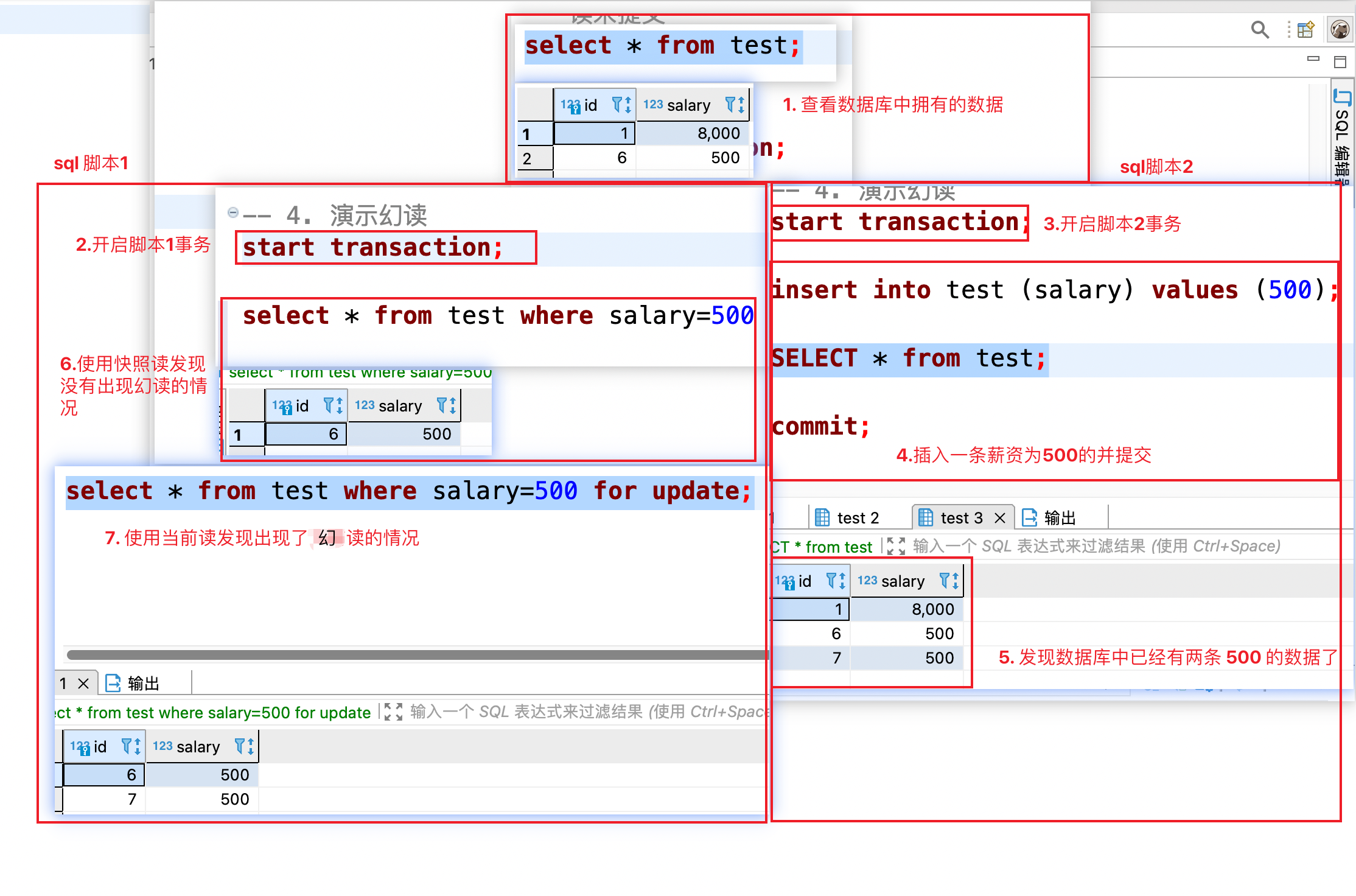

-## 实际情况演示

+## Practical Demonstration

-在下面我会使用 2 个命令行 MySQL ,模拟多线程(多事务)对同一份数据的脏读问题。

+Below, I will use two MySQL command line instances to simulate the dirty read problem with multiple threads (multiple transactions) on the same data.

-MySQL 命令行的默认配置中事务都是自动提交的,即执行 SQL 语句后就会马上执行 COMMIT 操作。如果要显式地开启一个事务需要使用命令:`START TRANSACTION`。

+In the default configuration of the MySQL command line, transactions are automatically committed, meaning that after executing an SQL statement, a COMMIT operation is immediately performed. To explicitly start a transaction, the command `START TRANSACTION` is used.

-我们可以通过下面的命令来设置隔离级别。

+We can set the isolation level using the following command:

```sql

SET [SESSION|GLOBAL] TRANSACTION ISOLATION LEVEL [READ UNCOMMITTED|READ COMMITTED|REPEATABLE READ|SERIALIZABLE]

```

-我们再来看一下我们在下面实际操作中使用到的一些并发控制语句:

-

-- `START TRANSACTION` |`BEGIN`:显式地开启一个事务。

-- `COMMIT`:提交事务,使得对数据库做的所有修改成为永久性。

-- `ROLLBACK`:回滚会结束用户的事务,并撤销正在进行的所有未提交的修改。

-

-### 脏读(读未提交)

-

-![]()

-

-### 避免脏读(读已提交)

-

-

-

-### 不可重复读

-

-还是刚才上面的读已提交的图,虽然避免了读未提交,但是却出现了,一个事务还没有结束,就发生了 不可重复读问题。

-

-

-

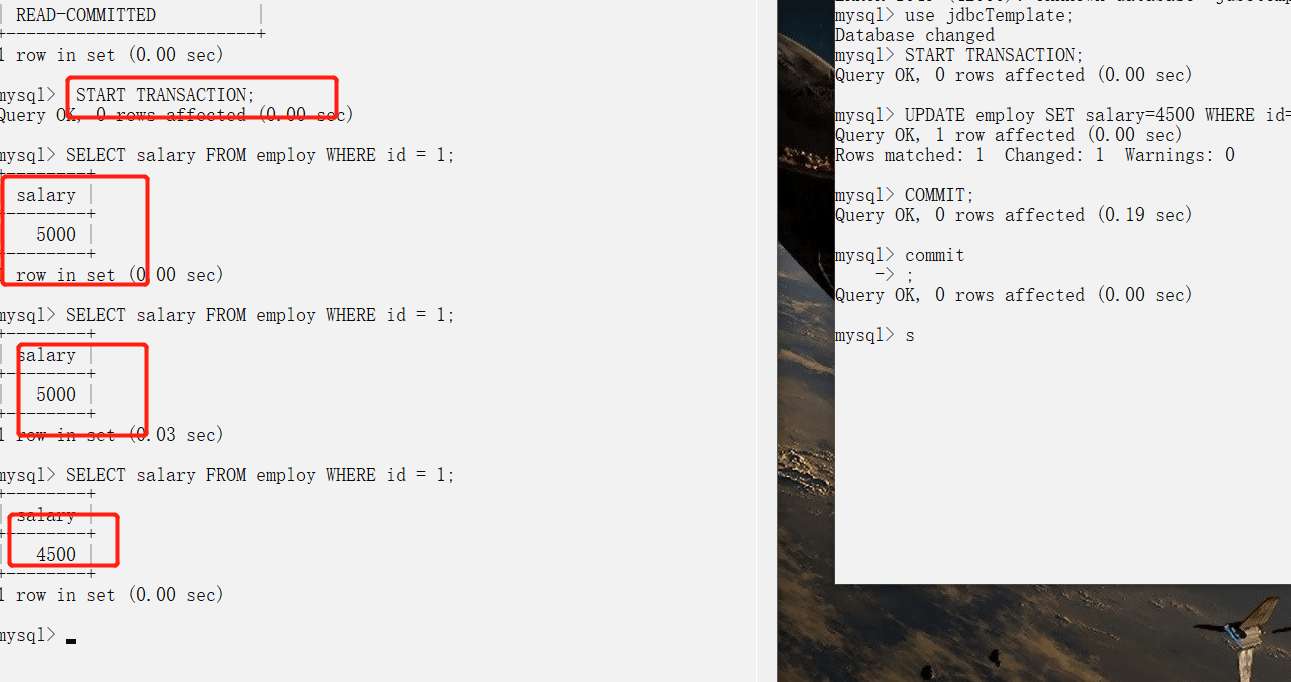

-### 可重复读

-

-

-

-### 幻读

-

-#### 演示幻读出现的情况

-

-

-

-SQL 脚本 1 在第一次查询工资为 500 的记录时只有一条,SQL 脚本 2 插入了一条工资为 500 的记录,提交之后;SQL 脚本 1 在同一个事务中再次使用当前读查询发现出现了两条工资为 500 的记录这种就是幻读。

-

-#### 解决幻读的方法

-

-解决幻读的方式有很多,但是它们的核心思想就是一个事务在操作某张表数据的时候,另外一个事务不允许新增或者删除这张表中的数据了。解决幻读的方式主要有以下几种:

-

-1. 将事务隔离级别调整为 `SERIALIZABLE` 。

-2. 在可重复读的事务级别下,给事务操作的这张表添加表锁。

-3. 在可重复读的事务级别下,给事务操作的这张表添加 `Next-key Lock(Record Lock+Gap Lock)`。

-

-### 参考

-

-- 《MySQL 技术内幕:InnoDB 存储引擎》

--

-- [Mysql 锁:灵魂七拷问](https://tech.youzan.com/seven-questions-about-the-lock-of-MySQL/)

-- [Innodb 中的事务隔离级别和锁的关系](https://tech.meituan.com/2014/08/20/innodb-lock.html)

+Next, let's look at some concurrency control statements we will use in the practical operations below:

-

+- `START TRANSACTION` | `BEGIN`: Explicitly starts a transaction.

+- \`COMMIT

diff --git a/docs/database/nosql.md b/docs/database/nosql.md

index d5ca59698bd..17bf3fa7070 100644

--- a/docs/database/nosql.md

+++ b/docs/database/nosql.md

@@ -1,61 +1,61 @@

---

-title: NoSQL基础知识总结

-category: 数据库

+title: Summary of NoSQL Fundamentals

+category: Database

tag:

- NoSQL

- MongoDB

- Redis

---

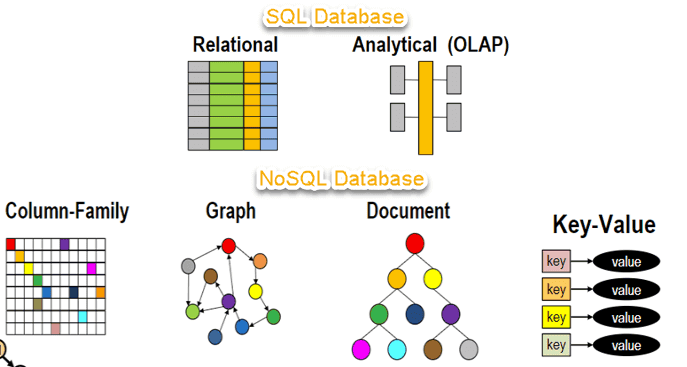

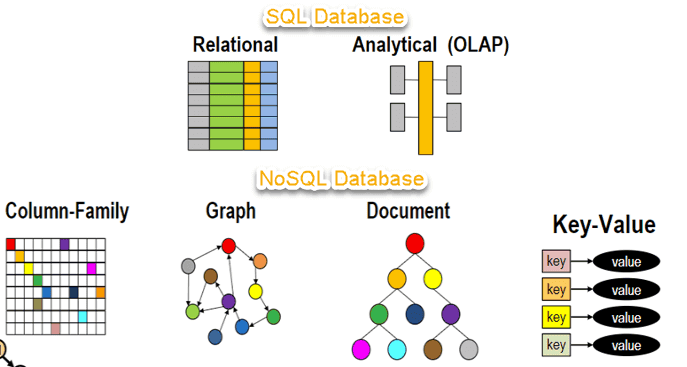

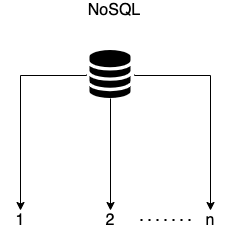

-## NoSQL 是什么?

+## What is NoSQL?

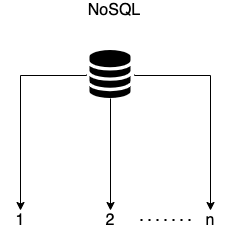

-NoSQL(Not Only SQL 的缩写)泛指非关系型的数据库,主要针对的是键值、文档以及图形类型数据存储。并且,NoSQL 数据库天生支持分布式,数据冗余和数据分片等特性,旨在提供可扩展的高可用高性能数据存储解决方案。

+NoSQL (Not Only SQL) refers to non-relational databases that primarily target key-value, document, and graph data storage. Moreover, NoSQL databases naturally support distributed features, data redundancy, and data partitioning, aiming to provide scalable, high-availability, and high-performance data storage solutions.

-一个常见的误解是 NoSQL 数据库或非关系型数据库不能很好地存储关系型数据。NoSQL 数据库可以存储关系型数据—它们与关系型数据库的存储方式不同。

+A common misconception is that NoSQL databases or non-relational databases cannot store relational data well. NoSQL databases can store relational data—they just have a different storage method compared to relational databases.

-NoSQL 数据库代表:HBase、Cassandra、MongoDB、Redis。

+Examples of NoSQL databases include: HBase, Cassandra, MongoDB, Redis.

-## SQL 和 NoSQL 有什么区别?

+## What are the differences between SQL and NoSQL?

-| | SQL 数据库 | NoSQL 数据库 |

-| :----------- | -------------------------------------------------------------------------- | --------------------------------------------------------------------------------------------------------------------------------------- |

-| 数据存储模型 | 结构化存储,具有固定行和列的表格 | 非结构化存储。文档:JSON 文档,键值:键值对,宽列:包含行和动态列的表,图:节点和边 |

-| 发展历程 | 开发于 1970 年代,重点是减少数据重复 | 开发于 2000 年代后期,重点是提升可扩展性,减少大规模数据的存储成本 |

-| 例子 | Oracle、MySQL、Microsoft SQL Server、PostgreSQL | 文档:MongoDB、CouchDB,键值:Redis、DynamoDB,宽列:Cassandra、 HBase,图表:Neo4j、 Amazon Neptune、Giraph |

-| ACID 属性 | 提供原子性、一致性、隔离性和持久性 (ACID) 属性 | 通常不支持 ACID 事务,为了可扩展、高性能进行了权衡,少部分支持比如 MongoDB 。不过,MongoDB 对 ACID 事务 的支持和 MySQL 还是有所区别的。 |

-| 性能 | 性能通常取决于磁盘子系统。要获得最佳性能,通常需要优化查询、索引和表结构。 | 性能通常由底层硬件集群大小、网络延迟以及调用应用程序来决定。 |

-| 扩展 | 垂直(使用性能更强大的服务器进行扩展)、读写分离、分库分表 | 横向(增加服务器的方式横向扩展,通常是基于分片机制) |

-| 用途 | 普通企业级的项目的数据存储 | 用途广泛比如图数据库支持分析和遍历连接数据之间的关系、键值数据库可以处理大量数据扩展和极高的状态变化 |

-| 查询语法 | 结构化查询语言 (SQL) | 数据访问语法可能因数据库而异 |

+| | SQL Databases | NoSQL Databases |

+| :------------------ | ---------------------------------------------------------------------------------------------------------------------------------------------------------- | ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

+| Data Storage Model | Structured storage with tables that have fixed rows and columns | Unstructured storage. Documents: JSON documents, Key-Value: Key-Value pairs, Wide Column: Tables with rows and dynamic columns, Graph: Nodes and edges |

+| Development History | Developed in the 1970s, focusing on reducing data duplication | Developed in the late 2000s, focusing on improving scalability and reducing storage costs for massive amounts of data |

+| Examples | Oracle, MySQL, Microsoft SQL Server, PostgreSQL | Documents: MongoDB, CouchDB; Key-Value: Redis, DynamoDB; Wide Column: Cassandra, HBase; Graph: Neo4j, Amazon Neptune, Giraph |

+| ACID Properties | Provides Atomicity, Consistency, Isolation, and Durability (ACID) properties | Generally does not support ACID transactions, making trade-offs for scalability and high performance; some, like MongoDB, support them, but differently than MySQL. |

+| Performance | Performance typically depends on the disk subsystem. To achieve optimal performance, optimizing queries, indexes, and table structures is often necessary. | Performance is usually determined by the size of the underlying hardware cluster, network latency, and the application calling. |

+| Scalability | Vertical (scaling up using more powerful servers), read-write separation, database sharding | Horizontal (scaling out by adding servers, usually based on sharding mechanisms) |

+| Use Cases | Data storage for typical enterprise-level projects | Wide-ranging uses, for example, graph databases support analysis and traversing relationships between connected data; key-value databases can handle massive data scaling and extreme state changes. |

+| Query Language | Structured Query Language (SQL) | Data access syntax may vary by database |

-## NoSQL 数据库有什么优势?

+## What are the advantages of NoSQL databases?

-NoSQL 数据库非常适合许多现代应用程序,例如移动、Web 和游戏等应用程序,它们需要灵活、可扩展、高性能和功能强大的数据库以提供卓越的用户体验。

+NoSQL databases are particularly suitable for many modern applications, such as mobile, web, and gaming applications, which require flexible, scalable, high-performance, and powerful databases to provide excellent user experiences.

-- **灵活性:** NoSQL 数据库通常提供灵活的架构,以实现更快速、更多的迭代开发。灵活的数据模型使 NoSQL 数据库成为半结构化和非结构化数据的理想之选。

-- **可扩展性:** NoSQL 数据库通常被设计为通过使用分布式硬件集群来横向扩展,而不是通过添加昂贵和强大的服务器来纵向扩展。

-- **高性能:** NoSQL 数据库针对特定的数据模型和访问模式进行了优化,这与尝试使用关系数据库完成类似功能相比可实现更高的性能。

-- **强大的功能:** NoSQL 数据库提供功能强大的 API 和数据类型,专门针对其各自的数据模型而构建。

+- **Flexibility:** NoSQL databases often provide flexible architectures for faster and more iterative development. Their flexible data models make NoSQL databases ideal for semi-structured and unstructured data.

+- **Scalability:** NoSQL databases are generally designed to scale horizontally by utilizing distributed hardware clusters rather than vertically scaling by adding expensive and powerful servers.

+- **High Performance:** NoSQL databases are optimized for specific data models and access patterns, achieving higher performance compared to trying to accomplish similar functions with a relational database.

+- **Powerful Features:** NoSQL databases offer powerful APIs and data types designed specifically for their respective data models.

-## NoSQL 数据库有哪些类型?

+## What types of NoSQL databases are there?

-NoSQL 数据库主要可以分为下面四种类型:

+NoSQL databases can primarily be divided into the following four types:

-- **键值**:键值数据库是一种较简单的数据库,其中每个项目都包含键和值。这是极为灵活的 NoSQL 数据库类型,因为应用可以完全控制 value 字段中存储的内容,没有任何限制。Redis 和 DynanoDB 是两款非常流行的键值数据库。

-- **文档**:文档数据库中的数据被存储在类似于 JSON(JavaScript 对象表示法)对象的文档中,非常清晰直观。每个文档包含成对的字段和值。这些值通常可以是各种类型,包括字符串、数字、布尔值、数组或对象等,并且它们的结构通常与开发者在代码中使用的对象保持一致。MongoDB 就是一款非常流行的文档数据库。

-- **图形**:图形数据库旨在轻松构建和运行与高度连接的数据集一起使用的应用程序。图形数据库的典型使用案例包括社交网络、推荐引擎、欺诈检测和知识图形。Neo4j 和 Giraph 是两款非常流行的图形数据库。

-- **宽列**:宽列存储数据库非常适合需要存储大量的数据。Cassandra 和 HBase 是两款非常流行的宽列存储数据库。

+- **Key-Value:** Key-value databases are a simpler type of database where each item consists of a key and a value. This is a very flexible type of NoSQL database because applications have complete control over the content stored in the value field, with no restrictions. Redis and DynamoDB are two popular key-value databases.

+- **Document:** Data in document databases is stored in documents resembling JSON (JavaScript Object Notation) objects, which are very clear and intuitive. Each document contains paired fields and values. These values can typically be of various types, including strings, numbers, booleans, arrays, or objects, and their structure often aligns with the objects developers use in code. MongoDB is a very popular document database.

+- **Graph:** Graph databases are designed to make it easy to build and run applications that work with highly connected datasets. Typical use cases for graph databases include social networks, recommendation engines, fraud detection, and knowledge graphs. Neo4j and Giraph are two well-known graph databases.

+- **Wide Column:** Wide-column store databases are well-suited for scenarios requiring the storage of massive amounts of data. Cassandra and HBase are two popular wide-column storage databases.

-下面这张图片来源于 [微软的官方文档 | 关系数据与 NoSQL 数据](https://learn.microsoft.com/en-us/dotnet/architecture/cloud-native/relational-vs-nosql-data)。

+The image below is sourced from [Microsoft's official documentation | Relational Data vs. NoSQL Data](https://learn.microsoft.com/en-us/dotnet/architecture/cloud-native/relational-vs-nosql-data).

-

+

-## 参考

+## References

-- NoSQL 是什么?- MongoDB 官方文档:

-- 什么是 NoSQL? - AWS:

-- NoSQL vs. SQL Databases - MongoDB 官方文档:

+- What is NoSQL? - MongoDB Official Documentation:

+- What is NoSQL? - AWS:

+- NoSQL vs. SQL Databases - MongoDB Official Documentation:

diff --git a/docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md b/docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md

index 7ad88958704..ce2d47640e9 100644

--- a/docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md

+++ b/docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md

@@ -1,118 +1,87 @@

---

-title: 3种常用的缓存读写策略详解

-category: 数据库

+title: Detailed Explanation of 3 Common Cache Read/Write Strategies

+category: Database

tag:

- Redis

---

-看到很多小伙伴简历上写了“**熟练使用缓存**”,但是被我问到“**缓存常用的 3 种读写策略**”的时候却一脸懵逼。

+I've seen many friends list "**proficient in using cache**" on their resumes, but when I ask them about the "**3 common read/write strategies for cache**," they often look confused.

-在我看来,造成这个问题的原因是我们在学习 Redis 的时候,可能只是简单写了一些 Demo,并没有去关注缓存的读写策略,或者说压根不知道这回事。

+In my opinion, this issue arises because when we learn Redis, we might only write some simple demos without paying attention to cache read/write strategies, or we might not even be aware of them.

-但是,搞懂 3 种常见的缓存读写策略对于实际工作中使用缓存以及面试中被问到缓存都是非常有帮助的!

+However, understanding the 3 common cache read/write strategies is very helpful for using cache in real work and for interview questions about cache!

-**下面介绍到的三种模式各有优劣,不存在最佳模式,根据具体的业务场景选择适合自己的缓存读写模式。**

+**The three patterns introduced below each have their pros and cons; there is no best pattern. Choose a cache read/write pattern that suits your specific business scenario.**

-### Cache Aside Pattern(旁路缓存模式)

+### Cache Aside Pattern

-**Cache Aside Pattern 是我们平时使用比较多的一个缓存读写模式,比较适合读请求比较多的场景。**

+**The Cache Aside Pattern is a commonly used cache read/write pattern, particularly suitable for scenarios with a high volume of read requests.**

-Cache Aside Pattern 中服务端需要同时维系 db 和 cache,并且是以 db 的结果为准。

+In the Cache Aside Pattern, the server needs to maintain both the database (db) and the cache, with the db results being the authoritative source.

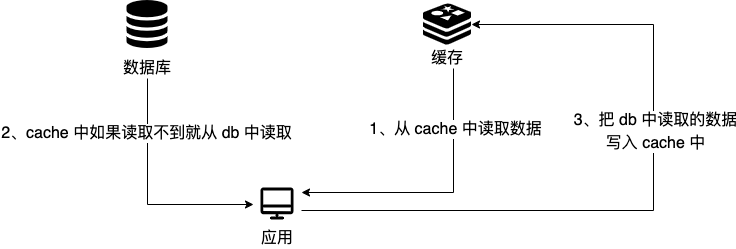

-下面我们来看一下这个策略模式下的缓存读写步骤。

+Let's take a look at the steps for reading and writing cache under this strategy.

-**写**:

+**Write:**

-- 先更新 db

-- 然后直接删除 cache 。

+- First, update the db.

+- Then, delete the cache directly.

-简单画了一张图帮助大家理解写的步骤。

+Here’s a simple diagram to help you understand the writing steps.

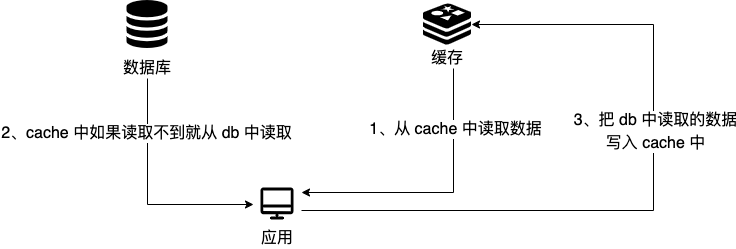

-**读** :

+**Read:**

-- 从 cache 中读取数据,读取到就直接返回

-- cache 中读取不到的话,就从 db 中读取数据返回

-- 再把数据放到 cache 中。

+- Read data from the cache; if found, return it directly.

+- If not found in the cache, read the data from the db and return it.

+- Then, place the data into the cache.

-简单画了一张图帮助大家理解读的步骤。

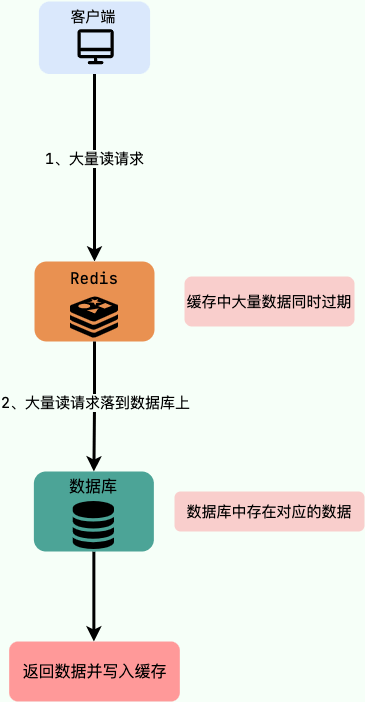

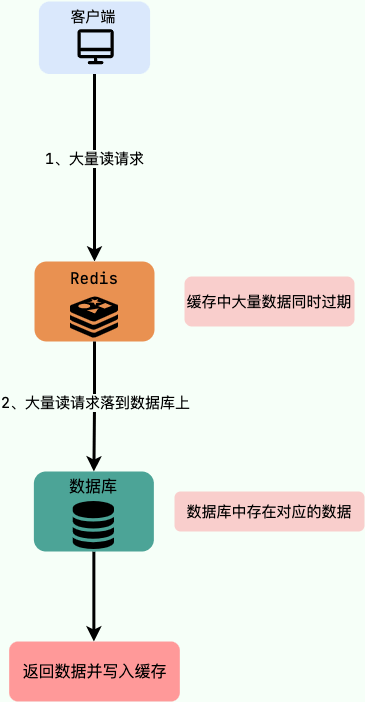

+Here’s a simple diagram to help you understand the reading steps.

-你仅仅了解了上面这些内容的话是远远不够的,我们还要搞懂其中的原理。

+If you only understand the above content, it is far from enough; we also need to grasp the underlying principles.

-比如说面试官很可能会追问:“**在写数据的过程中,可以先删除 cache ,后更新 db 么?**”

+For example, the interviewer might follow up with: "**During the data writing process, can we delete the cache first and then update the db?**"

-**答案:** 那肯定是不行的!因为这样可能会造成 **数据库(db)和缓存(Cache)数据不一致**的问题。

+**Answer:** Absolutely not! Because this could lead to the problem of **inconsistency between the database (db) and the cache.**

-举例:请求 1 先写数据 A,请求 2 随后读数据 A 的话,就很有可能产生数据不一致性的问题。

+For instance: If request 1 writes data A first, and request 2 subsequently reads data A, it is very likely to cause data inconsistency.

-这个过程可以简单描述为:

+This process can be simply described as:

-> 请求 1 先把 cache 中的 A 数据删除 -> 请求 2 从 db 中读取数据->请求 1 再把 db 中的 A 数据更新

+> Request 1 deletes data A from the cache -> Request 2 reads data from the db -> Request 1 updates data A in the db.

-当你这样回答之后,面试官可能会紧接着就追问:“**在写数据的过程中,先更新 db,后删除 cache 就没有问题了么?**”

+After you answer this, the interviewer might immediately ask: "**During the data writing process, is it okay to update the db first and then delete the cache?**"

-**答案:** 理论上来说还是可能会出现数据不一致性的问题,不过概率非常小,因为缓存的写入速度是比数据库的写入速度快很多。

+**Answer:** Theoretically, there could still be a problem with data inconsistency, but the probability is very low because the write speed of the cache is much faster than that of the database.

-举例:请求 1 先读数据 A,请求 2 随后写数据 A,并且数据 A 在请求 1 请求之前不在缓存中的话,也有可能产生数据不一致性的问题。

+For example: If request 1 reads data A first, and request 2 subsequently writes data A, and data A is not in the cache before request 1, there could still be a problem with data inconsistency.

-这个过程可以简单描述为:

+This process can be simply described as:

-> 请求 1 从 db 读数据 A-> 请求 2 更新 db 中的数据 A(此时缓存中无数据 A ,故不用执行删除缓存操作 ) -> 请求 1 将数据 A 写入 cache

+> Request 1 reads data A from the db -> Request 2 updates data A in the db (at this point, there is no data A in the cache, so no cache deletion is needed) -> Request 1 writes data A into the cache.

-现在我们再来分析一下 **Cache Aside Pattern 的缺陷**。

+Now let's analyze the **deficiencies of the Cache Aside Pattern**.

-**缺陷 1:首次请求数据一定不在 cache 的问题**

+**Deficiency 1: The issue that the first request for data is definitely not in the cache.**

-解决办法:可以将热点数据可以提前放入 cache 中。

+Solution: Hot data can be preloaded into the cache.

-**缺陷 2:写操作比较频繁的话导致 cache 中的数据会被频繁被删除,这样会影响缓存命中率 。**

+**Deficiency 2: Frequent write operations can lead to data being frequently deleted from the cache, which affects the cache hit rate.**

-解决办法:

+Solutions:

-- 数据库和缓存数据强一致场景:更新 db 的时候同样更新 cache,不过我们需要加一个锁/分布式锁来保证更新 cache 的时候不存在线程安全问题。

-- 可以短暂地允许数据库和缓存数据不一致的场景:更新 db 的时候同样更新 cache,但是给缓存加一个比较短的过期时间,这样的话就可以保证即使数据不一致的话影响也比较小。

+- For scenarios requiring strong consistency between the database and cache: Update the cache when updating the db, but we need to add a lock/distributed lock to ensure thread safety when updating the cache.

+- For scenarios where temporary inconsistency between the database and cache is acceptable: Update the cache when updating the db, but set a relatively short expiration time for the cache, which can ensure that even if data is inconsistent, the impact is minimal.

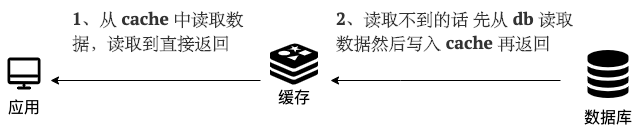

-### Read/Write Through Pattern(读写穿透)

+### Read/Write Through Pattern

-Read/Write Through Pattern 中服务端把 cache 视为主要数据存储,从中读取数据并将数据写入其中。cache 服务负责将此数据读取和写入 db,从而减轻了应用程序的职责。

+In the Read/Write Through Pattern, the server treats the cache as the primary data store, reading data from it and writing data into it. The cache service is responsible for reading and writing this data to the db, thereby reducing the responsibilities of the application.

-这种缓存读写策略小伙伴们应该也发现了在平时在开发过程中非常少见。抛去性能方面的影响,大概率是因为我们经常使用的分布式缓存 Redis 并没有提供 cache 将数据写入 db 的功能。

+This cache read/write strategy is also rarely seen in our development process. Aside from performance impacts, it is likely because the distributed cache we often use, Redis, does not provide the functionality for the cache to write data to the db.

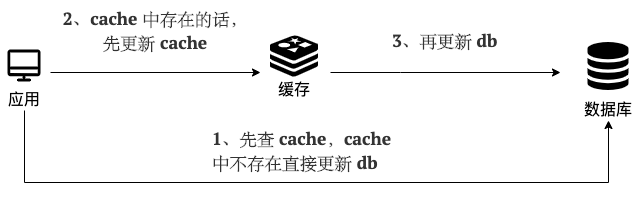

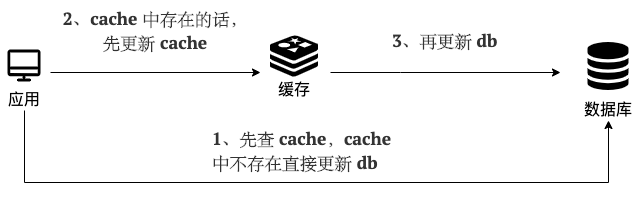

-**写(Write Through):**

+**Write (Write Through):**

-- 先查 cache,cache 中不存在,直接更新 db。

-- cache 中存在,则先更新 cache,然后 cache 服务自己更新 db(**同步更新 cache 和 db**)。

-

-简单画了一张图帮助大家理解写的步骤。

-

-

-

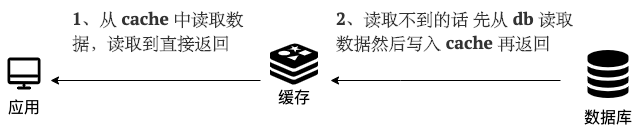

-**读(Read Through):**

-

-- 从 cache 中读取数据,读取到就直接返回 。

-- 读取不到的话,先从 db 加载,写入到 cache 后返回响应。

-

-简单画了一张图帮助大家理解读的步骤。

-

-

-

-Read-Through Pattern 实际只是在 Cache-Aside Pattern 之上进行了封装。在 Cache-Aside Pattern 下,发生读请求的时候,如果 cache 中不存在对应的数据,是由客户端自己负责把数据写入 cache,而 Read Through Pattern 则是 cache 服务自己来写入缓存的,这对客户端是透明的。

-

-和 Cache Aside Pattern 一样, Read-Through Pattern 也有首次请求数据一定不再 cache 的问题,对于热点数据可以提前放入缓存中。

-

-### Write Behind Pattern(异步缓存写入)

-

-Write Behind Pattern 和 Read/Write Through Pattern 很相似,两者都是由 cache 服务来负责 cache 和 db 的读写。

-

-但是,两个又有很大的不同:**Read/Write Through 是同步更新 cache 和 db,而 Write Behind 则是只更新缓存,不直接更新 db,而是改为异步批量的方式来更新 db。**

-

-很明显,这种方式对数据一致性带来了更大的挑战,比如 cache 数据可能还没异步更新 db 的话,cache 服务可能就就挂掉了。

-

-这种策略在我们平时开发过程中也非常非常少见,但是不代表它的应用场景少,比如消息队列中消息的异步写入磁盘、MySQL 的 Innodb Buffer Pool 机制都用到了这种策略。

-

-Write Behind Pattern 下 db 的写性能非常高,非常适合一些数据经常变化又对数据一致性要求没那么高的场景,比如浏览量、点赞量。

-

-

+- First, check the cache; if it does not exist, directly update the db.

+- If it exists in the cache, first update the cache, then the

diff --git a/docs/database/redis/cache-basics.md b/docs/database/redis/cache-basics.md

index 391e5bec82d..b82a91c1d3d 100644

--- a/docs/database/redis/cache-basics.md

+++ b/docs/database/redis/cache-basics.md

@@ -1,11 +1,11 @@

---

-title: 缓存基础常见面试题总结(付费)

-category: 数据库

+title: Summary of Common Interview Questions on Cache Basics (Paid)

+category: Database

tag:

- Redis

---

-**缓存基础** 相关的面试题为我的 [知识星球](../../about-the-author/zhishixingqiu-two-years.md)(点击链接即可查看详细介绍以及加入方法)专属内容,已经整理到了[《Java 面试指北》](../../zhuanlan/java-mian-shi-zhi-bei.md)中。

+Interview questions related to **cache basics** are exclusive content for my [Knowledge Planet](../../about-the-author/zhishixingqiu-two-years.md) (click the link to view detailed introduction and joining method), and have been organized into [“Java Interview Guide”](../../zhuanlan/java-mian-shi-zhi-bei.md).

diff --git a/docs/database/redis/redis-cluster.md b/docs/database/redis/redis-cluster.md

index e3ef2efd04c..480596dd84b 100644

--- a/docs/database/redis/redis-cluster.md

+++ b/docs/database/redis/redis-cluster.md

@@ -1,11 +1,11 @@

---

-title: Redis集群详解(付费)

-category: 数据库

+title: Detailed Explanation of Redis Clusters (Paid)

+category: Database

tag:

- Redis

---

-**Redis 集群** 相关的面试题为我的 [知识星球](../../about-the-author/zhishixingqiu-two-years.md)(点击链接即可查看详细介绍以及加入方法)专属内容,已经整理到了[《Java 面试指北》](../../zhuanlan/java-mian-shi-zhi-bei.md)中。

+The interview questions related to **Redis Clusters** are exclusive content for my [Knowledge Planet](../../about-the-author/zhishixingqiu-two-years.md) (click the link for a detailed introduction and joining methods) and have been compiled in [《Java Interview Guide》](../../zhuanlan/java-mian-shi-zhi-bei.md).

diff --git a/docs/database/redis/redis-common-blocking-problems-summary.md b/docs/database/redis/redis-common-blocking-problems-summary.md

index 9aec17fc0cc..62342697a2d 100644

--- a/docs/database/redis/redis-common-blocking-problems-summary.md

+++ b/docs/database/redis/redis-common-blocking-problems-summary.md

@@ -1,146 +1,144 @@

---

-title: Redis常见阻塞原因总结

-category: 数据库

+title: Summary of Common Blocking Reasons in Redis

+category: Database

tag:

- Redis

---

-> 本文整理完善自: ,作者:阿 Q 说代码

+> This article is compiled and perfected from: , author: A Q Talks Code

-这篇文章会详细总结一下可能导致 Redis 阻塞的情况,这些情况也是影响 Redis 性能的关键因素,使用 Redis 的时候应该格外注意!

+This article will summarize in detail the situations that may cause Redis blocking, which are also key factors affecting Redis performance. Care should be taken when using Redis!

-## O(n) 命令

+## O(n) Commands

-Redis 中的大部分命令都是 O(1)时间复杂度,但也有少部分 O(n) 时间复杂度的命令,例如:

+Most commands in Redis have an O(1) time complexity, but there are also a few commands with O(n) time complexity, such as:

-- `KEYS *`:会返回所有符合规则的 key。

-- `HGETALL`:会返回一个 Hash 中所有的键值对。

-- `LRANGE`:会返回 List 中指定范围内的元素。

-- `SMEMBERS`:返回 Set 中的所有元素。

-- `SINTER`/`SUNION`/`SDIFF`:计算多个 Set 的交集/并集/差集。

+- `KEYS *`: Returns all keys that match the rules.

+- `HGETALL`: Returns all key-value pairs in a Hash.

+- `LRANGE`: Returns elements within a specified range in a List.

+- `SMEMBERS`: Returns all elements in a Set.

+- `SINTER`/`SUNION`/`SDIFF`: Calculates the intersection/union/difference of multiple Sets.

- ……

-由于这些命令时间复杂度是 O(n),有时候也会全表扫描,随着 n 的增大,执行耗时也会越长,从而导致客户端阻塞。不过, 这些命令并不是一定不能使用,但是需要明确 N 的值。另外,有遍历的需求可以使用 `HSCAN`、`SSCAN`、`ZSCAN` 代替。

+Due to the O(n) time complexity of these commands, sometimes a full table scan occurs. As n increases, the execution time will also increase, leading to client blocking. However, these commands are not entirely unusable, but the value of N needs to be clarified. If there is a need for traversal, `HSCAN`, `SSCAN`, or `ZSCAN` can be used instead.

-除了这些 O(n)时间复杂度的命令可能会导致阻塞之外, 还有一些时间复杂度可能在 O(N) 以上的命令,例如:

+In addition to these O(n) time complexity commands that may cause blocking, there are also commands with time complexities potentially greater than O(N), such as:

-- `ZRANGE`/`ZREVRANGE`:返回指定 Sorted Set 中指定排名范围内的所有元素。时间复杂度为 O(log(n)+m),n 为所有元素的数量, m 为返回的元素数量,当 m 和 n 相当大时,O(n) 的时间复杂度更小。

-- `ZREMRANGEBYRANK`/`ZREMRANGEBYSCORE`:移除 Sorted Set 中指定排名范围/指定 score 范围内的所有元素。时间复杂度为 O(log(n)+m),n 为所有元素的数量, m 被删除元素的数量,当 m 和 n 相当大时,O(n) 的时间复杂度更小。

+- `ZRANGE`/`ZREVRANGE`: Returns all elements within a specified ranking range in a Sorted Set. The time complexity is O(log(n)+m), where n is the total number of elements and m is the number of elements returned. When m and n are relatively large, the time complexity O(n) is smaller.

+- `ZREMRANGEBYRANK`/`ZREMRANGEBYSCORE`: Removes all elements within a specified ranking range/specified score range in a Sorted Set. The time complexity is O(log(n)+m), where n is the total number of elements and m is the number of deleted elements. When m and n are relatively large, the time complexity O(n) is smaller.

- ……

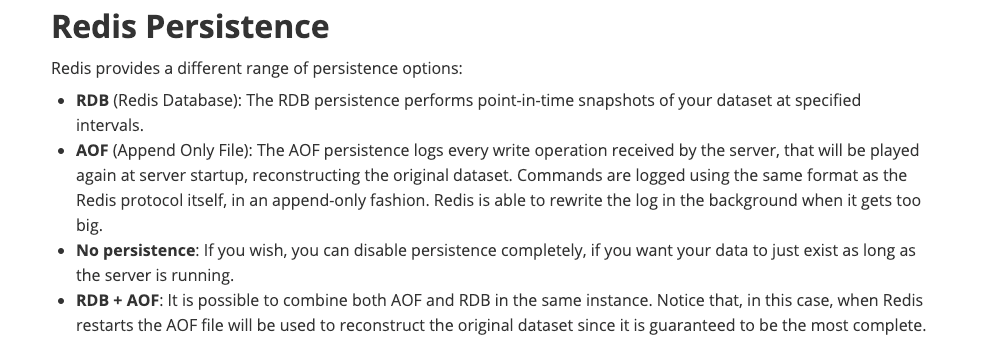

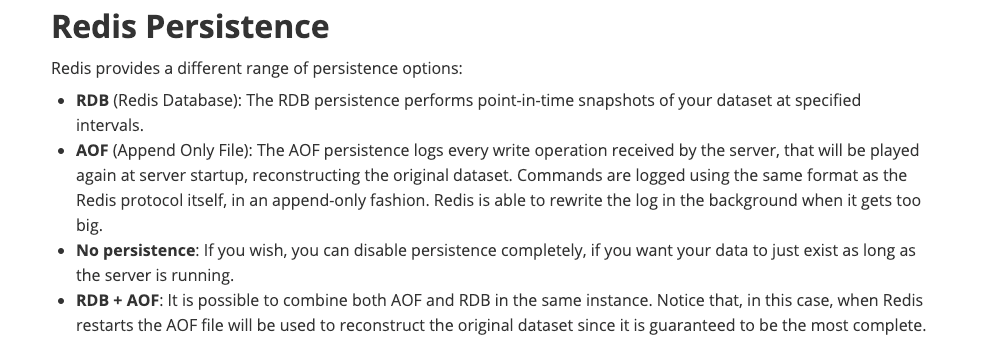

-## SAVE 创建 RDB 快照

+## SAVE Creating RDB Snapshots

-Redis 提供了两个命令来生成 RDB 快照文件:

+Redis provides two commands to generate RDB snapshot files:

-- `save` : 同步保存操作,会阻塞 Redis 主线程;

-- `bgsave` : fork 出一个子进程,子进程执行,不会阻塞 Redis 主线程,默认选项。

+- `save`: Synchronously saves operations and blocks the Redis main thread.

+- `bgsave`: Forks a child process to execute, which does not block the Redis main thread, the default option.

-默认情况下,Redis 默认配置会使用 `bgsave` 命令。如果手动使用 `save` 命令生成 RDB 快照文件的话,就会阻塞主线程。

+By default, Redis will use the `bgsave` command. If you manually use the `save` command to generate RDB snapshot files, it will block the main thread.

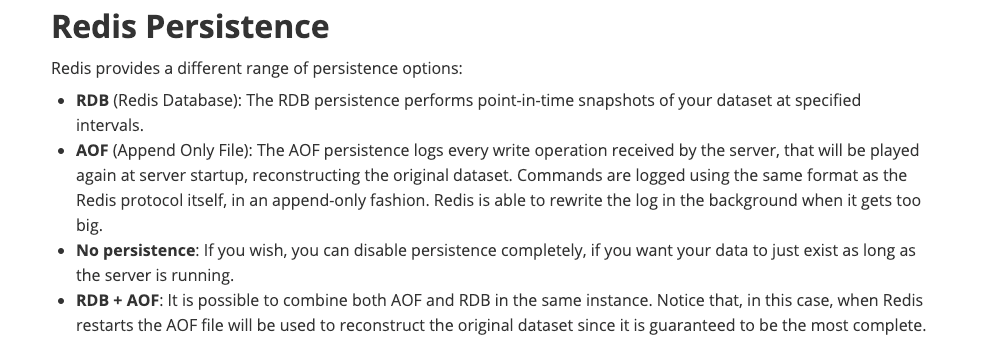

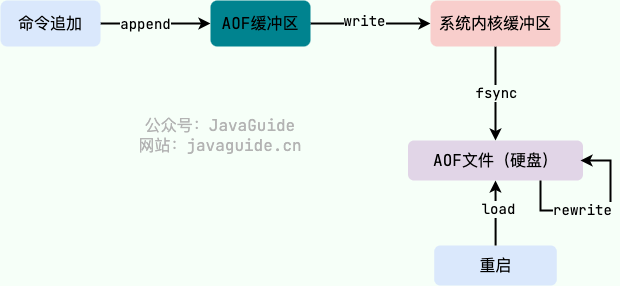

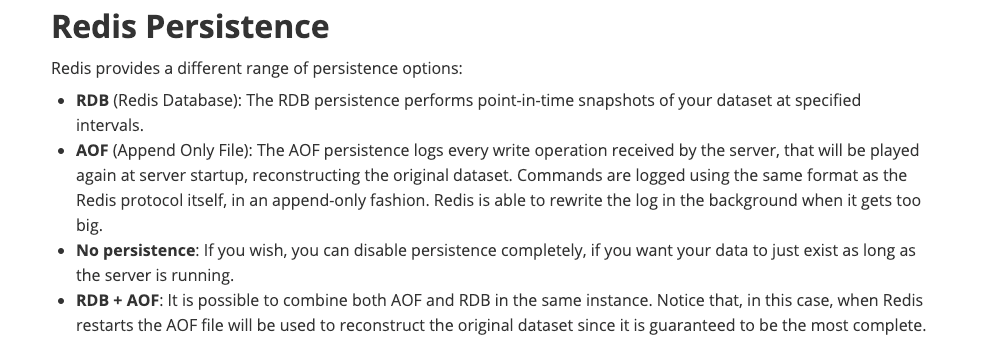

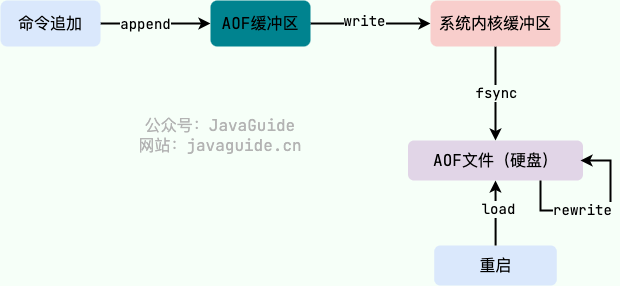

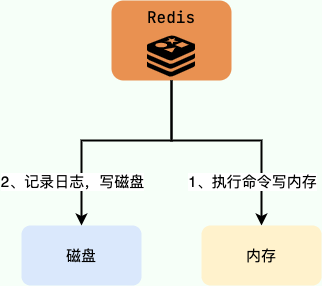

## AOF

-### AOF 日志记录阻塞

+### AOF Log Record Blocking

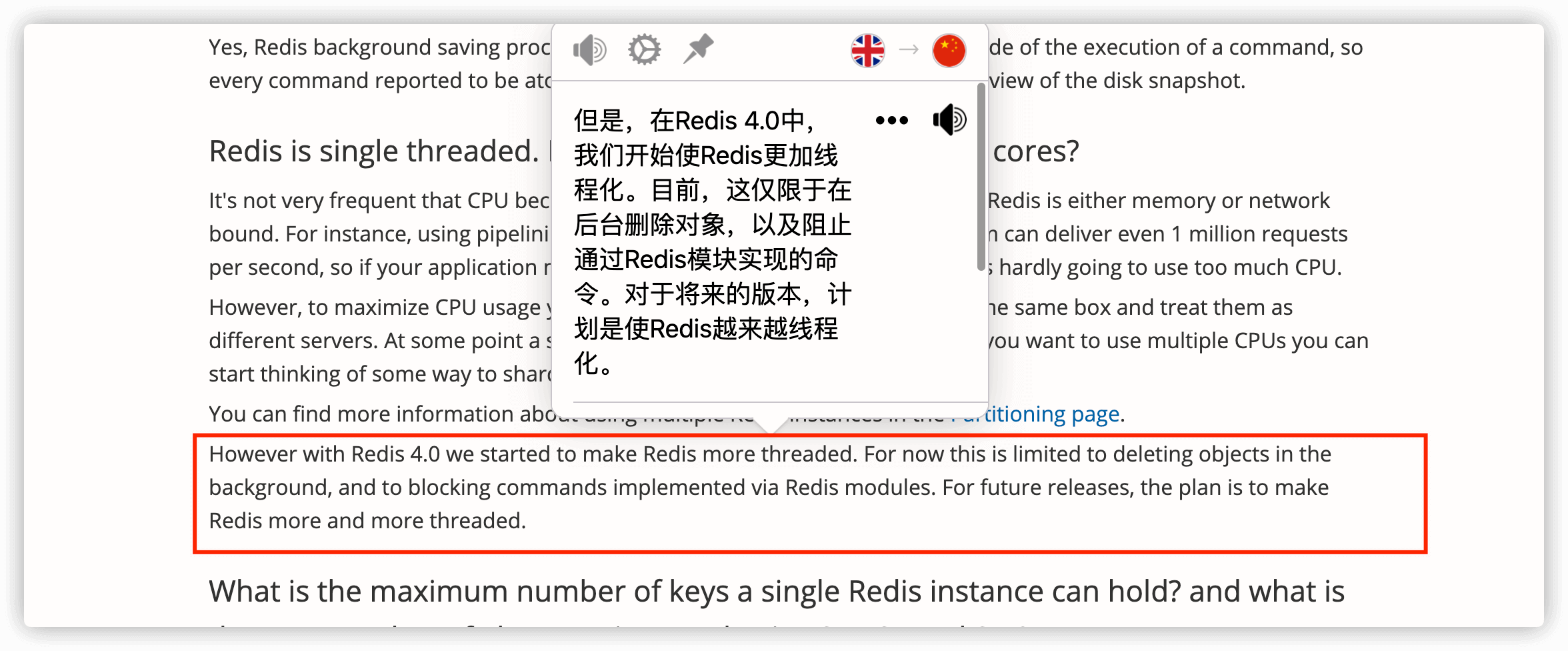

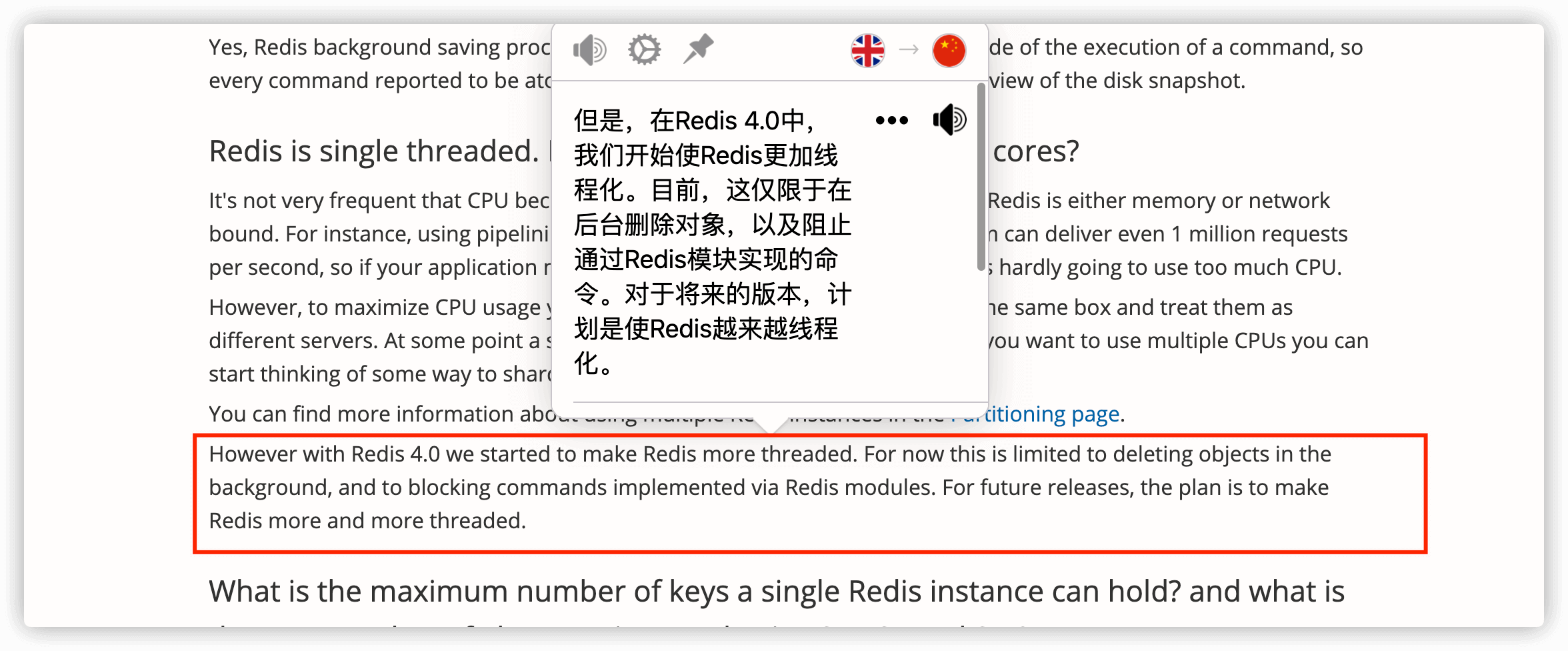

-Redis AOF 持久化机制是在执行完命令之后再记录日志,这和关系型数据库(如 MySQL)通常都是执行命令之前记录日志(方便故障恢复)不同。

+Redis's AOF persistence mechanism records logs after executing commands, differing from relational databases (like MySQL), which usually log before executing commands for recovery purposes.

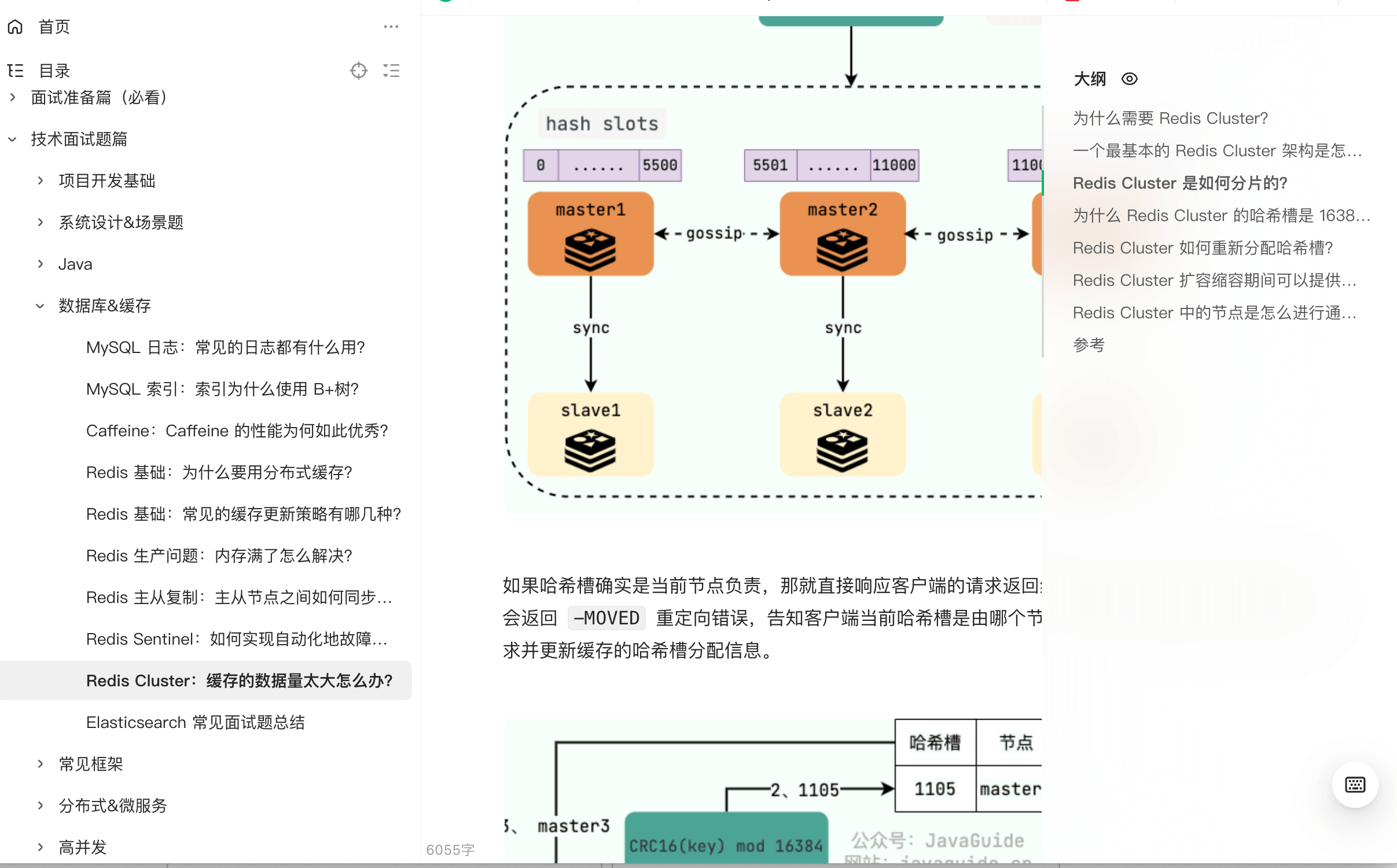

-

+

-**为什么是在执行完命令之后记录日志呢?**

+**Why record logs after executing commands?**

-- 避免额外的检查开销,AOF 记录日志不会对命令进行语法检查;

-- 在命令执行完之后再记录,不会阻塞当前的命令执行。

+- To avoid extra checking overhead, AOF log recording does not perform syntax checking on commands.

+- Logging after command execution does not block the current command execution.

-这样也带来了风险(我在前面介绍 AOF 持久化的时候也提到过):

+This also brings risks (which I mentioned when introducing AOF persistence):

-- 如果刚执行完命令 Redis 就宕机会导致对应的修改丢失;

-- **可能会阻塞后续其他命令的执行(AOF 记录日志是在 Redis 主线程中进行的)**。

+- If Redis crashes right after executing a command, the corresponding modifications may be lost.

+- **It may block the execution of subsequent commands (AOF log recording is conducted in the Redis main thread).**

-### AOF 刷盘阻塞

+### AOF Flush Blocking

-开启 AOF 持久化后每执行一条会更改 Redis 中的数据的命令,Redis 就会将该命令写入到 AOF 缓冲区 `server.aof_buf` 中,然后再根据 `appendfsync` 配置来决定何时将其同步到硬盘中的 AOF 文件。

+After enabling AOF persistence, every command that changes data in Redis will write that command to the AOF buffer `server.aof_buf`, and then according to the `appendfsync` configuration, it decides when to synchronize it to the AOF file on the hard disk.

-在 Redis 的配置文件中存在三种不同的 AOF 持久化方式( `fsync`策略),它们分别是:

+There are three different AOF persistence methods (fsync strategy) in Redis's configuration file:

-1. `appendfsync always`:主线程调用 `write` 执行写操作后,后台线程( `aof_fsync` 线程)立即会调用 `fsync` 函数同步 AOF 文件(刷盘),`fsync` 完成后线程返回,这样会严重降低 Redis 的性能(`write` + `fsync`)。

-2. `appendfsync everysec`:主线程调用 `write` 执行写操作后立即返回,由后台线程( `aof_fsync` 线程)每秒钟调用 `fsync` 函数(系统调用)同步一次 AOF 文件(`write`+`fsync`,`fsync`间隔为 1 秒)

-3. `appendfsync no`:主线程调用 `write` 执行写操作后立即返回,让操作系统决定何时进行同步,Linux 下一般为 30 秒一次(`write`但不`fsync`,`fsync` 的时机由操作系统决定)。

+1. `appendfsync always`: The main thread calls `write` to perform a write operation, after which the background thread (`aof_fsync` thread) immediately calls the `fsync` function to sync the AOF file (flush). After `fsync` completes, the thread returns; this will severely decrease Redis's performance (write + fsync).

+1. `appendfsync everysec`: The main thread calls `write` to perform a write operation and immediately returns, with the background thread (`aof_fsync` thread) calling the `fsync` function once every second to sync the AOF file (write + fsync, the fsync interval is 1 second).

+1. `appendfsync no`: The main thread calls `write` to perform a write operation and immediately returns, allowing the operating system to decide when to sync, which is usually once every 30 seconds on Linux (write but no fsync; the timing of fsync is determined by the operating system).

-当后台线程( `aof_fsync` 线程)调用 `fsync` 函数同步 AOF 文件时,需要等待,直到写入完成。当磁盘压力太大的时候,会导致 `fsync` 操作发生阻塞,主线程调用 `write` 函数时也会被阻塞。`fsync` 完成后,主线程执行 `write` 才能成功返回。

+When the background thread (`aof_fsync` thread) calls the `fsync` function to sync the AOF file, it needs to wait until the writing is complete. When there is too much disk pressure, blocking may occur during the `fsync` operation, and the main thread calling `write` will also be blocked. The main thread can only return successfully after `fsync` completes.

-关于 AOF 工作流程的详细介绍可以查看:[Redis 持久化机制详解](./redis-persistence.md),有助于理解 AOF 刷盘阻塞。

+For a detailed introduction to the AOF workflow, you can refer to: [Detailed Explanation of Redis Persistence Mechanism](./redis-persistence.md), which helps understand AOF flush blocking.

-### AOF 重写阻塞

+### AOF Rewrite Blocking

-1. fork 出一条子线程来将文件重写,在执行 `BGREWRITEAOF` 命令时,Redis 服务器会维护一个 AOF 重写缓冲区,该缓冲区会在子线程创建新 AOF 文件期间,记录服务器执行的所有写命令。

-2. 当子线程完成创建新 AOF 文件的工作之后,服务器会将重写缓冲区中的所有内容追加到新 AOF 文件的末尾,使得新的 AOF 文件保存的数据库状态与现有的数据库状态一致。

-3. 最后,服务器用新的 AOF 文件替换旧的 AOF 文件,以此来完成 AOF 文件重写操作。

+1. A child thread is forked to rewrite the file. When executing the `BGREWRITEAOF` command, the Redis server maintains an AOF rewrite buffer that records all write commands executed by the server during the child thread's creation of the new AOF file.

+1. After the child thread completes the task of creating the new AOF file, the server appends all content from the rewrite buffer to the end of the new AOF file, ensuring that the new AOF file preserves the database state consistent with the existing database state.

+1. Finally, the server replaces the old AOF file with the new AOF file to complete the AOF file rewrite operation.

-阻塞就是出现在第 2 步的过程中,将缓冲区中新数据写到新文件的过程中会产生**阻塞**。

+Blocking occurs during the process of step 2 when writing new data from the buffer to the new file, causing a **block**.

-相关阅读:[Redis AOF 重写阻塞问题分析](https://cloud.tencent.com/developer/article/1633077)。

+For further reading: [Analysis of Redis AOF Rewrite Blocking Issues](https://cloud.tencent.com/developer/article/1633077).

-## 大 Key

+## Big Key

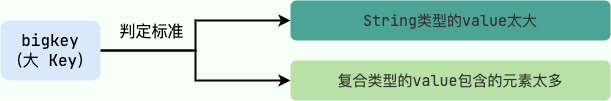

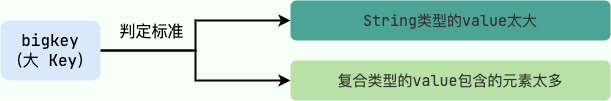

-如果一个 key 对应的 value 所占用的内存比较大,那这个 key 就可以看作是 bigkey。具体多大才算大呢?有一个不是特别精确的参考标准:

+If the value corresponding to a key occupies a large amount of memory, that key can be considered a big key. What exactly counts as large? There is a rather imprecise reference standard:

-- string 类型的 value 超过 1MB

-- 复合类型(列表、哈希、集合、有序集合等)的 value 包含的元素超过 5000 个(对于复合类型的 value 来说,不一定包含的元素越多,占用的内存就越多)。

+- String-type values exceeding 1MB.

+- Composite types (lists, hashes, sets, sorted sets, etc.) whose values contain more than 5000 elements (for composite types, having more elements does not necessarily mean occupying more memory).

-大 key 造成的阻塞问题如下:

+The blocking issues caused by big keys are as follows:

-- 客户端超时阻塞:由于 Redis 执行命令是单线程处理,然后在操作大 key 时会比较耗时,那么就会阻塞 Redis,从客户端这一视角看,就是很久很久都没有响应。

-- 引发网络阻塞:每次获取大 key 产生的网络流量较大,如果一个 key 的大小是 1 MB,每秒访问量为 1000,那么每秒会产生 1000MB 的流量,这对于普通千兆网卡的服务器来说是灾难性的。

-- 阻塞工作线程:如果使用 del 删除大 key 时,会阻塞工作线程,这样就没办法处理后续的命令。

+- Client timeout blocking: Since Redis executes commands in a single-threaded manner, operations on big keys can be time-consuming, causing Redis to block, resulting in the client not responding for an extended period.

+- Causing network blocking: The network traffic generated when retrieving big keys is relatively large. If a key's size is 1MB and the access frequency is 1000 per second, it will generate 1000MB of traffic per second, which is disastrous for a typical gigabit network card server.

+- Blocking worker threads: If deleting a big key using del, it will block worker threads, preventing subsequent commands from being processed.

-### 查找大 key

+### Finding Big Keys

-当我们在使用 Redis 自带的 `--bigkeys` 参数查找大 key 时,最好选择在从节点上执行该命令,因为主节点上执行时,会**阻塞**主节点。

+When using Redis's built-in `--bigkeys` parameter to find big keys, it is best to execute the command on a slave node, as executing it on the master node will **block** the master node.

-- 我们还可以使用 SCAN 命令来查找大 key;

+- We can also use the SCAN command to find big keys;

+- Analyzing RDB files to identify big keys requires that Redis is using RDB persistence. There are tools available online:

+ - redis-rdb-tools: A Python tool for analyzing Redis RDB snapshot files.

+ - rdb_bigkeys: A Go tool for analyzing Redis RDB snapshot files, which performs better.

-- 通过分析 RDB 文件来找出 big key,这种方案的前提是 Redis 采用的是 RDB 持久化。网上有现成的工具:

+### Deleting Big Keys

-- - redis-rdb-tools:Python 语言写的用来分析 Redis 的 RDB 快照文件用的工具

- - rdb_bigkeys:Go 语言写的用来分析 Redis 的 RDB 快照文件用的工具,性能更好。

+The essence of the delete operation is to free the memory space occupied by key-value pairs.

-### 删除大 key

+Freeing memory is just the first step. To manage memory space more efficiently, when an application releases memory, **the operating system needs to insert the released memory blocks into a linked list of free memory blocks** for subsequent management and reallocation. This process itself requires some time and can **block** the current application that is freeing memory.

-删除操作的本质是要释放键值对占用的内存空间。

+Therefore, if a large amount of memory is released at once, the time required for managing the linked list of free memory blocks will increase, consequently causing blocking in the Redis main thread. If the main thread becomes blocked, all other requests may timeout, leading to increasing timeouts that can exhaust Redis connections and generate various exceptions.

-释放内存只是第一步,为了更加高效地管理内存空间,在应用程序释放内存时,**操作系统需要把释放掉的内存块插入一个空闲内存块的链表**,以便后续进行管理和再分配。这个过程本身需要一定时间,而且会**阻塞**当前释放内存的应用程序。

+When deleting big keys, it is recommended to use batch deletions and asynchronous deletions.

-所以,如果一下子释放了大量内存,空闲内存块链表操作时间就会增加,相应地就会造成 Redis 主线程的阻塞,如果主线程发生了阻塞,其他所有请求可能都会超时,超时越来越多,会造成 Redis 连接耗尽,产生各种异常。

+## Clearing the Database

-删除大 key 时建议采用分批次删除和异步删除的方式进行。

+Clearing the database is similar to the deletion of big keys; `flushdb` and `flushall` involve the deletion and release of all key-value pairs, which are also blocking points in Redis.

-## 清空数据库

+## Cluster Expansion

-清空数据库和上面 bigkey 删除也是同样道理,`flushdb`、`flushall` 也涉及到删除和释放所有的键值对,也是 Redis 的阻塞点。

+Redis clusters can dynamically scale up and down nodes. This process is currently semi-automated and requires manual intervention.

-## 集群扩容

+During the expansion or contraction, data migration is needed. Redis ensures the consistency of migration; all migration operations are synchronous.

-Redis 集群可以进行节点的动态扩容缩容,这一过程目前还处于半自动状态,需要人工介入。

+During migration, both ends of Redis will enter a blocking state for varying durations. For small keys, this time can be negligible, but if a key's memory usage is too large, it can trigger failover within the cluster, causing unnecessary switching.

-在扩缩容的时候,需要进行数据迁移。而 Redis 为了保证迁移的一致性,迁移所有操作都是同步操作。

+## Swap

-执行迁移时,两端的 Redis 均会进入时长不等的阻塞状态,对于小 Key,该时间可以忽略不计,但如果一旦 Key 的内存使用过大,严重的时候会触发集群内的故障转移,造成不必要的切换。

+**What is Swap?** Swap refers to the exchange, and in Linux, Swap is often called memory swapping or swap partition. Similar to virtual memory in Windows, it solves memory shortages by virtualizing some hard disk space to be used as memory. Thus, the purpose of the Swap partition is to sacrifice hard disk space to increase memory and address the issue of insufficient or overloaded VPS memory.

-## Swap(内存交换)

+Swap can be very detrimental to Redis. One important premise for Redis to ensure high performance is that all data exists in memory. If the operating system swaps out some of the memory used by Redis to the hard disk, the read and write speeds of memory and hard disk differ by several orders of magnitude, leading to a drastic decline in Redis performance after the swap.

-**什么是 Swap?** Swap 直译过来是交换的意思,Linux 中的 Swap 常被称为内存交换或者交换分区。类似于 Windows 中的虚拟内存,就是当内存不足的时候,把一部分硬盘空间虚拟成内存使用,从而解决内存容量不足的情况。因此,Swap 分区的作用就是牺牲硬盘,增加内存,解决 VPS 内存不够用或者爆满的问题。

+Here are methods to check if Redis is experiencing Swap:

-Swap 对于 Redis 来说是非常致命的,Redis 保证高性能的一个重要前提是所有的数据在内存中。如果操作系统把 Redis 使用的部分内存换出硬盘,由于内存与硬盘的读写速度差几个数量级,会导致发生交换后的 Redis 性能急剧下降。

-

-识别 Redis 发生 Swap 的检查方法如下:

-

-1、查询 Redis 进程号

+1. Query the Redis process ID

```bash

redis-cli -p 6383 info server | grep process_id

process_id: 4476

```

-2、根据进程号查询内存交换信息

+2. Check memory swap information based on the process ID

```bash

cat /proc/4476/smaps | grep Swap

@@ -152,27 +150,27 @@ Swap: 0kB

.....

```

-如果交换量都是 0KB 或者个别的是 4KB,则正常。

+If the swap amounts are all 0KB or a few are 4KB, it is normal.

-预防内存交换的方法:

+Methods to prevent memory swapping:

-- 保证机器充足的可用内存

-- 确保所有 Redis 实例设置最大可用内存(maxmemory),防止极端情况 Redis 内存不可控的增长

-- 降低系统使用 swap 优先级,如`echo 10 > /proc/sys/vm/swappiness`

+- Ensure ample available memory on the machine.

+- Ensure all Redis instances set a maximum available memory (maxmemory) to prevent uncontrolled growth of Redis memory in extreme situations.

+- Lower the system's swap priority, such as `echo 10 > /proc/sys/vm/swappiness`.

-## CPU 竞争

+## CPU Competition

-Redis 是典型的 CPU 密集型应用,不建议和其他多核 CPU 密集型服务部署在一起。当其他进程过度消耗 CPU 时,将严重影响 Redis 的吞吐量。

+Redis is a typical CPU-intensive application and should not be deployed alongside other multi-core CPU-intensive services. When other processes excessively consume CPU, it will severely affect Redis's throughput.

-可以通过`redis-cli --stat`获取当前 Redis 使用情况。通过`top`命令获取进程对 CPU 的利用率等信息 通过`info commandstats`统计信息分析出命令不合理开销时间,查看是否是因为高算法复杂度或者过度的内存优化问题。

+You can use `redis-cli --stat` to get the current Redis usage. The `top` command can be used to get information on processes' CPU utilization, and `info commandstats` can provide statistics to analyze unreasonable command overhead, checking if it is due to high algorithm complexity or excessive memory optimization issues.

-## 网络问题

+## Network Issues

-连接拒绝、网络延迟,网卡软中断等网络问题也可能会导致 Redis 阻塞。

+Connection refusals, network delays, software interrupts on network cards, and other network issues might also lead to Redis blocking.

-## 参考

+## References

-- Redis 阻塞的 6 大类场景分析与总结:

-- Redis 开发与运维笔记-Redis 的噩梦-阻塞:

+- Analysis and Summary of 6 Major Scenarios of Redis Blocking:

+- Redis Development and Operation Notes - The Nightmare of Redis - Blocking:

diff --git a/docs/database/redis/redis-data-structures-01.md b/docs/database/redis/redis-data-structures-01.md

index 9dfb0c3eaa5..0e7d5a4d03f 100644

--- a/docs/database/redis/redis-data-structures-01.md

+++ b/docs/database/redis/redis-data-structures-01.md

@@ -1,69 +1,69 @@

---

-title: Redis 5 种基本数据类型详解

-category: 数据库

+title: Detailed Explanation of 5 Basic Data Types in Redis

+category: Database

tag:

- Redis

head:

- - meta

- name: keywords

- content: Redis常见数据类型

+ content: Common data types in Redis

- - meta

- name: description

- content: Redis基础数据类型总结:String(字符串)、List(列表)、Set(集合)、Hash(散列)、Zset(有序集合)

+ content: Summary of Redis basic data types: String, List, Set, Hash, Zset

---

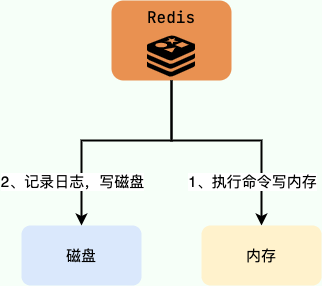

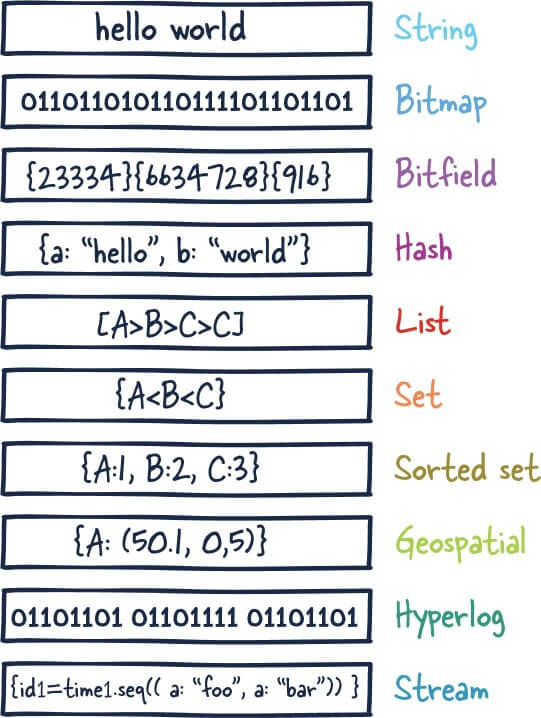

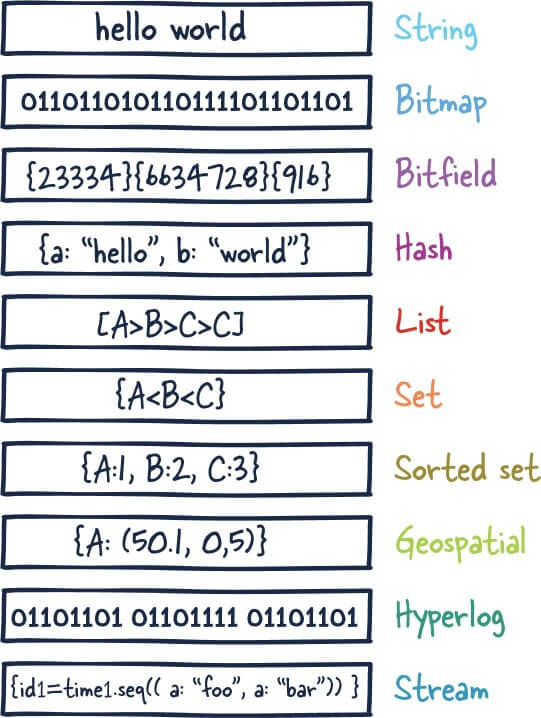

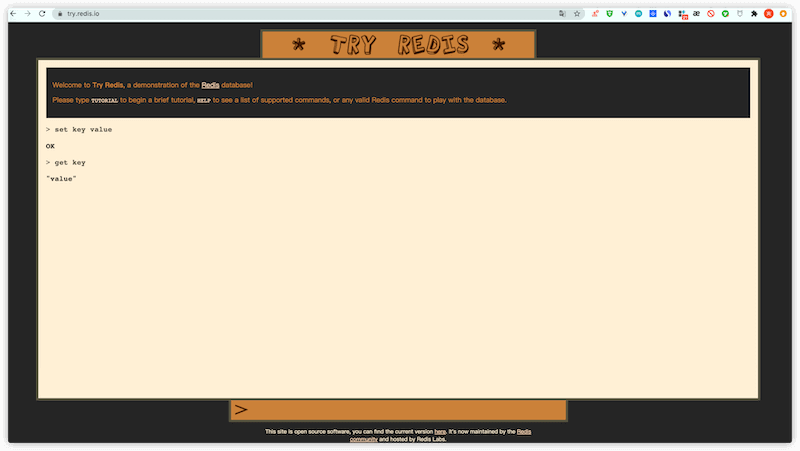

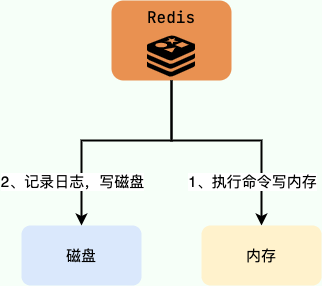

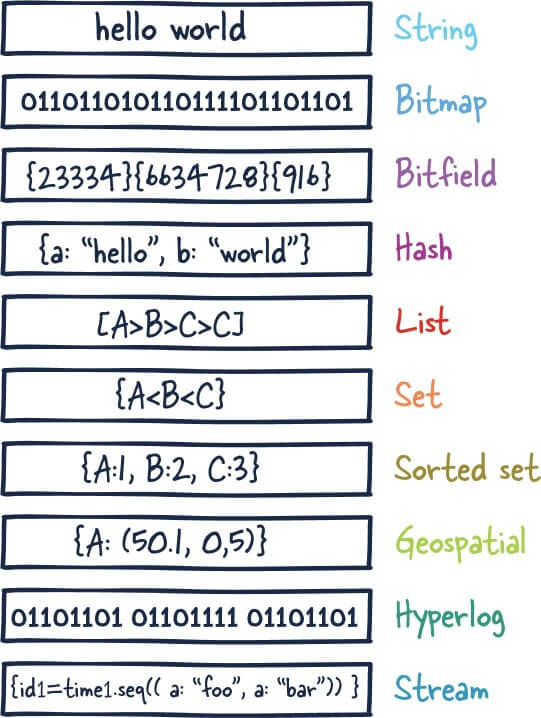

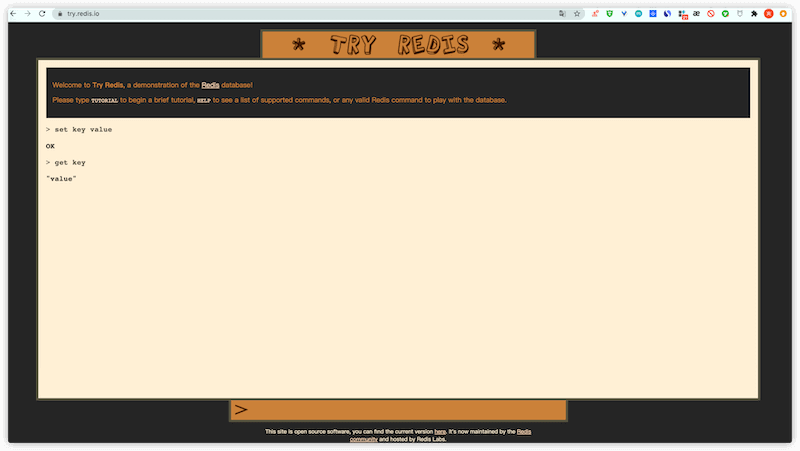

-Redis 共有 5 种基本数据类型:String(字符串)、List(列表)、Set(集合)、Hash(散列)、Zset(有序集合)。

+Redis has a total of 5 basic data types: String, List, Set, Hash, and Zset.

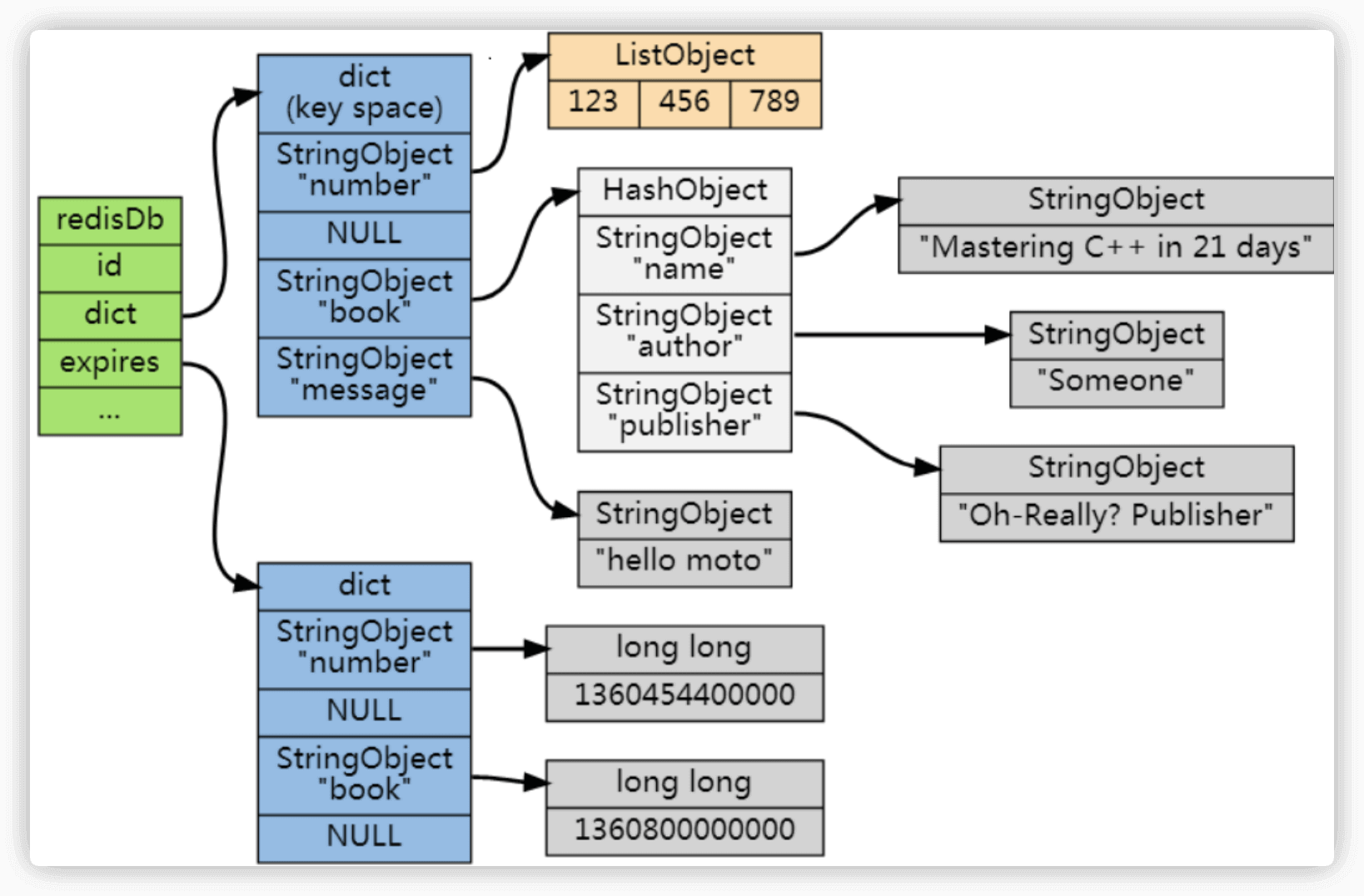

-这 5 种数据类型是直接提供给用户使用的,是数据的保存形式,其底层实现主要依赖这 8 种数据结构:简单动态字符串(SDS)、LinkedList(双向链表)、Dict(哈希表/字典)、SkipList(跳跃表)、Intset(整数集合)、ZipList(压缩列表)、QuickList(快速列表)。

+These 5 data types are directly provided for user use and represent the form of data storage. Their underlying implementation mainly relies on these 8 data structures: Simple Dynamic Strings (SDS), LinkedList, Dict (hash table/dictionary), SkipList, Intset (integer set), ZipList (compressed list), and QuickList.

-Redis 5 种基本数据类型对应的底层数据结构实现如下表所示:

+The underlying data structure implementations corresponding to the 5 basic data types in Redis are shown in the table below:

| String | List | Hash | Set | Zset |

| :----- | :--------------------------- | :------------ | :----------- | :---------------- |

-| SDS | LinkedList/ZipList/QuickList | Dict、ZipList | Dict、Intset | ZipList、SkipList |

+| SDS | LinkedList/ZipList/QuickList | Dict, ZipList | Dict, Intset | ZipList, SkipList |

-Redis 3.2 之前,List 底层实现是 LinkedList 或者 ZipList。 Redis 3.2 之后,引入了 LinkedList 和 ZipList 的结合 QuickList,List 的底层实现变为 QuickList。从 Redis 7.0 开始, ZipList 被 ListPack 取代。

+Before Redis 3.2, the underlying implementation of List was LinkedList or ZipList. After Redis 3.2, QuickList, a combination of LinkedList and ZipList, was introduced, and the underlying implementation of List changed to QuickList. Starting from Redis 7.0, ZipList has been replaced by ListPack.

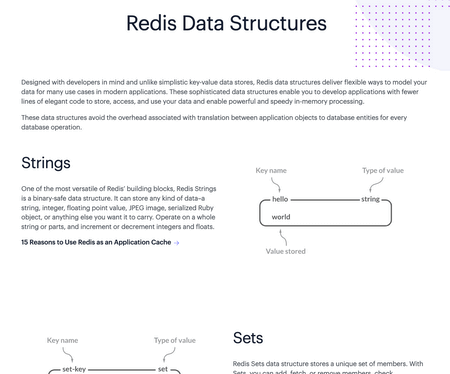

-你可以在 Redis 官网上找到 Redis 数据类型/结构非常详细的介绍:

+You can find a very detailed introduction to Redis data types/structures on the official Redis website:

- [Redis Data Structures](https://redis.com/redis-enterprise/data-structures/)

- [Redis Data types tutorial](https://redis.io/docs/manual/data-types/data-types-tutorial/)

-未来随着 Redis 新版本的发布,可能会有新的数据结构出现,通过查阅 Redis 官网对应的介绍,你总能获取到最靠谱的信息。

+In the future, with the release of new versions of Redis, new data structures may appear. By consulting the corresponding introductions on the Redis official website, you can always obtain the most reliable information.

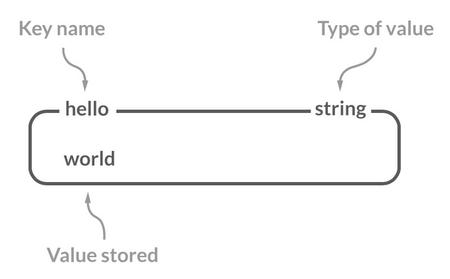

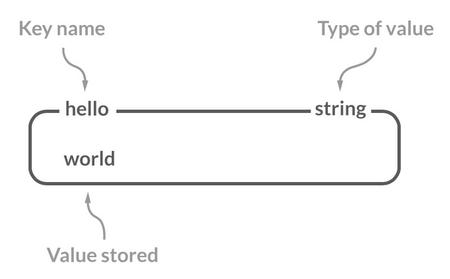

-## String(字符串)

+## String

-### 介绍

+### Introduction

-String 是 Redis 中最简单同时也是最常用的一个数据类型。

+String is the simplest and most commonly used data type in Redis.

-String 是一种二进制安全的数据类型,可以用来存储任何类型的数据比如字符串、整数、浮点数、图片(图片的 base64 编码或者解码或者图片的路径)、序列化后的对象。

+String is a binary-safe data type that can be used to store any type of data, such as strings, integers, floating-point numbers, images (base64 encoding or decoding of images or image paths), and serialized objects.

-虽然 Redis 是用 C 语言写的,但是 Redis 并没有使用 C 的字符串表示,而是自己构建了一种 **简单动态字符串**(Simple Dynamic String,**SDS**)。相比于 C 的原生字符串,Redis 的 SDS 不光可以保存文本数据还可以保存二进制数据,并且获取字符串长度复杂度为 O(1)(C 字符串为 O(N)),除此之外,Redis 的 SDS API 是安全的,不会造成缓冲区溢出。

+Although Redis is written in C, it does not use C's string representation but instead constructs a **Simple Dynamic String** (SDS). Compared to C's native strings, Redis's SDS can not only store text data but also binary data, and the complexity of obtaining the string length is O(1) (C strings are O(N)). In addition, Redis's SDS API is safe and does not cause buffer overflows.

-### 常用命令

+### Common Commands

-| 命令 | 介绍 |

-| ------------------------------- | -------------------------------- |

-| SET key value | 设置指定 key 的值 |

-| SETNX key value | 只有在 key 不存在时设置 key 的值 |

-| GET key | 获取指定 key 的值 |

-| MSET key1 value1 key2 value2 …… | 设置一个或多个指定 key 的值 |

-| MGET key1 key2 ... | 获取一个或多个指定 key 的值 |

-| STRLEN key | 返回 key 所储存的字符串值的长度 |

-| INCR key | 将 key 中储存的数字值增一 |

-| DECR key | 将 key 中储存的数字值减一 |

-| EXISTS key | 判断指定 key 是否存在 |

-| DEL key(通用) | 删除指定的 key |

-| EXPIRE key seconds(通用) | 给指定 key 设置过期时间 |

+| Command | Description |

+| -------------------------------- | --------------------------------------------------- |

+| SET key value | Set the value of the specified key |

+| SETNX key value | Set the value of the key only if it does not exist |

+| GET key | Get the value of the specified key |

+| MSET key1 value1 key2 value2 ... | Set the values of one or more specified keys |

+| MGET key1 key2 ... | Get the values of one or more specified keys |

+| STRLEN key | Return the length of the string value stored at key |

+| INCR key | Increment the numeric value stored at key by one |

+| DECR key | Decrement the numeric value stored at key by one |

+| EXISTS key | Determine if the specified key exists |

+| DEL key (general) | Delete the specified key |

+| EXPIRE key seconds (general) | Set an expiration time for the specified key |

-更多 Redis String 命令以及详细使用指南,请查看 Redis 官网对应的介绍: 。

+For more Redis String commands and detailed usage guides, please refer to the corresponding introduction on the Redis official website: .

-**基本操作**:

+**Basic Operations**:

```bash

> SET key value

@@ -80,424 +80,22 @@ OK

(nil)

```

-**批量设置**:

+**Batch Setting**:

```bash

> MSET key1 value1 key2 value2

OK

-> MGET key1 key2 # 批量获取多个 key 对应的 value

+> MGET key1 key2 # Batch get the values corresponding to multiple keys

1) "value1"

2) "value2"

```

-**计数器(字符串的内容为整数的时候可以使用):**

+**Counter (when the content of the string is an integer)**:

```bash

> SET number 1

OK

-> INCR number # 将 key 中储存的数字值增一

+> INCR number # Increment the numeric value stored at key by one

(integer) 2

> GET number

-"2"

-> DECR number # 将 key 中储存的数字值减一

-(integer) 1

-> GET number

-"1"

-```

-

-**设置过期时间(默认为永不过期)**:

-

-```bash

-> EXPIRE key 60

-(integer) 1

-> SETEX key 60 value # 设置值并设置过期时间

-OK

-> TTL key

-(integer) 56

-```

-

-### 应用场景

-

-**需要存储常规数据的场景**

-

-- 举例:缓存 Session、Token、图片地址、序列化后的对象(相比较于 Hash 存储更节省内存)。

-- 相关命令:`SET`、`GET`。

-

-**需要计数的场景**

-

-- 举例:用户单位时间的请求数(简单限流可以用到)、页面单位时间的访问数。

-- 相关命令:`SET`、`GET`、 `INCR`、`DECR` 。

-

-**分布式锁**

-

-利用 `SETNX key value` 命令可以实现一个最简易的分布式锁(存在一些缺陷,通常不建议这样实现分布式锁)。

-

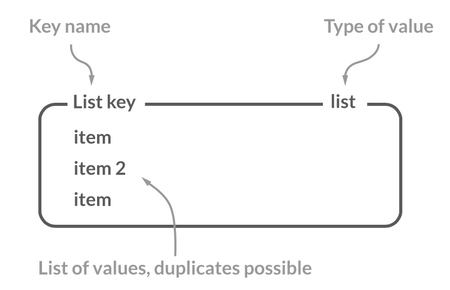

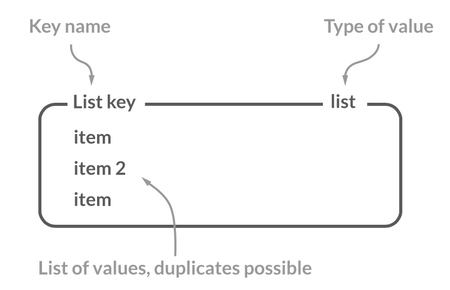

-## List(列表)

-

-### 介绍

-

-Redis 中的 List 其实就是链表数据结构的实现。我在 [线性数据结构 :数组、链表、栈、队列](https://javaguide.cn/cs-basics/data-structure/linear-data-structure.html) 这篇文章中详细介绍了链表这种数据结构,我这里就不多做介绍了。

-

-许多高级编程语言都内置了链表的实现比如 Java 中的 `LinkedList`,但是 C 语言并没有实现链表,所以 Redis 实现了自己的链表数据结构。Redis 的 List 的实现为一个 **双向链表**,即可以支持反向查找和遍历,更方便操作,不过带来了部分额外的内存开销。

-

-

-

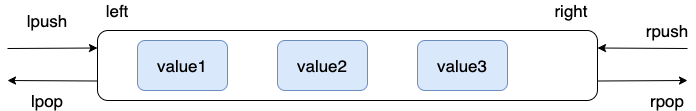

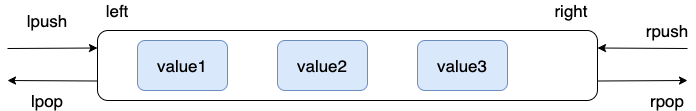

-### 常用命令

-

-| 命令 | 介绍 |

-| --------------------------- | ------------------------------------------ |

-| RPUSH key value1 value2 ... | 在指定列表的尾部(右边)添加一个或多个元素 |

-| LPUSH key value1 value2 ... | 在指定列表的头部(左边)添加一个或多个元素 |

-| LSET key index value | 将指定列表索引 index 位置的值设置为 value |

-| LPOP key | 移除并获取指定列表的第一个元素(最左边) |

-| RPOP key | 移除并获取指定列表的最后一个元素(最右边) |

-| LLEN key | 获取列表元素数量 |

-| LRANGE key start end | 获取列表 start 和 end 之间 的元素 |

-

-更多 Redis List 命令以及详细使用指南,请查看 Redis 官网对应的介绍: 。

-

-**通过 `RPUSH/LPOP` 或者 `LPUSH/RPOP`实现队列**:

-

-```bash

-> RPUSH myList value1

-(integer) 1

-> RPUSH myList value2 value3

-(integer) 3

-> LPOP myList

-"value1"

-> LRANGE myList 0 1

-1) "value2"

-2) "value3"

-> LRANGE myList 0 -1

-1) "value2"

-2) "value3"

-```

-

-**通过 `RPUSH/RPOP`或者`LPUSH/LPOP` 实现栈**:

-

-```bash

-> RPUSH myList2 value1 value2 value3

-(integer) 3

-> RPOP myList2 # 将 list的最右边的元素取出

-"value3"

-```

-

-我专门画了一个图方便大家理解 `RPUSH` , `LPOP` , `lpush` , `RPOP` 命令:

-

-

-

-**通过 `LRANGE` 查看对应下标范围的列表元素**:

-

-```bash

-> RPUSH myList value1 value2 value3

-(integer) 3

-> LRANGE myList 0 1

-1) "value1"

-2) "value2"

-> LRANGE myList 0 -1

-1) "value1"

-2) "value2"

-3) "value3"

-```

-

-通过 `LRANGE` 命令,你可以基于 List 实现分页查询,性能非常高!

-

-**通过 `LLEN` 查看链表长度**:

-

-```bash

-> LLEN myList

-(integer) 3

-```

-

-### 应用场景

-

-**信息流展示**

-

-- 举例:最新文章、最新动态。

-- 相关命令:`LPUSH`、`LRANGE`。

-

-**消息队列**

-

-`List` 可以用来做消息队列,只是功能过于简单且存在很多缺陷,不建议这样做。

-

-相对来说,Redis 5.0 新增加的一个数据结构 `Stream` 更适合做消息队列一些,只是功能依然非常简陋。和专业的消息队列相比,还是有很多欠缺的地方比如消息丢失和堆积问题不好解决。

-

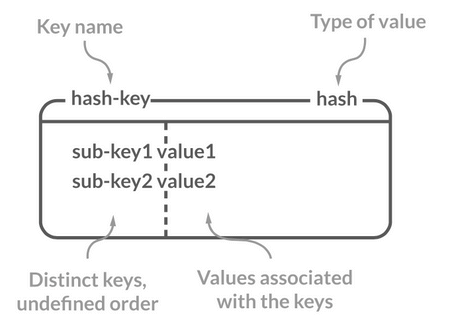

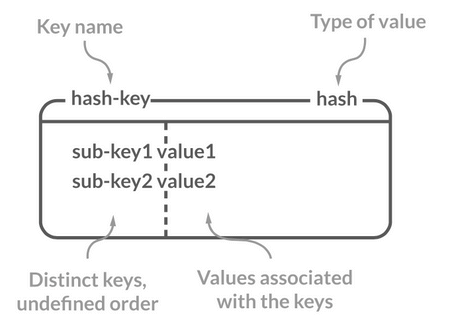

-## Hash(哈希)

-

-### 介绍

-

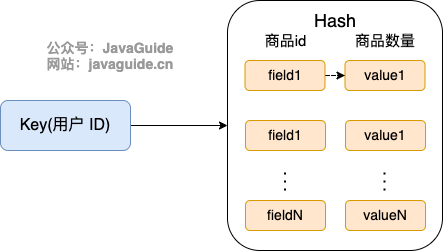

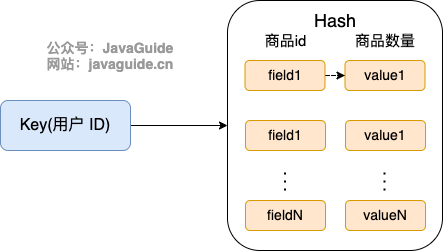

-Redis 中的 Hash 是一个 String 类型的 field-value(键值对) 的映射表,特别适合用于存储对象,后续操作的时候,你可以直接修改这个对象中的某些字段的值。

-

-Hash 类似于 JDK1.8 前的 `HashMap`,内部实现也差不多(数组 + 链表)。不过,Redis 的 Hash 做了更多优化。

-

-

-

-### 常用命令

-

-| 命令 | 介绍 |

-| ----------------------------------------- | -------------------------------------------------------- |

-| HSET key field value | 设置指定哈希表中指定字段的值 |

-| HSETNX key field value | 只有指定字段不存在时设置指定字段的值 |

-| HMSET key field1 value1 field2 value2 ... | 同时将一个或多个 field-value (域-值)对设置到指定哈希表中 |

-| HGET key field | 获取指定哈希表中指定字段的值 |

-| HMGET key field1 field2 ... | 获取指定哈希表中一个或者多个指定字段的值 |

-| HGETALL key | 获取指定哈希表中所有的键值对 |

-| HEXISTS key field | 查看指定哈希表中指定的字段是否存在 |

-| HDEL key field1 field2 ... | 删除一个或多个哈希表字段 |

-| HLEN key | 获取指定哈希表中字段的数量 |

-| HINCRBY key field increment | 对指定哈希中的指定字段做运算操作(正数为加,负数为减) |

-

-更多 Redis Hash 命令以及详细使用指南,请查看 Redis 官网对应的介绍: 。

-

-**模拟对象数据存储**:

-

-```bash

-> HMSET userInfoKey name "guide" description "dev" age 24

-OK

-> HEXISTS userInfoKey name # 查看 key 对应的 value中指定的字段是否存在。

-(integer) 1

-> HGET userInfoKey name # 获取存储在哈希表中指定字段的值。

-"guide"

-> HGET userInfoKey age

-"24"

-> HGETALL userInfoKey # 获取在哈希表中指定 key 的所有字段和值

-1) "name"

-2) "guide"

-3) "description"

-4) "dev"

-5) "age"

-6) "24"

-> HSET userInfoKey name "GuideGeGe"

-> HGET userInfoKey name

-"GuideGeGe"

-> HINCRBY userInfoKey age 2

-(integer) 26

```

-

-### 应用场景

-

-**对象数据存储场景**

-

-- 举例:用户信息、商品信息、文章信息、购物车信息。

-- 相关命令:`HSET` (设置单个字段的值)、`HMSET`(设置多个字段的值)、`HGET`(获取单个字段的值)、`HMGET`(获取多个字段的值)。

-

-## Set(集合)

-

-### 介绍

-

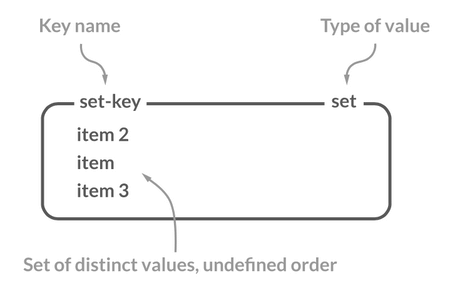

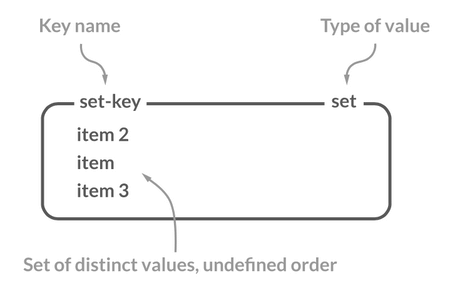

-Redis 中的 Set 类型是一种无序集合,集合中的元素没有先后顺序但都唯一,有点类似于 Java 中的 `HashSet` 。当你需要存储一个列表数据,又不希望出现重复数据时,Set 是一个很好的选择,并且 Set 提供了判断某个元素是否在一个 Set 集合内的重要接口,这个也是 List 所不能提供的。

-

-你可以基于 Set 轻易实现交集、并集、差集的操作,比如你可以将一个用户所有的关注人存在一个集合中,将其所有粉丝存在一个集合。这样的话,Set 可以非常方便的实现如共同关注、共同粉丝、共同喜好等功能。这个过程也就是求交集的过程。

-

-

-

-### 常用命令

-

-| 命令 | 介绍 |

-| ------------------------------------- | ----------------------------------------- |

-| SADD key member1 member2 ... | 向指定集合添加一个或多个元素 |

-| SMEMBERS key | 获取指定集合中的所有元素 |

-| SCARD key | 获取指定集合的元素数量 |

-| SISMEMBER key member | 判断指定元素是否在指定集合中 |

-| SINTER key1 key2 ... | 获取给定所有集合的交集 |

-| SINTERSTORE destination key1 key2 ... | 将给定所有集合的交集存储在 destination 中 |

-| SUNION key1 key2 ... | 获取给定所有集合的并集 |

-| SUNIONSTORE destination key1 key2 ... | 将给定所有集合的并集存储在 destination 中 |

-| SDIFF key1 key2 ... | 获取给定所有集合的差集 |

-| SDIFFSTORE destination key1 key2 ... | 将给定所有集合的差集存储在 destination 中 |

-| SPOP key count | 随机移除并获取指定集合中一个或多个元素 |

-| SRANDMEMBER key count | 随机获取指定集合中指定数量的元素 |

-

-更多 Redis Set 命令以及详细使用指南,请查看 Redis 官网对应的介绍: 。

-

-**基本操作**:

-

-```bash

-> SADD mySet value1 value2

-(integer) 2

-> SADD mySet value1 # 不允许有重复元素,因此添加失败

-(integer) 0

-> SMEMBERS mySet

-1) "value1"

-2) "value2"

-> SCARD mySet

-(integer) 2

-> SISMEMBER mySet value1

-(integer) 1

-> SADD mySet2 value2 value3

-(integer) 2

-```

-

-- `mySet` : `value1`、`value2` 。

-- `mySet2`:`value2`、`value3` 。

-

-**求交集**:

-

-```bash

-> SINTERSTORE mySet3 mySet mySet2

-(integer) 1

-> SMEMBERS mySet3

-1) "value2"

-```

-

-**求并集**:

-

-```bash

-> SUNION mySet mySet2

-1) "value3"

-2) "value2"

-3) "value1"

-```

-

-**求差集**:

-

-```bash

-> SDIFF mySet mySet2 # 差集是由所有属于 mySet 但不属于 A 的元素组成的集合

-1) "value1"

-```

-

-### 应用场景

-

-**需要存放的数据不能重复的场景**

-

-- 举例:网站 UV 统计(数据量巨大的场景还是 `HyperLogLog`更适合一些)、文章点赞、动态点赞等场景。

-- 相关命令:`SCARD`(获取集合数量) 。

-

-

-

-**需要获取多个数据源交集、并集和差集的场景**

-

-- 举例:共同好友(交集)、共同粉丝(交集)、共同关注(交集)、好友推荐(差集)、音乐推荐(差集)、订阅号推荐(差集+交集) 等场景。

-- 相关命令:`SINTER`(交集)、`SINTERSTORE` (交集)、`SUNION` (并集)、`SUNIONSTORE`(并集)、`SDIFF`(差集)、`SDIFFSTORE` (差集)。

-

-

-

-**需要随机获取数据源中的元素的场景**

-

-- 举例:抽奖系统、随机点名等场景。

-- 相关命令:`SPOP`(随机获取集合中的元素并移除,适合不允许重复中奖的场景)、`SRANDMEMBER`(随机获取集合中的元素,适合允许重复中奖的场景)。

-

-## Sorted Set(有序集合)

-

-### 介绍

-

-Sorted Set 类似于 Set,但和 Set 相比,Sorted Set 增加了一个权重参数 `score`,使得集合中的元素能够按 `score` 进行有序排列,还可以通过 `score` 的范围来获取元素的列表。有点像是 Java 中 `HashMap` 和 `TreeSet` 的结合体。

-

-

-

-### 常用命令

-

-| 命令 | 介绍 |

-| --------------------------------------------- | ------------------------------------------------------------------------------------------------------------- |

-| ZADD key score1 member1 score2 member2 ... | 向指定有序集合添加一个或多个元素 |

-| ZCARD KEY | 获取指定有序集合的元素数量 |

-| ZSCORE key member | 获取指定有序集合中指定元素的 score 值 |

-| ZINTERSTORE destination numkeys key1 key2 ... | 将给定所有有序集合的交集存储在 destination 中,对相同元素对应的 score 值进行 SUM 聚合操作,numkeys 为集合数量 |

-| ZUNIONSTORE destination numkeys key1 key2 ... | 求并集,其它和 ZINTERSTORE 类似 |

-| ZDIFFSTORE destination numkeys key1 key2 ... | 求差集,其它和 ZINTERSTORE 类似 |

-| ZRANGE key start end | 获取指定有序集合 start 和 end 之间的元素(score 从低到高) |

-| ZREVRANGE key start end | 获取指定有序集合 start 和 end 之间的元素(score 从高到底) |

-| ZREVRANK key member | 获取指定有序集合中指定元素的排名(score 从大到小排序) |

-

-更多 Redis Sorted Set 命令以及详细使用指南,请查看 Redis 官网对应的介绍: 。

-

-**基本操作**:

-

-```bash

-> ZADD myZset 2.0 value1 1.0 value2

-(integer) 2

-> ZCARD myZset

-2

-> ZSCORE myZset value1

-2.0

-> ZRANGE myZset 0 1

-1) "value2"

-2) "value1"

-> ZREVRANGE myZset 0 1

-1) "value1"

-2) "value2"

-> ZADD myZset2 4.0 value2 3.0 value3

-(integer) 2

-

-```

-

-- `myZset` : `value1`(2.0)、`value2`(1.0) 。

-- `myZset2`:`value2` (4.0)、`value3`(3.0) 。

-

-**获取指定元素的排名**:

-

-```bash

-> ZREVRANK myZset value1

-0

-> ZREVRANK myZset value2

-1

-```

-

-**求交集**:

-

-```bash

-> ZINTERSTORE myZset3 2 myZset myZset2

-1

-> ZRANGE myZset3 0 1 WITHSCORES

-value2

-5

-```

-

-**求并集**:

-

-```bash

-> ZUNIONSTORE myZset4 2 myZset myZset2

-3

-> ZRANGE myZset4 0 2 WITHSCORES

-value1

-2

-value3

-3

-value2

-5

-```

-

-**求差集**:

-

-```bash

-> ZDIFF 2 myZset myZset2 WITHSCORES

-value1

-2

-```

-

-### 应用场景

-

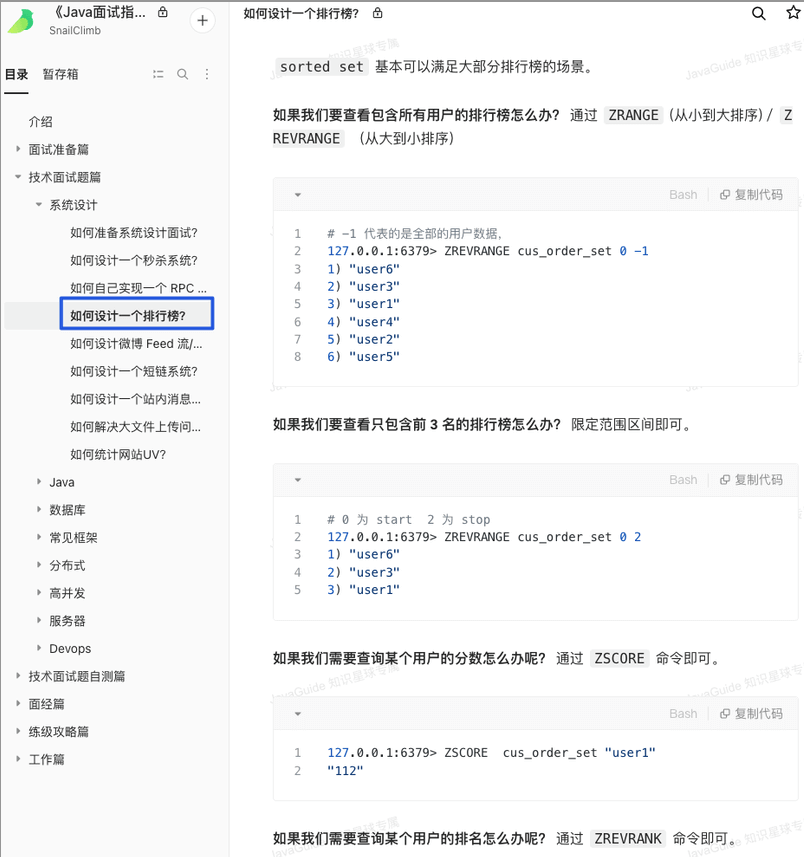

-**需要随机获取数据源中的元素根据某个权重进行排序的场景**

-

-- 举例:各种排行榜比如直播间送礼物的排行榜、朋友圈的微信步数排行榜、王者荣耀中的段位排行榜、话题热度排行榜等等。

-- 相关命令:`ZRANGE` (从小到大排序)、 `ZREVRANGE` (从大到小排序)、`ZREVRANK` (指定元素排名)。

-

-

-

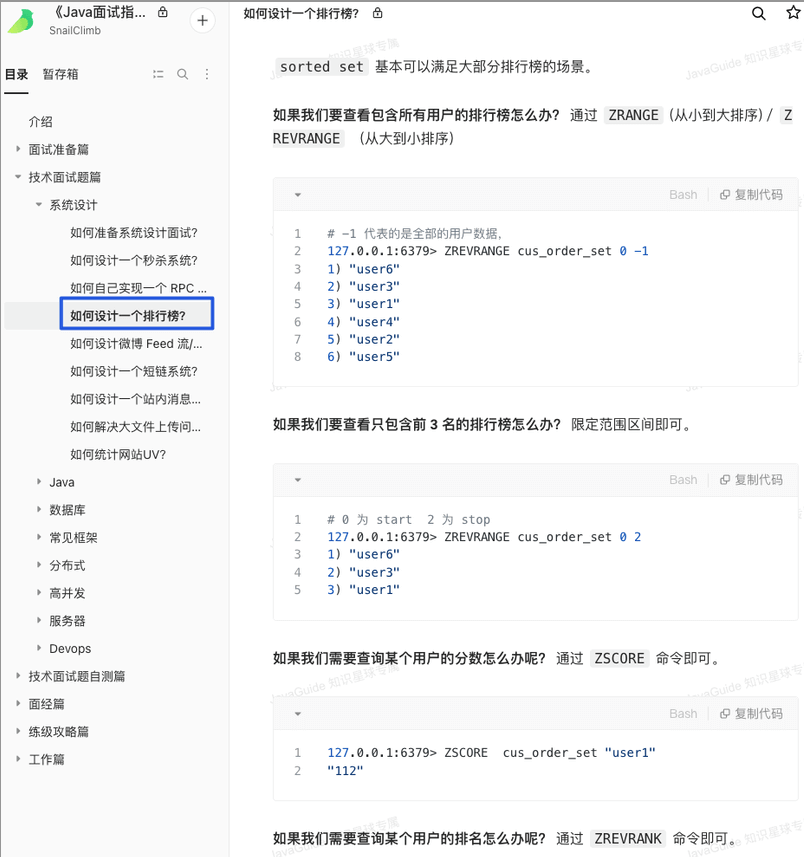

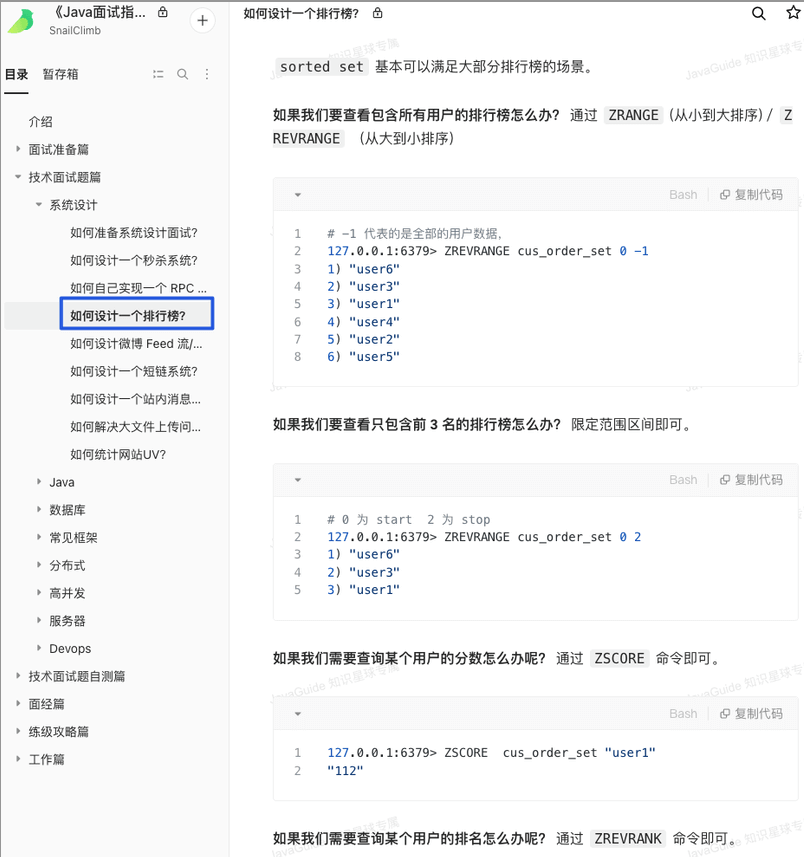

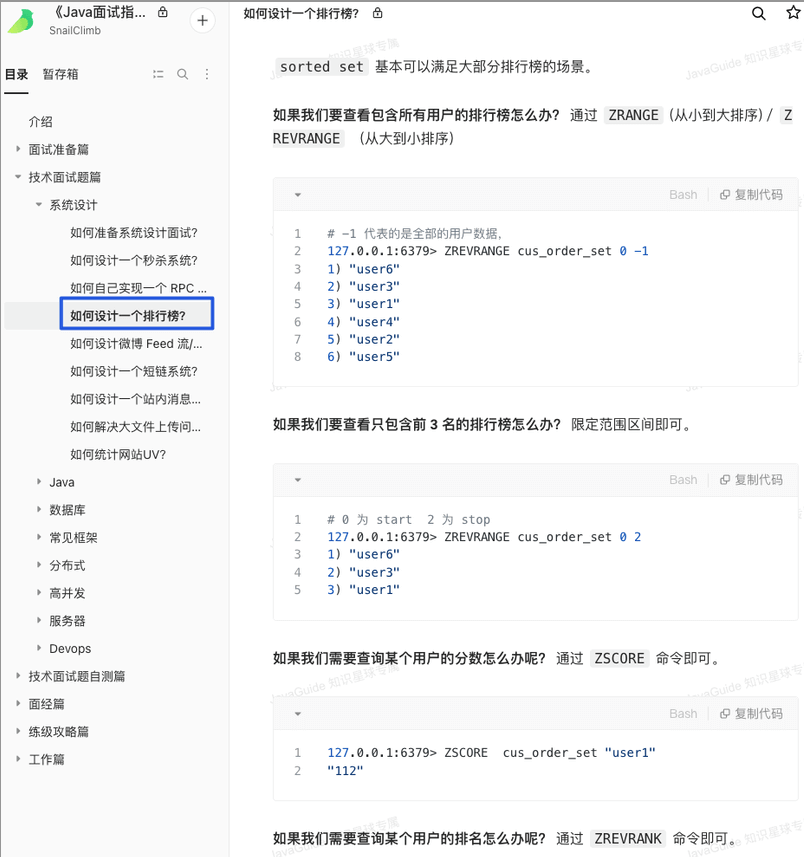

-[《Java 面试指北》](https://javaguide.cn/zhuanlan/java-mian-shi-zhi-bei.html) 的「技术面试题篇」就有一篇文章详细介绍如何使用 Sorted Set 来设计制作一个排行榜。

-

-

-

-**需要存储的数据有优先级或者重要程度的场景** 比如优先级任务队列。

-

-- 举例:优先级任务队列。

-- 相关命令:`ZRANGE` (从小到大排序)、 `ZREVRANGE` (从大到小排序)、`ZREVRANK` (指定元素排名)。

-

-## 总结

-

-| 数据类型 | 说明 |

-| -------- | ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

-| String | 一种二进制安全的数据类型,可以用来存储任何类型的数据比如字符串、整数、浮点数、图片(图片的 base64 编码或者解码或者图片的路径)、序列化后的对象。 |

-| List | Redis 的 List 的实现为一个双向链表,即可以支持反向查找和遍历,更方便操作,不过带来了部分额外的内存开销。 |

-| Hash | 一个 String 类型的 field-value(键值对) 的映射表,特别适合用于存储对象,后续操作的时候,你可以直接修改这个对象中的某些字段的值。 |

-| Set | 无序集合,集合中的元素没有先后顺序但都唯一,有点类似于 Java 中的 `HashSet` 。 |

-| Zset | 和 Set 相比,Sorted Set 增加了一个权重参数 `score`,使得集合中的元素能够按 `score` 进行有序排列,还可以通过 `score` 的范围来获取元素的列表。有点像是 Java 中 `HashMap` 和 `TreeSet` 的结合体。 |

-

-## 参考

-

-- Redis Data Structures: 。

-- Redis Commands: 。

-- Redis Data types tutorial: 。

-- Redis 存储对象信息是用 Hash 还是 String :

-

-

diff --git a/docs/database/redis/redis-data-structures-02.md b/docs/database/redis/redis-data-structures-02.md

index 9e5fbcee59b..835b5f8b8be 100644

--- a/docs/database/redis/redis-data-structures-02.md

+++ b/docs/database/redis/redis-data-structures-02.md

@@ -1,48 +1,48 @@

---

-title: Redis 3 种特殊数据类型详解

-category: 数据库

+title: Detailed Explanation of 3 Special Data Types in Redis

+category: Database

tag:

- Redis

head:

- - meta

- name: keywords

- content: Redis常见数据类型

+ content: Common data types in Redis

- - meta

- name: description

- content: Redis特殊数据类型总结:HyperLogLogs(基数统计)、Bitmap (位存储)、Geospatial (地理位置)。

+ content: Summary of Redis special data types: HyperLogLogs (cardinality statistics), Bitmap (bit storage), Geospatial (geolocation).

---

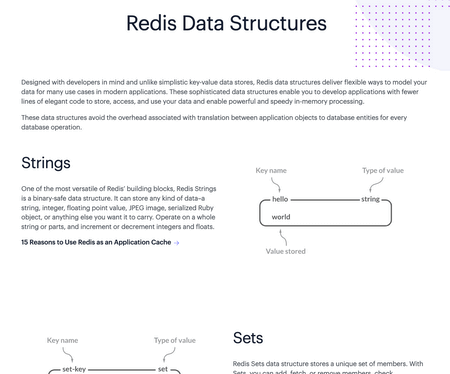

-除了 5 种基本的数据类型之外,Redis 还支持 3 种特殊的数据类型:Bitmap、HyperLogLog、GEO。

+In addition to the 5 basic data types, Redis also supports 3 special data types: Bitmap, HyperLogLog, and GEO.

-## Bitmap (位图)

+## Bitmap

-### 介绍

+### Introduction

-根据官网介绍:

+According to the official website:

> Bitmaps are not an actual data type, but a set of bit-oriented operations defined on the String type which is treated like a bit vector. Since strings are binary safe blobs and their maximum length is 512 MB, they are suitable to set up to 2^32 different bits.

>

-> Bitmap 不是 Redis 中的实际数据类型,而是在 String 类型上定义的一组面向位的操作,将其视为位向量。由于字符串是二进制安全的块,且最大长度为 512 MB,它们适合用于设置最多 2^32 个不同的位。

+> Bitmap is not an actual data type in Redis, but a set of bit-oriented operations defined on the String type, treated as a bit vector. Since strings are binary safe blobs and their maximum length is 512 MB, they are suitable for setting up to 2^32 different bits.

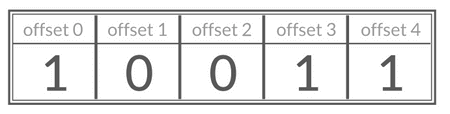

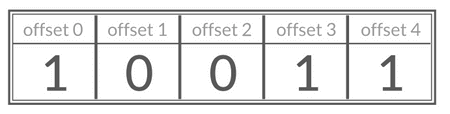

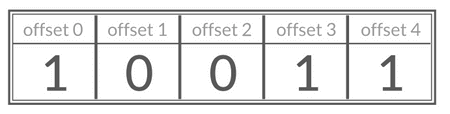

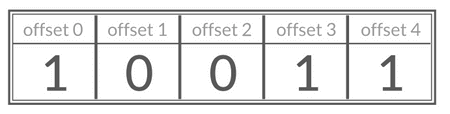

-Bitmap 存储的是连续的二进制数字(0 和 1),通过 Bitmap, 只需要一个 bit 位来表示某个元素对应的值或者状态,key 就是对应元素本身 。我们知道 8 个 bit 可以组成一个 byte,所以 Bitmap 本身会极大的节省储存空间。

+Bitmaps store continuous binary numbers (0 and 1). With Bitmap, only one bit is needed to represent the value or state of a corresponding element, where the key is the element itself. We know that 8 bits can form one byte, so Bitmap can greatly save storage space.

-你可以将 Bitmap 看作是一个存储二进制数字(0 和 1)的数组,数组中每个元素的下标叫做 offset(偏移量)。

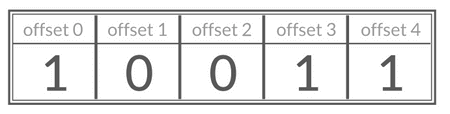

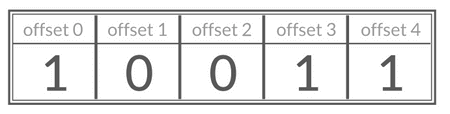

+You can think of Bitmap as an array that stores binary numbers (0 and 1), where each element's index is called an offset.

-### 常用命令

+### Common Commands

-| 命令 | 介绍 |

-| ------------------------------------- | ---------------------------------------------------------------- |

-| SETBIT key offset value | 设置指定 offset 位置的值 |

-| GETBIT key offset | 获取指定 offset 位置的值 |

-| BITCOUNT key start end | 获取 start 和 end 之间值为 1 的元素个数 |

-| BITOP operation destkey key1 key2 ... | 对一个或多个 Bitmap 进行运算,可用运算符有 AND, OR, XOR 以及 NOT |

+| Command | Description |

+| ------------------------------------- | ------------------------------------------------------------------------------- |

+| SETBIT key offset value | Set the value at the specified offset position |

+| GETBIT key offset | Get the value at the specified offset position |

+| BITCOUNT key start end | Get the number of elements with a value of 1 between start and end |

+| BITOP operation destkey key1 key2 ... | Perform operations on one or more Bitmaps, with operators AND, OR, XOR, and NOT |

-**Bitmap 基本操作演示**:

+**Basic Bitmap Operations Demonstration**:

```bash

-# SETBIT 会返回之前位的值(默认是 0)这里会生成 7 个位

+# SETBIT will return the previous value of the bit (default is 0), generating 7 bits

> SETBIT mykey 7 1

(integer) 0

> SETBIT mykey 7 0

@@ -53,174 +53,35 @@ Bitmap 存储的是连续的二进制数字(0 和 1),通过 Bitmap, 只需

(integer) 0

> SETBIT mykey 8 1

(integer) 0

-# 通过 bitcount 统计被被设置为 1 的位的数量。

+# Count the number of bits set to 1 using bitcount.

> BITCOUNT mykey

(integer) 2

```

-### 应用场景

+### Application Scenarios

-**需要保存状态信息(0/1 即可表示)的场景**

+**Scenarios that require saving state information (0/1 can represent)**

-- 举例:用户签到情况、活跃用户情况、用户行为统计(比如是否点赞过某个视频)。

-- 相关命令:`SETBIT`、`GETBIT`、`BITCOUNT`、`BITOP`。

+- Example: User sign-in status, active user status, user behavior statistics (e.g., whether a user has liked a certain video).

+- Related commands: `SETBIT`, `GETBIT`, `BITCOUNT`, `BITOP`.

-## HyperLogLog(基数统计)

+## HyperLogLog

-### 介绍

+### Introduction

-HyperLogLog 是一种有名的基数计数概率算法 ,基于 LogLog Counting(LLC)优化改进得来,并不是 Redis 特有的,Redis 只是实现了这个算法并提供了一些开箱即用的 API。

+HyperLogLog is a well-known probabilistic algorithm for cardinality counting, optimized from LogLog Counting (LLC). It is not unique to Redis; Redis simply implements this algorithm and provides some out-of-the-box APIs.

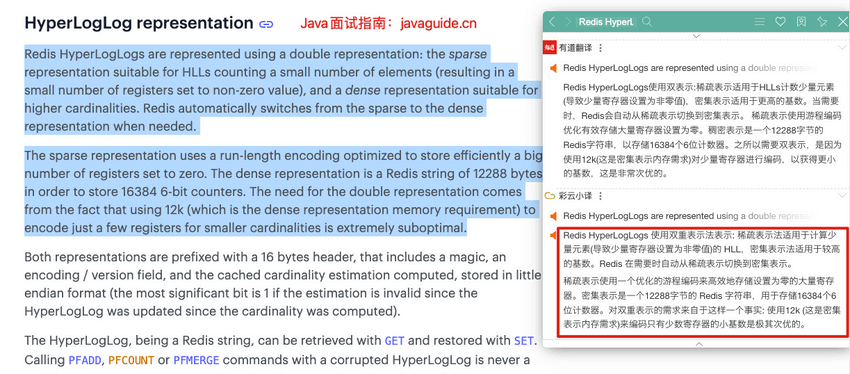

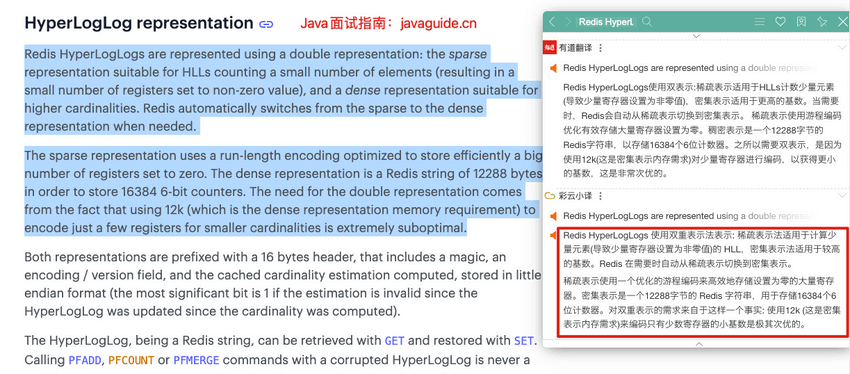

-Redis 提供的 HyperLogLog 占用空间非常非常小,只需要 12k 的空间就能存储接近`2^64`个不同元素。这是真的厉害,这就是数学的魅力么!并且,Redis 对 HyperLogLog 的存储结构做了优化,采用两种方式计数:

+The HyperLogLog provided by Redis occupies a very small space, requiring only 12k of space to store nearly `2^64` different elements. This is truly impressive; this is the charm of mathematics! Additionally, Redis has optimized the storage structure of HyperLogLog, using two counting methods:

-- **稀疏矩阵**:计数较少的时候,占用空间很小。

-- **稠密矩阵**:计数达到某个阈值的时候,占用 12k 的空间。

+- **Sparse Matrix**: When the count is low, it occupies very little space.

+- **Dense Matrix**: When the count reaches a certain threshold, it occupies 12k of space.

-Redis 官方文档中有对应的详细说明:

+The official Redis documentation provides detailed explanations:

-基数计数概率算法为了节省内存并不会直接存储元数据,而是通过一定的概率统计方法预估基数值(集合中包含元素的个数)。因此, HyperLogLog 的计数结果并不是一个精确值,存在一定的误差(标准误差为 `0.81%` )。

+The cardinality counting probabilistic algorithm does not directly store metadata to save memory; instead, it estimates the cardinality value (the number of elements in the set) through certain probabilistic statistical methods. Therefore, the counting result of HyperLogLog is not an exact value and has a certain margin of error (standard error is `0.81%`).

-HyperLogLog 的使用非常简单,但原理非常复杂。HyperLogLog 的原理以及在 Redis 中的实现可以看这篇文章:[HyperLogLog 算法的原理讲解以及 Redis 是如何应用它的](https://juejin.cn/post/6844903785744056333) 。

-

-再推荐一个可以帮助理解 HyperLogLog 原理的工具:[Sketch of the Day: HyperLogLog — Cornerstone of a Big Data Infrastructure](http://content.research.neustar.biz/blog/hll.html) 。

-

-除了 HyperLogLog 之外,Redis 还提供了其他的概率数据结构,对应的官方文档地址: 。

-

-### 常用命令

-

-HyperLogLog 相关的命令非常少,最常用的也就 3 个。

-

-| 命令 | 介绍 |

-| ----------------------------------------- | -------------------------------------------------------------------------------- |

-| PFADD key element1 element2 ... | 添加一个或多个元素到 HyperLogLog 中 |

-| PFCOUNT key1 key2 | 获取一个或者多个 HyperLogLog 的唯一计数。 |

-| PFMERGE destkey sourcekey1 sourcekey2 ... | 将多个 HyperLogLog 合并到 destkey 中,destkey 会结合多个源,算出对应的唯一计数。 |

-

-**HyperLogLog 基本操作演示**:

-

-```bash

-> PFADD hll foo bar zap

-(integer) 1

-> PFADD hll zap zap zap

-(integer) 0

-> PFADD hll foo bar

-(integer) 0

-> PFCOUNT hll

-(integer) 3

-> PFADD some-other-hll 1 2 3

-(integer) 1

-> PFCOUNT hll some-other-hll

-(integer) 6

-> PFMERGE desthll hll some-other-hll

-"OK"

-> PFCOUNT desthll

-(integer) 6

-```

-

-### 应用场景

-

-**数量巨大(百万、千万级别以上)的计数场景**

-

-- 举例:热门网站每日/每周/每月访问 ip 数统计、热门帖子 uv 统计。

-- 相关命令:`PFADD`、`PFCOUNT` 。

-

-## Geospatial (地理位置)

-

-### 介绍

-

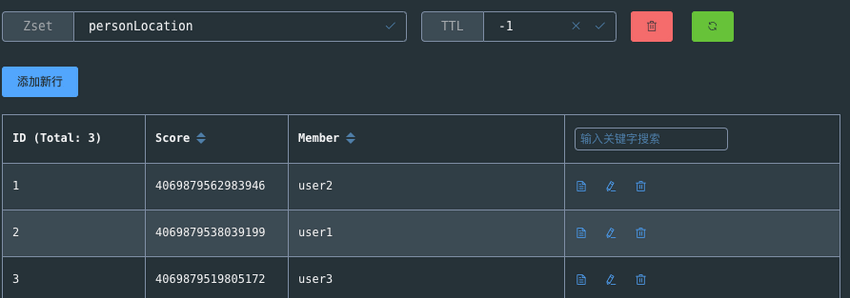

-Geospatial index(地理空间索引,简称 GEO) 主要用于存储地理位置信息,基于 Sorted Set 实现。

-

-通过 GEO 我们可以轻松实现两个位置距离的计算、获取指定位置附近的元素等功能。

-

-

-

-### 常用命令

-

-| 命令 | 介绍 |

-| ------------------------------------------------ | ---------------------------------------------------------------------------------------------------- |

-| GEOADD key longitude1 latitude1 member1 ... | 添加一个或多个元素对应的经纬度信息到 GEO 中 |

-| GEOPOS key member1 member2 ... | 返回给定元素的经纬度信息 |

-| GEODIST key member1 member2 M/KM/FT/MI | 返回两个给定元素之间的距离 |

-| GEORADIUS key longitude latitude radius distance | 获取指定位置附近 distance 范围内的其他元素,支持 ASC(由近到远)、DESC(由远到近)、Count(数量) 等参数 |

-| GEORADIUSBYMEMBER key member radius distance | 类似于 GEORADIUS 命令,只是参照的中心点是 GEO 中的元素 |

-

-**基本操作**:

-

-```bash

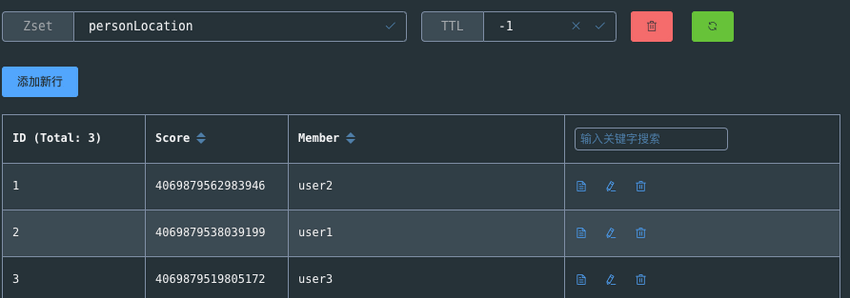

-> GEOADD personLocation 116.33 39.89 user1 116.34 39.90 user2 116.35 39.88 user3

-3

-> GEOPOS personLocation user1

-116.3299986720085144

-39.89000061669732844

-> GEODIST personLocation user1 user2 km

-1.4018

-```

-

-通过 Redis 可视化工具查看 `personLocation` ,果不其然,底层就是 Sorted Set。

-

-GEO 中存储的地理位置信息的经纬度数据通过 GeoHash 算法转换成了一个整数,这个整数作为 Sorted Set 的 score(权重参数)使用。

-

-

-

-**获取指定位置范围内的其他元素**:

-

-```bash

-> GEORADIUS personLocation 116.33 39.87 3 km

-user3

-user1

-> GEORADIUS personLocation 116.33 39.87 2 km

-> GEORADIUS personLocation 116.33 39.87 5 km

-user3

-user1

-user2

-> GEORADIUSBYMEMBER personLocation user1 5 km

-user3

-user1

-user2

-> GEORADIUSBYMEMBER personLocation user1 2 km

-user1

-user2

-```

-

-`GEORADIUS` 命令的底层原理解析可以看看阿里的这篇文章:[Redis 到底是怎么实现“附近的人”这个功能的呢?](https://juejin.cn/post/6844903966061363207) 。

-

-**移除元素**:

-

-GEO 底层是 Sorted Set ,你可以对 GEO 使用 Sorted Set 相关的命令。

-

-```bash

-> ZREM personLocation user1

-1

-> ZRANGE personLocation 0 -1

-user3

-user2

-> ZSCORE personLocation user2

-4069879562983946

-```

-

-### 应用场景

-

-**需要管理使用地理空间数据的场景**

-

-- 举例:附近的人。

-- 相关命令: `GEOADD`、`GEORADIUS`、`GEORADIUSBYMEMBER` 。

-

-## 总结

-

-| 数据类型 | 说明 |

-| ---------------- | --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

-| Bitmap | 你可以将 Bitmap 看作是一个存储二进制数字(0 和 1)的数组,数组中每个元素的下标叫做 offset(偏移量)。通过 Bitmap, 只需要一个 bit 位来表示某个元素对应的值或者状态,key 就是对应元素本身 。我们知道 8 个 bit 可以组成一个 byte,所以 Bitmap 本身会极大的节省储存空间。 |

-| HyperLogLog | Redis 提供的 HyperLogLog 占用空间非常非常小,只需要 12k 的空间就能存储接近`2^64`个不同元素。不过,HyperLogLog 的计数结果并不是一个精确值,存在一定的误差(标准误差为 `0.81%` )。 |

-| Geospatial index | Geospatial index(地理空间索引,简称 GEO) 主要用于存储地理位置信息,基于 Sorted Set 实现。 |

-

-## 参考

-

-- Redis Data Structures: 。

-- 《Redis 深度历险:核心原理与应用实践》1.6 四两拨千斤——HyperLogLog

-- 布隆过滤器,位图,HyperLogLog:

-

-

+Using HyperLogLog is very simple, but the principle is quite complex. You can read this article for an explanation of the principle of HyperLogLog and how it is applied in Redis: \[Explanation of the Principle of HyperLogLog Algorithm and How Redis Applies It\](https://juejin.cn/post/684490378574

diff --git a/docs/database/redis/redis-delayed-task.md b/docs/database/redis/redis-delayed-task.md

index 35f9304321f..acfebfbb9d6 100644

--- a/docs/database/redis/redis-delayed-task.md

+++ b/docs/database/redis/redis-delayed-task.md

@@ -1,82 +1,82 @@

---

-title: 如何基于Redis实现延时任务

-category: 数据库

+title: How to Implement Delayed Tasks Based on Redis

+category: Database

tag:

- Redis

---

-基于 Redis 实现延时任务的功能无非就下面两种方案:

+The functionality of implementing delayed tasks based on Redis consists of the following two solutions:

-1. Redis 过期事件监听

-2. Redisson 内置的延时队列

+1. Redis Expiration Event Listening

+1. Built-in Delayed Queue in Redisson

-面试的时候,你可以先说自己考虑了这两种方案,但最后发现 Redis 过期事件监听这种方案存在很多问题,因此你最终选择了 Redisson 内置的 DelayedQueue 这种方案。

+During the interview, you can first mention that you considered these two solutions, but ultimately found that the Redis expiration event listening approach has many issues, which led you to choose the built-in DelayedQueue in Redisson.

-这个时候面试官可能会追问你一些相关的问题,我们后面会提到,提前准备就好了。